W ewoluującym krajobrazie automatyki przemysłowej roboty wykazały się niezwykłą biegłością w wykonywaniu powtarzalnych, szybkich zadań, kierowanych przez zaawansowane systemy wizji komputerowej. Jednak w obliczu scenariuszy „wymagających częstego kontaktu fizycznego” – takich jak przewlekanie cienkiego drutu przez złącze lub montaż delikatnych komponentów elektronicznych – nawet najbardziej zaawansowane systemy wizyjne często osiągają kres swoich możliwości. Zadania te wymagają czegoś więcej niż tylko wzroku; wymagają one subtelnego zmysłu dotyku i zrozumienia oporu fizycznego. Aby wypełnić tę lukę sensoryczną, zespół badawczy kierowany przez Tailai Chenga, Fan Wu i Kejia Chen opracował TacUMI – multimodalny interfejs ręczny zaprojektowany do rejestrowania skomplikowanych interakcji siłowych i dotykowych podczas ludzkich demonstracji, dostarczając nowy schemat tego, jak roboty mogą uczyć się złożonych interakcji fizycznych.

Ograniczenia robotyki opartej wyłącznie na wizji

Fundamentalne wyzwanie w nowoczesnym uczeniu się robotów leży w „czarnej skrzynce” interakcji fizycznej. Podczas gdy obecne ramy, takie jak Diffusion Policy i ACT, odniosły sukces w zadaniach o krótkim horyzoncie czasowym, często traktują one demonstrację jako monolityczny blok danych. W przypadku złożonych zadań o długim horyzoncie, takich jak montaż kabli, obserwacje wizualne i dane proprioceptywne robota – wewnętrzne poczucie pozycji własnych kończyn robota – są często niewystarczające. Na przykład, gdy ludzki operator rozciąga kabel, aby wytworzyć napięcie przed umieszczeniem go w gnieździe, zmiana wizualna może być znikoma, jednak stan fizyczny zadania uległ znaczącej zmianie. Bez możliwości „poczucia” tego napięcia, robot ma trudności z zidentyfikowaniem przejścia między różnymi etapami operacji, co prowadzi do błędów w wykonaniu, gdy otoczenie nawet nieznacznie odbiega od danych treningowych.

Przedstawiamy TacUMI: Multimodalny przełom

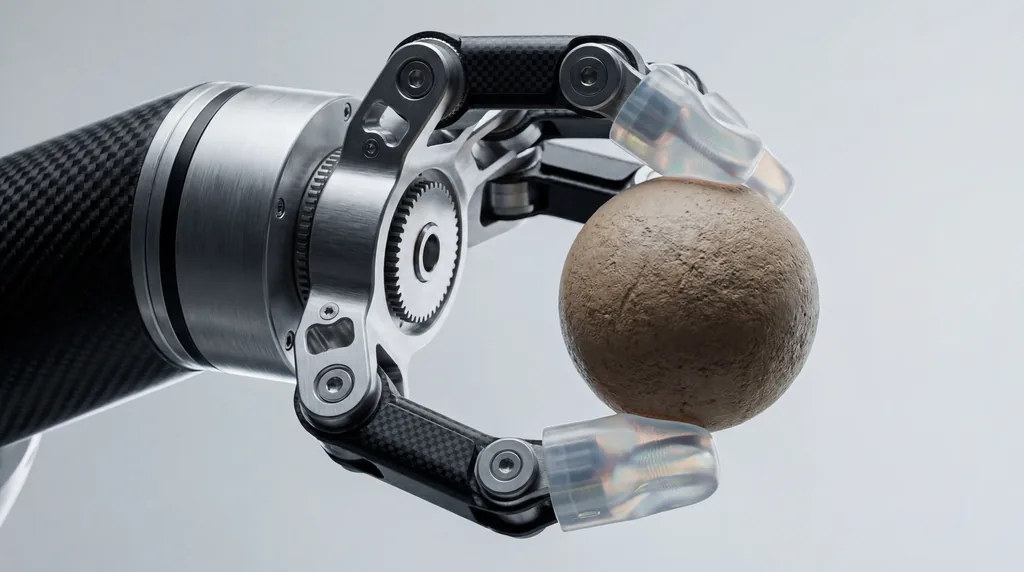

Opierając się na fundamentach Universal Manipulation Interface (UMI), badacze z Technical University of Munich, Agile Robots SE oraz ich partnerzy z uniwersytetów w Nanjing i Szanghaju zaprezentowali TacUMI. System ten to kompaktowy, kompatybilny z robotami chwytak zaprojektowany do gromadzenia danych o wysokiej wierności. W przeciwieństwie do swoich poprzedników, którzy w dużej mierze polegali na kamerach i estymacji pozycji opartej na technologii SLAM (Simultaneous Localization and Mapping), TacUMI integruje zestaw specjalistycznych czujników: czujniki ViTac na opuszkach palców do mapowania dotykowego o wysokiej rozdzielczości, czujnik siły i momentu obrotowego o sześciu stopniach swobody (6D) na nadgarstku oraz precyzyjne urządzenie do śledzenia pozycji 6D. Ten zestaw pozwala na zsynchronizowane pozyskiwanie danych wizualnych, siłowych i dotykowych, tworząc bogaty, wielowymiarowy zbiór danych o ludzkiej zręczności.

Rejestrowanie ludzkiego dotyku

Konstrukcja sprzętowa TacUMI została specjalnie opracowana, aby wyeliminować „szum” typowo kojarzony z ręcznymi urządzeniami demonstracyjnymi. Jedną z wyróżniających się cech jest mechanizm stale blokowanych szczęk. W tradycyjnych urządzeniach ręcznych siła wywierana przez ludzkiego operatora w celu utrzymania chwytu może zakłócać zdolność czujników do rejestrowania rzeczywistych sił interakcji między narzędziem a obiektem. Pozwalając operatorowi na zablokowanie chwytaka po zabezpieczeniu obiektu, TacUMI zapewnia, że czujniki siły i momentu obrotowego rejestrują wyłącznie czyste dane z samej interakcji podczas zadania. Pozwala to ludziom na naturalne demonstrowanie delikatnych zadań, podczas gdy urządzenie rejestruje interakcje o wysokim napięciu – takie jak te występujące przy manipulacji odkształcalnymi obiektami liniowymi (DLO) – bez poślizgu czy zanieczyszczenia danych z czujników.

Segmentacja semantyczna i dekompozycja zadań

Głównym wkładem badawczym jest opracowanie ram segmentacji multimodalnej, które wykorzystują modele czasowe, a konkretnie dwukierunkową sieć typu Long Short-Term Memory (BiLSTM). Celem tych ram jest rozłożenie demonstracji o długim horyzoncie na semantycznie znaczące „umiejętności” lub moduły. Przetwarzając zsynchronizowane strumienie danych dotykowych, siłowych i wizualnych, model może wykrywać granice zdarzeń – dokładny moment chwycenia kabla, moment przyłożenia napięcia i moment jego pomyślnego osadzenia. Ta dekompozycja ma kluczowe znaczenie dla uczenia hierarchicznego, w którym robot najpierw uczy się poszczególnych umiejętności motorycznych, a następnie poznaje koordynatora wysokiego szczebla, aby skutecznie je sekwencjonować, co czyni proces uczenia się bardziej skalowalnym i łatwiejszym do zinterpretowania niż podejścia end-to-end.

Studium przypadku: Opanowanie delikatnego montażu elektroniki

Aby potwierdzić skuteczność TacUMI, badacze ocenili system w trudnym zadaniu montażu kabli, który jest podstawą montażu elektroniki i pozostaje trudny do zautomatyzowania. Eksperyment wymagał od operatora podniesienia kabla, poruszania się w zagraconym środowisku, wytworzenia określonego napięcia i włożenia złącza do precyzyjnej obudowy. Wyniki były uderzające: system osiągnął ponad 90-procentową dokładność segmentacji. Co istotne, badania wykazały wyraźną poprawę wydajności wraz z dodawaniem kolejnych modalności. Podczas gdy modele oparte wyłącznie na wizji często nie potrafiły odróżnić fazy „napinania” od „wkładania”, uwzględnienie danych dotykowych i siłowych pozwoliło modelowi precyzyjnie wskazać granice przejścia, udowadniając, że multimodalne sensory są niezbędne do zrozumienia zadań wymagających częstego kontaktu.

Rola współpracy międzyinstytucjonalnej

Opracowanie TacUMI reprezentuje znaczącą współpracę kilku prestiżowych instytucji. Główny autor Tailai Cheng, związany zarówno z Technical University of Munich, jak i Agile Robots SE, pracował u boku Kejia Chena, Lingyun Chena i innych kolegów nad dopracowaniem integracji sprzętowo-programowej. Wkład Fan Wu z Shanghai University i Zhenshan Binga z Nanjing University był kluczowy w opracowaniu ram algorytmicznych, które pozwalają systemowi na generalizację w różnych metodach zbierania danych. Co ciekawe, badacze wykazali, że model wytrenowany na danych zebranych przez TacUMI może zostać wdrożony w zestawach danych zebranych za pomocą tradycyjnej teleoperacji robotycznej, osiągając porównywalną dokładność i pokazując wszechstronność systemu w różnych konfiguracjach robotycznych.

Przyszłe kierunki uczenia się robotów poprzez demonstrację

Sukces interfejsu TacUMI otwiera kilka nowych dróg dla dziedziny uczenia się robotów poprzez demonstrację (LfD). Zapewniając praktyczne podstawy do skalowalnego gromadzenia wysokiej jakości danych multimodalnych, system przybliża nas do osiągnięcia ludzkiej wrażliwości dotykowej w systemach autonomicznych. Badacze sugerują, że kolejne kroki obejmują skalowanie TacUMI do jeszcze bardziej zróżnicowanych i nieprzewidywalnych zastosowań przemysłowych, takich jak obsługa miękkich materiałów i złożony montaż wielonarzędziowy. W miarę jak roboty wychodzą ze sztywnych ustawień fabrycznych do bardziej dynamicznych środowisk, zdolność do „wyczuwania” swojej drogi przez zadanie – ułatwiona przez urządzenia takie jak TacUMI – prawdopodobnie stanie się tak fundamentalna, jak zdolność widzenia.

Implikacje dla branży robotyki

Dla szerszej branży robotyki TacUMI sygnalizuje odejście od polegania na drogich, uciążliwych systemach teleoperacji. Obniżając barierę wejścia dla gromadzenia wyrafinowanych danych dotykowych, ten interfejs ręczny pozwala na szybszą iterację w szkoleniu robotów. W sektorach takich jak produkcja elektroniki i usługi domowe, gdzie koszt porażki jest wysoki, a złożoność zadań ogromna, zdolność do rozbicia działań o długim horyzoncie na wyuczalne, oparte na dotyku moduły mogłaby drastycznie skrócić czas wymagany do wdrożenia autonomicznych rozwiązań. Jak zauważają Fan Wu i zespół badawczy, integracja tych modalności sensorycznych to nie tylko aktualizacja techniczna; to niezbędna ewolucja dla robotów mających operować w świecie fizycznym zdefiniowanym przez dotyk i opór.

Comments

No comments yet. Be the first!