Dans le paysage en constante évolution de l'automatisation industrielle, les robots ont fait preuve d'une compétence remarquable dans l'exécution de tâches répétitives et à haute vitesse guidées par une vision par ordinateur sophistiquée. Cependant, face à des scénarios « riches en contacts » — comme l'enfilage d'un fil fin dans un connecteur ou l'assemblage de composants électroniques délicats — même les systèmes visuels les plus avancés atteignent souvent un plateau. Ces tâches exigent plus que la simple vue ; elles nécessitent un sens nuancé du toucher et une compréhension de la résistance physique. Pour combler cette lacune sensorielle, une équipe de recherche dirigée par Tailai Cheng, Fan Wu et Kejia Chen a mis au point TacUMI, une interface portative multimodale conçue pour capturer la danse complexe de la force et du retour tactile lors des démonstrations humaines, offrant ainsi un nouveau modèle sur la manière dont les robots pourraient apprendre des interactions physiques complexes.

Les limites de la robotique basée uniquement sur la vision

Le défi fondamental de l'apprentissage robotique moderne réside dans la « boîte noire » de l'interaction physique. Bien que les cadres actuels tels que Diffusion Policy et ACT aient fait leurs preuves dans des tâches à horizon court, ils traitent souvent une démonstration comme un bloc de données monolithique. Pour des tâches complexes à long horizon comme le montage de câbles, les observations visuelles et les données proprioceptives du robot — le sens interne de la position de ses propres membres — sont fréquemment insuffisantes. Par exemple, lorsqu'un opérateur humain étire un câble pour créer une tension avant de l'insérer dans une fente, le changement visuel peut être négligeable, alors que l'état physique de la tâche a considérablement évolué. Sans la capacité de « ressentir » cette tension, un robot peine à identifier la transition entre les différentes étapes de l'opération, ce qui entraîne des échecs d'exécution lorsque l'environnement s'écarte, même légèrement, des données d'entraînement.

Présentation de TacUMI : une percée multimodale

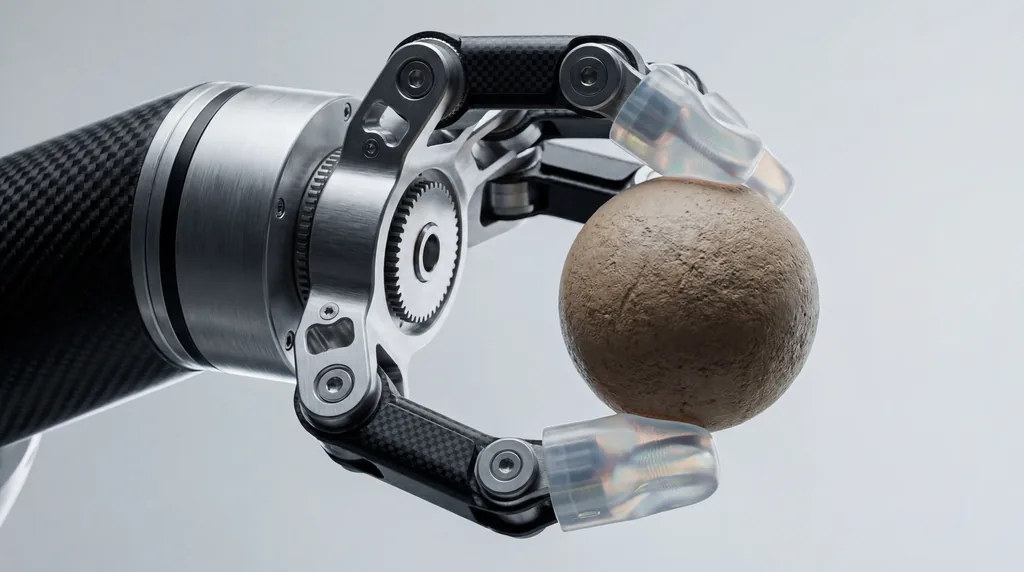

S'appuyant sur l'interface de manipulation universelle (UMI) fondamentale, des chercheurs de la Technical University of Munich, d'Agile Robots SE et leurs partenaires des universités de Nanjing et de Shanghai ont présenté TacUMI. Ce système est une pince compacte, compatible avec les robots, conçue pour la collecte de données haute fidélité. Contrairement à ses prédécesseurs, qui reposaient largement sur des caméras et l'estimation de pose basée sur le SLAM (Simultaneous Localization and Mapping), TacUMI intègre une suite de capteurs spécialisés : des capteurs ViTac sur le bout des doigts pour une cartographie tactile haute résolution, un capteur d'effort-couple à six degrés de liberté (6D) au poignet, et un tracker de pose 6D de haute précision. Cet ensemble permet l'acquisition synchronisée des modalités visuelles, de force et tactiles, créant ainsi un ensemble de données riche et multidimensionnel de la dextérité humaine.

Capturer le toucher humain

La conception matérielle de TacUMI est spécifiquement étudiée pour éliminer le « bruit » typiquement associé aux dispositifs de démonstration portatifs. L'une des caractéristiques marquantes est un mécanisme de mâchoire verrouillable en continu. Dans les appareils portatifs traditionnels, la force exercée par l'opérateur humain pour maintenir une prise peut interférer avec la capacité des capteurs à enregistrer les forces d'interaction réelles entre l'outil et l'objet. En permettant à l'opérateur de verrouiller la pince une fois l'objet sécurisé, TacUMI garantit que les capteurs d'effort-couple n'enregistrent que les données d'interaction pures de la tâche elle-même. Cela permet aux humains de démontrer des tâches délicates naturellement, tandis que l'appareil capture les interactions à haute tension — telles que celles rencontrées dans la manipulation d'objets linéaires déformables (DLO) — sans glissement ni contamination des capteurs.

Segmentation sémantique et décomposition des tâches

Une contribution centrale de la recherche est le développement d'un cadre de segmentation multimodal utilisant des modèles temporels, spécifiquement un réseau Bi-directional Long Short-Term Memory (BiLSTM). L'objectif de ce cadre est de décomposer les démonstrations à long horizon en « compétences » ou modules sémantiquement significatifs. En traitant les flux synchronisés de données tactiles, de force et visuelles, le modèle peut détecter les frontières d'événements — le moment exact où un câble est saisi, le moment où la tension est appliquée et le moment où il est correctement logé. Cette décomposition est cruciale pour l'apprentissage hiérarchique, où un robot apprend d'abord des compétences motrices individuelles, puis apprend un coordinateur de haut niveau pour les séquencer efficacement, rendant le processus d'apprentissage plus évolutif et interprétable que les approches de bout en bout.

Étude de cas : maîtriser l'assemblage électronique délicat

Pour valider l'efficacité de TacUMI, les chercheurs ont évalué le système sur une tâche difficile de montage de câbles, un élément de base de l'assemblage électronique qui reste difficile à automatiser. L'expérience exigeait que l'opérateur ramasse un câble, navigue dans un environnement encombré, crée une tension spécifique et insère le connecteur dans un boîtier précis. Les résultats ont été frappants : le système a atteint une précision de segmentation de plus de 90 %. Surtout, la recherche a mis en évidence une amélioration remarquable des performances à mesure que des modalités étaient ajoutées. Alors que les modèles basés uniquement sur la vision échouaient souvent à distinguer les phases de « mise sous tension » et d'« insertion », l'inclusion des données tactiles et de force a permis au modèle de localiser les limites de transition avec une grande précision, prouvant que la détection multimodale est essentielle pour comprendre les tâches riches en contacts.

Le rôle de la collaboration multi-institutionnelle

Le développement de TacUMI représente une collaboration significative entre plusieurs institutions prestigieuses. L'auteur principal Tailai Cheng, associé à la fois à la Technical University of Munich et à Agile Robots SE, a travaillé aux côtés de Kejia Chen, Lingyun Chen et d'autres collègues pour affiner l'intégration matériel-logiciel. Les contributions de Fan Wu de la Shanghai University et de Zhenshan Bing de la Nanjing University ont été déterminantes dans le développement du cadre algorithmique qui permet au système de se généraliser à travers différentes méthodes de collecte de données. Fait intéressant, les chercheurs ont démontré qu'un modèle entraîné sur des données collectées par TacUMI pouvait être déployé sur des ensembles de données collectés via une téléopération robotique traditionnelle, atteignant une précision comparable et démontrant la polyvalence du système à travers différentes incarnations robotiques.

Orientations futures pour l'apprentissage robotique par démonstration

Le succès de l'interface TacUMI ouvre plusieurs nouvelles voies pour le domaine de l'apprentissage par démonstration (LfD - Robot Learning from Demonstration). En fournissant une base pratique pour la collecte évolutive de données multimodales de haute qualité, le système rapproche le curseur de l'obtention d'une sensibilité tactile de type humain dans les systèmes autonomes. Les chercheurs suggèrent que les prochaines étapes consistent à adapter TacUMI à des applications industrielles encore plus diverses et imprévisibles, telles que la manipulation de matériaux souples et l'assemblage complexe multi-outils. À mesure que les robots sortent des cadres d'usine rigides pour intégrer des environnements plus dynamiques, la capacité à « ressentir » leur chemin à travers une tâche — facilitée par des dispositifs comme TacUMI — deviendra probablement aussi fondamentale que la capacité de voir.

Implications pour l'industrie de la robotique

Pour l'ensemble de l'industrie robotique, TacUMI signale un abandon de la dépendance aux configurations de téléopération coûteuses et encombrantes. En abaissant la barrière à l'entrée pour la collecte de données tactiles sophistiquées, cette interface portative permet une itération plus rapide dans l'entraînement des robots. Dans des secteurs comme la fabrication électronique et les services à domicile, où le coût de l'échec est élevé et la complexité des tâches immense, la capacité à décomposer les actions à long horizon en modules apprenables et informés par le toucher pourrait réduire considérablement le temps nécessaire au déploiement de solutions autonomes. Comme le notent Fan Wu et l'équipe de recherche, l'intégration de ces modalités sensorielles n'est pas seulement une mise à niveau technique ; c'est une évolution nécessaire pour des robots destinés à opérer dans un monde physique défini par le toucher et la résistance.

Comments

No comments yet. Be the first!