In der sich ständig weiterentwickelnden Landschaft der industriellen Automatisierung haben Roboter bemerkenswerte Fähigkeiten bei der Ausführung repetitiver Hochgeschwindigkeitsaufgaben unter der Führung hochentwickelter Computer-Vision-Systeme bewiesen. Wenn sie jedoch mit „kontaktintensiven“ Szenarien konfrontiert werden – wie dem Einfädeln eines dünnen Drahtes in einen Stecker oder der Montage empfindlicher elektronischer Komponenten –, stoßen selbst die fortschrittlichsten visuellen Systeme oft an ihre Grenzen. Diese Aufgaben erfordern mehr als nur Sehvermögen; sie verlangen ein nuanciertes Tastgefühl und ein Verständnis für physischen Widerstand. Um diese sensorische Lücke zu schließen, hat ein Forschungsteam unter der Leitung von Tailai Cheng, Fan Wu und Kejia Chen TacUMI entwickelt, eine multimodale handgehaltene Schnittstelle, die darauf ausgelegt ist, das komplexe Zusammenspiel von Kraft und taktilem Feedback während menschlicher Demonstrationen zu erfassen und so eine neue Vorlage dafür zu liefern, wie Roboter komplexe physische Interaktionen erlernen könnten.

Die Grenzen der rein visuellen Robotik

Die grundlegende Herausforderung beim modernen Roboterlernen liegt in der „Blackbox“ der physischen Interaktion. Während aktuelle Frameworks wie Diffusion Policy und ACT bei Aufgaben mit kurzem Zeithorizont Erfolge gezeigt haben, behandeln sie eine Demonstration oft als einen monolithischen Datenblock. Für komplexe Aufgaben mit langem Zeithorizont, wie etwa die Kabelmontage, reichen visuelle Beobachtungen und propriozeptive Daten des Roboters – der interne Sinn für die Position der eigenen Gliedmaßen des Roboters – häufig nicht aus. Wenn beispielsweise ein menschlicher Bediener ein Kabel dehnt, um Spannung zu erzeugen, bevor er es in einen Schlitz einführt, mag die visuelle Veränderung vernachlässigbar sein, doch der physische Zustand der Aufgabe hat sich signifikant verändert. Ohne die Fähigkeit, diese Spannung zu „fühlen“, hat ein Roboter Schwierigkeiten, den Übergang zwischen verschiedenen Phasen des Vorgangs zu erkennen, was zu Fehlern bei der Ausführung führt, wenn die Umgebung auch nur geringfügig von den Trainingsdaten abweicht.

Einführung von TacUMI: Ein multimodaler Durchbruch

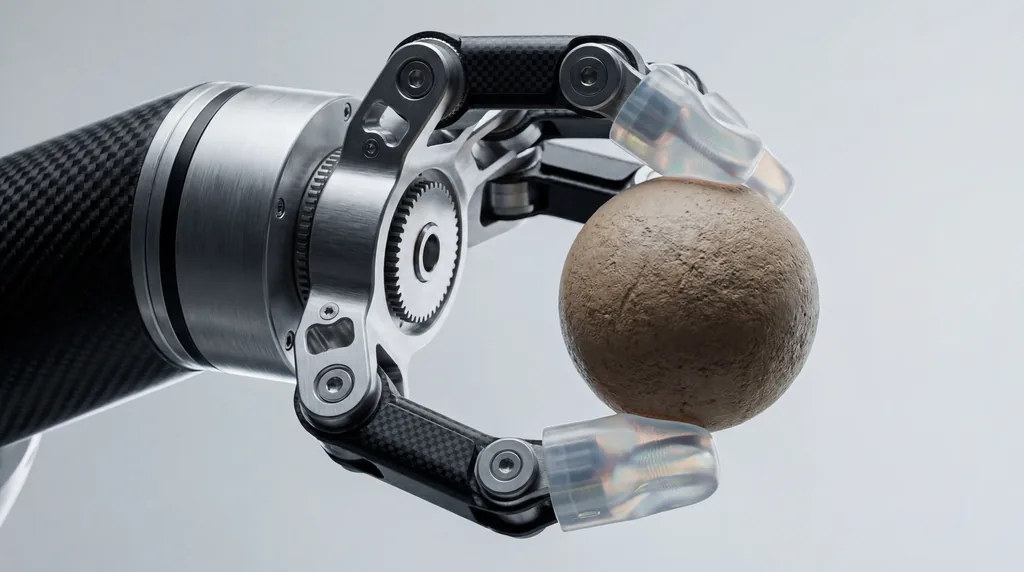

Aufbauend auf dem grundlegenden Universal Manipulation Interface (UMI) haben Forscher der Technischen Universität München, von Agile Robots SE und deren Partner an den Universitäten von Nanjing und Shanghai TacUMI vorgestellt. Dieses System ist ein kompakter, roboterkompatibler Greifer, der für die hochpräzise Datenerfassung entwickelt wurde. Im Gegensatz zu seinen Vorgängern, die sich stark auf Kameras und SLAM-basierte (Simultaneous Localization and Mapping) Posenschätzung verließen, integriert TacUMI eine Reihe spezialisierter Sensoren: ViTac-Sensoren an den Fingerspitzen für hochauflösendes taktiles Mapping, einen 6D-Kraft-Momenten-Sensor am Handgelenk und einen hochpräzisen 6D-Posentracker. Dieses Ensemble ermöglicht die synchronisierte Erfassung visueller, kraftbasierter und taktiler Modalitäten und schafft so einen reichhaltigen, multidimensionalen Datensatz menschlicher Geschicklichkeit.

Das Erfassen der menschlichen Berührung

Das Hardware-Design von TacUMI ist speziell darauf ausgelegt, das „Rauschen“ zu eliminieren, das typischerweise mit handgehaltenen Demonstrationsgeräten verbunden ist. Eines der herausragenden Merkmale ist ein kontinuierlich verriegelbarer Backenmechanismus. Bei herkömmlichen Handgeräten kann die Kraft, die der menschliche Bediener aufwendet, um einen Griff aufrechtzuerhalten, die Fähigkeit der Sensoren stören, die tatsächlichen Interaktionskräfte zwischen dem Werkzeug und dem Objekt aufzuzeichnen. Indem es dem Bediener ermöglicht wird, den Greifer zu verriegeln, sobald ein Objekt gesichert ist, stellt TacUMI sicher, dass die Kraft-Momenten-Sensoren nur die reinen Interaktionsdaten der Aufgabe selbst aufzeichnen. Dies ermöglicht es Menschen, feinfühlige Aufgaben natürlich zu demonstrieren, während das Gerät die Interaktionen unter hoher Spannung erfasst – wie sie bei der Handhabung deformierbarer linearer Objekte (DLO) vorkommen –, ohne dass es zu Verrutschen oder Sensorverunreinigungen kommt.

Semantische Segmentierung und Aufgabenzerlegung

Ein Kernbeitrag der Forschung ist die Entwicklung eines multimodalen Segmentierungs-Frameworks, das zeitliche Modelle nutzt, speziell ein Bi-directional Long Short-Term Memory (BiLSTM)-Netzwerk. Das Ziel dieses Frameworks ist es, Demonstrationen mit langem Zeithorizont in semantisch bedeutsame „Skills“ oder Module zu zerlegen. Durch die Verarbeitung der synchronisierten Ströme taktiler, Kraft- und visueller Daten kann das Modell Ereignisgrenzen erkennen – den genauen Moment, in dem ein Kabel gegriffen wird, den Moment, in dem Spannung angelegt wird, und den Moment, in dem es erfolgreich platziert ist. Diese Zerlegung ist entscheidend für hierarchisches Lernen, bei dem ein Roboter zuerst einzelne motorische Fähigkeiten lernt und dann einen übergeordneten Koordinator, um diese effektiv zu sequenzieren. Dies macht den Lernprozess skalierbarer und interpretierbarer als End-to-End-Ansätze.

Fallstudie: Beherrschung der Montage empfindlicher Elektronik

Um die Wirksamkeit von TacUMI zu validieren, evaluierten die Forscher das System bei einer anspruchsvollen Kabelmontage-Aufgabe, einem Standardprozess der Elektronikfertigung, der weiterhin schwer zu automatisieren ist. Das Experiment erforderte vom Bediener, ein Kabel aufzunehmen, durch eine unübersichtliche Umgebung zu navigieren, eine spezifische Spannung zu erzeugen und den Stecker in ein präzises Gehäuse einzuführen. Die Ergebnisse waren beeindruckend: Das System erreichte eine Segmentierungsgenauigkeit von mehr als 90 Prozent. Entscheidend war, dass die Forschung eine bemerkenswerte Leistungsverbesserung zeigte, je mehr Modalitäten hinzugefügt wurden. Während rein visuelle Modelle oft scheiterten, zwischen den Phasen „Spannen“ und „Einführen“ zu unterscheiden, ermöglichte die Einbeziehung von taktilen und Kraftdaten dem Modell, die Übergangsgrenzen mit hoher Präzision zu bestimmen. Dies beweist, dass multimodale Sensorik für das Verständnis kontaktintensiver Aufgaben unerlässlich ist.

Die Rolle der multi-institutionellen Zusammenarbeit

Die Entwicklung von TacUMI repräsentiert eine bedeutende Zusammenarbeit zwischen mehreren renommierten Institutionen. Hauptautor Tailai Cheng, der sowohl mit der Technischen Universität München als auch mit Agile Robots SE verbunden ist, arbeitete zusammen mit Kejia Chen, Lingyun Chen und anderen Kollegen an der Verfeinerung der Hardware-Software-Integration. Die Beiträge von Fan Wu von der Universität Shanghai und Zhenshan Bing von der Universität Nanjing waren maßgeblich an der Entwicklung des algorithmischen Frameworks beteiligt, das es dem System ermöglicht, über verschiedene Datenerfassungsmethoden hinweg zu generalisieren. Interessanterweise zeigten die Forscher, dass ein Modell, das auf TacUMI-erfassten Daten trainiert wurde, auf Datensätze angewendet werden konnte, die über traditionelle robotische Teleoperation gesammelt wurden, wobei eine vergleichbare Genauigkeit erzielt wurde, was die Vielseitigkeit des Systems über verschiedene Roboterverkörperungen hinweg unterstreicht.

Zukünftige Richtungen für das Roboterlernen durch Demonstration

Der Erfolg der TacUMI-Schnittstelle eröffnet mehrere neue Wege für das Feld des Robot Learning from Demonstration (LfD). Indem es eine praktische Grundlage für die skalierbare Erfassung hochwertiger, multimodaler Daten bietet, bringt das System die Forschung näher an das Ziel, eine menschenähnliche taktile Sensibilität in autonomen Systemen zu erreichen. Die Forscher schlagen vor, dass die nächsten Schritte darin bestehen, TacUMI auf noch vielfältigere und unvorhersehbare industrielle Anwendungen zu skalieren, wie etwa die Handhabung weicher Materialien und die komplexe Montage mit mehreren Werkzeugen. Da Roboter aus starren Fabrikumgebungen in dynamischere Umgebungen vordringen, wird die Fähigkeit, sich durch eine Aufgabe zu „fühlen“ – unterstützt durch Geräte wie TacUMI –, wahrscheinlich ebenso grundlegend werden wie die Fähigkeit zu sehen.

Implikationen für die Robotikindustrie

Für die breitere Robotikindustrie signalisiert TacUMI eine Abkehr von der Abhängigkeit von teuren, sperrigen Teleoperations-Setups. Durch die Senkung der Eintrittsbarriere für die Erfassung anspruchsvoller taktiler Daten ermöglicht diese handgehaltene Schnittstelle eine schnellere Iteration beim Robotertraining. In Sektoren wie der Elektronikfertigung und bei Haushaltsdienstleistungen, wo die Fehlerkosten hoch und die Komplexität der Aufgaben immens sind, könnte die Fähigkeit, Aktionen mit langem Zeithorizont in lernbare, taktil informierte Module zu zerlegen, die für den Einsatz autonomer Lösungen erforderliche Zeit drastisch verkürzen. Wie Fan Wu und das Forschungsteam anmerken, ist die Integration dieser sensorischen Modalitäten nicht nur ein technisches Upgrade; es ist eine notwendige Evolution für Roboter, die in einer physischen Welt operieren sollen, die durch Berührung und Widerstand definiert ist.

Kommentare

Noch keine Kommentare. Seien Sie der Erste!