No cenário em evolução da automação industrial, os robôs têm demonstrado uma proficiência notável na execução de tarefas repetitivas e de alta velocidade, orientados por sistemas sofisticados de visão computacional. No entanto, quando confrontados com cenários "ricos em contato" — como passar um fio fino por um conector ou montar componentes eletrônicos delicados — até mesmo os sistemas visuais mais avançados costumam atingir um limite. Essas tarefas exigem mais do que apenas a visão; elas demandam um senso de tato matizado e uma compreensão da resistência física. Para preencher essa lacuna sensorial, uma equipe de pesquisa liderada por Tailai Cheng, Fan Wu e Kejia Chen desenvolveu o TacUMI, uma interface portátil multimodal projetada para capturar a complexa dança de força e feedback tátil durante demonstrações humanas, fornecendo um novo modelo de como os robôs podem aprender interações físicas complexas.

As Limitações da Robótica Baseada Apenas em Visão

O desafio fundamental no aprendizado robótico moderno reside na "caixa preta" da interação física. Embora frameworks atuais como Diffusion Policy e ACT tenham mostrado sucesso em tarefas de curto horizonte, eles frequentemente tratam uma demonstração como um bloco monolítico de dados. Para tarefas complexas de longo horizonte, como a montagem de cabos, as observações visuais e os dados proprioceptivos do robô — o senso interno da posição dos próprios membros do robô — são frequentemente insuficientes. Por exemplo, quando um operador humano estica um cabo para criar tensão antes de inseri-lo em uma fenda, a mudança visual pode ser insignificante, mas o estado físico da tarefa transitou significativamente. Sem a capacidade de "sentir" essa tensão, um robô tem dificuldade em identificar a transição entre as diferentes etapas da operação, levando a falhas na execução quando o ambiente se desvia, mesmo que ligeiramente, dos dados de treinamento.

Apresentando o TacUMI: Um Avanço Multimodal

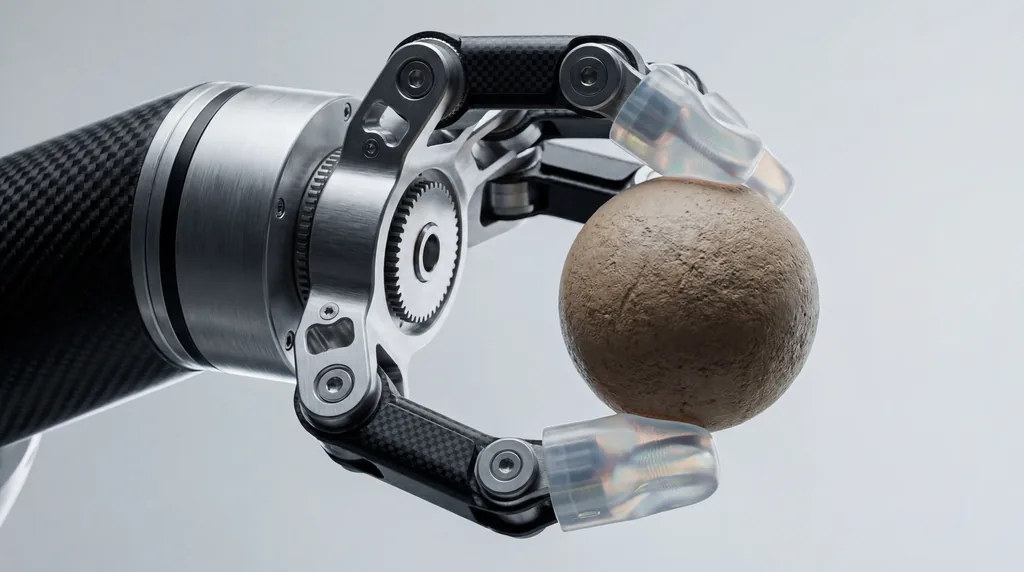

Com base na Universal Manipulation Interface (UMI) fundamental, pesquisadores da Universidade Técnica de Munique, da Agile Robots SE e seus parceiros nas Universidades de Nanjing e Xangai introduziram o TacUMI. Este sistema é uma garra compacta e compatível com robôs, projetada para coleta de dados de alta fidelidade. Ao contrário de seus predecessores, que dependiam fortemente de câmeras e estimativa de pose baseada em SLAM (Localização e Mapeamento Simultâneos), o TacUMI integra um conjunto de sensores especializados: sensores ViTac nas pontas dos dedos para mapeamento tátil de alta resolução, um sensor de força-torque de seis graus de liberdade (6D) no pulso e um rastreador de pose 6D de alta precisão. Esse conjunto permite a aquisição sincronizada de modalidades visuais, de força e táteis, criando um conjunto de dados rico e multidimensional da destreza humana.

Capturando o Toque Humano

O design do hardware do TacUMI foi especificamente projetado para eliminar o "ruído" tipicamente associado a dispositivos de demonstração portáteis. Um dos recursos de destaque é um mecanismo de mandíbula continuamente bloqueável. Em dispositivos portáteis tradicionais, a força exercida pelo operador humano para manter a aderência pode interferir na capacidade dos sensores de registrar as forças de interação reais entre a ferramenta e o objeto. Ao permitir que o operador trave a garra uma vez que o objeto esteja seguro, o TacUMI garante que os sensores de força-torque registrem apenas os dados limpos de interação da tarefa em si. Isso permite que os humanos demonstrem tarefas delicadas de forma natural, enquanto o dispositivo captura as interações de alta tensão — como as encontradas na manipulação de objetos lineares deformáveis (DLO) — sem deslizamento ou contaminação dos sensores.

Segmentação Semântica e Decomposição de Tarefas

Uma contribuição central da pesquisa é o desenvolvimento de um framework de segmentação multimodal que utiliza modelos temporais, especificamente uma rede Long Short-Term Memory Bidirecional (BiLSTM). O objetivo deste framework é decompor demonstrações de longo horizonte em "habilidades" ou módulos semanticamente significativos. Ao processar os fluxos sincronizados de dados táteis, de força e visuais, o modelo pode detectar fronteiras de eventos — o momento exato em que um cabo é agarrado, o momento em que a tensão é aplicada e o momento em que ele é encaixado com sucesso. Essa decomposição é crítica para a aprendizagem hierárquica, onde um robô aprende primeiro habilidades motoras individuais e, em seguida, aprende um coordenador de alto nível para sequenciá-las de forma eficaz, tornando o processo de aprendizagem mais escalável e interpretável do que as abordagens de ponta a ponta (end-to-end).

Estudo de Caso: Dominando a Montagem de Eletrônicos Delicados

Para validar a eficácia do TacUMI, os pesquisadores avaliaram o sistema em uma tarefa desafiadora de montagem de cabos, um elemento básico da montagem eletrônica que continua sendo difícil de automatizar. O experimento exigiu que o operador pegasse um cabo, navegasse em um ambiente desordenado, criasse uma tensão específica e inserisse o conector em um compartimento preciso. Os resultados foram impressionantes: o sistema alcançou mais de 90 por cento de precisão na segmentação. Crucialmente, a pesquisa destacou uma melhoria notável no desempenho à medida que mais modalidades eram adicionadas. Enquanto os modelos baseados apenas em visão muitas vezes falhavam em distinguir entre as fases de "tensionamento" e "inserção", a inclusão de dados táteis e de força permitiu que o modelo identificasse as fronteiras de transição com alta precisão, provando que a detecção multimodal é essencial para a compreensão de tarefas ricas em contato.

O Papel da Colaboração Multi-Institucional

O desenvolvimento do TacUMI representa uma colaboração significativa entre várias instituições de prestígio. O autor principal, Tailai Cheng, associado tanto à Universidade Técnica de Munique quanto à Agile Robots SE, trabalhou ao lado de Kejia Chen, Lingyun Chen e outros colegas para refinar a integração hardware-software. As contribuições de Fan Wu, da Universidade de Xangai, e Zhenshan Bing, da Universidade de Nanjing, foram fundamentais no desenvolvimento do framework algorítmico que permite ao sistema generalizar entre diferentes métodos de coleta de dados. Curiosamente, os pesquisadores demonstraram que um modelo treinado com dados coletados pelo TacUMI poderia ser implantado em conjuntos de dados coletados via teleoperação robótica tradicional, alcançando precisão comparável e demonstrando a versatilidade do sistema em diferentes personificações robóticas.

Direções Futuras para a Aprendizagem Robótica por Demonstração

O sucesso da interface TacUMI abre vários novos caminhos para o campo da Aprendizagem Robótica por Demonstração (LfD). Ao fornecer uma base prática para a coleta escalável de dados multimodais de alta qualidade, o sistema aproxima-se de alcançar uma sensibilidade tátil semelhante à humana em sistemas autônomos. Os pesquisadores sugerem que os próximos passos envolvem a escala do TacUMI para aplicações industriais ainda mais diversas e imprevisíveis, como o manuseio de materiais flexíveis e a montagem complexa com múltiplas ferramentas. À medida que os robôs saem de ambientes de fábrica rígidos para ambientes mais dinâmicos, a capacidade de "sentir" seu caminho através de uma tarefa — facilitada por dispositivos como o TacUMI — provavelmente se tornará tão fundamental quanto a capacidade de ver.

Implicações para a Indústria da Robótica

Para a indústria robótica em geral, o TacUMI sinaliza uma mudança no afastamento da dependência de configurações de teleoperação caras e complicadas. Ao reduzir a barreira de entrada para a coleta de dados táteis sofisticados, esta interface portátil permite uma iteração mais rápida no treinamento de robôs. Em setores como a fabricação de eletrônicos e serviços domésticos, onde o custo da falha é alto e a complexidade das tarefas é imensa, a capacidade de decompor ações de longo horizonte em módulos aprendíveis e informados pelo tato poderia reduzir drasticamente o tempo necessário para implantar soluções autônomas. Como observam Fan Wu e a equipe de pesquisa, a integração dessas modalidades sensoriais não é apenas uma atualização técnica; é uma evolução necessária para robôs destinados a operar em um mundo físico definido pelo toque e pela resistência.

Comments

No comments yet. Be the first!