In het evoluerende landschap van de industriële automatisering hebben robots een opmerkelijke vaardigheid getoond in het uitvoeren van repetitieve taken op hoge snelheid, aangestuurd door geavanceerde computer vision. Echter, wanneer ze geconfronteerd worden met "contact-rijke" scenario's — zoals het door een connector halen van een dunne draad of het assembleren van delicate elektronische componenten — bereiken zelfs de meest geavanceerde visuele systemen vaak een plateau. Deze taken vereisen meer dan alleen zicht; ze vragen om een genuanceerd tastgevoel en een begrip van fysieke weerstand. Om deze zintuiglijke kloof te overbruggen, heeft een onderzoeksteam onder leiding van Tailai Cheng, Fan Wu en Kejia Chen TacUMI ontwikkeld: een multimodale handheld interface die is ontworpen om het ingewikkelde samenspel van kracht en tactiele feedback tijdens menselijke demonstraties vast te leggen, wat een nieuwe blauwdruk biedt voor de manier waarop robots complexe fysieke interacties zouden kunnen leren.

De beperkingen van robotica op basis van alleen visie

De fundamentele uitdaging in het moderne leren van robots ligt in de "black box" van fysieke interactie. Hoewel huidige kaders zoals Diffusion Policy en ACT succes hebben getoond in short-horizon taken, behandelen ze een demonstratie vaak als een monolithisch blok data. Voor complexe, long-horizon taken zoals kabelmontage zijn visuele observaties en proprioceptieve data van de robot — het interne gevoel van de positie van de eigen ledematen van de robot — vaak onvoldoende. Wanneer een menselijke operator bijvoorbeeld een kabel uitrekt om spanning te creëren voordat deze in een gleuf wordt gestoken, kan de visuele verandering verwaarloosbaar zijn, terwijl de fysieke staat van de taak aanzienlijk is veranderd. Zonder het vermogen om deze spanning te "voelen", heeft een robot moeite om de overgang tussen verschillende stadia van de operatie te identificeren, wat leidt tot fouten in de uitvoering wanneer de omgeving zelfs maar enigszins afwijkt van de trainingsdata.

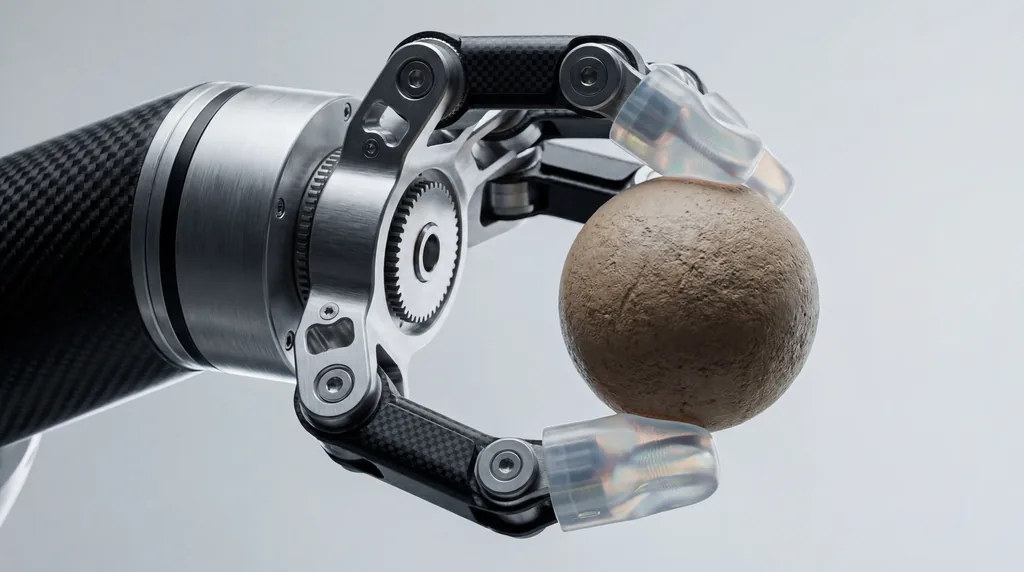

Introductie van TacUMI: Een multimodale doorbraak

Voortbouwend op de fundamentele Universal Manipulation Interface (UMI), hebben onderzoekers van de Technische Universiteit München, Agile Robots SE en hun partners aan de universiteiten van Nanjing en Shanghai TacUMI geïntroduceerd. Dit systeem is een compacte, robot-compatibele grijper die is ontworpen voor high-fidelity dataverzameling. In tegenstelling tot zijn voorgangers, die zwaar leunden op camera's en op SLAM (Simultaneous Localization and Mapping) gebaseerde pose-schatting, integreert TacUMI een reeks gespecialiseerde sensoren: ViTac-sensoren op de vingertoppen voor tactiele mapping met hoge resolutie, een kracht-koppelsensor met zes vrijheidsgraden (6D) bij de pols en een uiterst nauwkeurige 6D-pose-tracker. Dit ensemble maakt de gesynchroniseerde acquisitie van visuele, kracht- en tactiele modaliteiten mogelijk, waardoor een rijke, multidimensionale dataset van menselijke behendigheid ontstaat.

Het vastleggen van de menselijke aanraking

Het hardware-ontwerp van TacUMI is specifiek ontwikkeld om de "ruis" te elimineren die doorgaans gepaard gaat met handbediende demonstratie-apparaten. Een van de opvallende kenmerken is een continu vergrendelbaar klemmechanisme. Bij traditionele handbediende apparaten kan de kracht die de menselijke operator uitoefent om grip te houden de sensoren storen bij het registreren van de werkelijke interactiekrachten tussen het gereedschap en het object. Door de operator de mogelijkheid te geven de grijper te vergrendelen zodra een object is vastgezet, zorgt TacUMI ervoor dat de kracht-koppelsensoren alleen de zuivere interactiedata van de taak zelf registreren. Hierdoor kunnen mensen delicate taken op een natuurlijke manier demonstreren, terwijl het apparaat de interacties met hoge spanning vastlegt — zoals die bij de manipulatie van vervormbare lineaire objecten (DLO's) — zonder slip of sensorvervuiling.

Semantische segmentatie en taakdecompositie

Een kernbijdrage van het onderzoek is de ontwikkeling van een multimediaal segmentatiekader dat gebruikmaakt van temporele modellen, specifiek een Bi-directional Long Short-Term Memory (BiLSTM) netwerk. Het doel van dit kader is om long-horizon demonstraties te ontleden in semantisch betekenisvolle "vaardigheden" of modules. Door de gesynchroniseerde stromen van tactiele, kracht- en visuele data te verwerken, kan het model gebeurtenisgrenzen detecteren — het exacte moment waarop een kabel wordt gegrepen, het moment waarop spanning wordt uitgeoefend en het moment waarop deze succesvol is geplaatst. Deze decompositie is cruciaal voor hiërarchisch leren, waarbij een robot eerst individuele motorische vaardigheden leert en vervolgens een coördinator op hoog niveau leert om deze effectief te sequensen, wat het leerproces schaalbaarder en interpreteerbaarder maakt dan end-to-end benaderingen.

Casestudy: Het beheersen van delicate assemblage van elektronica

Om de effectiviteit van TacUMI te valideren, evalueerden de onderzoekers het systeem op een uitdagende kabelmontage-taak, een basisonderdeel van elektronica-assemblage dat moeilijk te automatiseren blijft. Het experiment vereiste dat de operator een kabel oppakte, door een rommelige omgeving navigeerde, specifieke spanning creëerde en de connector in een nauwkeurige behuizing plaatste. De resultaten waren opvallend: het systeem behaalde een segmentatienauwkeurigheid van meer dan 90 procent. Cruciaal was dat het onderzoek een opmerkelijke verbetering in prestaties liet zien naarmate er meer modaliteiten werden toegevoegd. Waar modellen op basis van alleen visie vaak faalden om onderscheid te maken tussen de fasen van "spannen" en "insteken", stelde de toevoeging van tactiele en krachtdata het model in staat om overgangsgrenzen met hoge precisie aan te wijzen, wat bewijst dat multimodale waarneming essentieel is voor het begrijpen van contact-rijke taken.

De rol van samenwerking tussen meerdere instituten

De ontwikkeling van TacUMI vertegenwoordigt een aanzienlijke samenwerking tussen verschillende prestigieuze instellingen. Hoofdauteur Tailai Cheng, verbonden aan zowel de Technische Universiteit München als Agile Robots SE, werkte samen met Kejia Chen, Lingyun Chen en andere collega's om de hardware-software-integratie te verfijnen. De bijdragen van Fan Wu van de Universiteit van Shanghai en Zhenshan Bing van de Universiteit van Nanjing waren instrumenteel bij het ontwikkelen van het algoritmische kader dat het systeem in staat stelt te generaliseren over verschillende methoden van dataverzameling. Interessant is dat de onderzoekers aantoonden dat een model dat is getraind op met TacUMI verzamelde data, kon worden ingezet op datasets die zijn verzameld via traditionele robotische teleoperatie, waarbij vergelijkbare nauwkeurigheid werd behaald en de veelzijdigheid van het systeem over verschillende robotische verschijningsvormen werd aangetoond.

Toekomstige richtingen voor het leren van robots door demonstratie

Het succes van de TacUMI-interface opent verschillende nieuwe wegen voor het vakgebied van Robot Learning from Demonstration (LfD). Door een praktische basis te bieden voor de schaalbare verzameling van hoogwaardige, multimodale data, brengt het systeem de tactiele gevoeligheid van autonome systemen dichter bij die van de mens. De onderzoekers suggereren dat de volgende stappen bestaan uit het schalen van TacUMI naar nog diversere en onvoorspelbaardere industriële toepassingen, zoals het hanteren van zachte materialen en complexe assemblage met meerdere gereedschappen. Naarmate robots zich verplaatsen van rigide fabrieksinstellingen naar meer dynamische omgevingen, zal het vermogen om hun weg door een taak te "voelen" — gefaciliteerd door apparaten zoals TacUMI — waarschijnlijk even fundamenteel worden als het vermogen om te zien.

Gevolgen voor de robotica-industrie

Voor de bredere robotica-industrie signaleert TacUMI een verschuiving weg van de afhankelijkheid van dure, omslachtige teleoperatie-opstellingen. Door de drempel voor het verzamelen van geavanceerde tactiele data te verlagen, maakt deze handheld interface een snellere iteratie in robottraining mogelijk. In sectoren zoals de elektronicaproductie en huishoudelijke diensten, waar de kosten van falen hoog zijn en de complexiteit van taken enorm, zou het vermogen om long-horizon acties op te splitsen in leerbare, tactiel geïnformeerde modules de tijd die nodig is om autonome oplossingen in te zetten drastisch kunnen verkorten. Zoals Fan Wu en het onderzoeksteam opmerken, is de integratie van deze zintuiglijke modaliteiten niet alleen een technische upgrade; het is een noodzakelijke evolutie voor robots die bedoeld zijn om te opereren in een fysieke wereld die wordt gedefinieerd door aanraking en weerstand.

Comments

No comments yet. Be the first!