En el cambiante panorama de la automatización industrial, los robots han demostrado una competencia notable en la realización de tareas repetitivas de alta velocidad guiadas por sistemas sofisticados de visión artificial. Sin embargo, cuando se enfrentan a escenarios de "contacto intensivo" —como enhebrar un cable delgado en un conector o ensamblar componentes electrónicos delicados— incluso los sistemas visuales más avanzados suelen alcanzar un límite. Estas tareas requieren más que solo la vista; demandan un sentido del tacto matizado y una comprensión de la resistencia física. Para cerrar esta brecha sensorial, un equipo de investigación dirigido por Tailai Cheng, Fan Wu y Kejia Chen ha desarrollado TacUMI, una interfaz portátil multimodal diseñada para capturar la intrincada danza de la fuerza y la retroalimentación táctil durante las demostraciones humanas, proporcionando un nuevo modelo de cómo los robots podrían aprender interacciones físicas complejas.

Las limitaciones de la robótica basada únicamente en la visión

El desafío fundamental en el aprendizaje robótico moderno reside en la "caja negra" de la interacción física. Si bien los marcos de trabajo actuales como Diffusion Policy y ACT han tenido éxito en tareas de horizonte corto, a menudo tratan una demostración como un bloque monolítico de datos. Para tareas complejas de horizonte largo, como el montaje de cables, las observaciones visuales y los datos propioceptivos del robot —el sentido interno de la posición de sus propias extremidades— suelen ser insuficientes. Por ejemplo, cuando un operador humano estira un cable para crear tensión antes de insertarlo en una ranura, el cambio visual puede ser insignificante, pero el estado físico de la tarea ha transitado significativamente. Sin la capacidad de "sentir" esta tensión, un robot tiene dificultades para identificar la transición entre las diferentes etapas de la operación, lo que provoca fallos en la ejecución cuando el entorno se desvía aunque sea ligeramente de los datos de entrenamiento.

Presentando TacUMI: Un avance multimodal

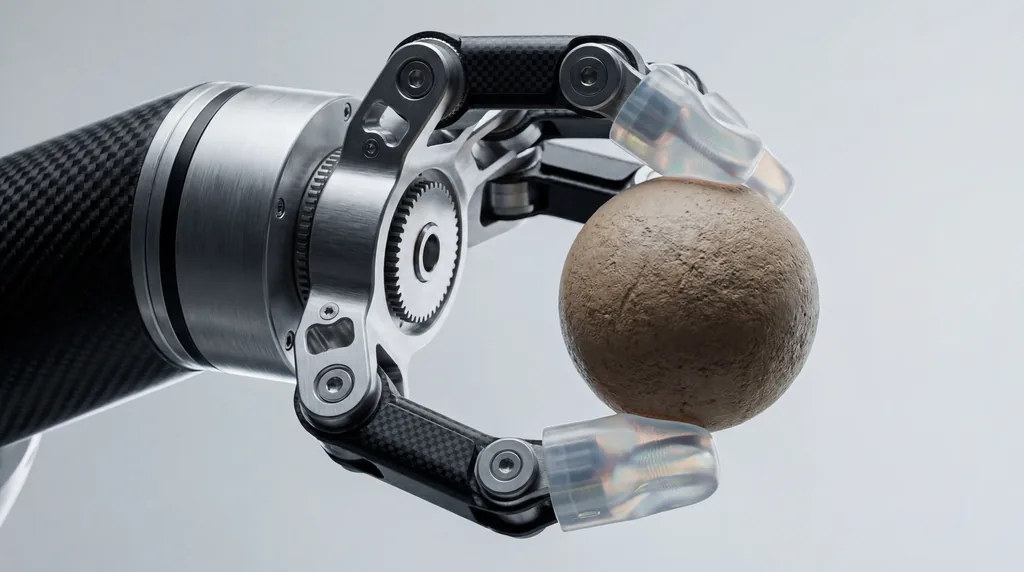

Basándose en la Universal Manipulation Interface (UMI) fundacional, los investigadores de la Universidad Técnica de Múnich, Agile Robots SE, y sus socios en las universidades de Nanjing y Shanghái han presentado TacUMI. Este sistema es una pinza compacta y compatible con robots diseñada para la recopilación de datos de alta fidelidad. A diferencia de sus predecesores, que dependían en gran medida de cámaras y estimación de pose basada en SLAM (Localización y Mapeo Simultáneos), TacUMI integra un conjunto de sensores especializados: sensores ViTac en las puntas de los dedos para un mapeo táctil de alta resolución, un sensor de fuerza-par de seis grados de libertad (6D) en la muñeca y un rastreador de pose 6D de alta precisión. Este conjunto permite la adquisición sincronizada de modalidades visuales, de fuerza y táctiles, creando un conjunto de datos multidimensional enriquecido sobre la destreza humana.

Capturando el toque humano

El diseño de hardware de TacUMI está específicamente diseñado para eliminar el "ruido" típicamente asociado con los dispositivos de demostración portátiles. Una de las características más destacadas es un mecanismo de mandíbula bloqueable de forma continua. En los dispositivos portátiles tradicionales, la fuerza ejercida por el operador humano para mantener el agarre puede interferir con la capacidad de los sensores para registrar las fuerzas de interacción reales entre la herramienta y el objeto. Al permitir que el operador bloquee la pinza una vez que el objeto está asegurado, TacUMI garantiza que los sensores de fuerza-par registren solo los datos limpios de la interacción de la tarea en sí. Esto permite a los humanos demostrar tareas delicadas de forma natural, mientras el dispositivo captura las interacciones de alta tensión —como las que se encuentran en la manipulación de objetos lineales deformables (DLO)— sin deslizamientos ni contaminación de los sensores.

Segmentación semántica y descomposición de tareas

Una contribución central de la investigación es el desarrollo de un marco de segmentación multimodal que utiliza modelos temporales, específicamente una red de Memoria a Largo Plazo de Corto Alcance Bidireccional (BiLSTM). El objetivo de este marco es descomponer las demostraciones de horizonte largo en "habilidades" o módulos semánticamente significativos. Al procesar los flujos sincronizados de datos táctiles, de fuerza y visuales, el modelo puede detectar límites de eventos: el momento exacto en que se agarra un cable, el momento en que se aplica la tensión y el momento en que se asienta con éxito. Esta descomposición es fundamental para el aprendizaje jerárquico, donde un robot aprende primero habilidades motoras individuales y luego aprende un coordinador de alto nivel para secuenciarlas de manera efectiva, lo que hace que el proceso de aprendizaje sea más escalable e interpretable que los enfoques de extremo a extremo (end-to-end).

Estudio de caso: Dominando el ensamblaje de electrónica delicada

Para validar la eficacia de TacUMI, los investigadores evaluaron el sistema en una desafiante tarea de montaje de cables, un elemento básico del ensamblaje electrónico que sigue siendo difícil de automatizar. El experimento requería que el operador recogiera un cable, navegara por un entorno saturado, creara una tensión específica e insertara el conector en un alojamiento preciso. Los resultados fueron sorprendentes: el sistema logró una precisión de segmentación superior al 90 por ciento. Crucialmente, la investigación destacó una mejora notable en el rendimiento a medida que se añadían más modalidades. Mientras que los modelos que solo utilizaban visión a menudo no lograban distinguir entre las fases de "tensado" e "inserción", la inclusión de datos táctiles y de fuerza permitió al modelo identificar los límites de transición con alta precisión, demostrando que la detección multimodal es esencial para comprender tareas de contacto intensivo.

El papel de la colaboración multiinstitucional

El desarrollo de TacUMI representa una colaboración significativa entre varias instituciones prestigiosas. El autor principal, Tailai Cheng, asociado tanto con la Universidad Técnica de Múnich como con Agile Robots SE, trabajó junto a Kejia Chen, Lingyun Chen y otros colegas para perfeccionar la integración de hardware y software. Las contribuciones de Fan Wu, de la Universidad de Shanghái, y Zhenshan Bing, de la Universidad de Nanjing, fueron fundamentales para desarrollar el marco algorítmico que permite al sistema generalizarse a través de diferentes métodos de recopilación de datos. Curiosamente, los investigadores demostraron que un modelo entrenado con datos recopilados por TacUMI podía desplegarse en conjuntos de datos recopilados mediante teleoperación robótica tradicional, logrando una precisión comparable y mostrando la versatilidad del sistema en diferentes encarnaciones robóticas.

Direcciones futuras para el Aprendizaje Robótico por Demostración

El éxito de la interfaz TacUMI abre varias vías nuevas para el campo del Aprendizaje Robótico por Demostración (LfD). Al proporcionar una base práctica para la recopilación escalable de datos multimodales de alta calidad, el sistema acerca el objetivo de lograr una sensibilidad táctil similar a la humana en sistemas autónomos. Los investigadores sugieren que los próximos pasos implican escalar TacUMI a aplicaciones industriales aún más diversas e impredecibles, como el manejo de materiales blandos y el ensamblaje complejo con múltiples herramientas. A medida que los robots salen de los entornos rígidos de las fábricas y entran en entornos más dinámicos, la capacidad de "sentir" su camino a través de una tarea —facilitada por dispositivos como TacUMI— probablemente se volverá tan fundamental como la capacidad de ver.

Implicaciones para la industria de la robótica

Para la industria de la robótica en general, TacUMI señala un cambio que se aleja de la dependencia de configuraciones de teleoperación costosas y engorrosas. Al reducir la barrera de entrada para recopilar datos táctiles sofisticados, esta interfaz portátil permite una iteración más rápida en el entrenamiento de robots. En sectores como la fabricación de productos electrónicos y los servicios domésticos, donde el coste del fracaso es alto y la complejidad de las tareas es inmensa, la capacidad de desglosar acciones de horizonte largo en módulos aprendibles e informados tácticamente podría reducir drásticamente el tiempo necesario para desplegar soluciones autónomas. Como señalan Fan Wu y el equipo de investigación, la integración de estas modalidades sensoriales no es solo una mejora técnica; es una evolución necesaria para los robots destinados a operar en un mundo físico definido por el tacto y la resistencia.

Comments

No comments yet. Be the first!