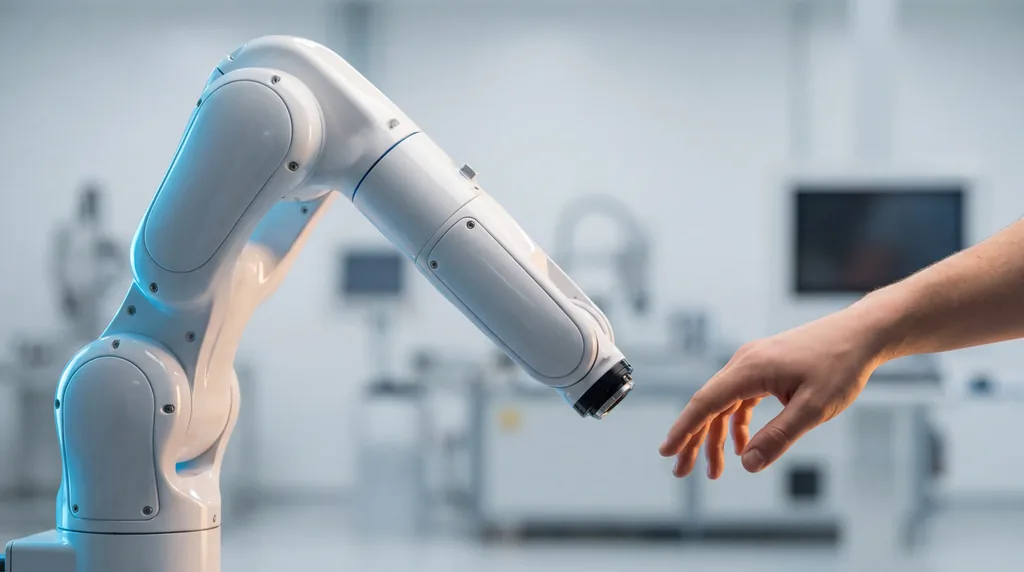

Vertrauen entschlüsseln: Wie Machine-Learning-Modelle den menschlichen Komfort bei der Roboter-Kollaboration vorhersagen

Da die Industrie 5.0 den Fokus auf eine menschenzentrierte Fertigung verlagert, ist die Fähigkeit von Robotern, das menschliche Vertrauen einzuschätzen, zu einer kritischen Sicherheitsanforderung geworden. Forscher der Aalborg University und des Istituto Italiano di Tecnologia (IIT) haben ein datenbasiertes Framework entwickelt, das es Maschinen ermöglicht, Verhaltenssignale zu interpretieren. Dies erlaubt es ihnen, ihre Bewegungen anzupassen und in Echtzeit eine Beziehung zu den menschlichen Bedienern aufzubauen. Indem das Team über traditionelle Umfragen nach der Interaktion hinausgeht, konnte es erfolgreich demonstrieren, dass Maschinen die immaterielle Qualität des menschlichen Vertrauens durch physische Bewegungs- und Interaktionsparameter quantifizieren können, wobei hohe Vorhersagegenauigkeiten in risikoreichen industriellen Umgebungen erzielt wurden.

Die Evolution der Industrie 5.0

Die Industrielandschaft durchläuft derzeit einen Paradigmenwechsel von der Industrie 4.0 – die Hypereffizienz und Massenautomatisierung priorisierte – hin zu den nuancierteren Zielen der Industrie 5.0. Diese neue Ära betont die menschenzentrierte Fertigung, in der kollaborative Roboter (Cobots) nicht nur Werkzeuge sind, sondern Partner, die an der Seite menschlicher Bediener arbeiten. Dieser Übergang erfordert einen starken Fokus auf Arbeitssicherheit, Ergonomie und psychologisches Wohlbefinden. In einem kollaborativen Umfeld reicht „blinde“ Automatisierung nicht mehr aus; ein Roboter, der sich zu schnell oder zu nah an einer Bedienperson bewegt, kann Stress auslösen, zu menschlichen Fehlern führen oder sogar physischen Schaden verursachen.

Vertrauen ist der Dreh- und Angelpunkt dieser Interaktion. Wie von Forschern auf diesem Gebiet definiert, ist Vertrauen die Überzeugung, dass ein Akteur die Ziele einer Person unterstützt, insbesondere in unsicheren oder vulnerablen Situationen. In industriellen Umgebungen ist ein Ungleichgewicht des Vertrauens gefährlich: Untervertrauen kann zur Überlastung des Bedieners führen, da die Arbeiter die Maschine mikromanagen, während Übervertrauen in Selbstgefälligkeit und Sicherheitsrisiken resultieren kann. Um dies zu adressieren, suchte das Forschungsteam, darunter Giulio Campagna und Arash Ajoudani, nach einem System, das es Robotern ermöglicht, diese subtilen psychologischen Zustände wahrzunehmen und ihr Verhalten entsprechend neu zu kalibrieren.

Die Mechanik der Vertrauensmodellierung

Der Kern der Studie, die kürzlich in IEEE Robotics and Automation Letters veröffentlicht wurde, dreht sich um ein neuartiges datenbasiertes Framework, das darauf ausgelegt ist, Vertrauen durch Verhaltensindikatoren zu bewerten. Das Herzstück bildet ein PBO-Algorithmus (Preference-Based Optimization). Im Gegensatz zu herkömmlichen Modellen, die die Präferenzen eines Nutzers lediglich vermuten, generiert der PBO-Algorithmus spezifische Roboter-Trajektorien und holt dann aktiv Feedback vom Bediener ein. Dies schafft eine Rückkopplungsschleife, in der der Roboter lernt, welche Bewegungen – wie spezifische Ausführungszeiten oder Trennungsabstände – vom menschlichen Partner als vertrauenswürdig wahrgenommen werden.

Die Forschung wurde von einem multidisziplinären Team durchgeführt, darunter Marta Lagomarsino und Marta Lorenzini vom Human-Robot Interfaces and Interaction Lab am IIT, zusammen mit Forschern des Human-Robot Interaction Lab der Aalborg University. Durch die Quantifizierung subjektiver menschlicher Gefühle in mathematische Interaktionsparameter hat das Team die Lücke zwischen menschlicher Psychologie und Robotersteuerung geschlossen. Das Framework optimiert drei Schlüsselvariablen: die Ausführungszeit des Roboters, den physischen Abstand zwischen Mensch und Maschine sowie die vertikale Nähe des Endeffektors des Roboters zum Kopf des Nutzers.

Übersetzung von Verhalten in Daten

Eine große Herausforderung in der Robotik ist der Übergang von der qualitativen Beobachtung zur quantitativen prädiktiven Modellierung. Um dies zu überwinden, identifizierten die Forscher spezifische Verhaltensindikatoren – abgeleitet sowohl aus der Körpersprache des Menschen als auch aus der Eigenbewegung des Roboters –, die das Vertrauensniveau signalisieren. Menschliche Faktoren wurden mittels Ganzkörper-Motion-Capture verfolgt, wobei der Kopf und der Oberkörper auf Anzeichen von Zögern oder Wohlbefinden überwacht wurden. Diese Indikatoren wurden dann mit den Bewegungscharakteristiken des Roboters gepaart, um eine ganzheitliche Sicht auf die Zusammenarbeit zu erhalten.

Indem sie explizites Bediener-Feedback als „Ground Truth“ verwendeten, trainierten die Forscher Machine-Learning-Modelle darauf, die physischen Signaturen von Vertrauen zu erkennen. Hauptautor Giulio Campagna und seine Kollegen konzentrierten sich auf die dynamische Beziehung zwischen der Art und Weise, wie sich ein Mensch als Reaktion auf den Pfad eines Roboters bewegt. Diese Methodik ermöglicht es dem Modell, Vertrauenspräferenzen vorherzusagen, selbst wenn der Bediener kein aktives Feedback gibt, wodurch stilles physisches Verhalten in einen reichhaltigen Datenstrom umgewandelt wird, der den nächsten Schritt des Roboters informiert.

Fallstudie: Simulation in der chemischen Industrie

Um das Framework in einer realistischen, risikoreichen Umgebung zu testen, implementierte das Team ein Szenario, das die gefährliche Aufgabe des Mischens von Chemikalien beinhaltete. In dieser Simulation unterstützte ein Robotermanipulator einen menschlichen Bediener beim Gießen und Transportieren von chemischen Stoffen. Diese Umgebung wurde gezielt gewählt, da das Gefahrenpotenzial – und damit die Notwendigkeit von Vertrauen – von Natur aus hoch ist. Das Experiment umfasste die Verfolgung der Ganzkörperbewegung des Bedieners, während der Roboter verschiedene Trajektorien basierend auf den Parametern des PBO-Algorithmus ausführte.

Die Ergebnisse waren überzeugend. Das Forschungsteam evaluierte mehrere Machine-Learning-Modelle, wobei der „Voting Classifier“ eine herausragende Genauigkeitsrate von 84,07 % erreichte. Noch beeindruckender war, dass das Modell einen Area Under the ROC Curve (AUC-ROC)-Wert von 0,90 verzeichnete – eine Metrik, die eine hohe Zuverlässigkeit und eine starke Fähigkeit zur Unterscheidung zwischen verschiedenen Vertrauensniveaus anzeigt. Diese Kennzahlen legen nahe, dass das Framework nicht nur rät, sondern die Beziehung zwischen menschlicher Bewegung und internen Vertrauenszuständen präzise dekodiert.

Zukünftige Auswirkungen auf die Arbeitssicherheit

Die Auswirkungen dieser Forschung reichen weit über das Labor hinaus. Durch die Integration von Echtzeit-Vertrauensmessung in Industrieroboter können Unternehmen die Arbeitssicherheit erheblich verbessern. Ein Roboter, der das Unbehagen eines Bedieners spürt, kann seine Bewegungen autonom verlangsamen oder seinen Abstand vergrößern, wodurch die kognitive Belastung und der Stress des Bedieners reduziert werden. Dies schafft ein „Closed-Loop“-System, in dem der Roboter sein Verhalten ständig neu kalibriert, um das optimale Vertrauensniveau aufrechtzuerhalten und Unfälle zu verhindern, die oft aus Reibungen zwischen Mensch und Roboter resultieren.

Darüber hinaus verleiht die Verwendung von SHAP-Werten (SHapley Additive exPlanations) in der Studie der KI eine Ebene der Erklärbarkeit. Dies ermöglicht es Forschern genau zu sehen, welche Verhaltensindikatoren – wie die Geschwindigkeit des Zurückweichens eines Menschen oder der Neigungswinkel seines Kopfes – den Vertrauenswert am stärksten beeinflussen. Während Arash Ajoudani und das Team am IIT diese Modelle weiter verfeinern, wird sich der Fokus wahrscheinlich in Richtung Personalisierung verschieben. Zukünftige Systeme könnten in der Lage sein, sich an die einzigartigen Persönlichkeitsmerkmale und emotionalen Reaktionen einzelner Arbeiter anzupassen und so ein intuitiveres und widerstandsfähigeres kollaboratives Ökosystem zu fördern. In der Welt der Industrie 5.0 könnte der effizienteste Roboter bald derjenige sein, der seinen menschlichen Partner am besten versteht.

Kommentare

Noch keine Kommentare. Seien Sie der Erste!