Nel panorama in continua evoluzione dell'automazione industriale, i robot hanno dimostrato una notevole competenza nell'eseguire compiti ripetitivi e ad alta velocità guidati da una sofisticata visione artificiale. Tuttavia, quando si trovano di fronte a scenari "ricchi di contatto" — come l'inserimento di un sottile filo in un connettore o l'assemblaggio di delicati componenti elettronici — anche i sistemi visivi più avanzati raggiungono spesso una fase di stallo. Questi compiti richiedono più della semplice vista; esigono un senso del tatto sfumato e una comprensione della resistenza fisica. Per colmare questo divario sensoriale, un team di ricerca guidato da Tailai Cheng, Fan Wu e Kejia Chen ha sviluppato TacUMI, un'interfaccia portatile multi-modale progettata per catturare l'intricata danza della forza e del feedback tattile durante le dimostrazioni umane, fornendo un nuovo modello su come i robot potrebbero apprendere interazioni fisiche complesse.

I limiti della robotica basata solo sulla visione

La sfida fondamentale nel moderno apprendimento robotico risiede nella "scatola nera" dell'interazione fisica. Sebbene gli attuali framework come Diffusion Policy e ACT abbiano mostrato successo in compiti a breve orizzonte, spesso trattano una dimostrazione come un blocco monolitico di dati. Per compiti complessi a lungo orizzonte come il montaggio di cavi, le osservazioni visive e i dati propriocettivi del robot — il senso interno della posizione degli arti del robot stesso — sono frequentemente insufficienti. Ad esempio, quando un operatore umano tende un cavo per creare tensione prima di inserirlo in una fessura, il cambiamento visivo potrebbe essere trascurabile, eppure lo stato fisico del compito è mutato significativamente. Senza la capacità di "sentire" questa tensione, un robot fatica a identificare la transizione tra le diverse fasi dell'operazione, portando a fallimenti nell'esecuzione quando l'ambiente devia anche leggermente dai dati di addestramento.

Presentazione di TacUMI: una svolta multi-modale

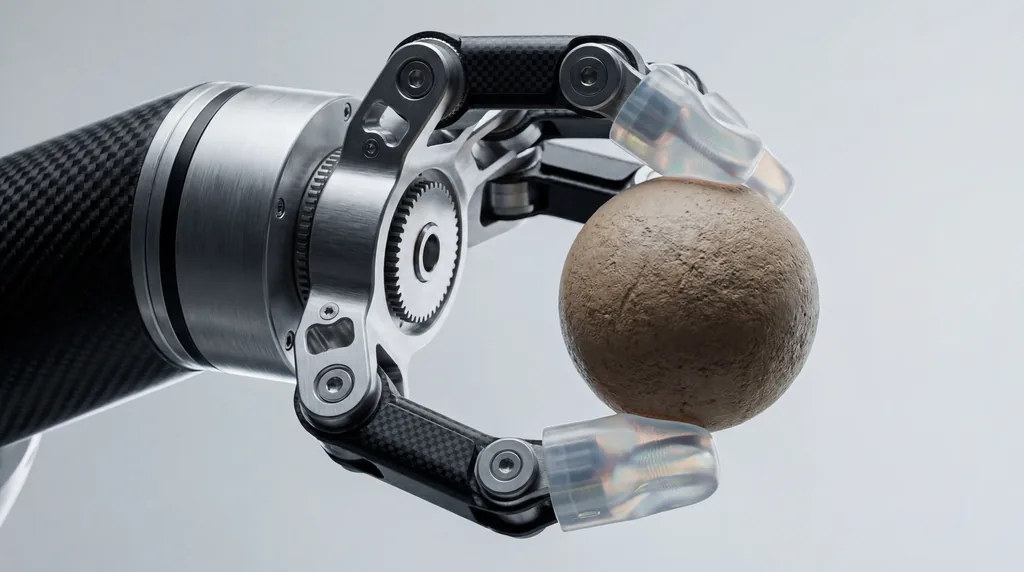

Basandosi sulla fondamentale Universal Manipulation Interface (UMI), i ricercatori della Università Tecnica di Monaco (TUM), di Agile Robots SE e i loro partner delle Università di Nanchino e Shanghai hanno introdotto TacUMI. Questo sistema è una pinza compatta e compatibile con i robot, progettata per la raccolta di dati ad alta fedeltà. A differenza dei suoi predecessori, che si affidavano pesantemente a telecamere e alla stima della posa basata su SLAM (Simultaneous Localization and Mapping), TacUMI integra una suite di sensori specializzati: sensori ViTac sui polpastrelli per la mappatura tattile ad alta risoluzione, un sensore di forza-coppia a sei gradi di libertà (6D) sul polso e un tracciatore di posa 6D ad alta precisione. Questo insieme consente l'acquisizione sincronizzata di modalità visive, di forza e tattili, creando un set di dati ricco e multidimensionale della destrezza umana.

Catturare il tocco umano

Il design hardware di TacUMI è specificamente progettato per eliminare il "rumore" tipicamente associato ai dispositivi di dimostrazione portatili. Una delle caratteristiche principali è un meccanismo a ganasce bloccabili in modo continuo. Nei dispositivi portatili tradizionali, la forza esercitata dall'operatore umano per mantenere la presa può interferire con la capacità dei sensori di registrare le effettive forze di interazione tra l'utensile e l'oggetto. Consentendo all'operatore di bloccare la pinza una volta assicurato l'oggetto, TacUMI garantisce che i sensori di forza-coppia registrino solo i dati puliti dell'interazione del compito stesso. Ciò consente agli esseri umani di dimostrare compiti delicati in modo naturale, mentre il dispositivo cattura le interazioni ad alta tensione — come quelle che si trovano nella manipolazione di oggetti lineari deformabili (DLO) — senza scivolamenti o contaminazioni dei sensori.

Segmentazione semantica e decomposizione dei compiti

Un contributo fondamentale della ricerca è lo sviluppo di un framework di segmentazione multi-modale che utilizza modelli temporali, nello specifico una rete Bi-directional Long Short-Term Memory (BiLSTM). L'obiettivo di questo framework è scomporre le dimostrazioni a lungo orizzonte in "skill" o moduli semanticamente significativi. Elaborando i flussi sincronizzati di dati tattili, di forza e visivi, il modello può rilevare i confini degli eventi: il momento esatto in cui un cavo viene afferrato, il momento in cui viene applicata la tensione e il momento in cui viene inserito con successo. Questa decomposizione è fondamentale per l'apprendimento gerarchico, in cui un robot apprende prima le singole abilità motorie e poi apprende un coordinatore di alto livello per sequenziarle efficacemente, rendendo il processo di apprendimento più scalabile e interpretabile rispetto agli approcci end-to-end.

Case Study: padroneggiare l'assemblaggio di componenti elettronici delicati

Per convalidare l'efficacia di TacUMI, i ricercatori hanno valutato il sistema in un impegnativo compito di montaggio di cavi, un elemento cardine dell'assemblaggio elettronico che rimane difficile da automatizzare. L'esperimento richiedeva all'operatore di raccogliere un cavo, navigare in un ambiente ingombro, creare una tensione specifica e inserire il connettore in un alloggiamento preciso. I risultati sono stati sorprendenti: il sistema ha raggiunto un'accuratezza di segmentazione superiore al 90 percento. Fondamentalmente, la ricerca ha evidenziato un notevole miglioramento delle prestazioni man mano che venivano aggiunte più modalità. Mentre i modelli basati solo sulla visione spesso non riuscivano a distinguere tra le fasi di "tensionamento" e "inserimento", l'inclusione di dati tattili e di forza ha permesso al modello di individuare i confini di transizione con alta precisione, dimostrando che il rilevamento multi-modale è essenziale per comprendere i compiti ricchi di contatto.

Il ruolo della collaborazione multi-istituzionale

Lo sviluppo di TacUMI rappresenta una collaborazione significativa tra diverse prestigiose istituzioni. L'autore principale Tailai Cheng, associato sia alla Università Tecnica di Monaco che ad Agile Robots SE, ha lavorato insieme a Kejia Chen, Lingyun Chen e altri colleghi per perfezionare l'integrazione hardware-software. I contributi di Fan Wu della Università di Shanghai e di Zhenshan Bing della Università di Nanchino sono stati determinanti nello sviluppo del framework algoritmico che consente al sistema di generalizzare tra diversi metodi di raccolta dati. È interessante notare che i ricercatori hanno dimostrato che un modello addestrato su dati raccolti da TacUMI potrebbe essere implementato su set di dati raccolti tramite la tradizionale teleoperazione robotica, ottenendo un'accuratezza comparabile e mettendo in mostra la versatilità del sistema attraverso diverse incarnazioni robotiche.

Direzioni future per l'apprendimento robotico da dimostrazione

Il successo dell'interfaccia TacUMI apre diverse nuove strade per il campo del Robot Learning from Demonstration (LfD). Fornendo una base pratica per la raccolta scalabile di dati multi-modali di alta qualità, il sistema avvicina il traguardo del raggiungimento di una sensibilità tattile simile a quella umana nei sistemi autonomi. I ricercatori suggeriscono che i prossimi passi prevedano il dimensionamento di TacUMI per applicazioni industriali ancora più diverse e imprevedibili, come la manipolazione di materiali morbidi e l'assemblaggio complesso multi-utensile. Man mano che i robot escono dai rigidi contesti di fabbrica per entrare in ambienti più dinamici, la capacità di "farsi strada" attraverso un compito — facilitata da dispositivi come TacUMI — diventerà probabilmente fondamentale quanto la capacità di vedere.

Implicazioni per l'industria della robotica

Per l'industria della robotica in generale, TacUMI segnala un allontanamento dalla dipendenza da configurazioni di teleoperazione costose e ingombranti. Abbassando la barriera all'ingresso per la raccolta di sofisticati dati tattili, questa interfaccia portatile consente un'iterazione più rapida nell'addestramento dei robot. In settori come la produzione di elettronica e i servizi domestici, dove il costo del fallimento è alto e la complessità dei compiti è immensa, la capacità di scomporre azioni a lungo orizzonte in moduli apprendibili e informati dal tatto potrebbe ridurre drasticamente il tempo richiesto per implementare soluzioni autonome. Come osservano Fan Wu e il team di ricerca, l'integrazione di queste modalità sensoriali non è solo un aggiornamento tecnico; è un'evoluzione necessaria per i robot destinati a operare in un mondo fisico definito dal tocco e dalla resistenza.

Comments

No comments yet. Be the first!