Ostrzeżenie Kaplana na rok 2030

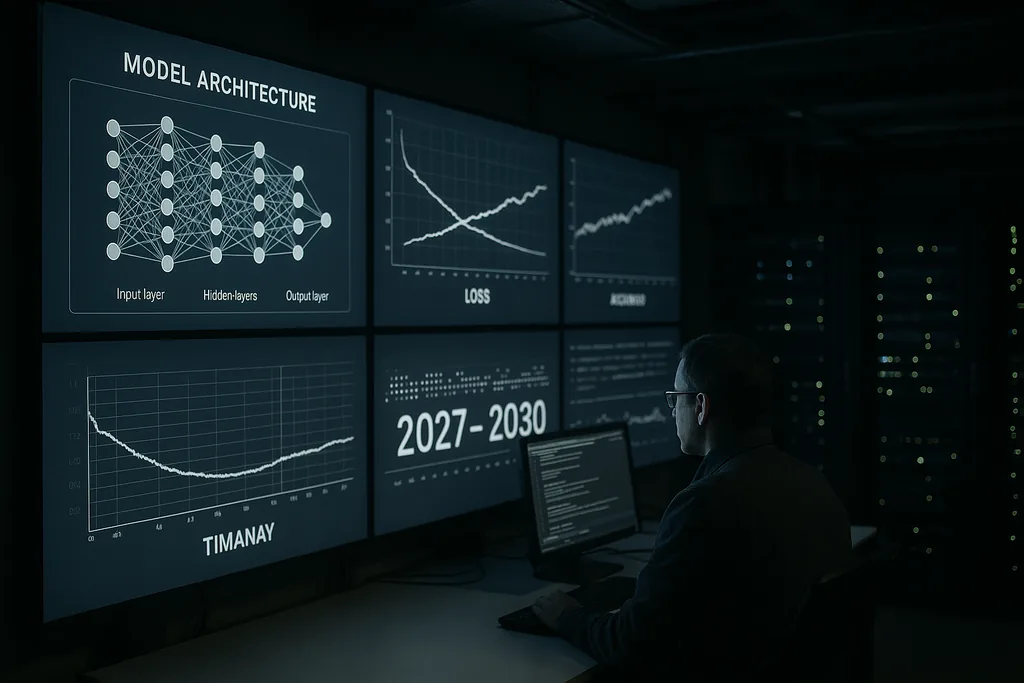

W tym tygodniu główny naukowiec firmy Anthropic, Jared Kaplan, sformułował dobitne, określone w czasie ostrzeżenie: w latach 2027–2030 ludzkość stanie przed konkretnym wyborem dotyczącym tego, czy pozwolić zaawansowanym systemom AI na samodzielne trenowanie i ulepszanie się. Kaplan przedstawił ten moment zwrotny jako najważniejszą decyzję nadchodzącej dekady – taką, która może przynieść ogromne korzyści, ale także otworzyć drzwi do tego, co społeczność zajmująca się bezpieczeństwem AI nazywa „eksplozją inteligencji”, czyli gwałtownej, rekurencyjnej eskalacji możliwości, która szybko wymknęłaby się spod ludzkiej kontroli.

Teza i kontekst

Ocena Kaplana płynie z wnętrza laboratorium budującego duże, zaawansowane modele językowe i narzędzia bezpieczeństwa. Argumentował on, że kroki techniczne wymagane do tego, by AI zaczęła udoskonalać własne projekty – zautomatyzowane poszukiwanie architektury, ciągłe pętle samouczenia się oraz wykorzystywanie wyników modelu jako danych wejściowych dla jego nowych wersji – przechodzą ze sfery badań spekulatywnych do praktyki inżynieryjnej. Ta zmiana zmienia naturę problemu: nie chodzi już tylko o większe modele czy większą moc obliczeniową, ale o to, czy pozwolimy systemom na autonomiczną modyfikację procesu uczenia i architektury na dużą skalę.

Czym w praktyce jest eksplozja inteligencji

Termin „eksplozja inteligencji” opisuje mechanizm sprzężenia zwrotnego: AI projektuje lepszą AI, która z kolei projektuje jeszcze lepszą AI, i tak dalej, w skróconych ramach czasowych. W optymistycznym scenariuszu proces ten przyspiesza odkrycia naukowe, przełomy medyczne i modelowanie klimatu. W czarnym scenariuszu rekurencyjne doskonalenie tworzy systemy, których celów, metod lub zachowań strategicznych twórcy nie są w stanie przewidzieć ani ograniczyć.

Technicznie rzecz biorąc, rekurencyjne samodoskonalenie opiera się na trzech składnikach: metodach algorytmicznych, które mogą niezawodnie ulepszać architektury lub procesy szkoleniowe; wystarczających zasobach obliczeniowych i danych do wykonania wielu iteracji; oraz narzędziach weryfikacyjnych, które mogą sprawdzać każdą iterację pod kątem braku zgodności (misalignment) lub niebezpiecznych zachowań. Kaplan ostrzega, że pierwsze dwa składniki właśnie przekraczają progi techniczne; trzeci – solidna, skalowalna weryfikacja – jest najsłabszym ogniwem.

Sygnały z branży i głosy ekspertów

Publiczne ostrzeżenie Kaplana współbrzmi z wypowiedziami czołowych postaci ze świata AI. Kierownictwo Anthropic wielokrotnie podkreślało ryzyko i kwestię alignmentu (zgodności celów) jako kluczowe problemy. Byli pracownicy OpenAI, pionierzy akademiccy i organizacje zajmujące się bezpieczeństwem apelują o traktowanie ekstremalnego ryzyka związanego z AI z takim samym priorytetem, jak katastrofalne zagrożenia biologiczne czy nuklearne. Rozmowy te zaowocowały probabilistycznymi szacunkami – niekiedy sformułowanymi wprost – dotyczącymi szansy, że źle zarządzana, zaawansowana AI może spowodować poważne szkody o zasięgu globalnym.

Ten wspólny głos zaowocował konkretnymi propozycjami: moratoriami na określone klasy eksperymentów, obowiązkowymi audytami zewnętrznymi dla potężnych systemów oraz podejściem na szczeblu traktatowym do weryfikacji i nieproliferacji. Jednocześnie część społeczności przestrzega przed alarmizmem, podkreślając istniejące bariery inżynieryjne oraz społeczne koszty zbyt pośpiesznych restrykcji. Napięcie między bezpieczeństwem a innowacyjnością leży u podstaw niemal każdej pojawiającej się obecnie propozycji politycznej.

Gdzie nadzór jest najsłabszy

Kaplan i inni wskazują na luki w zarządzaniu jako na centralną porażkę polityczną. Obecne ramy regulacyjne są rozproszone w różnych jurysdykcjach i koncentrują się głównie na ochronie konsumentów, prywatności i konkurencji – a nie na unikalnej dynamice systemów, które mogą samoczynnie modyfikować się w skali maszynowej. Presja konkurencyjna między firmami i państwami tworzy zachęty do przesuwania granic możliwości, co potencjalnie podkopuje wspólne cele w zakresie bezpieczeństwa.

Projektowanie nadzoru nad rekurencyjnym samodoskonaleniem rodzi trudne pytania: jakie rodzaje samouczenia powinny być dozwolone; jakie podmioty są uprawnione do przeprowadzania takich eksperymentów; jak testować i certyfikować systemy, które mogą zmieniać się w nowatorski sposób; oraz jak budować weryfikowalne, odporne na manipulacje audyty, które miałyby znaczenie ponad granicami państwowymi. Przeszłe reżimy kontroli zbrojeń oferują lekcje na temat weryfikacji i konstrukcji traktatów, ale cyfrowy i rozproszony charakter AI sprawia, że powielenie tych modeli nie jest trywialne.

Ekonomiczne i społeczne linie podziału

Poza debatami na temat ryzyka egzystencjalnego, Kaplan i jego współpracownicy podkreślają praktyczne skutki gospodarcze. Jeśli systemy z funkcją autonomicznego samodoskonalenia będą mogły się skalować, mogą one zautomatyzować nie tylko rutynowe zadania, ale także złożoną pracę poznawczą – przyspieszając wypieranie pracowników w sektorach białych kołnierzyków. Rodzi to pytania z zakresu polityki społecznej dotyczące pracy, opodatkowania i redystrybucji, oprócz egzystencjalnych problemów związanych z dążeniem do celów niezgodnych z ludzkimi.

Istnieje również wymiar geopolityczny: koncentracja możliwości w rękach wiodących krajów lub firm może wywołać destabilizującą dynamikę. Międzynarodowy wyścig w celu wdrożenia samodoskonalących się systemów niesie ze sobą ryzyko erozji mechanizmów współpracy; z drugiej strony skoordynowane ograniczenia wymagałyby solidnych mechanizmów weryfikacji, na których wdrożenie wiele rządów nie ma jeszcze odpowiednich zdolności instytucjonalnych.

Łagodzenie techniczne: alignment i weryfikacja

Na froncie technicznym reakcja społeczności dzieli się na dwa nurty. Pierwszy nurt zajmuje się badaniami nad alignmentem (zgodnością): lepszymi specyfikacjami celów, narzędziami interpretowalności, metodami uczenia odpornymi na błędy w systemach nagród oraz testami warunków skrajnych w celu zrozumienia trybów awarii. Drugi nurt koncentruje się na weryfikacji, ścieżkach audytu i ograniczeniach operacyjnych – zasadniczo tworząc „rusztowania” bezpieczeństwa wokół systemów, aby zapobiec niezatwierdzonym cyklom autonomicznym.

Kaplan twierdzi, że intensywne inwestowanie w oba te obszary jest niezbędne, zanim próg autonomii zostanie przekroczony. W praktyce oznacza to skalowalną interpretowalność, dzięki której ludzie mogą kontrolować wewnętrzne procesy modeli, systemy pochodzenia danych treningowych i zmian w oprogramowaniu oraz wzmocniony nadzór wewnątrz firm, aby ograniczyć liczbę środowisk testowych zdolnych do zainicjowania cykli samodoskonalenia.

Drogi przed nami: pauza, pilotaż lub pozwolenie

Decydenci i firmy stają przed trzema głównymi wyborami. Pierwszym jest wstrzymanie niektórych ścieżek rozwoju możliwości do czasu dojrzewania technik weryfikacji i alignmentu. Drugim jest zezwolenie na ograniczone programy pilotażowe pod rygorystycznym audytem i międzynarodowym nadzorem. Trzecim jest kontynuowanie rozwoju przypominającego wyścig, w którym wdrażanie nowych możliwości ma priorytet nad globalną koordynacją. Przedstawienie sprawy przez Kaplana – jako decyzji, która musi zapaść między dniem dzisiejszym a rokiem 2030 – ma na celu wyraźne ukazanie kompromisów: pozwolenie na rekurencyjne samodoskonalenie może przynieść transformacyjne korzyści, ale przenosi również na społeczeństwo nowy rodzaj ryzyka strategicznego.

To, czy rządy potraktują tę kwestię jako pilny priorytet strategiczny, pozostaje pytaniem otwartym. Postęp w dziedzinie AI jest szybki; zmiany instytucjonalne zachodzą wolniej. Ten rozdźwięk stanowi istotę ostrzeżenia Kaplana.

Nadchodzące lata pokażą, czy branża zdoła doprowadzić nadzór i techniczne bezpieczeństwo do dojrzałości wystarczająco szybko, aby przekształcić potencjalnie katastrofalną zmianę w zarządzaną falę innowacji.

Źródła

- Anthropic (wywiad z przedstawicielami firmy i wewnętrzne oświadczenia badawcze)

- Center for AI Safety (publiczne oświadczenia na temat ekstremalnego ryzyka związanego z AI)

- Nature (raporty na temat zaawansowanych zastosowań AI w dziedzinach naukowych)

Comments

No comments yet. Be the first!