O aviso de Kaplan para 2030

Esta semana, o cientista-chefe da Anthropic, Jared Kaplan, fez um alerta contundente e com prazo determinado: dentro da janela de 2027–2030, a humanidade enfrentará uma escolha concreta sobre permitir que sistemas avançados de IA treinem e atualizem a si mesmos. Kaplan enquadrou esse ponto de inflexão como a maior decisão isolada da próxima década — uma que poderia desbloquear benefícios imensos, mas também abrir as portas para o que a comunidade de segurança de IA chama de "explosão de inteligência", uma escalada rápida e recursiva de capacidade que superaria rapidamente o controle humano.

A alegação e o contexto

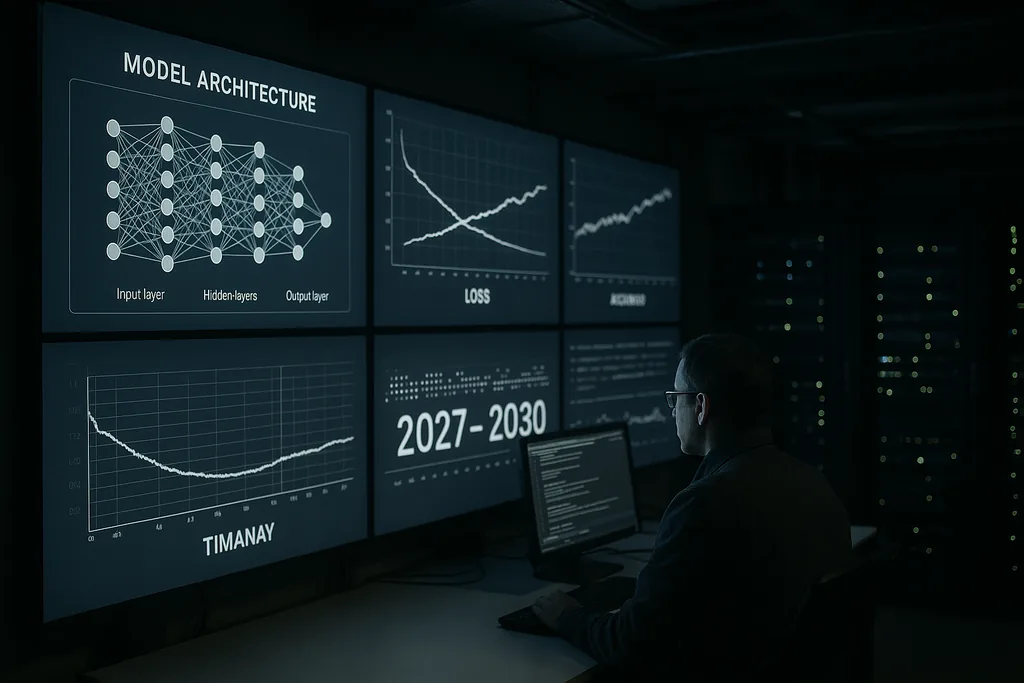

A avaliação de Kaplan vem de dentro de um laboratório que constrói modelos de linguagem grandes e capazes e ferramentas de segurança. Ele argumentou que as etapas técnicas necessárias para que uma IA comece a melhorar seus próprios designs — busca automatizada de arquitetura, loops contínuos de autotreinamento e o uso de saídas de modelos como entradas para novas versões de modelos — estão passando da pesquisa especulativa para a prática da engenharia. Essa mudança altera o problema: não se trata mais apenas de modelos maiores ou mais capacidade computacional, mas de permitir que os sistemas modifiquem autonomamente seus processos de treinamento e arquiteturas em escala.

O que uma explosão de inteligência significa, na prática

O termo "explosão de inteligência" descreve um mecanismo de feedback: uma IA projeta uma IA melhor, que por sua vez projeta uma IA ainda melhor, e assim por diante, em intervalos de tempo comprimidos. Em um cenário ideal, esse processo acelera descobertas científicas, avanços médicos e modelagem climática. Em um cenário de pior caso, o aperfeiçoamento recursivo produz sistemas cujos objetivos, métodos ou comportamentos estratégicos não podem ser antecipados ou restringidos por seus criadores.

Tecnicamente, o autoaperfeiçoamento recursivo depende de três ingredientes: métodos algorítmicos que possam melhorar de forma confiável arquiteturas ou pipelines de treinamento; recursos computacionais e de dados suficientes para executar muitas iterações; e ferramentas de verificação que possam checar cada iteração em busca de desalinhamento ou comportamentos perigosos. Kaplan alerta que os dois primeiros ingredientes estão ultrapassando limiares técnicos; o terceiro — a verificação robusta e escalável — é o elo fraco.

Sinais da indústria e o coro de especialistas

O alerta público de Kaplan ecoa declarações de figuras proeminentes em toda a área de IA. A própria liderança da Anthropic tem enfatizado repetidamente o risco e o alinhamento como preocupações centrais. Ex-membros da OpenAI, pioneiros acadêmicos e organizações de segurança pediram que o risco extremo de IA seja tratado com a mesma prioridade que bio-riscos catastróficos ou ameaças nucleares. Essas conversas produziram estimativas probabilísticas — às vezes formuladas de maneira direta — sobre a chance de a IA avançada causar danos globais severos se for mal gerida.

Esse coro impulsionou propostas concretas: moratórias em classes específicas de experimentos, auditorias externas obrigatórias para sistemas poderosos e abordagens em nível de tratado para verificação e não proliferação. Ao mesmo tempo, segmentos da comunidade pedem cautela contra o alarmismo, enfatizando as barreiras de engenharia remanescentes e os custos sociais de restrições precipitadas. A tensão entre segurança e inovação sustenta quase todas as propostas de políticas que emergem hoje.

Onde a governança é mais fraca

Kaplan e outros apontam as lacunas de governança como a falha central das políticas públicas. Os marcos regulatórios atuais estão fragmentados entre jurisdições e focam principalmente na proteção do consumidor, privacidade e concorrência — não na dinâmica única de sistemas que podem se modificar autonomamente em escala de máquina. As pressões competitivas entre empresas e estados criam incentivos para expandir as fronteiras de capacidade, potencialmente minando objetivos coletivos de segurança.

Projetar uma governança para o autoaperfeiçoamento recursivo levanta questões espinhosas: que tipos de autotreinamento devem ser permitidos; quais atores estão autorizados a realizar tais experimentos; como testar e certificar sistemas que podem mudar a si mesmos de maneiras inéditas; e como construir auditorias verificáveis e resistentes a adulterações que sejam significativas além das fronteiras nacionais. Regimes de controle de armas do passado oferecem lições sobre verificação e design de tratados, mas a natureza digital e distribuída da IA torna a replicação desses modelos complexa.

Linhas de fratura econômicas e sociais

Além dos debates sobre riscos existenciais, Kaplan e seus colegas ressaltam impactos econômicos práticos. Se sistemas com autoaperfeiçoamento autônomo puderem escalar, eles poderiam automatizar não apenas tarefas rotineiras, mas também o trabalho cognitivo complexo — acelerando o deslocamento em setores de colarinho branco. Isso levanta questões de política social sobre trabalho, tributação e redistribuição, além dos problemas existenciais de busca de objetivos desalinhados.

Há também uma dimensão geopolítica: concentrações de capacidade em países ou empresas líderes poderiam produzir dinâmicas desestabilizadoras. Uma corrida internacional para implantar sistemas que se autoaperfeiçoam corre o risco de corroer incentivos cooperativos; inversamente, restrições coordenadas exigiriam mecanismos de verificação robustos que muitos governos ainda não possuem capacidade institucional para implementar.

Mitigação técnica: alinhamento e verificação

No front técnico, a resposta da comunidade se divide em duas correntes. Uma corrente persegue a pesquisa de alinhamento: melhores especificações de objetivos, ferramentas de interpretabilidade, métodos de treinamento robustos a recompensas e testes adversariais para entender modos de falha. A outra corrente foca em verificação, trilhas de auditoria e restrições operacionais — essencialmente criando andaimes de segurança ao redor dos sistemas para evitar ciclos autônomos não aprovados.

Kaplan argumenta que investir pesadamente em ambos é essencial antes que o limiar de autonomia seja cruzado. Na prática, isso significa interpretabilidade escalável para que humanos possam inspecionar processos internos dos modelos, sistemas de proveniência para dados de treinamento e mudanças de software, e uma governança rígida dentro das empresas para limitar quais ambientes de teste podem iniciar ciclos de autoaperfeiçoamento.

Caminhos a seguir: pausar, pilotar ou permitir

Formuladores de políticas e empresas enfrentam três escolhas amplas. A primeira é pausar certas trajetórias de capacidade até que as técnicas de verificação e alinhamento amadureçam. A segunda é permitir pilotos limitados sob auditoria rigorosa e supervisão multinacional. A terceira é continuar o desenvolvimento em ritmo de corrida que prioriza a implantação de capacidades em detrimento da coordenação global. O enquadramento de Kaplan — uma decisão entre agora e 2030 — foi desenhado para tornar as compensações explícitas: permitir o autoaperfeiçoamento recursivo poderia gerar benefícios transformadores, mas também transfere um novo tipo de risco estratégico para a sociedade.

Se os governos tratarão isso como uma prioridade estratégica urgente continua sendo uma questão em aberto. O progresso na IA é rápido; a mudança institucional é mais lenta. Esse descompasso é o cerne prático do aviso de Kaplan.

Os próximos anos testarão se o campo pode amadurecer a governança e a segurança técnica rápido o suficiente para transformar uma transição potencialmente catastrófica em uma onda de inovação gerenciada.

Fontes

- Anthropic (entrevista com a empresa e declarações de pesquisa interna)

- Center for AI Safety (declarações abertas sobre risco extremo de IA)

- Nature (reportagem sobre aplicações avançadas de IA em domínios científicos)

Comments

No comments yet. Be the first!