Kaplan'ın 2030 uyarısı

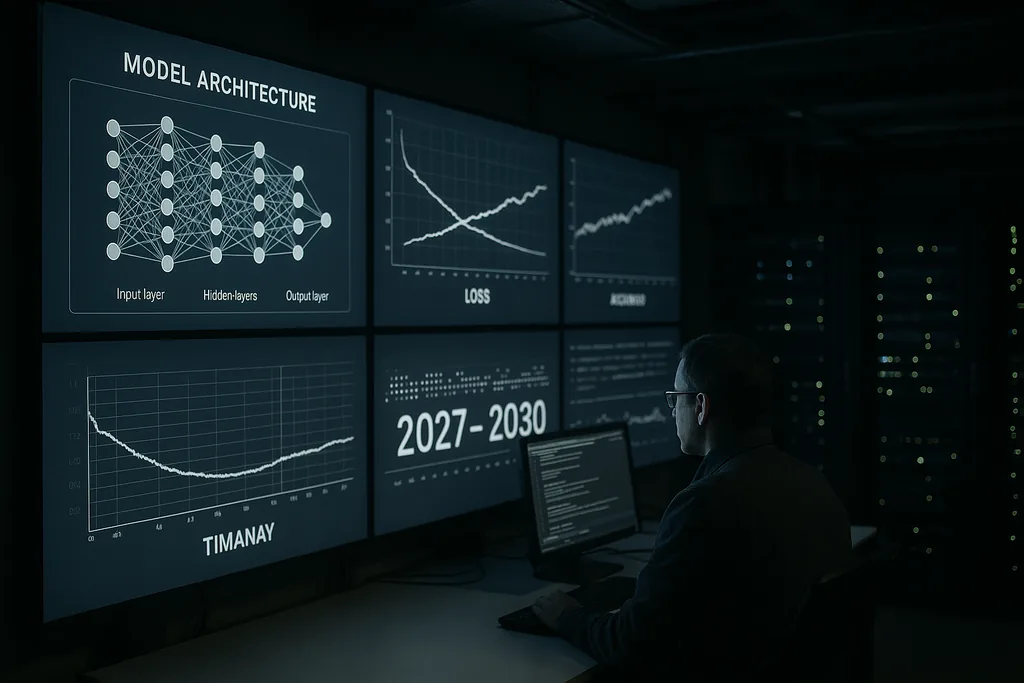

Bu hafta, Anthropic'in baş bilim insanı Jared Kaplan kesin ve zamana dayalı bir uyarıda bulundu: 2027–2030 penceresi içinde insanlık, gelişmiş yapay zeka sistemlerinin kendilerini eğitmesine ve yükseltmesine izin verip vermeme konusunda somut bir seçimle karşı karşıya kalacak. Kaplan bu dönüm noktasını, önümüzdeki on yılın en büyük tek kararı olarak nitelendirdi; bu karar büyük faydaların önünü açabileceği gibi, yapay zeka güvenliği topluluğunun "zeka patlaması" olarak adlandırdığı, insan kontrolünü hızla aşacak yeteneklerin hızlı ve özyinelemeli bir şekilde tırmanmasına da kapı aralayabilir.

İddia ve bağlam

Kaplan'ın değerlendirmesi, büyük ve yetenekli dil modelleri ile güvenlik araçları inşa eden bir laboratuvarın içinden geliyor. Bir yapay zekanın kendi tasarımlarını iyileştirmeye başlaması için gereken teknik adımların —otomatik mimari arama, sürekli kendi kendine eğitim döngüleri ve model çıktılarını yeni model versiyonları için girdi olarak kullanma— spekülatif araştırmalardan mühendislik pratiğine dönüştüğünü savundu. Bu değişim sorunu farklı bir boyuta taşıyor: Mesele artık sadece daha büyük modeller veya daha fazla hesaplama gücü değil, sistemlerin kendi eğitim süreçlerini ve mimarilerini geniş ölçekte otonom olarak değiştirmelerine izin verip vermeyeceğimizdir.

Zeka patlaması pratikte ne anlama geliyor?

"Zeka patlaması" terimi bir geri bildirim mekanizmasını tanımlar: Bir yapay zeka daha iyi bir yapay zeka tasarlar, o da karşılığında daha da iyi bir yapay zeka tasarlar ve bu süreç sıkıştırılmış zaman dilimlerinde bu şekilde devam eder. En iyi senaryoda, bu süreç bilimsel keşifleri, tıbbi atılımları ve iklim modellemeyi hızlandırır. En kötü senaryoda ise özyinelemeli gelişim, hedefleri, yöntemleri veya stratejik davranışları yaratıcıları tarafından öngörülemeyen veya kısıtlanamayan sistemler üretir.

Teknik olarak, özyinelemeli öz-gelişim üç bileşene dayanır: mimarileri veya eğitim boru hatlarını güvenilir şekilde iyileştirebilen algoritmik yöntemler; birçok yinelemeyi yürütmek için yeterli hesaplama ve veri kaynakları; ve her yinelemeyi uyumsuzluk veya güvensiz davranışlar açısından kontrol edebilecek doğrulama araçları. Kaplan, ilk iki bileşenin teknik eşikleri aşmakta olduğu konusunda uyarıyor; üçüncüsü —sağlam ve ölçeklenebilir doğrulama— ise zayıf halkadır.

Sektör sinyalleri ve uzman korosu

Kaplan'ın kamuoyuna yönelik uyarısı, yapay zeka dünyasındaki önde gelen isimlerin açıklamalarıyla örtüşüyor. Anthropic'in kendi yönetimi, risk ve hizalamayı defalarca merkezi endişeler olarak vurguladı. Eski OpenAI çalışanları, akademik öncüler ve güvenlik kuruluşları, aşırı yapay zeka riskine feci biyolojik riskler veya nükleer tehditlerle aynı önceliğin verilmesi çağrısında bulundu. Bu konuşmalar, gelişmiş yapay zekanın kötü yönetilmesi durumunda ciddi küresel zarara yol açma olasılığına dair —bazen açık bir dille ifade edilen— olasılıksal tahminler ortaya çıkardı.

Bu koro somut önerileri gündeme taşıdı: belirli deney sınıfları üzerinde moratoryumlar, güçlü sistemler için zorunlu dış denetimler ve doğrulama ile yayılmanın önlenmesine yönelik antlaşma düzeyinde yaklaşımlar. Aynı zamanda, topluluğun bazı kesimleri alarmizme karşı dikkatli olunması çağrısında bulunarak, geriye kalan mühendislik engellerini ve aceleci kısıtlamaların sosyal maliyetlerini vurguluyor. Güvenlik ve inovasyon arasındaki gerilim, günümüzde ortaya çıkan hemen her politika önerisinin temelini oluşturuyor.

Yönetişimin en zayıf olduğu noktalar

Kaplan ve diğerleri, yönetişim boşluklarını merkezi politika başarısızlığı olarak işaret ediyor. Mevcut düzenleyici çerçeveler yargı alanları arasında parçalanmış durumda ve öncelikle tüketiciyi koruma, gizlilik ve rekabete odaklanıyor; makine ölçeğinde kendi kendini değiştirebilen sistemlerin benzersiz dinamiklerine değil. Firmalar ve devletler arasındaki rekabet baskıları, yetenek sınırlarını zorlamak için teşvikler yaratarak kolektif güvenlik hedeflerini potansiyel olarak baltalıyor.

Özyinelemeli öz-gelişim için yönetişim tasarlamak çetrefilli soruları beraberinde getiriyor: Ne tür kendi kendine eğitime izin verilmeli; bu tür deneyleri yapmaya hangi aktörler yetkili; kendilerini yeni yollarla değiştirebilecek sistemler nasıl test edilip sertifikalandırılmalı; ve ulusal sınırların ötesinde anlamlı olan, doğrulanabilir ve müdahaleye dayanıklı denetimler nasıl inşa edilmeli. Geçmişteki silah kontrol rejimleri doğrulama ve antlaşma tasarımı konusunda dersler sunuyor, ancak yapay zekanın dijital ve dağıtık doğası bu modellerin kopyalanmasını zorlaştırıyor.

Ekonomik ve sosyal fay hatları

Varoluşsal risk tartışmalarının ötesinde Kaplan ve meslektaşları, pratik ekonomik etkilerin altını çiziyor. Otonom öz-gelişime sahip sistemlerin ölçeklenmesine izin verilirse, bu sistemler sadece rutin görevleri değil, aynı zamanda karmaşık bilişsel emeği de otomatikleştirebilir ve beyaz yakalı sektörlerdeki iş kaybını hızlandırabilir. Bu durum, hatalı hizalanmış hedef arayışının varoluşsal problemlerine ek olarak emek, vergilendirme ve yeniden dağıtım üzerine sosyal politika sorularını gündeme getiriyor.

Ayrıca jeopolitik bir boyut da mevcut: Lider ülkelerdeki veya firmalardaki yetenek yoğunlaşması istikrarsızlaştırıcı dinamikler yaratabilir. Kendi kendini geliştiren sistemleri devreye sokmak için girilecek uluslararası bir yarış, iş birliği teşviklerini aşındırma riski taşır; aksine, koordineli kısıtlamalar birçok hükümetin henüz uygulamak için kurumsal kapasiteye sahip olmadığı sağlam doğrulama mekanizmaları gerektirecektir.

Teknik azaltma: Hizalama ve doğrulama

Teknik cephede, topluluğun yanıtı iki kola ayrılıyor. Bir kol hizalama araştırmalarını sürdürüyor: daha iyi hedef belirleme, yorumlanabilirlik araçları, ödül odaklı sağlam eğitim yöntemleri ve hata modlarını anlamak için çekişmeli testler. Diğer kol ise doğrulama, denetim izleri ve operasyonel kısıtlamalara odaklanıyor; temel olarak onaylanmamış otonom döngüleri önlemek için sistemlerin etrafında güvenlik iskeleleri oluşturuyor.

Kaplan, otonomi eşiği aşılmadan önce her iki alana da yoğun yatırım yapmanın şart olduğunu savunuyor. Uygulamada bu, insanların dahili model süreçlerini inceleyebilmesi için ölçeklenebilir yorumlanabilirlik, eğitim verileri ve yazılım değişiklikleri için kaynak takip sistemleri ve hangi test ortamlarının öz-gelişim döngülerini başlatabileceğini sınırlamak için şirket içi sertleştirilmiş yönetişim anlamına geliyor.

Öndeki yollar: Duraklat, pilot uygulama yap veya izin ver

Politika yapıcılar ve şirketler üç genel seçenekle karşı karşıya. Birincisi, doğrulama ve hizalama teknikleri olgunlaşana kadar belirli yetenek yollarını duraklatmak. İkincisi, sıkı denetim ve çok uluslu gözetim altında sınırlı pilot uygulamalara izin vermek. Üçüncüsü ise küresel koordinasyon yerine yeteneklerin konuşlandırılmasına öncelik veren yarış benzeri bir geliştirmeye devam etmek. Kaplan'ın kurgusu —şimdi ile 2030 arasında bir karar— ödünleşimleri açık hale getirmek için tasarlandı: Özyinelemeli öz-gelişime izin vermek dönüştürücü faydalar sağlayabilir, ancak aynı zamanda topluma yeni bir tür stratejik risk transfer eder.

Hükümetlerin bunu acil bir stratejik öncelik olarak görüp görmeyeceği ucu açık bir soru. Yapay zekadaki ilerleme hızlı; kurumsal değişim ise daha yavaş. Bu uyumsuzluk, Kaplan'ın uyarısının pratik özünü oluşturuyor.

Önümüzdeki yıllar, alanın yönetişim ve teknik güvenliği, potansiyel olarak feci bir geçişi yönetilen bir inovasyon dalgasına dönüştürecek kadar hızlı olgunlaştırıp olgunlaştıramayacağını test edecek.

Kaynaklar

- Anthropic (şirket mülakatı ve dahili araştırma beyanları)

- Center for Yapay Zeka Güvenliği (aşırı yapay zeka riski üzerine açık beyanlar)

- Nature (bilimsel alanlardaki gelişmiş yapay zeka uygulamaları üzerine raporlama)

Comments

No comments yet. Be the first!