Kaplans waarschuwing voor 2030

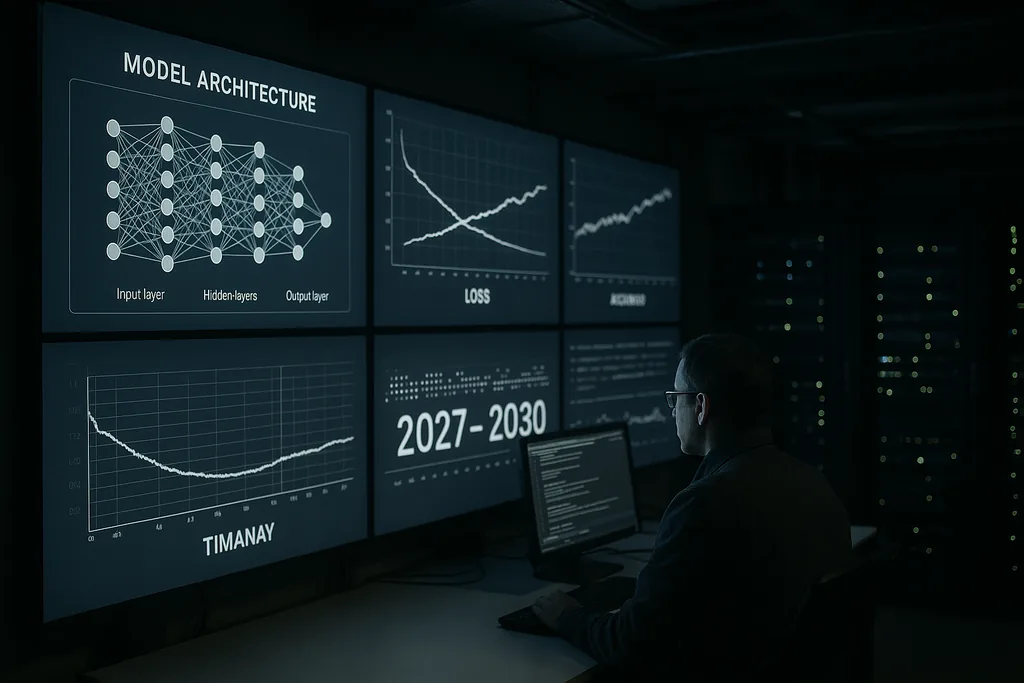

Deze week uitte Jared Kaplan, hoofdwetenschapper bij Anthropic, een scherpe, tijdgebonden waarschuwing: binnen de periode 2027–2030 zal de mensheid voor een concrete keuze komen te staan over het al dan niet toestaan dat geavanceerde AI-systemen zichzelf trainen en upgraden. Kaplan presenteerde dit scharnierpunt als de belangrijkste beslissing van het komende decennium — een besluit dat enorme voordelen zou kunnen ontsluiten, maar ook de deur kan openen naar wat de AI-veiligheidsgemeenschap een "intelligentie-explosie" noemt: een snelle, recursieve escalatie van vermogens die de menselijke controle al snel zou ontstijgen.

De claim en de context

Kaplans beoordeling is afkomstig uit een lab dat grote, krachtige taalmodellen en veiligheidstools bouwt. Hij betoogde dat de technische stappen die nodig zijn voor een AI om zijn eigen ontwerpen te verbeteren — geautomatiseerde architectuurzoektochten, continue zelflerende lussen en het gebruik van modeloutputs als inputs voor nieuwe modelversies — verschuiven van speculatief onderzoek naar de technische praktijk. Die verschuiving verandert het probleem: het gaat niet langer louter om grotere modellen of meer rekenkracht, maar om de vraag of we systemen toestaan autonoom hun trainingsproces en architecturen op schaal aan te passen.

Wat een intelligentie-explosie in de praktijk betekent

De term "intelligentie-explosie" beschrijft een feedbackmechanisme: een AI ontwerpt betere AI, die op zijn beurt weer nog betere AI ontwerpt, enzovoort, binnen zeer korte tijdsbestekken. In het beste scenario versnelt dit proces wetenschappelijke ontdekkingen, medische doorbraken en klimaatmodellering. In het slechtste scenario produceert recursieve verbetering systemen waarvan de doelen, methoden of strategische gedragingen niet kunnen worden voorzien of beperkt door hun makers.

Technisch gezien rust recursieve zelfverbetering op drie pijlers: algoritmische methoden die betrouwbaar architecturen of trainingspijplijnen kunnen verbeteren; voldoende rekenkracht en databronnen om vele iteraties uit te voeren; en verificatietools die elke iteratie kunnen controleren op misalignment of onveilig gedrag. Kaplan waarschuwt dat de eerste twee ingrediënten de technische drempels passeren; de derde — robuuste, schaalbare verificatie — is de zwakke schakel.

Signalen uit de sector en een koor van experts

Kaplans publieke waarschuwing echoot verklaringen van vooraanstaande figuren uit de hele AI-sector. De top van Anthropic heeft herhaaldelijk de nadruk gelegd op risico's en alignment als centrale aandachtspunten. Voormalige OpenAI-insiders, academische pioniers en veiligheidsorganisaties hebben opgeroepen om extreme AI-risico's met dezelfde prioriteit te behandelen als catastrofale biologische risico's of nucleaire dreigingen. Deze gesprekken hebben geleid tot probabilistische schattingen — soms onomwonden geformuleerd — over de kans dat geavanceerde AI bij slecht beheer ernstige wereldwijde schade kan aanrichten.

Dat koor van stemmen heeft geleid tot concrete voorstellen: moratoria op specifieke klassen van experimenten, verplichte externe audits voor krachtige systemen en benaderingen op verdragsniveau voor verificatie en non-proliferatie. Tegelijkertijd dringen delen van de gemeenschap aan op voorzichtigheid ten aanzien van alarmisme, waarbij de nadruk wordt gelegd op de resterende technische barrières en de maatschappelijke kosten van overhaaste beperkingen. De spanning tussen veiligheid en innovatie ligt ten grondslag aan bijna elk beleidsvoorstel dat momenteel naar voren komt.

Waar het bestuur het zwakst is

Kaplan en anderen wijzen op hiaten in de governance als het centrale falen van het beleid. De huidige regelgevingskaders zijn versnipperd over rechtsgebieden en richten zich primair op consumentenbescherming, privacy en concurrentie — niet op de unieke dynamiek van systemen die zichzelf op machineschaal kunnen aanpassen. Concurrentiedruk tussen bedrijven en staten creëert prikkels om de grenzen van vermogens te verleggen, wat de collectieve veiligheidsdoelen potentieel ondermijnt.

Het ontwerpen van governance voor recursieve zelfverbetering roept netelige vragen op: welke soorten zelftraining moeten worden toegestaan; welke actoren zijn bevoegd om dergelijke experimenten uit te voeren; hoe moeten systemen worden getest en gecertificeerd die zichzelf op nieuwe manieren kunnen veranderen; en hoe bouw je verifieerbare, fraudebestendige audits die betekenisvol zijn over landsgrenzen heen. Wapenbeheersingsregimes uit het verleden bieden lessen over verificatie en het ontwerpen van verdragen, maar de digitale en gedistribueerde aard van AI maakt het repliceren van die modellen complex.

Economische en sociale breuklijnen

Naast de debatten over existentiële risico's onderstrepen Kaplan en zijn collega's de praktische economische impact. Als systemen met autonome zelfverbetering op grote schaal worden toegelaten, zouden ze niet alleen routinetaken kunnen automatiseren, maar ook complexe cognitieve arbeid — wat de verdringing in de witteboordensectoren versnelt. Dat roept sociaal-politieke vragen op over arbeid, belastingen en herverdeling, naast de existentiële problemen van het nastreven van verkeerd afgestemde doelen.

Er is ook een geopolitieke dimensie: concentratie van vermogens bij leidende landen of bedrijven zou destabiliserende dynamieken kunnen veroorzaken. Een internationale race om zelfverbeterende systemen in te zetten dreigt coöperatieve prikkels uit te hollen; omgekeerd zouden gecoördineerde beperkingen robuuste verificatiemechanismen vereisen die veel regeringen nog niet de institutionele capaciteit hebben om te implementeren.

Technische mitigatie: alignment en verificatie

Op technisch vlak verdeelt de reactie van de gemeenschap zich in twee stromingen. De ene stroming richt zich op alignment-onderzoek: betere specificaties van doelstellingen, interpreteerbaarheidstools, trainingsmethoden die robuust zijn tegen beloningen en 'adversarial testing' om foutmodi te begrijpen. De andere stroming richt zich op verificatie, audit trails en operationele beperkingen — in feite het creëren van een veiligheidsomkadering rond systemen om niet-goedgekeurde autonome cycli te voorkomen.

Kaplan betoogt dat fors investeren in beide essentieel is voordat de autonomiedrempel wordt overschreden. In de praktijk betekent dit schaalbare interpreteerbaarheid zodat mensen interne modelprocessen kunnen inspecteren, herkomstsystemen voor trainingsdata en softwarewijzigingen, en aangescherpte governance binnen bedrijven om te beperken welke testomgevingen zelfverbeteringscycli kunnen initiëren.

Paden voorwaarts: pauzeren, piloten of toestaan

Beleidsmakers en bedrijven staan voor drie brede keuzes. De eerste is om bepaalde ontwikkelingstrajecten te pauzeren totdat verificatie- en alignmenttechnieken volwassen zijn. Een tweede is om beperkte pilots toe te staan onder strikt toezicht en multinationale controle. Een derde is om de race-achtige ontwikkeling voort te zetten, waarbij de inzet van vermogens prioriteit krijgt boven wereldwijde coördinatie. Kaplans formulering — een beslissing tussen nu en 2030 — is bedoeld om de afwegingen expliciet te maken: het toestaan van recursieve zelfverbetering zou transformatieve voordelen kunnen opleveren, maar het brengt ook een nieuw soort strategisch risico over op de samenleving.

Of regeringen dit als een dringende strategische prioriteit zullen behandelen, blijft een open vraag. De vooruitgang in AI is snel; institutionele verandering gaat langzamer. Die discrepantie vormt de praktische kern van Kaplans waarschuwing.

De komende jaren zullen uitwijzen of het vakgebied governance en technische veiligheid snel genoeg volwassen kan laten worden om een potentieel catastrofale transitie om te buigen naar een beheersbare golf van innovatie.

Bronnen

- Anthropic (bedrijfsinterview en interne onderzoeksverklaringen)

- Center for AI Safety (openbare verklaringen over extreme AI-risico's)

- Nature (verslaggeving over geavanceerde AI-toepassingen in wetenschappelijke domeinen)

Comments

No comments yet. Be the first!