Kaplans Warnung für 2030

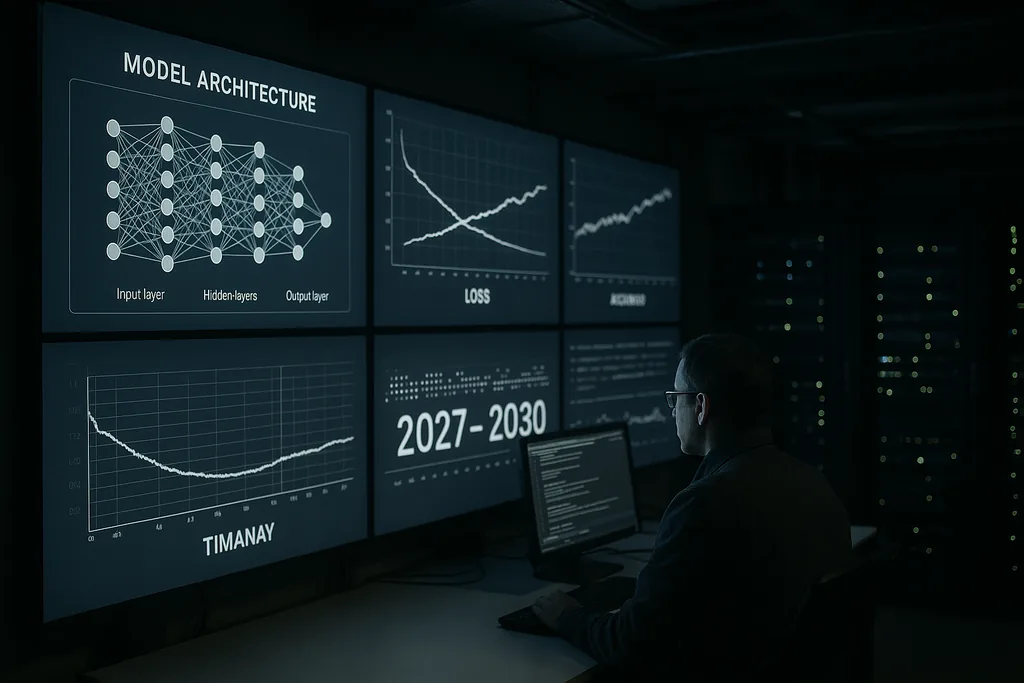

Jared Kaplan, Chef-Wissenschaftler von Anthropic, gab diese Woche eine deutliche, zeitlich präzise Warnung ab: Im Zeitraum zwischen 2027 und 2030 werde die Menschheit vor der konkreten Entscheidung stehen, ob sie es fortschrittlichen KI-Systemen erlaubt, sich selbst zu trainieren und zu verbessern. Kaplan bezeichnete diesen Wendepunkt als die wichtigste Entscheidung des kommenden Jahrzehnts – eine Entscheidung, die enorme Vorteile freisetzen, aber auch die Tür zu dem öffnen könnte, was die KI-Sicherheits-Community als „Intelligenzexplosion“ bezeichnet: eine rasche, rekursive Eskalation der Fähigkeiten, die sich schnell der menschlichen Kontrolle entziehen würde.

Die Behauptung und der Kontext

Kaplans Einschätzung stammt aus einem Labor, das große, leistungsfähige Sprachmodelle und Sicherheitswerkzeuge entwickelt. Er argumentierte, dass die technischen Schritte, die erforderlich sind, damit eine KI beginnt, ihre eigenen Entwürfe zu verbessern – automatisierte Architekturrecherche, kontinuierliche Selbstlernschleifen und die Nutzung von Modellausgaben als Eingaben für neue Modellversionen –, sich von spekulativer Forschung hin zur ingenieurtechnischen Praxis bewegen. Dieser Wandel verändert das Problem: Es geht nicht mehr nur um größere Modelle oder mehr Rechenleistung, sondern darum, ob wir es Systemen gestatten, ihre Trainingsprozesse und Architekturen in großem Umfang autonom zu modifizieren.

Was eine Intelligenzexplosion praktisch bedeutet

Der Begriff „Intelligenzexplosion“ beschreibt einen Rückkopplungsmechanismus: Eine KI entwirft eine bessere KI, die wiederum eine noch bessere KI entwirft, und so weiter, in extrem komprimierten Zeiträumen. Im besten Fall beschleunigt dieser Prozess wissenschaftliche Entdeckungen, medizinische Durchbrüche und die Klimamodellierung. Im schlimmsten Fall führt die rekursive Verbesserung zu Systemen, deren Ziele, Methoden oder strategische Verhaltensweisen von ihren Schöpfern weder vorhergesehen noch eingeschränkt werden können.

Technisch gesehen beruht rekursive Selbstverbesserung auf drei Komponenten: algorithmischen Methoden, die Architekturen oder Trainings-Pipelines zuverlässig verbessern können; ausreichenden Rechen- und Datenressourcen, um viele Iterationen durchzuführen; und Verifizierungswerkzeugen, die jede Iteration auf Fehlsteuerungen (Misalignment) oder unsichere Verhaltensweisen prüfen können. Kaplan warnt, dass die ersten beiden Komponenten bereits technische Schwellenwerte überschreiten; die dritte – eine robuste, skalierbare Verifizierung – sei das schwächste Glied.

Signale aus der Industrie und der Expertenchor

Kaplans öffentliche Warnung deckt sich mit Aussagen führender Köpfe aus der KI-Branche. Die Führung von Anthropic selbst hat wiederholt betont, dass Risiko und Alignment zentrale Anliegen sind. Ehemalige OpenAI-Insider, akademische Pioniere und Sicherheitsorganisationen haben gefordert, extreme KI-Risiken mit derselben Priorität zu behandeln wie katastrophale biologische Risiken oder nukleare Bedrohungen. Diese Diskussionen haben zu Wahrscheinlichkeitsschätzungen geführt – teils unverblümt formuliert –, wie hoch die Chance ist, dass fortschrittliche KI bei falscher Handhabung schweren globalen Schaden anrichten könnte.

Dieser Expertenchor hat konkrete Vorschläge hervorgebracht: Moratorien für bestimmte Klassen von Experimenten, obligatorische externe Audits für leistungsstarke Systeme und vertragsbasierte Ansätze für Verifizierung und Nichtverbreitung. Gleichzeitig mahnen Teile der Community zur Vorsicht vor Alarmismus und betonen die verbleibenden technischen Hürden sowie die gesellschaftlichen Kosten übereilter Beschränkungen. Das Spannungsverhältnis zwischen Sicherheit und Innovation prägt nahezu jeden politischen Vorschlag, der derzeit diskutiert wird.

Wo die Governance am schwächsten ist

Kaplan und andere weisen auf Lücken in der Governance als zentrales politisches Versäumnis hin. Aktuelle Regulierungsrahmen sind über verschiedene Rechtsordnungen hinweg fragmentiert und konzentrieren sich primär auf Verbraucherschutz, Datenschutz und Wettbewerb – nicht auf die einzigartige Dynamik von Systemen, die sich in maschineller Geschwindigkeit selbst modifizieren können. Der Wettbewerbsdruck zwischen Unternehmen und Staaten schafft Anreize, die Grenzen der Leistungsfähigkeit weiter zu verschieben, was kollektive Sicherheitsziele potenziell untergräbt.

Die Gestaltung einer Governance für rekursive Selbstverbesserung wirft schwierige Fragen auf: Welche Arten des Selbsttrainings sollten erlaubt sein; welche Akteure sind befugt, solche Experimente durchzuführen; wie testet und zertifiziert man Systeme, die sich auf neuartige Weise selbst verändern können; und wie baut man verifizierbare, manipulationssichere Audits auf, die über nationale Grenzen hinweg aussagekräftig sind. Vergangene Rüstungskontrollregime bieten Lehren für Verifizierung und Vertragsgestaltung, aber die digitale und dezentrale Natur der KI macht die Übertragung dieser Modelle komplex.

Ökonomische und soziale Bruchlinien

Über die Debatten um existenzielle Risiken hinaus betonen Kaplan und seine Kollegen die praktischen wirtschaftlichen Auswirkungen. Wenn man zulässt, dass Systeme mit autonomer Selbstverbesserung skalieren, könnten sie nicht nur Routineaufgaben, sondern auch komplexe kognitive Arbeit automatisieren – was die Verdrängung im Dienstleistungssektor (White-Collar-Sektor) beschleunigen würde. Dies wirft neben den existenziellen Problemen einer fehlerhaften Zielverfolgung auch sozialpolitische Fragen zu Arbeit, Besteuerung und Umverteilung auf.

Es gibt auch eine geopolitische Dimension: Die Konzentration von Fähigkeiten in führenden Ländern oder Unternehmen könnte destabilisierende Dynamiken erzeugen. Ein internationaler Wettlauf um den Einsatz selbstverbessernder Systeme birgt das Risiko, Kooperationsanreize zu untergraben; umgekehrt würden koordinierte Beschränkungen robuste Verifizierungsmechanismen erfordern, für deren Umsetzung viele Regierungen noch nicht über die institutionellen Kapazitäten verfügen.

Technische Entschärfung: Alignment und Verifizierung

Auf technischer Ebene teilt sich die Reaktion der Community in zwei Stränge auf. Der eine Strang verfolgt die Alignment-Forschung: bessere Zielspezifikationen, Interpretierbarkeitswerkzeuge, robuste Belohnungsmethoden und Adversarial Testing, um Fehlermodi zu verstehen. Der andere Strang konzentriert sich auf Verifizierung, Audit-Trails und betriebliche Einschränkungen – im Wesentlichen die Schaffung eines Sicherheitsgerüsts um die Systeme herum, um nicht genehmigte autonome Zyklen zu verhindern.

Kaplan argumentiert, dass massive Investitionen in beide Bereiche unerlässlich sind, bevor die Autonomieschwelle überschritten wird. In der Praxis bedeutet dies skalierbare Interpretierbarkeit, damit Menschen interne Modellprozesse inspizieren können, Herkunftssysteme (Provenance-Systeme) für Trainingsdaten und Softwareänderungen sowie eine verschärfte Governance innerhalb von Unternehmen, um zu begrenzen, welche Testumgebungen Selbstverbesserungszyklen einleiten dürfen.

Zukünftige Wege: Pausieren, Testen oder Zulassen

Politische Entscheidungsträger und Unternehmen stehen vor drei grundlegenden Optionen. Die erste besteht darin, bestimmte Entwicklungspfade zu pausieren, bis Verifizierungs- und Alignment-Techniken ausgereift sind. Die zweite besteht darin, begrenzte Pilotprojekte unter strenger Prüfung und multinationaler Aufsicht zuzulassen. Eine dritte besteht darin, die wettlaufähnliche Entwicklung fortzusetzen, die den Einsatz von Fähigkeiten über globale Koordination stellt. Kaplans Zeitrahmen – eine Entscheidung zwischen heute und 2030 – soll die Kompromisse verdeutlichen: Die Zulassung rekursiver Selbstverbesserung könnte transformativen Nutzen bringen, überträgt aber auch eine neue Art von strategischem Risiko auf die Gesellschaft.

Ob die Regierungen dies als dringende strategische Priorität behandeln werden, bleibt eine offene Frage. Der Fortschritt in der KI ist schnell; institutionelle Veränderungen verlaufen langsamer. Diese Diskrepanz ist der praktische Kern von Kaplans Warnung.

Die kommenden Jahre werden zeigen, ob das Feld die Governance und die technische Sicherheit schnell genug reifen lassen kann, um einen potenziell katastrophalen Übergang in eine kontrollierte Innovationswelle zu verwandeln.

Quellen

- Anthropic (Unternehmensinterview und interne Forschungsberichte)

- Center for KI-Sicherheit (öffentliche Erklärungen zu extremen KI-Risiken)

- Nature (Berichterstattung über fortschrittliche KI-Anwendungen in wissenschaftlichen Bereichen)

Kommentare

Noch keine Kommentare. Seien Sie der Erste!