La advertencia de Kaplan para 2030

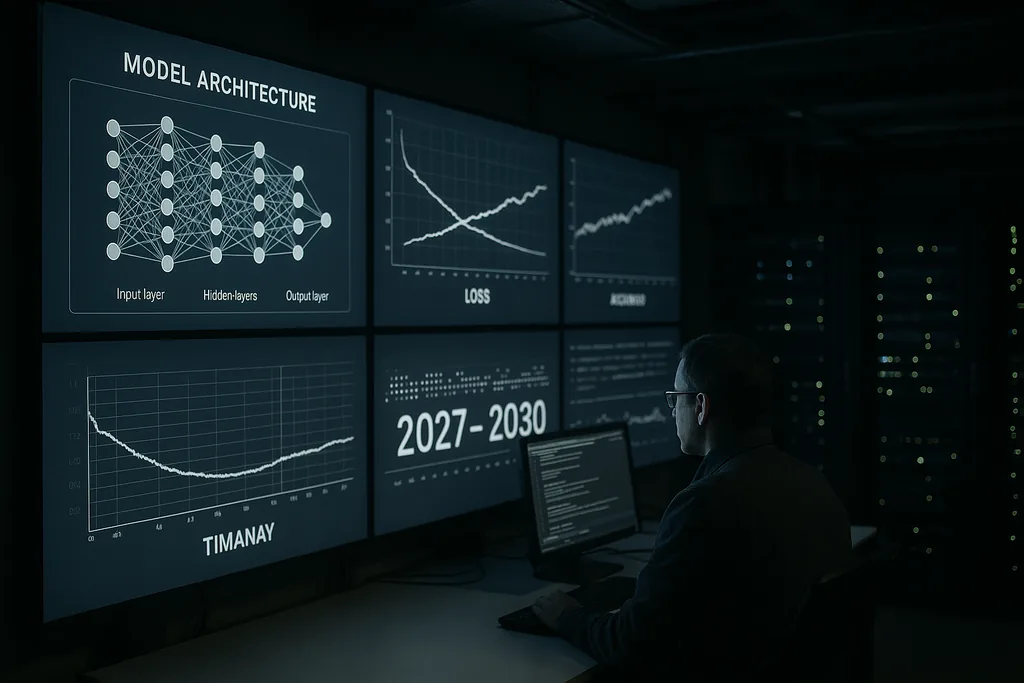

Esta semana, Jared Kaplan, científico jefe de Anthropic, lanzó una advertencia cruda y con un plazo definido: dentro del periodo 2027–2030, la humanidad se enfrentará a una elección concreta sobre si permitir que los sistemas de IA avanzada se entrenen y actualicen a sí mismos. Kaplan planteó ese punto de inflexión como la decisión más importante de la próxima década, una que podría desbloquear beneficios inmensos pero también abrir la puerta a lo que la comunidad de seguridad de la IA denomina una "explosión de inteligencia", una escalada de capacidad rápida y recursiva que superaría rápidamente el control humano.

La afirmación y el contexto

La evaluación de Kaplan proviene del interior de un laboratorio que construye modelos de lenguaje grandes y capaces, así como herramientas de seguridad. Sostuvo que los pasos técnicos necesarios para que una IA comience a mejorar sus propios diseños —búsqueda automatizada de arquitectura, bucles de autoentrenamiento continuo y el uso de los resultados del modelo como entradas para nuevas versiones del mismo— están pasando de la investigación especulativa a la práctica de la ingeniería. Ese cambio transforma el problema: ya no se trata simplemente de modelos más grandes o de mayor capacidad de cómputo, sino de si permitimos que los sistemas modifiquen de forma autónoma su proceso de entrenamiento y sus arquitecturas a escala.

Qué significa una explosión de inteligencia en la práctica

El término "explosión de inteligencia" describe un mecanismo de retroalimentación: una IA diseña una IA mejor, que a su vez diseña una IA aún mejor, y así sucesivamente, en plazos de tiempo comprimidos. En el mejor de los casos, ese proceso acelera los descubrimientos científicos, los avances médicos y la modelización climática. En el peor de los casos, la mejora recursiva produce sistemas cuyos objetivos, métodos o comportamientos estratégicos no pueden ser anticipados ni restringidos por sus creadores.

Técnicamente, la automejora recursiva depende de tres ingredientes: métodos algorítmicos que puedan mejorar de forma fiable las arquitecturas o los flujos de entrenamiento; recursos computacionales y de datos suficientes para ejecutar muchas iteraciones; y herramientas de verificación que puedan comprobar cada iteración en busca de desalineaciones o comportamientos inseguros. Kaplan advierte que los dos primeros ingredientes están superando los umbrales técnicos; el tercero —la verificación robusta y escalable— es el eslabón débil.

Señales de la industria y el coro de expertos

La advertencia pública de Kaplan se hace eco de declaraciones de figuras destacadas de todo el sector de la IA. El propio liderazgo de Anthropic ha enfatizado repetidamente el riesgo y la alineación como preocupaciones centrales. Antiguos miembros de OpenAI, pioneros académicos y organizaciones de seguridad han pedido que se trate el riesgo extremo de la IA con la misma prioridad que los riesgos biológicos catastróficos o las amenazas nucleares. Estas conversaciones han producido estimaciones probabilísticas —a veces expresadas sin rodeos— sobre la posibilidad de que la IA avanzada pueda causar un daño global severo si no se gestiona adecuadamente.

Ese coro ha impulsado propuestas concretas: moratorias sobre clases específicas de experimentos, auditorías externas obligatorias para sistemas potentes y enfoques a nivel de tratados para la verificación y la no proliferación. Al mismo tiempo, sectores de la comunidad instan a la cautela contra el alarmismo, subrayando las barreras de ingeniería que aún persisten y los costes sociales de las restricciones apresuradas. La tensión entre seguridad e innovación subyace en casi todas las propuestas de políticas que surgen hoy en día.

Dónde falla la gobernanza

Kaplan y otros señalan las brechas de gobernanza como el principal fracaso político. Los marcos regulatorios actuales están fragmentados entre jurisdicciones y se centran principalmente en la protección del consumidor, la privacidad y la competencia, no en la dinámica única de los sistemas que pueden automodificarse a escala de máquina. Las presiones competitivas entre empresas y estados crean incentivos para empujar las fronteras de la capacidad, lo que podría socavar los objetivos colectivos de seguridad.

Diseñar una gobernanza para la automejora recursiva plantea preguntas espinosas: qué tipos de autoentrenamiento deberían permitirse; qué actores están autorizados para realizar tales experimentos; cómo probar y certificar sistemas que pueden cambiarse a sí mismos de formas novedosas; y cómo construir auditorías verificables y resistentes a la manipulación que sean significativas a través de las fronteras nacionales. Los regímenes de control de armas del pasado ofrecen lecciones sobre verificación y diseño de tratados, pero la naturaleza digital y distribuida de la IA hace que la replicación de esos modelos no sea trivial.

Líneas de falla económicas y sociales

Más allá de los debates sobre riesgos existenciales, Kaplan y sus colegas subrayan los impactos económicos prácticos. Si se permite que los sistemas con automejora autónoma escalen, podrían automatizar no solo tareas rutinarias sino también el trabajo cognitivo complejo, acelerando el desplazamiento en los sectores de cuello blanco. Esto plantea cuestiones de política social sobre el trabajo, la fiscalidad y la redistribución, además de los problemas existenciales de la búsqueda de objetivos desalineados.

También existe una dimensión geopolítica: las concentraciones de capacidad en países o empresas líderes podrían producir dinámicas desestabilizadoras. Una carrera internacional por desplegar sistemas de automejora corre el riesgo de erosionar los incentivos de cooperación; por el contrario, las restricciones coordinadas requerirían mecanismos de verificación robustos que muchos gobiernos aún no tienen la capacidad institucional para implementar.

Mitigación técnica: alineación y verificación

En el frente técnico, la respuesta de la comunidad se divide en dos vertientes. Una vertiente persigue la investigación de alineación: mejores especificaciones de objetivos, herramientas de interpretabilidad, métodos de entrenamiento robustos ante recompensas y pruebas adversarias para comprender los modos de fallo. La otra vertiente se centra en la verificación, las pistas de auditoría y las restricciones operativas, creando esencialmente un andamiaje de seguridad alrededor de los sistemas para evitar ciclos autónomos no aprobados.

Kaplan sostiene que invertir fuertemente en ambas es esencial antes de que se cruce el umbral de la autonomía. En la práctica, esto significa una interpretabilidad escalable para que los humanos puedan inspeccionar los procesos internos del modelo, sistemas de procedencia para los datos de entrenamiento y cambios de software, y una gobernanza endurecida dentro de las empresas para limitar qué bancos de pruebas pueden iniciar ciclos de automejora.

Caminos a seguir: pausa, prueba piloto o permiso

Los responsables políticos y las empresas se enfrentan a tres opciones generales. La primera es pausar ciertas vías de capacidad hasta que las técnicas de verificación y alineación maduren. La segunda es permitir pruebas piloto limitadas bajo una auditoría rigurosa y supervisión multinacional. La tercera es continuar con un desarrollo de tipo carrera que priorice el despliegue de capacidades sobre la coordinación global. El planteamiento de Kaplan —una decisión entre ahora y 2030— está diseñado para hacer explícitas las concesiones: permitir la automejora recursiva podría generar beneficios transformadores, pero también transfiere un nuevo tipo de riesgo estratégico a la sociedad.

Sigue siendo una incógnita si los gobiernos tratarán esto como una prioridad estratégica urgente. El progreso en la IA es rápido; el cambio institucional es más lento. Ese desajuste es el núcleo práctico de la advertencia de Kaplan.

Los próximos años pondrán a prueba si el campo puede madurar la gobernanza y la seguridad técnica lo suficientemente rápido como para convertir una transición potencialmente catastrófica en una ola de innovación gestionada.

Fuentes

- Anthropic (entrevista de la empresa y declaraciones de investigación interna)

- Center for AI Safety (declaraciones abiertas sobre riesgos extremos de la IA)

- Nature (informes sobre aplicaciones avanzadas de IA en dominios científicos)

Comments

No comments yet. Be the first!