Kaplan 的 2030 年警告

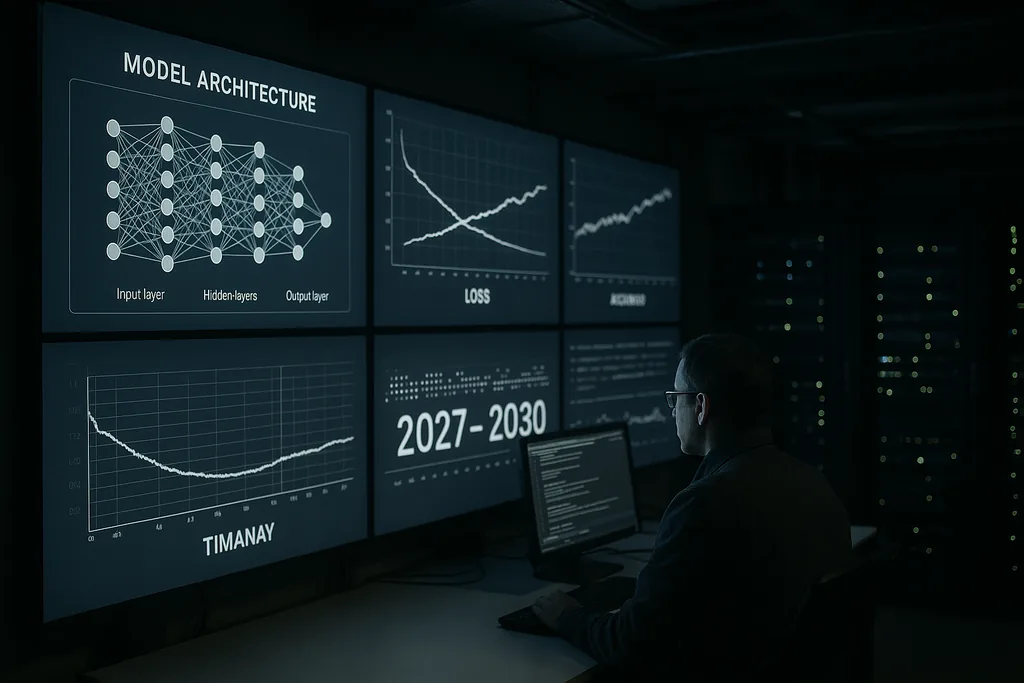

本周,Anthropic 的首席科学家 Jared Kaplan 发布了一项严峻且具有明确时间节点的警告:在 2027 年至 2030 年的时间窗口内,人类将面临一个具体的抉择,即是否允许先进的 AI 系统进行自我训练和升级。Kaplan 将这一转折点描述为未来十年最重要的决策——它可能释放巨大的红利,但也可能开启 AI 安全界所称的“智能爆炸”之门,即一种快速、递归的能力升级,并会迅速脱离人类的控制。

主张与背景

Kaplan 的评估来自一家致力于构建大型、高性能语言模型和安全工具的实验室。他认为,AI 开始改进自身设计所需的技术步骤——自动化架构搜索、持续自我训练循环,以及将模型输出作为新版本模型的输入——正在从推测性研究转向工程实践。这种转变改变了问题的性质:这不再仅仅关乎更大的模型或更多的算力,而在于我们是否允许系统大规模地自主修改其训练过程和架构。

“智能爆炸”的实际含义

“智能爆炸”一词描述的是一种反馈机制:AI 设计出更好的 AI,后者反过来又在压缩的时间框架内设计出更优秀的 AI,以此类推。在理想情况下,这一过程将加速科学发现、医学突破和气候建模。在最坏的情况下,递归改进会产生一些其目标、方法或战略行为无法被创造者预见或约束的系统。

从技术上讲,递归自我改进依赖于三个要素:能够可靠改进架构或训练流水线的算法方法;执行多次迭代所需的充足计算和数据资源;以及能够检查每次迭代是否存在目标失配或不安全行为的验证工具。Kaplan 警告称,前两个要素正在跨越技术门槛;而第三个——强大且可扩展的验证——则是目前的薄弱环节。

行业信号与专家的共鸣

Kaplan 的公开警告与 AI 领域多位领军人物的表态呼应。Anthropic 自身的高层也多次强调风险与对齐是核心关注点。OpenAI 的前内部人士、学术界先驱和安全组织都呼吁,应将 AI 的极端风险提升到与灾难性生物风险或核威胁同等的优先级。这些讨论产生了一些概率评估(有时措辞十分直白),探讨如果管理不善,先进 AI 可能造成严重全球危害的可能性。

这种共鸣推动了一些具体提案:暂停特定类别的实验、对强大系统进行强制性外部审计,以及针对验证和防扩散采取条约级别的措施。与此同时,社区中的部分声音也敦促警惕危言耸听,强调仍存在的工程障碍以及过于仓促的限制所带来的社会成本。安全与创新之间的张力几乎是当今每一项政策提案的基础。

治理最薄弱的环节

Kaplan 等人指出,治理空白是核心的政策失败。目前的监管框架分散在不同司法管辖区,主要关注消费者保护、隐私和竞争,而非能够以机器规模自我修改的系统的独特动态。企业与国家之间的竞争压力产生了推动能力前沿的动机,这可能会削弱集体的安全目标。

为递归自我改进设计治理方案引发了棘手的问题:应允许何种类型的自我训练;哪些主体有权进行此类实验;如何测试和认证可能以全新方式自我改变的系统;以及如何建立能够跨越国界且具有实际意义的、可验证且防篡改的审计。过去的军备控制体系在验证和条约设计方面提供了教训,但 AI 的数字化和分布式特性使得复制这些模式并非易事。

经济与社会断裂带

除了生存风险的辩论外,Kaplan 及其同事还强调了实际的经济影响。如果允许具有自主自我改进能力的系统规模化,它们不仅可以自动化日常任务,还可以自动化复杂的认知劳动,从而加速白领部门的人员更替。这除了引发目标失配的生存问题外,还带来了关于劳动力、税收和再分配的社会政策问题。

此外还存在地缘政治维度:能力集中在领先国家或公司手中可能会产生动荡。部署自我改进系统的国际竞赛存在侵蚀合作动机的风险;相反,协调约束则需要强大的验证机制,而许多政府目前尚不具备实施这些机制的机构能力。

技术缓解措施:对齐与验证

在技术层面,社区的反应分为两个流派。一个流派追求对齐研究:更好的目标规范、可解释性工具、鲁棒的奖励训练方法,以及用于了解失效模式的对抗性测试。另一个流派则专注于验证、审计追踪和操作约束——本质上是在系统周围创建安全脚手架,以防止未经批准的自主循环。

Kaplan 认为,在跨越自主性门槛之前,对这两方面进行大量投入至关重要。在实践中,这意味着需要开发可扩展的可解释性,以便人类能够检查模型内部过程;建立训练数据和软件更改的溯源系统;以及加强公司内部治理,限制哪些测试平台可以启动自我改进循环。

前方的道路:暂停、试点或许可

决策者和公司面临三种广泛的选择。第一种是暂停某些能力路径,直到验证和对齐技术成熟。第二种是在严厉审计和多国监督下允许有限的试点。第三种是继续进行竞争式的开发,将能力部署置于全球协调之上。Kaplan 的框架——即现在到 2030 年之间的抉择——旨在使权衡明确化:允许递归自我改进可能会产生变革性的收益,但它也向社会转移了一种新型的战略风险。

各国政府是否会将此视为紧急战略重点仍是一个悬而未决的问题。AI 的进步是飞速的,而制度变革则较为缓慢。这种错位正是 Kaplan 警告的核心所在。

未来几年将考验该领域能否以足够快的速度完善治理和技术安全,从而将潜在的灾难性转型转化为受控的创新浪潮。

来源

- Anthropic(公司访谈及内部研究声明)

- Center for AI Safety(关于 AI 极端风险的公开声明)

- Nature(关于科学领域先进 AI 应用的报道)

Comments

No comments yet. Be the first!