Kaplans varning för 2030

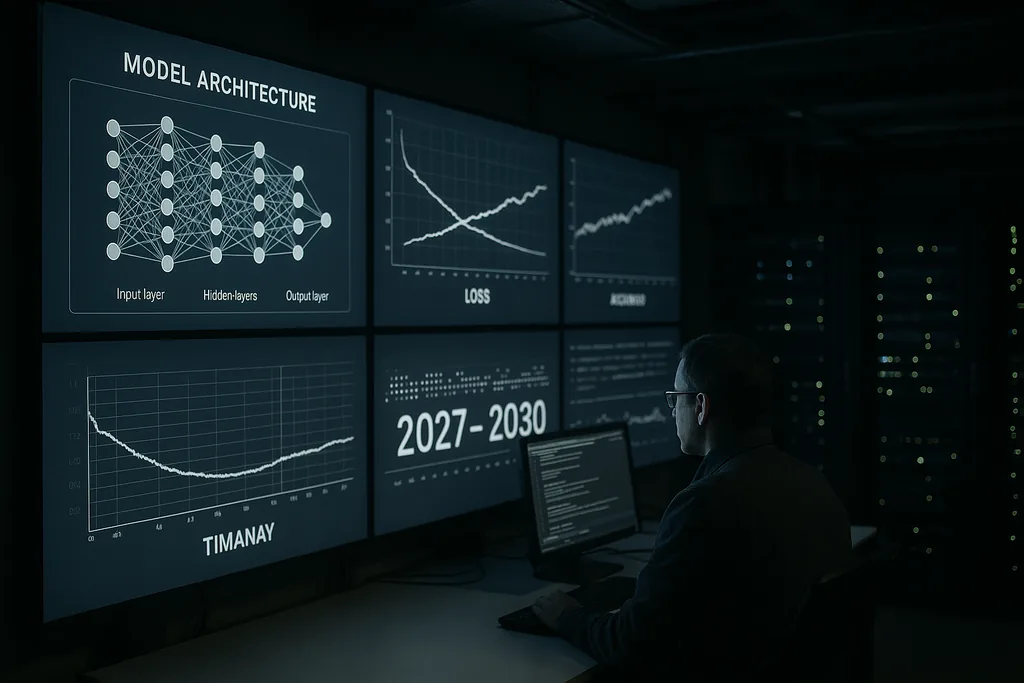

Denna vecka levererade Anthropics forskningschef Jared Kaplan en kraftfull, tidsbestämd varning: inom fönstret 2027–2030 kommer mänskligheten att stå inför ett konkret val om huruvida avancerade AI-system ska tillåtas träna och uppgradera sig själva. Kaplan beskrev detta vägskäl som det enskilt största beslutet under det kommande decenniet – ett beslut som kan låsa upp enorma fördelar men också öppna dörren för vad AI-säkerhetskretsar kallar en ”intelligensexplosion”, en snabb, rekursiv eskalering av förmåga som snabbt skulle kunna överstiga mänsklig kontroll.

Påståendet och kontexten

Kaplans bedömning kommer inifrån ett labb som bygger stora, kapabla språkmodeller och säkerhetsverktyg. Han hävdade att de tekniska steg som krävs för att en AI ska börja förbättra sin egen design – automatiserad arkitektursökning, kontinuerliga självträningsloopar och användning av modellutdata som indata för nya modellversioner – håller på att gå från spekulativ forskning till ingenjörspraxis. Detta skifte förändrar problemet: det handlar inte längre bara om större modeller eller mer beräkningskraft, utan om huruvida vi tillåter system att autonomt modifiera sin träningsprocess och arkitektur i stor skala.

Vad en intelligensexplosion innebär i praktiken

Termen ”intelligensexplosion” beskriver en återkopplingsmekanism: en AI designar bättre AI, som i sin tur designar ännu bättre AI, och så vidare, under komprimerade tidsramar. I ett bästa scenario påskyndar denna process vetenskapliga upptäckter, medicinska genombrott och klimatmodellering. I ett värsta scenario producerar rekursiv förbättring system vars mål, metoder eller strategiska beteenden inte kan förutses eller begränsas av deras skapare.

Tekniskt sett vilar rekursiv självförbättring på tre ingredienser: algoritmiska metoder som tillförlitligt kan förbättra arkitekturer eller träningspipelines; tillräckliga beräknings- och dataresurser för att genomföra många iterationer; samt verifieringsverktyg som kan kontrollera varje iteration för bristande alignment eller osäkra beteenden. Kaplan varnar för att de första två ingredienserna håller på att passera tekniska trösklar; den tredje – robust, skalbar verifiering – är den svaga länken.

Branschnoterat och en kör av experter

Kaplans offentliga varning ekar av uttalanden från ledande figurer inom AI-området. Anthropics egen ledning har upprepade gånger betonat risker och alignment som centrala orosmoment. Tidigare OpenAI-insidare, akademiska pionjärer och säkerhetsorganisationer har efterlyst att extrema AI-risker prioriteras på samma nivå som katastrofala biorisker eller kärnvapenhot. Dessa samtal har utmynnat i sannolikhetsbedömningar – ibland bryskt formulerade – om risken för att avancerad AI kan orsaka allvarlig global skada om den hanteras felaktigt.

Denna kör har drivit fram konkreta förslag: moratorier för specifika klasser av experiment, obligatoriska externa granskningar för kraftfulla system och fördragsbaserade metoder för verifiering och icke-spridning. Samtidigt uppmanar delar av communityt till försiktighet mot alarmism och betonar kvarvarande tekniska barriärer samt de sociala kostnaderna för överilade restriktioner. Spänningen mellan säkerhet och innovation ligger till grund för nästan varje politiskt förslag som växer fram idag.

Där styrningen är som svagast

Kaplan och andra pekar på styrningsglapp som det centrala politiska misslyckandet. Nuvarande regulatoriska ramverk är fragmenterade mellan olika jurisdiktioner och fokuserar främst på konsumentskydd, integritet och konkurrens – inte på den unika dynamiken i system som kan modifiera sig själva i maskinskala. Konkurrenstryck mellan företag och stater skapar incitament att pressa förmågans frontlinjer, vilket potentiellt undergräver kollektiva säkerhetsmål.

Att utforma styrning för rekursiv självförbättring väcker svåra frågor: vilka typer av självträning ska tillåtas; vilka aktörer har tillstånd att utföra sådana experiment; hur ska man testa och certifiera system som kan förändra sig själva på nya sätt; och hur bygger man verifierbara, manipulationssäkra granskningar som är meningsfulla över nationsgränser. Tidigare rustningskontrollregimer erbjuder lärdomar om verifiering och utformning av fördrag, men AI:s digitala och distribuerade natur gör det icke-trivialt att replikera dessa modeller.

Ekonomiska och sociala sprickzoner

Utöver debatterna om existentiella risker understryker Kaplan och hans kollegor praktiska ekonomiska effekter. Om system med autonom självförbättring tillåts skalas upp, skulle de kunna automatisera inte bara rutinuppgifter utan även komplext kognitivt arbete – vilket påskyndar undanträngningen inom tjänstemannasektorer. Det väcker socialpolitiska frågor om arbete, beskattning och omfördelning, utöver de existentiella problemen med feljusterad måluppfyllelse.

Det finns även en geopolitisk dimension: koncentration av förmåga hos ledande länder eller företag kan skapa destabiliserande dynamik. En internationell kapplöpning om att distribuera självförbättrande system riskerar att urholka incitamenten för samarbete; omvänt skulle samordnade begränsningar kräva robusta verifieringsmekanismer som många regeringar ännu inte har den institutionella kapaciteten att implementera.

Teknisk begränsning: alignment och verifiering

På den tekniska fronten är communityts svar uppdelat i två strömmar. Den ena driver alignment-forskning: bättre målspecifikationer, tolkbarhetsverktyg, belöningsrobusta träningsmetoder och adversariell testning för att förstå fellägen. Den andra strömmen fokuserar på verifiering, granskningskedjor och operativa begränsningar – i princip att skapa säkerhetsställningar runt system för att förhindra ej godkända autonoma cykler.

Kaplan hävdar att det är nödvändigt att investera kraftigt i båda innan autonomitröskeln passeras. I praktiken innebär detta skalbar tolkbarhet så att människor kan inspektera interna modellprocesser, provenanssystem för träningsdata och mjukvaruändringar, samt stärkt intern styrning inom företag för att begränsa vilka testmiljöer som kan initiera självförbättringscykler.

Vägen framåt: pausa, testa eller tillåta

Beslutsfattare och företag står inför tre övergripande val. Det första är att pausa vissa utvecklingsvägar tills verifierings- och alignment-tekniker mognat. Det andra är att tillåta begränsade pilottester under sträng granskning och multinationell tillsyn. Det tredje är att fortsätta en kapplöpningsliknande utveckling som prioriterar utrullning av förmågor framför global samordning. Kaplans inramning – ett beslut mellan nu och 2030 – är utformad för att tydliggöra avvägningarna: att tillåta rekursiv självförbättring kan ge transformativa fördelar, men det överför också en ny typ av strategisk risk på samhället.

Huruvida regeringar kommer att behandla detta som en brådskande strategisk prioritet är fortfarande en öppen fråga. Framstegen inom AI går snabbt; institutionell förändring går långsammare. Denna obalans är själva kärnan i Kaplans varning.

De kommande åren kommer att pröva om fältet kan utveckla styrning och teknisk säkerhet snabbt nog för att vända en potentiellt katastrofal övergång till en kontrollerad innovationsvåg.

Källor

- Anthropic (företagsintervju och interna forskningsuttalanden)

- Center for AI-säkerhet (offentliga uttalanden om extrema AI-risker)

- Nature (rapportering om avancerade AI-applikationer inom vetenskapliga domäner)

Comments

No comments yet. Be the first!