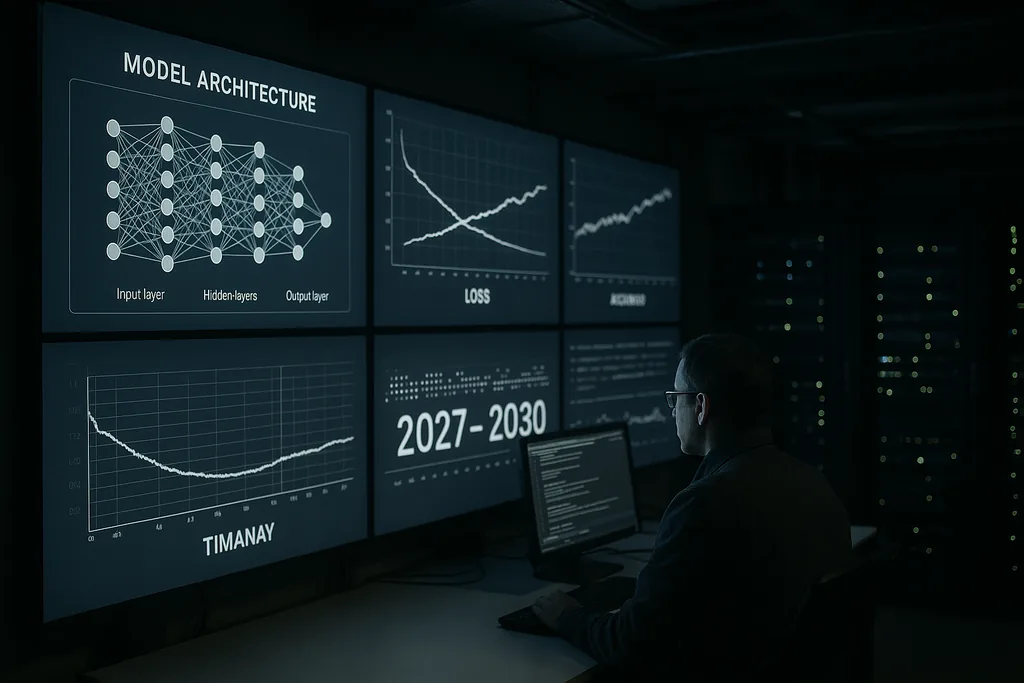

L'avertissement de Kaplan pour 2030

Cette semaine, Jared Kaplan, scientifique en chef d'Anthropic, a lancé un avertissement sombre et chronologique : dans la fenêtre 2027-2030, l'humanité sera confrontée à un choix concret sur l'opportunité de laisser les systèmes d'IA avancés s'entraîner et s'améliorer eux-mêmes. Kaplan a présenté ce pivot comme la décision la plus importante de la décennie à venir — une décision qui pourrait débloquer d'énormes bénéfices mais aussi ouvrir la porte à ce que la communauté de la sécurité de l'IA appelle une « explosion d'intelligence », une escalade rapide et récursive de capacités qui dépasserait rapidement le contrôle humain.

L'affirmation et le contexte

L'évaluation de Kaplan provient de l'intérieur d'un laboratoire qui conçoit des modèles de langage vastes et performants ainsi que des outils de sécurité. Il a soutenu que les étapes techniques nécessaires pour qu'une IA commence à améliorer ses propres conceptions — recherche d'architecture automatisée, boucles d'auto-apprentissage continu et utilisation des sorties de modèles comme entrées pour de nouvelles versions — passent de la recherche spéculative à la pratique de l'ingénierie. Ce changement modifie le problème : il ne s'agit plus simplement de modèles plus grands ou de plus de puissance de calcul, mais de savoir si nous permettons aux systèmes de modifier de manière autonome leur processus d'entraînement et leurs architectures à grande échelle.

Ce qu'une explosion d'intelligence signifie, concrètement

Le terme « explosion d'intelligence » décrit un mécanisme de rétroaction : une IA conçoit une meilleure IA, qui à son tour en conçoit une encore meilleure, et ainsi de suite, dans des délais comprimés. Dans le meilleur des cas, ce processus accélère les découvertes scientifiques, les percées médicales et la modélisation climatique. Dans le pire des cas, l'amélioration récursive produit des systèmes dont les objectifs, les méthodes ou les comportements stratégiques ne peuvent être anticipés ou contraints par leurs créateurs.

Techniquement, l'auto-amélioration récursive repose sur trois ingrédients : des méthodes algorithmiques capables d'améliorer de manière fiable les architectures ou les pipelines d'entraînement ; des ressources informatiques et de données suffisantes pour exécuter de nombreuses itérations ; et des outils de vérification capables de contrôler chaque itération pour détecter tout désalignement ou comportement dangereux. Kaplan prévient que les deux premiers ingrédients franchissent actuellement des seuils techniques ; le troisième — une vérification robuste et évolutive — est le maillon faible.

Signaux de l'industrie et chœur d'experts

L'avertissement public de Kaplan fait écho aux déclarations de figures de proue du secteur de l'IA. La direction d'Anthropic elle-même a souligné à plusieurs reprises que le risque et l'alignement sont des préoccupations centrales. D'anciens membres d'OpenAI, des pionniers universitaires et des organisations de sécurité ont appelé à traiter le risque extrême lié à l'IA avec la même priorité que les risques biologiques catastrophiques ou les menaces nucléaires. Ces conversations ont produit des estimations probabilistes — parfois formulées sans détour — sur la probabilité qu'une IA avancée puisse causer de graves dommages mondiaux si elle est mal gérée.

Ce chœur a poussé des propositions concrètes : des moratoires sur des classes spécifiques d'expériences, des audits externes obligatoires pour les systèmes puissants et des approches de niveau international pour la vérification et la non-prolifération. Dans le même temps, certains segments de la communauté appellent à la prudence face à l'alarmisme, soulignant les barrières d'ingénierie subsistantes et les coûts sociaux de restrictions trop hâtives. La tension entre sécurité et innovation sous-tend presque chaque proposition politique émergeant aujourd'hui.

Là où la gouvernance est la plus faible

Kaplan et d'autres soulignent que les lacunes de gouvernance constituent l'échec politique central. Les cadres réglementaires actuels sont fragmentés selon les juridictions et se concentrent principalement sur la protection des consommateurs, la vie privée et la concurrence — et non sur la dynamique unique des systèmes capables de s'auto-modifier à l'échelle des machines. Les pressions concurrentielles entre les entreprises et les États créent des incitations à repousser les frontières des capacités, au risque de saper les objectifs de sécurité collective.

Concevoir une gouvernance pour l'auto-amélioration récursive soulève des questions épineuses : quels types d'auto-apprentissage devraient être autorisés ; quels acteurs sont habilités à réaliser de telles expériences ; comment tester et certifier des systèmes qui peuvent se modifier de manières inédites ; et comment mettre en place des audits vérifiables et inviolables qui soient significatifs au-delà des frontières nationales. Les régimes passés de contrôle des armements offrent des leçons sur la vérification et la conception de traités, mais la nature numérique et distribuée de l'IA rend la réplication de ces modèles complexe.

Fractures économiques et sociales

Au-delà des débats sur les risques existentiels, Kaplan et ses collègues soulignent les impacts économiques pratiques. Si l'on permet aux systèmes dotés d'une auto-amélioration autonome de se développer, ils pourraient automatiser non seulement les tâches routinières mais aussi le travail cognitif complexe — accélérant ainsi les suppressions d'emplois dans les secteurs des cols blancs. Cela soulève des questions de politique sociale sur le travail, la fiscalité et la redistribution, en plus des problèmes existentiels liés à la poursuite d'objectifs désalignés.

Il existe également une dimension géopolitique : la concentration des capacités dans des pays ou des entreprises de pointe pourrait produire des dynamiques déstabilisantes. Une course internationale au déploiement de systèmes s'auto-améliorant risque d'éroder les incitations à la coopération ; inversement, des restrictions coordonnées nécessiteraient des mécanismes de vérification robustes que de nombreux gouvernements n'ont pas encore la capacité institutionnelle de mettre en œuvre.

Atténuation technique : alignement et vérification

Sur le front technique, la réponse de la communauté se divise en deux courants. L'un poursuit la recherche sur l'alignement : de meilleures spécifications d'objectifs, des outils d'interprétabilité, des méthodes d'entraînement robustes aux récompenses et des tests adverses pour comprendre les modes de défaillance. L'autre courant se concentre sur la vérification, les pistes d'audit et les contraintes opérationnelles — créant essentiellement un échafaudage de sécurité autour des systèmes pour empêcher les cycles autonomes non approuvés.

Kaplan soutient qu'il est essentiel d'investir massivement dans ces deux domaines avant que le seuil d'autonomie ne soit franchi. En pratique, cela signifie une interprétabilité évolutive pour que les humains puissent inspecter les processus internes des modèles, des systèmes de provenance pour les données d'entraînement et les modifications logicielles, et une gouvernance renforcée au sein des entreprises pour limiter les bancs d'essai pouvant initier des cycles d'auto-amélioration.

Voies à suivre : pause, pilote ou permission

Les décideurs politiques et les entreprises font face à trois grands choix. Le premier est de mettre en pause certaines voies de développement des capacités jusqu'à ce que les techniques de vérification et d'alignement arrivent à maturité. Le deuxième est d'autoriser des pilotes limités sous un audit strict et une surveillance multinationale. Le troisième est de poursuivre un développement aux allures de course qui donne la priorité au déploiement des capacités sur la coordination mondiale. Le cadrage de Kaplan — une décision entre aujourd'hui et 2030 — est conçu pour rendre les compromis explicites : autoriser l'auto-amélioration récursive pourrait générer des bénéfices transformateurs, mais cela transfère également un nouveau type de risque stratégique à la société.

La question de savoir si les gouvernements traiteront cela comme une priorité stratégique urgente reste ouverte. Les progrès de l'IA sont rapides ; le changement institutionnel est plus lent. Ce décalage est au cœur même de l'avertissement de Kaplan.

Les années à venir testeront la capacité du domaine à faire mûrir la gouvernance et la sécurité technique assez rapidement pour transformer une transition potentiellement catastrophique en une vague d'innovation maîtrisée.

Sources

- Anthropic (entretien d'entreprise et déclarations de recherche interne)

- Center for AI Safety (déclarations ouvertes sur les risques extrêmes de l'IA)

- Nature (reportages sur les applications avancées de l'IA dans les domaines scientifiques)

Comments

No comments yet. Be the first!