Wstęp: Klasa na rozdrożu

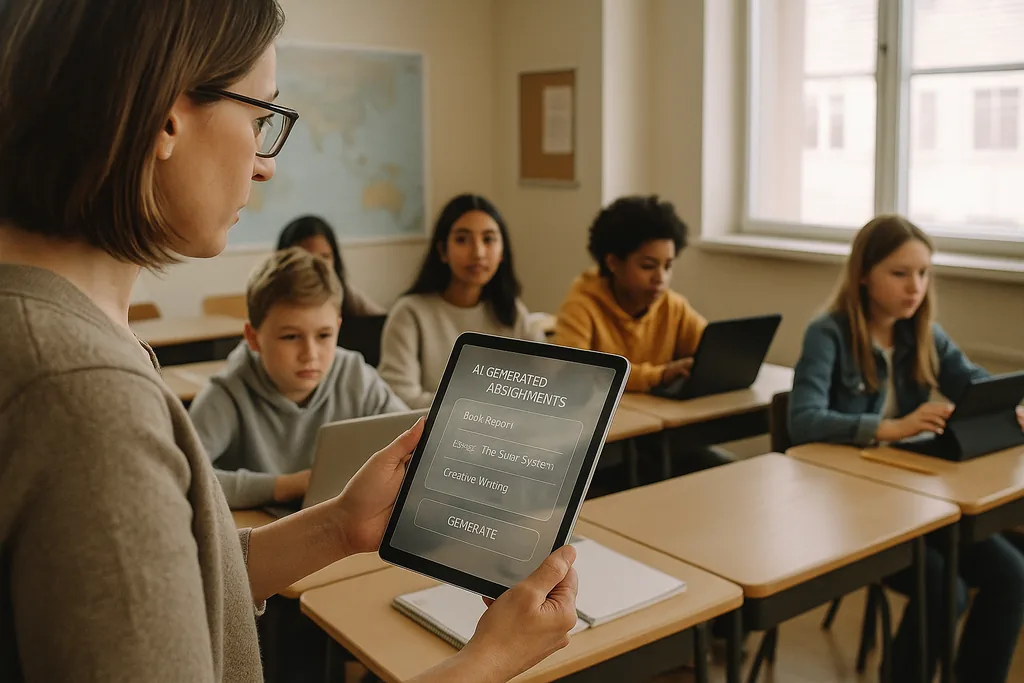

W rzęsiście oświetlonej klasie gimnazjalnej na przedmieściach Ohio w tym miesiącu (styczeń 2026), nauczyciel obsługuje platformę AI, która generuje indywidualne ćwiczenia matematyczne dla każdego ucznia. Scena ta – reklamowana przez dostawców jako skuteczny sposób na niwelowanie luk w nauce i odciążenie nauczycieli, by mogli skupić się na pracy w małych grupach – znajduje się obecnie w centrum intensywnej debaty. W całych Stanach Zjednoczonych okręgi szkolne, dysponujące pokaźnymi popandemicznymi budżetami na technologię i borykające się z niedoborami nauczycieli, podpisują kontrakty z dostawcami EdTech; jednocześnie rosnąca rzesza pedagogów, obrońców praw obywatelskich i agencji międzynarodowych argumentuje, że koszty pośpiesznego wdrażania AI mogą być znacznie większe niż korzyści.

Problem z danymi: uprzedzenia wpisane w narzędzia edukacyjne

Gdy algorytm rutynowo przypisuje niższe oceny lub częstsze interwencje tym samym grupom demograficznym, efekt nie jest jedynie błędem technicznym: staje się mechanizmem instytucjonalnym, który utrwala nierówności. Dyrektorzy szkół stają przed dylematem prawnym i etycznym, ponieważ wybory dotyczące zamówień – to, jakie platformy kupić, jakie dane gromadzić i jak długo je przechowywać – decydują o tym, którzy uczniowie będą poddawani zautomatyzowanym ocenom, a którzy nie.

Pedagogika i problem „czarnej skrzynki”

Poza kwestiami uprzedzeń i prywatności, nauczyciele obawiają się długofalowych konsekwencji edukacyjnych wynikających z outsourcingu pracy kognitywnej do nieprzejrzystych systemów. Generatywna sztuczna inteligencja potrafi stworzyć poprawny esej lub rozwiązać zadanie krok po kroku, ale gdy uczniowie polegają na maszynie w kwestii generowania pomysłów, formułowania argumentów czy szkicowania rozwiązań, celowy wysiłek poznawczy, który rozwija krytyczne myślenie, może zaniknąć. Nauka to nie tylko poprawne odpowiedzi, ale proces myślenia – pokazywanie toku rozumowania, zmaganie się z kontrargumentami, poprawianie wersji roboczych – a wiele obecnych narzędzi AI ten proces zaciemnia.

Sytuację pogarsza charakter wielu modeli przypominający „czarną skrzynkę”. Uczniowie i nauczyciele rzadko widzą, jak wygenerowano rekomendację lub ocenę, co utrudnia przekształcenie zautomatyzowanego wyniku w moment instruktażowy. Federalne wytyczne dotyczące edukacji kładą nacisk na utrzymanie czynnika ludzkiego (human-in-the-loop) przy podejmowaniu istotnych decyzji właśnie z tego powodu: odpowiedzialność, interpretowalność i profesjonalny osąd pedagoga pozostają kluczowe dla rzetelnej pedagogiki.

Nadzór, zgoda i nadszarpnięte zaufanie

AI w szkołach często niesie ze sobą nowe formy nadzoru. Oprogramowanie do proctoringu, analityka zachowań i telemetria platform tworzą zapisy twarzy uczniów, ich ruchów, wzorców pisania na klawiaturze i czasu poświęconego na zadania. Dane te są cenne dla dostawców i administratorów szkół, ale są również wrażliwe: kwestie tego, kto ma do nich dostęp, jak długo są przechowywane i czy są wykorzystywane do tworzenia nowych produktów komercyjnych, to pytania, na które wiele okręgów nie znalazło jeszcze wyczerpujących odpowiedzi.

Dla rodzin i nauczycieli wszechobecny monitoring może nadszarpnąć zaufanie. Uczniowie wiedzący, że są stale obserwowani, prawdopodobnie zmienią swoje zachowanie w sposób szkodliwy dla nauki: unikając naturalnych momentów dekoncentracji, które mogą prowadzić do kreatywnych poszukiwań, lub odczuwając lęk obniżający wyniki. Kwestia zgody jest skomplikowana w szkolnictwie podstawowym i średnim (K–12), ponieważ osoby nieletnie nie zawsze mogą świadomie wyrazić zgodę, a rodzice mogą nie mieć jasnych, porównywalnych opcji wyboru, gdy usługi dostawców są łączone w kontrakty obejmujące całe okręgi.

Nierówne wdrożenia i nowa przepaść cyfrowa

Zamiast wyrównywać szanse, AI może pogłębiać istniejące podziały. Bogatsze okręgi są w stanie testować solidne produkty, wymagać ochrony prywatności w kontraktach i finansować rozwój zawodowy, aby nauczyciele mogli rozważnie integrować te narzędzia. Okręgi z mniejszymi zasobami mogą akceptować bezpłatne lub tańsze usługi, które wiążą się ze słabszymi gwarancjami prywatności, mniejszą przejrzystością i minimalnym przeszkoleniem. Wynik: dwa poziomy AI w edukacji – zaawansowane, dobrze wspierane wdrożenia w niektórych szkołach oraz słabo nadzorowane, mało wspierane systemy w innych.

Ten rozłam nie tylko pogłębia luki w wynikach nauczania, ale tworzy odmienne modele edukacyjne. W zamożnych okręgach AI może służyć jako asystent dobrze przeszkolonych pedagogów; gdzie indziej ryzykuje staniem się substytutem inwestycji w nauczycieli i programy nauczania.

Oddolny opór i wezwanie do „cyfrowej rozwagi”

Sprzeciw formuje się na wielu szczeblach. Grupy nauczycieli, koalicje rodziców i organizacje praw obywatelskich proszą okręgi o spowolnienie zakupów, nakazanie pilotaży i wymaganie niezależnych audytów pod kątem uprzedzeń i naruszeń prywatności. Wielu zwolenników tych zmian nie jest przeciwnych technologii; opowiadają się oni za pedagogiką. Ich żądaniem jest trzeźwy, oparty na dowodach proces: małe programy pilotażowe, pomiar efektów uczenia się, testowanie pod kątem nierównego traktowania oraz angażowanie nauczycieli i rodzin w decyzje zakupowe.

Od zamówień do odpowiedzialności: konkretne kroki

Przejście od szybkiej adaptacji do odpowiedzialnego użytkowania wymaga zmiany priorytetów. Okręgi powinny traktować zamówienia na AI jako decyzję z zakresu polityki publicznej, a nie rutynowy zakup IT. Oznacza to żądanie od dostawców jasnej dokumentacji dotyczącej źródeł danych i praktyk łagodzenia uprzedzeń, wymaganie wyjaśnialności każdej decyzji wpływającej na ocenianie lub dyscyplinę oraz określenie umownych ograniczeń w ponownym wykorzystaniu danych. Inwestycje w szkolenia nauczycieli i integrację z programem nauczania muszą towarzyszyć każdemu wdrożeniu; licencje na oprogramowanie bez kapitału ludzkiego przyniosą gorsze efekty i będą nieść ryzyko szkód.

Regulatorzy i darczyńcy mają do odegrania określoną rolę. Agencje publiczne mogą zapewnić niezależne ramy ewaluacji, finansować badania pilotażowe mierzące zarówno postępy w nauce, jak i efekty w zakresie równości, oraz wydawać wytyczne dotyczące zamówień priorytetyzujące prywatność i przejrzystość. Bez tego systemowego wsparcia okręgi nadal będą mierzyć się z asymetryczną siłą przetargową w starciu z dużymi dostawcami oraz nierównomiernym poziomem ochrony.

O co toczy się gra

Decyzje podejmowane obecnie w biurach ds. zamówień i przez rady szkolne ukształtują sposób, w jaki całe pokolenie będzie doświadczać nauki. AI ma potencjał, by wzmacniać dobre nauczanie i personalizować edukację na dużą skalę – ale ma też zdolność do formalizowania dyskryminacji, utrwalania nadzoru i osłabiania wysiłku intelektualnego, który szkoły mają wspierać. Pytanie dla liderów edukacji nie brzmi, czy używać AI, ale jak robić to w sposób chroniący prawa uczniów i wzmacniający pedagogikę, zamiast ją zastępować.

Podpisując wieloletnie kontrakty, okręgi nie tylko kupują oprogramowanie; aprobują wizję tego, czym powinna być szkoła. Najbezpieczniejsza ścieżka jest pragmatyczna i skoncentrowana na człowieku: testować, mierzyć, wymagać przejrzystości, inwestować w ludzi i uczynić sprawiedliwość społeczną domyślnym ograniczeniem dla każdego wdrożenia technicznego.

Źródła

- Center for Democracy & Technology — raport na temat szkód i zagrożeń związanych z AI w edukacji

- American Civil Liberties Union — analiza AI i nierówności

- U.S. Department of Education — raport „Sztuczna inteligencja i przyszłość nauczania i uczenia się”

- UNESCO — „Wytyczne dla generatywnej sztucznej inteligencji w edukacji i badaniach”

Comments

No comments yet. Be the first!