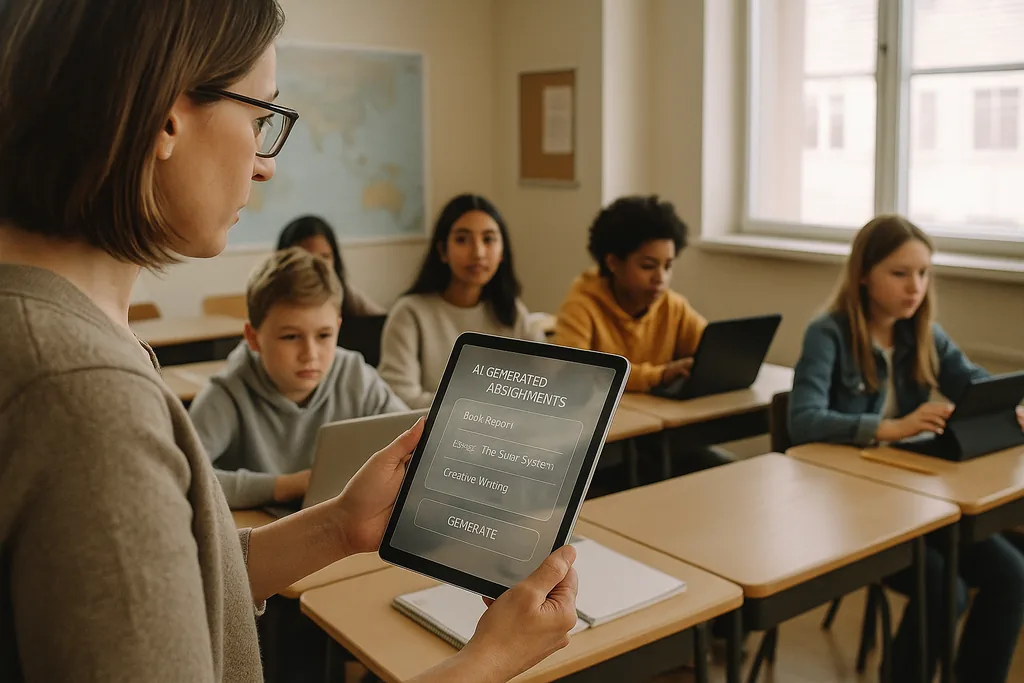

L’accroche : une salle de classe et une croisée des chemins

Ce mois-ci (janvier 2026), dans une salle de classe de collège brillamment éclairée de la banlieue de l'Ohio, un enseignant parcourt une plateforme d'IA qui génère des exercices de mathématiques individualisés pour chaque élève. Cette scène — présentée par les fournisseurs comme un moyen efficace de combler les lacunes d'apprentissage et de libérer les enseignants pour l'instruction en petits groupes — se trouve désormais au centre d'un débat intense. Partout aux États-Unis, des districts disposant de budgets technologiques post-pandémie conséquents et pressés par la pénurie d'enseignants signent des contrats avec des fournisseurs d'EdTech ; parallèlement, un nombre croissant d'éducateurs, de défenseurs des droits civiques et d'agences internationales soutiennent que les coûts d'une adoption précipitée de l'IA pourraient être bien supérieurs aux bénéfices.

Le problème des données : des biais ancrés dans les outils d'apprentissage

Lorsqu'un algorithme attribue systématiquement des scores plus bas ou des interventions plus fréquentes aux mêmes groupes démographiques, l'effet n'est pas un simple bug technique : il devient un mécanisme institutionnel qui fige l'inégalité. Les responsables scolaires font face à un dilemme juridique et éthique, car les choix d'approvisionnement — quelles plateformes acheter, quelles données collecter, combien de temps les conserver — déterminent quels élèves seront soumis à des jugements automatisés et lesquels ne le seront pas.

La pédagogie et le problème de la « boîte noire »

Au-delà du biais et de la vie privée, les enseignants s'inquiètent des conséquences éducatives à long terme de l'externalisation du travail cognitif à des systèmes opaques. L'IA générative peut produire un essai passable ou résoudre un problème étape par étape, mais lorsque les élèves s'appuient sur la machine pour générer des idées, rédiger des arguments ou esquisser des solutions, l'effort cognitif délibéré qui développe la pensée critique peut s'atrophier. L'apprentissage ne concerne pas seulement les bonnes réponses, mais le processus de réflexion — montrer son travail, se confronter à des contre-arguments, réviser des ébauches — et de nombreux outils d'IA actuels occultent ce processus.

À cela s'ajoute la nature de « boîte noire » de nombreux modèles. Les élèves et les enseignants voient rarement comment une recommandation ou une note a été obtenue, ce qui rend difficile la transformation d'un résultat automatisé en un moment pédagogique. Les directives fédérales en matière d'éducation ont insisté sur le maintien d'un « humain dans la boucle » pour les décisions importantes précisément pour cette raison : la responsabilité, l'interprétabilité et le jugement professionnel de l'éducateur restent essentiels à une pédagogie saine.

Surveillance, consentement et confiance brisée

L'IA à l'école apporte souvent avec elle de nouvelles formes de surveillance. Les logiciels de surveillance d'examens, l'analyse comportementale et la télémétrie des plateformes créent des enregistrements des visages, des mouvements, des habitudes de frappe et du temps passé sur une tâche par les élèves. Ces données sont précieuses pour les fournisseurs et les administrateurs scolaires, mais elles sont aussi sensibles : qui peut y accéder, combien de temps sont-elles stockées et si elles sont utilisées pour développer de nouveaux produits commerciaux sont des questions auxquelles de nombreux districts n'ont pas encore répondu de manière exhaustive.

Pour les familles et les enseignants, la présence d'une surveillance généralisée peut éroder la confiance. Les élèves qui savent qu'ils sont observés en permanence sont susceptibles de modifier leur comportement d'une manière qui nuit à l'apprentissage : éviter les comportements légitimement déconnectés qui peuvent mener à l'exploration créative, ou ressentir une anxiété qui mine les performances. Le consentement est complexe dans les cadres scolaires (K-12) car les mineurs ne peuvent pas toujours donner un accord pleinement éclairé, et les parents peuvent ne pas disposer de choix clairs et comparables lorsque les services des fournisseurs sont regroupés dans des contrats à l'échelle du district.

Déploiements inéquitables et nouvelle fracture numérique

Loin d'uniformiser les chances, l'IA peut creuser une fracture existante. Les districts plus riches sont en mesure de tester des produits robustes, d'exiger des protections de la vie privée dans les contrats et de financer le développement professionnel pour que les enseignants puissent intégrer les outils de manière réfléchie. Les districts sous-dotés peuvent accepter des services gratuits ou à prix réduit assortis de garanties de confidentialité plus faibles, d'une transparence moindre et d'une formation minimale. Le résultat : deux niveaux d'IA dans l'éducation — des déploiements premium et bien encadrés dans certaines écoles, et des systèmes mal gouvernés et peu soutenus dans d'autres.

Cette scission ne se contente pas d'élargir les écarts de réussite, elle produit des modèles éducatifs divergents. Dans les districts aisés, l'IA peut servir d'assistant à des éducateurs bien formés ; ailleurs, elle risque de devenir un substitut à l'investissement dans les enseignants et les programmes scolaires.

Résistance citoyenne et appel à la « raison numérique »

Une contestation se forme à plusieurs niveaux. Des groupements d'enseignants, des coalitions de parents et des organisations de défense des droits civiques demandent aux districts de ralentir les achats, de rendre les projets pilotes obligatoires et d'exiger des audits indépendants sur les biais et les atteintes à la vie privée. De nombreux défenseurs ne sont pas anti-technologie ; ils sont pro-pédagogie. Leur demande porte sur un processus sobre et fondé sur des preuves : tester à petite échelle, mesurer les résultats d'apprentissage, tester les impacts disparates et impliquer les enseignants et les familles dans les décisions d'achat.

De l'approvisionnement à la responsabilité : mesures concrètes

Passer d'une adoption rapide à une utilisation responsable nécessite un changement de priorités. Les districts devraient traiter l'achat d'IA comme une décision de politique publique plutôt que comme un achat informatique de routine. Cela signifie demander aux fournisseurs une documentation claire sur les sources de données et les pratiques d'atténuation des biais, exiger l'explicabilité pour toute décision affectant la notation ou la discipline, et spécifier des limites contractuelles sur la réutilisation des données. Les investissements dans la formation des enseignants et l'intégration curriculaire doivent accompagner tout déploiement ; des licences logicielles sans capacité humaine produiront des résultats décevants et risqueront de causer des préjudices.

Les régulateurs et les bailleurs de fonds ont un rôle à jouer. Les agences publiques peuvent fournir des cadres d'évaluation indépendants, financer des études pilotes qui mesurent à la fois les gains d'apprentissage et les résultats en matière d'équité, et publier des directives d'achat qui privilégient la vie privée et la transparence. Sans ces soutiens systémiques, les districts continueront de faire face à un pouvoir de négociation asymétrique avec les grands fournisseurs et à un paysage de protections inégal.

Les enjeux

Les choix faits aujourd'hui dans les bureaux d'approvisionnement et les conseils scolaires façonneront la manière dont toute une génération vivra l'apprentissage. L'IA a le potentiel d'amplifier un bon enseignement et de personnaliser l'instruction à grande échelle — mais elle a aussi la capacité d'institutionnaliser la discrimination, d'ancrer la surveillance et de diluer le travail intellectuel que les écoles sont censées favoriser. La question pour les leaders de l'éducation n'est pas de savoir s'il faut utiliser l'IA, mais comment le faire de manière à protéger les droits des élèves et à renforcer la pédagogie plutôt que de la remplacer.

Alors que les districts signent des contrats pluriannuels, ils n'achètent pas seulement des logiciels ; ils valident une vision de ce que l'école devrait être. La voie la plus sûre est pragmatique et centrée sur l'humain : tester, mesurer, exiger la transparence, investir dans les personnes et faire de l'équité la contrainte par défaut de tout déploiement technique.

Sources

- Center for Democracy & Technology — rapport sur les préjudices et les risques de l'IA dans l'éducation

- American Civil Liberties Union — analyse de l'IA et de l'iniquité

- U.S. Department of Education — rapport « Intelligence artificielle et futur de l'enseignement et de l'apprentissage »

- UNESCO — « Guide pour l'IA générative dans l'éducation et la recherche »

Comments

No comments yet. Be the first!