Lede: Ein Klassenzimmer und ein Scheideweg

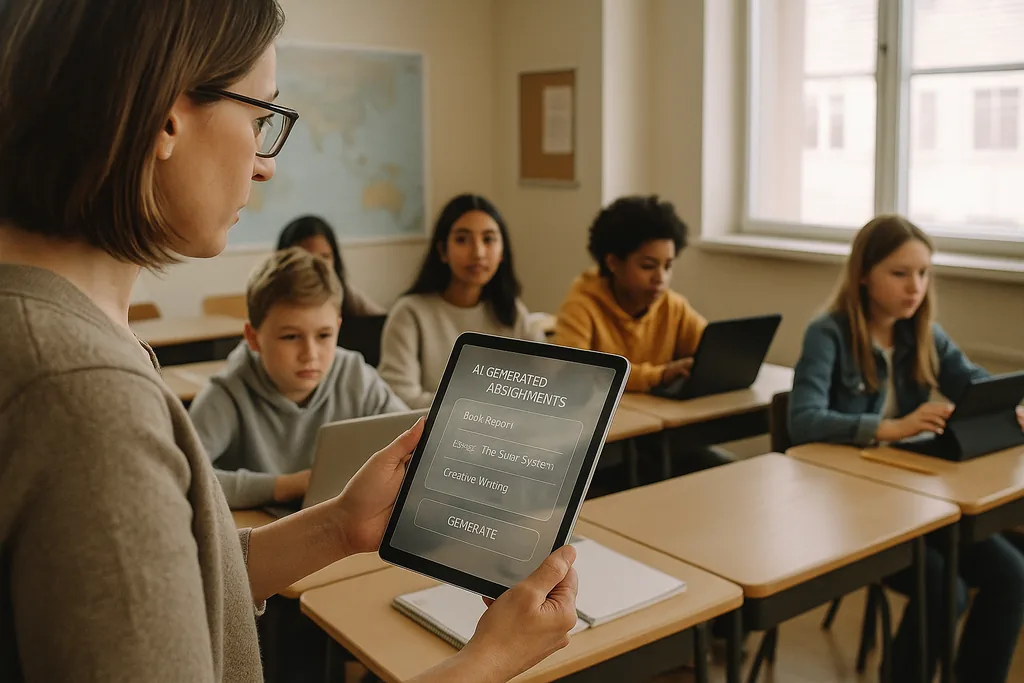

In einem hell erleuchteten Klassenzimmer einer Mittelschule in einem Vorort von Ohio tippt eine Lehrkraft diesen Monat (Januar 2026) auf einer KI-Plattform, die individualisierte Matheübungen für jeden Schüler generiert. Die Szene – von Anbietern als effizienter Weg angepriesen, um Lernlücken zu schließen und Lehrkräfte für den Unterricht in Kleingruppen freizustellen – steht nun im Zentrum einer intensiven Debatte. In den gesamten Vereinigten Staaten schließen Schulbezirke, die über reichlich Technologiebudgets aus der Zeit nach der Pandemie verfügen und durch Lehrermangel unter Druck geraten sind, Verträge mit EdTech-Anbietern ab. Gleichzeitig argumentiert ein wachsender Chor von Pädagogen, Bürgerrechtlern und internationalen Organisationen, dass die Kosten für den überstürzten Einsatz von KI weitaus höher sein könnten als der Nutzen.

Das Datenproblem: In Lernwerkzeuge eingebetteter Bias

Wenn ein Algorithmus routinemäßig denselben demografischen Gruppen niedrigere Punktzahlen oder häufigere Interventionen zuweist, ist der Effekt nicht nur ein technischer Fehler: Er wird zu einem institutionellen Mechanismus, der Ungleichheit festschreibt. Schulleitungen stehen vor einem rechtlichen und ethischen Dilemma, da Beschaffungsentscheidungen – welche Plattformen gekauft, welche Daten gesammelt und wie lange sie aufbewahrt werden – darüber entscheiden, welche Schüler automatisierten Urteilen unterworfen werden und welche nicht.

Pädagogik und das „Black Box“-Problem

Über Bias und Privatsphäre hinaus sorgen sich Lehrkräfte um die langfristigen pädagogischen Folgen der Auslagerung kognitiver Arbeit an undurchsichtige Systeme. Generative KI kann einen passablen Aufsatz verfassen oder ein Problem Schritt für Schritt lösen. Doch wenn Schüler sich darauf verlassen, dass die Maschine Ideen generiert, Argumente entwirft oder Lösungen skizziert, kann die bewusste kognitive Anstrengung, die kritisches Denken entwickelt, verkümmern. Beim Lernen geht es nicht nur um richtige Antworten, sondern um den Denkprozess – das Offenlegen der eigenen Arbeit, das Ringen mit Gegenargumenten, das Überarbeiten von Entwürfen –, und viele aktuelle KI-Tools verschleiern diesen Prozess.

Erschwerend kommt die „Black Box“-Natur vieler Modelle hinzu. Schüler und Lehrer sehen selten, wie eine Empfehlung oder eine Note hergeleitet wurde, was es schwierig macht, eine automatisierte Ausgabe in einen instruktiven Moment zu verwandeln. Die staatlichen Bildungsrichtlinien haben genau aus diesem Grund betont, dass der Mensch bei folgenschweren Entscheidungen die Kontrolle behalten muss („Human-in-the-Loop“): Rechenschaftspflicht, Interpretierbarkeit und das professionelle Urteilsvermögen der Lehrkraft bleiben für eine fundierte Pädagogik unerlässlich.

Überwachung, Einwilligung und erschüttertes Vertrauen

KI in Schulen bringt oft neue Formen der Überwachung mit sich. Proctoring-Software, Verhaltensanalysen und Plattform-Telemetrie erstellen Aufzeichnungen von Gesichtern, Bewegungen, Tippmustern und der Zeit, die Schüler mit Aufgaben verbringen. Diese Daten sind für Anbieter und Schulverwaltungen wertvoll, aber auch sensibel: Wer darauf zugreifen kann, wie lange sie gespeichert werden und ob sie zur Entwicklung neuer kommerzieller Produkte verwendet werden, sind Fragen, die viele Bezirke noch nicht umfassend beantwortet haben.

Für Familien und Lehrkräfte kann die ständige Überwachung das Vertrauen untergraben. Schüler, die wissen, dass sie kontinuierlich beobachtet werden, ändern wahrscheinlich ihr Verhalten auf eine Weise, die dem Lernen schadet: Sie vermeiden legitimes Abschweifen, das zu kreativen Erkundungen führen kann, oder empfinden Angst, die die Leistung beeinträchtigt. Die Einwilligung ist im K-12-Bereich kompliziert, da Minderjährige nicht immer eine voll informierte Zustimmung geben können und Eltern möglicherweise keine klaren, vergleichbaren Wahlmöglichkeiten haben, wenn Anbieter in bezirksweite Verträge eingebunden sind.

Ungerechte Einführung und eine neue digitale Kluft

Weit davon entfernt, für Chancengleichheit zu sorgen, kann KI eine bestehende Kluft vertiefen. Wohlhabendere Bezirke sind in der Lage, robuste Produkte zu testen, Datenschutzgarantien in Verträgen einzufordern und Fortbildungen zu finanzieren, damit Lehrer die Werkzeuge durchdacht integrieren können. Unterfinanzierte Bezirke akzeptieren möglicherweise kostenlose oder vergünstigte Dienste, die mit schwächeren Datenschutzgarantien, weniger Transparenz und minimaler Schulung einhergehen. Das Ergebnis: zwei Klassen von KI in der Bildung – hochwertige, gut unterstützte Einsätze in einigen Schulen und schlecht verwaltete, kaum unterstützte Systeme in anderen.

Diese Spaltung vergrößert nicht nur die Leistungslücken, sondern bringt auch unterschiedliche Bildungsmodelle hervor. In wohlhabenden Bezirken kann KI als Assistent für gut ausgebildete Pädagogen dienen; andernorts droht sie zu einem Ersatz für Investitionen in Lehrkräfte und Lehrpläne zu werden.

Widerstand an der Basis und ein Ruf nach „digitaler Vernunft“

Auf mehreren Ebenen formiert sich Widerstand. Lehrergruppen, Elternkoalitionen und Bürgerrechtsorganisationen fordern die Bezirke auf, die Beschaffung zu verlangsamen, Pilotprojekte vorzuschreiben und unabhängige Audits auf Bias und Datenschutzrisiken zu verlangen. Viele Befürworter sind nicht technologiefeindlich; sie sind pro-pädagogisch eingestellt. Ihre Forderung ist ein nüchterner, evidenzbasierter Prozess: klein anfangen, Lernergebnisse messen, auf ungleiche Auswirkungen testen und Lehrer sowie Familien in Beschaffungsentscheidungen einbeziehen.

Von der Beschaffung zur Rechenschaftspflicht: Konkrete Schritte

Der Übergang von der schnellen Einführung zur verantwortungsvollen Nutzung erfordert eine Verschiebung der Prioritäten. Bezirke sollten die Beschaffung von KI eher als eine öffentliche Grundsatzentscheidung denn als einen routinemäßigen IT-Kauf behandeln. Das bedeutet, von den Anbietern eine klare Dokumentation über Datenquellen und Praktiken zur Bias-Minimierung zu verlangen, Erklärbarkeit für jede Entscheidung einzufordern, die Noten oder Disziplinarmaßnahmen betrifft, und vertragliche Grenzen für die Wiederverwendung von Daten festzulegen. Investitionen in die Lehrerfortbildung und die Integration in den Lehrplan müssen jede Einführung begleiten; Softwarelizenzen ohne menschliche Kapazitäten werden hinter den Erwartungen zurückbleiben und Risiken bergen.

Regulierungsbehörden und Geldgeber haben ebenfalls Aufgaben zu erfüllen. Öffentliche Stellen können unabhängige Bewertungsrahmen bereitstellen, Pilotstudien finanzieren, die sowohl Lernerfolge als auch Gerechtigkeitsaspekte messen, und Beschaffungsrichtlinien herausgeben, die Datenschutz und Transparenz priorisieren. Ohne diese systemische Unterstützung werden die Bezirke gegenüber großen Anbietern weiterhin über eine asymmetrische Verhandlungsmacht verfügen und mit einer ungleichen Schutzlandschaft konfrontiert sein.

Was auf dem Spiel steht

Die Entscheidungen, die jetzt in Beschaffungsämtern und Schulbehörden getroffen werden, werden prägen, wie eine ganze Generation das Lernen erlebt. KI hat das Potenzial, guten Unterricht zu verstärken und Instruktionen in großem Maßstab zu personalisieren – aber sie hat auch die Fähigkeit, Diskriminierung zu formalisieren, Überwachung zu verankern und die intellektuelle Arbeit zu verwässern, die Schulen eigentlich fördern sollen. Die Frage für Bildungsverantwortliche ist nicht, ob sie KI einsetzen sollen, sondern wie sie dies auf eine Weise tun können, die die Rechte der Schüler schützt und die Pädagogik stärkt, anstatt sie zu ersetzen.

Wenn Bezirke mehrjährige Verträge unterzeichnen, kaufen sie nicht nur Software; sie unterstützen eine Vision davon, was Schule sein sollte. Der sicherste Weg ist pragmatisch und menschenzentriert: testen, messen, Transparenz fordern, in Menschen investieren und Gerechtigkeit zur Standardvorgabe für jeden technischen Einsatz machen.

Quellen

- Center for Democracy & Technology — Bericht über Schäden und Risiken von KI in der Bildung

- American Civil Liberties Union — Analyse von KI und Ungleichheit

- U.S. Department of Education — Bericht „Artificial Intelligence and the Future of Teaching and Learning“

- UNESCO — „Guidance for generative AI in education and research“

Kommentare

Noch keine Kommentare. Seien Sie der Erste!