Lead: Een klaslokaal op een kruispunt

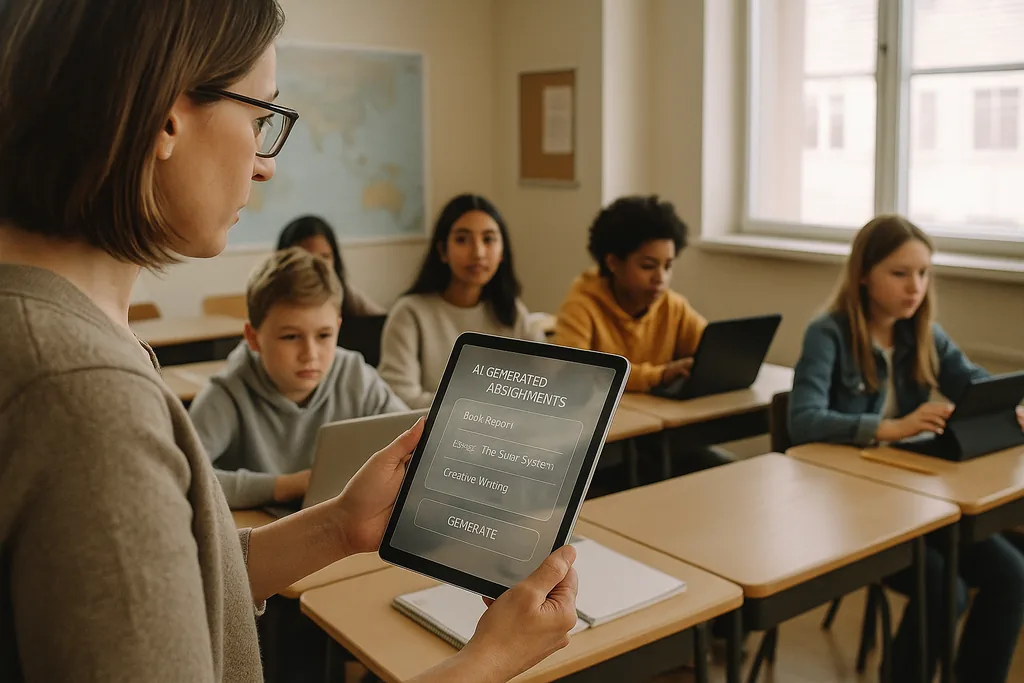

In een helder verlicht klaslokaal van een middelbare school in een voorstad van Ohio tikt een docent deze maand (januari 2026) door een AI-platform dat individuele wiskundeoefeningen genereert voor elke leerling. De scène — door leveranciers aangeprezen als een efficiënte manier om leerachterstanden in te halen en docenten vrij te maken voor instructie in kleine groepen — staat nu centraal in een intens debat. In de hele Verenigde Staten sluiten districten, ruim voorzien van technologiebudgetten van na de pandemie en onder druk gezet door lerarentekorten, contracten af met EdTech-leveranciers; tegelijkertijd stelt een groeiende groep pedagogen, burgerrechtenactivisten en internationale instanties dat de kosten van een overhaaste overstap naar AI wel eens veel groter zouden kunnen zijn dan de baten.

Het dataprobleem: ingebakken vooroordelen in leermiddelen

Wanneer een algoritme routinematig lagere scores of frequentere interventies toekent aan dezelfde demografische groepen, is dat niet louter een technische bug: het wordt een institutioneel mechanisme dat ongelijkheid bestendigt. Schoolbestuurders staan voor een juridisch en ethisch dilemma omdat inkoopkeuzes — welke platforms worden aangeschaft, welke gegevens worden verzameld, hoe lang deze worden bewaard — bepalen welke leerlingen onderworpen worden aan geautomatiseerde oordelen en welke niet.

Pedagogiek en het 'black box'-probleem

Naast vooroordelen en privacy maken docenten zich zorgen over de educatieve gevolgen op de lange termijn van het uitbesteden van cognitief werk aan ondoorzichtige systemen. Generatieve AI kan een acceptabel essay produceren of een probleem stap voor stap oplossen, maar wanneer leerlingen op de machine vertrouwen om ideeën te genereren, argumenten op te stellen of oplossingen te schetsen, kan de bewuste cognitieve inspanning die kritisch denken ontwikkelt, atrofiëren. Leren gaat niet alleen over de juiste antwoorden, maar over het denkproces — het tonen van de uitwerking, het worstelen met tegenargumenten, het herzien van concepten — en veel huidige AI-tools vertroebelen dat proces.

Dit wordt verergerd door de 'black box'-aard van veel modellen. Leerlingen en docenten zien zelden hoe een aanbeveling of een cijfer tot stand is gekomen, wat het moeilijk maakt om een geautomatiseerde output om te zetten in een leermoment. Federale onderwijsrichtlijnen hebben om precies die reden benadrukt dat er een mens ('human in the loop') betrokken moet blijven bij besluiten met grote gevolgen: verantwoording, interpreteerbaarheid en het professionele oordeel van de docent blijven essentieel voor een gezonde pedagogiek.

Toezicht, toestemming en geschonden vertrouwen

AI in scholen brengt vaak nieuwe vormen van surveillance met zich mee. Proctoringsoftware, gedragsanalyse en platformtelemetrie leggen de gezichten, bewegingen, typpatronen en taaktijd van leerlingen vast. Die gegevens zijn waardevol voor leveranciers en schoolbestuurders, maar ook gevoelig: wie er toegang toe heeft, hoe lang ze worden bewaard en of ze worden gebruikt om nieuwe commerciële producten te ontwikkelen, zijn vragen die veel districten nog niet uitgebreid hebben beantwoord.

Voor gezinnen en docenten kan de aanwezigheid van alomtegenwoordige monitoring het vertrouwen uithollen. Leerlingen die weten dat ze continu worden geobserveerd, zullen waarschijnlijk hun gedrag aanpassen op manieren die het leerproces schaden: het vermijden van legitiem 'off-task' gedrag dat kan leiden tot creatieve verkenning, of het ervaren van angst die prestaties ondermijnt. Toestemming is ingewikkeld in het basis- en voortgezet onderwijs omdat minderjarigen niet altijd volledig geïnformeerde instemming kunnen geven, en ouders krijgen mogelijk geen duidelijke, vergelijkbare keuzes wanneer leveranciers worden gebundeld in district-brede contracten.

Ongelijke uitrol en een nieuwe digitale kloof

Verre van het creëren van een gelijk speelveld, kan AI een bestaande kloof verdiepen. Rijkere districten zijn in staat om robuuste producten te testen, privacybescherming in contracten te eisen en professionele ontwikkeling te financieren, zodat docenten tools doordacht kunnen integreren. Districten met minder middelen accepteren mogelijk gratis of goedkopere diensten die gepaard gaan met zwakkere privacygaranties, minder transparantie en minimale training. Het resultaat: twee niveaus van AI in het onderwijs — hoogwaardige, goed ondersteunde implementaties in sommige scholen, en slecht beheerde, nauwelijks ondersteunde systemen in andere.

Die splitsing vergroot niet alleen de prestatiekloof, maar brengt ook uiteenlopende onderwijsmodellen voort. In welvarende districten kan AI dienen als assistent van goed opgeleide docenten; elders dreigt het een substituut te worden voor investeringen in leraren en curricula.

Verzet vanuit de basis en een roep om "digitale nuchterheid"

Er ontstaat weerstand op meerdere niveaus. Lerarencollectieven, oudercoalities en burgerrechtenorganisaties vragen districten om de inkoop te vertragen, proefprojecten te verplichten en onafhankelijke audits te eisen voor vooroordelen en privacyschade. Veel pleitbezorgers zijn niet tegen technologie; ze zijn voor pedagogiek. Hun eis is een nuchter, op bewijs gebaseerd proces: begin klein met pilots, meet leerresultaten, test op ongelijke effecten en betrek docenten en gezinnen bij inkoopbeslissingen.

Van inkoop naar verantwoording: concrete stappen

De overgang van snelle adoptie naar verantwoord gebruik vereist een verschuiving in prioriteiten. Districten zouden de inkoop van AI moeten behandelen als een beleidsbeslissing in plaats van een routineuze IT-aankoop. Dat betekent dat leveranciers om duidelijke documentatie over databronnen en methoden ter voorkoming van vooroordelen moet worden gevraagd, dat uitlegbaarheid vereist is voor elk besluit dat van invloed is op cijfers of discipline, en dat contractuele beperkingen op hergebruik van gegevens moeten worden vastgelegd. Investeringen in lerarenopleiding en curriculaire integratie moeten elke uitrol vergezellen; softwarelicenties zonder menselijke capaciteit zullen ondermaats presteren en risico's op schade met zich meebrengen.

Toezichthouders en financiers hebben een rol te spelen. Overheidsinstanties kunnen onafhankelijke evaluatiekaders bieden, proefstudies financieren die zowel leerwinst als gelijkheidsscores meten, en inkooprichtlijnen uitgeven die prioriteit geven aan privacy en transparantie. Zonder die systemische ondersteuning zullen districten te maken blijven krijgen met asymmetrische onderhandelingsmacht ten opzichte van grote leveranciers en een ongelijkmatig landschap van beschermingsmaatregelen.

Wat er op het spel staat

De keuzes die nu worden gemaakt in inkoopbureaus en schoolbesturen zullen bepalen hoe een hele generatie onderwijs ervaart. AI heeft de potentie om goed onderwijs te versterken en instructie op schaal te personaliseren — maar het heeft ook de capaciteit om discriminatie te formaliseren, surveillance te verankeren en de intellectuele inspanning die scholen moeten bevorderen, te verwateren. De vraag voor onderwijsleiders is niet of ze AI moeten gebruiken, maar hoe ze dat kunnen doen op manieren die de rechten van leerlingen beschermen en de pedagogiek versterken in plaats van te vervangen.

Terwijl districten meerjarige contracten ondertekenen, kopen ze niet alleen software; ze onderschrijven een visie op wat onderwijs zou moeten zijn. Het veiligste pad is pragmatisch en mensgericht: test in pilots, meet de resultaten, eis transparantie, investeer in mensen en maak gelijkheid de standaardvoorwaarde voor elke technische implementatie.

Bronnen

- Center for Democracy & Technology — rapport over schade en risico's van AI in het onderwijs

- American Civil Liberties Union — analyse van AI en ongelijkheid

- U.S. Department of Education — rapport "Artificiële Intelligentie and the Future of Teaching and Learning"

- UNESCO — "Guidance for generative AI in education and research"

Comments

No comments yet. Be the first!