Entradilla: Un aula y una encrucijada

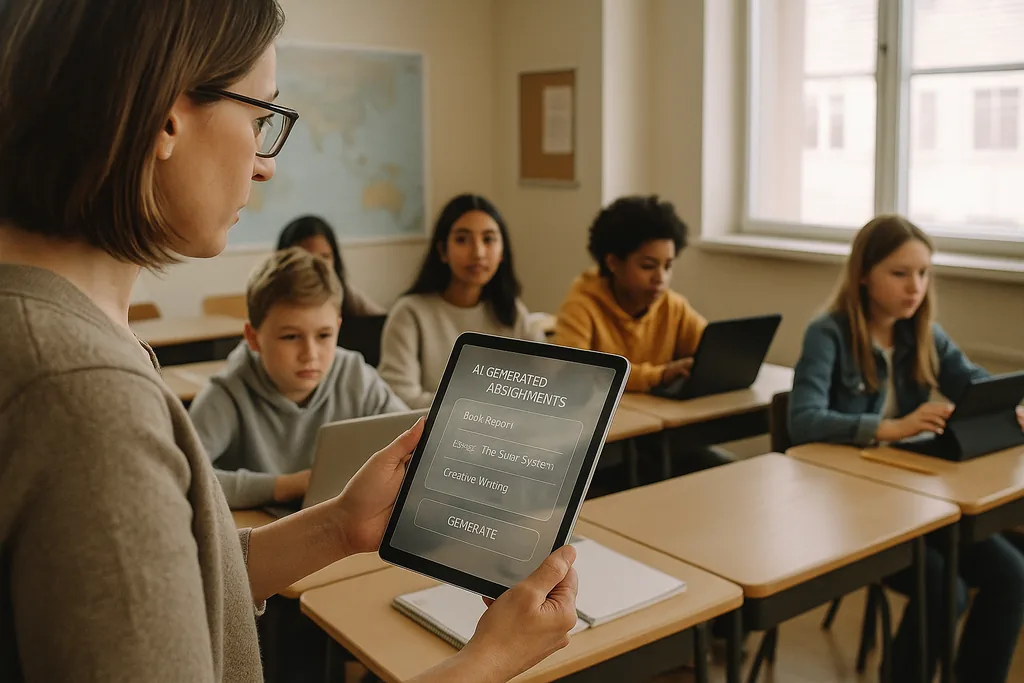

En un aula de secundaria intensamente iluminada en las afueras de Ohio este mes (enero de 2026), un profesor navega por una plataforma de IA que genera ejercicios de matemáticas individualizados para cada alumno. La escena —promocionada por los proveedores como una forma eficiente de cerrar las brechas de aprendizaje y liberar a los docentes para la instrucción en grupos pequeños— se encuentra ahora en el centro de un intenso debate. En todo Estados Unidos, distritos dotados de presupuestos tecnológicos post-pandemia y presionados por la escasez de profesores están contratando a proveedores de EdTech; simultáneamente, un coro creciente de educadores, defensores de los derechos civiles y organismos internacionales argumenta que los costes de apresurarse hacia la IA pueden ser mucho mayores que los beneficios.

El problema de los datos: sesgo intrínseco en las herramientas de aprendizaje

Cuando un algoritmo asigna sistemáticamente puntuaciones más bajas o intervenciones más frecuentes a los mismos grupos demográficos, el efecto no es simplemente un error técnico: se convierte en un mecanismo institucional que consolida la desigualdad. Los líderes escolares se enfrentan a un dilema ético y legal, ya que las decisiones de adquisición —qué plataformas comprar, qué datos recopilar, cuánto tiempo conservarlos— determinan qué estudiantes estarán sujetos a juicios automatizados y cuáles no.

La pedagogía y el problema de la "caja negra"

Más allá del sesgo y la privacidad, a los docentes les preocupan las consecuencias educativas a largo plazo de subcontratar el trabajo cognitivo a sistemas opacos. La IA generativa puede producir un ensayo aceptable o resolver un problema paso a paso, pero cuando los estudiantes dependen de la máquina para generar ideas, redactar argumentos o esbozar soluciones, el esfuerzo cognitivo deliberado que desarrolla el pensamiento crítico puede atrofiarse. El aprendizaje no consiste solo en obtener respuestas correctas, sino en el proceso de pensamiento —mostrar el trabajo realizado, lidiar con contraargumentos, revisar borradores— y muchas herramientas de IA actuales oscurecen ese proceso.

A esto se suma la naturaleza de "caja negra" de muchos modelos. Los estudiantes y profesores rara vez ven cómo se derivó una recomendación o una calificación, lo que dificulta convertir un resultado automatizado en un momento de instrucción. Las directrices educativas federales han enfatizado la importancia de mantener a un humano en el proceso (human in the loop) para decisiones trascendentales precisamente por esta razón: la rendición de cuentas, la interpretabilidad y el juicio profesional del educador siguen siendo esenciales para una pedagogía sólida.

Vigilancia, consentimiento y confianza fracturada

La IA en las escuelas a menudo trae consigo nuevas formas de vigilancia. El software de supervisión (proctoring), la analítica de comportamiento y la telemetría de las plataformas crean registros de los rostros, movimientos, patrones de escritura y tiempo de dedicación a las tareas de los alumnos. Esos registros son valiosos para los proveedores y los administradores escolares, pero también sensibles: quién puede acceder a ellos, cuánto tiempo se almacenan y si se utilizan para desarrollar nuevos productos comerciales son preguntas que muchos distritos aún no han respondido de manera integral.

Para las familias y los profesores, la presencia de una monitorización generalizada puede erosionar la confianza. Es probable que los estudiantes que saben que están siendo observados continuamente cambien su comportamiento de formas que perjudiquen el aprendizaje: evitando conductas legítimas ajenas a la tarea que pueden conducir a la exploración creativa, o sintiendo una ansiedad que socava el rendimiento. El consentimiento es complicado en los entornos K-12 porque los menores no siempre pueden proporcionar un acuerdo plenamente informado, y es posible que a los padres no se les ofrezcan opciones claras y comparables cuando los proveedores se agrupan en contratos a nivel de distrito.

Implementaciones desiguales y una nueva brecha digital

Lejos de igualar las oportunidades, la IA puede profundizar la brecha existente. Los distritos más ricos pueden pilotar productos robustos, exigir protecciones de privacidad en los contratos y financiar el desarrollo profesional para que los profesores integren las herramientas con criterio. Los distritos con menos recursos pueden aceptar servicios gratuitos o de nivel de descuento que conllevan garantías de privacidad más débiles, menos transparencia y una formación mínima. El resultado: dos niveles de IA en la educación —despliegues premium y bien respaldados en algunas escuelas, y sistemas mal gobernados y con poco apoyo en otras.

Esa división no solo amplía las brechas de rendimiento, sino que produce modelos educativos divergentes. En los distritos prósperos, la IA puede servir como asistente para educadores bien formados; en otros lugares, corre el riesgo de convertirse en un sustituto de la inversión en profesores y currículos.

Resistencia de base y una llamada a la "cordura digital"

La oposición se está formando a múltiples niveles. Grupos de profesores, coaliciones de padres y organizaciones de derechos civiles están pidiendo a los distritos que ralenticen las adquisiciones, exijan proyectos piloto y requieran auditorías independientes sobre sesgos y riesgos para la privacidad. Muchos defensores no están en contra de la tecnología; están a favor de la pedagogía. Su demanda es un proceso sobrio y basado en la evidencia: pilotar a pequeña escala, medir los resultados de aprendizaje, comprobar los impactos dispares e involucrar a profesores y familias en las decisiones de compra.

De la contratación a la rendición de cuentas: pasos concretos

Pasar de una adopción rápida a un uso responsable requiere un cambio de prioridades. Los distritos deben tratar la adquisición de IA como una decisión de política pública en lugar de una compra rutinaria de TI. Eso significa pedir a los proveedores documentación clara sobre las fuentes de datos y las prácticas de mitigación de sesgos, exigir explicabilidad para cualquier decisión que afecte a la calificación o la disciplina, y especificar límites contractuales para la reutilización de datos. Las inversiones en formación docente e integración curricular deben acompañar cualquier despliegue; las licencias de software sin capacidad humana no cumplirán lo prometido y se arriesgarán a causar daños.

Los reguladores y los financiadores tienen un papel que desempeñar. Las agencias públicas pueden proporcionar marcos de evaluación independientes, financiar estudios piloto que midan tanto las ganancias de aprendizaje como los resultados de equidad, y emitir directrices de contratación que prioricen la privacidad y la transparencia. Sin estos apoyos sistémicos, los distritos seguirán enfrentándose a un poder de negociación asimétrico frente a los grandes proveedores y a un panorama de protecciones desigual.

Lo que está en juego

Las decisiones que se toman ahora en las oficinas de contratación y en las juntas escolares darán forma a la manera en que toda una generación experimenta el aprendizaje. La IA tiene el potencial de amplificar la buena enseñanza y personalizar la instrucción a gran escala, pero también tiene la capacidad de formalizar la discriminación, afianzar la vigilancia y diluir la labor intelectual que las escuelas deben fomentar. La pregunta para los líderes educativos no es si usar la IA, sino cómo hacerlo de manera que proteja los derechos de los estudiantes y fortalezca la pedagogía en lugar de reemplazarla.

A medida que los distritos firman contratos plurianuales, no solo están comprando software; están respaldando una visión de lo que debe ser la escolarización. El camino más seguro es pragmático y centrado en el ser humano: pilotar, medir, exigir transparencia, invertir en las personas y hacer que la equidad sea la restricción predeterminada para cualquier despliegue técnico.

Fuentes

- Center for Democracy & Technology — informe sobre daños y riesgos de la IA en la educación

- American Civil Liberties Union — análisis de la IA y la inequidad

- U.S. Department of Education — informe "Artificial Intelligence and the Future of Teaching and Learning"

- UNESCO — "Guidance for generative AI in education and research"

Comments

No comments yet. Be the first!