Lide: Uma sala de aula e uma encruzilhada

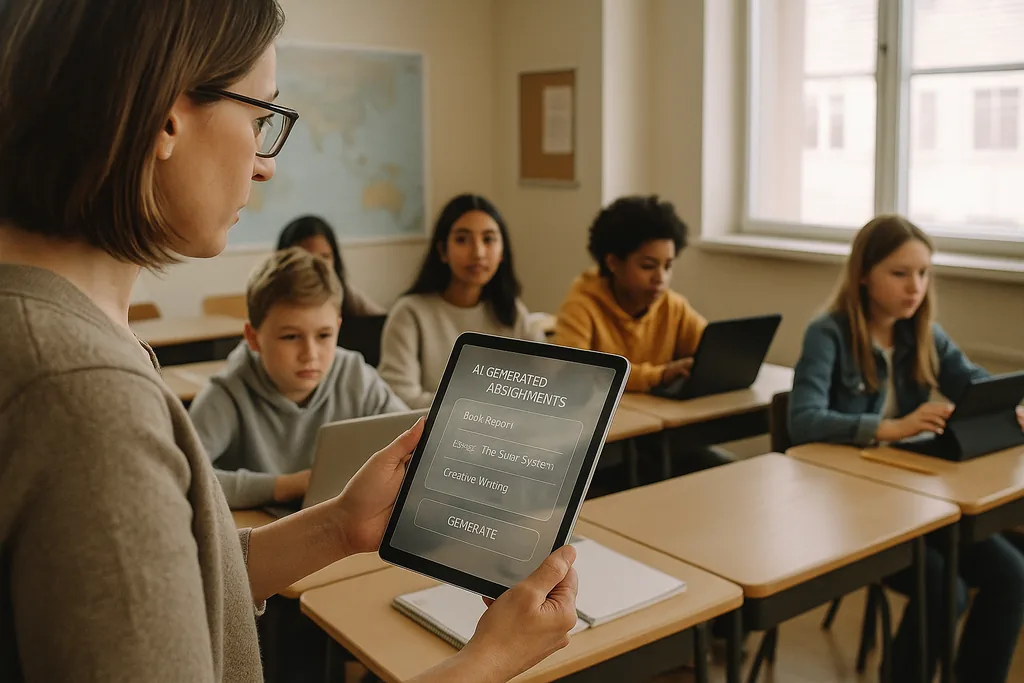

Em uma sala de aula de ensino fundamental bem iluminada nos subúrbios de Ohio, este mês (janeiro de 2026), um professor utiliza uma plataforma de IA que gera exercícios de matemática individualizados para cada aluno. A cena — alardeada pelos fornecedores como uma forma eficiente de reduzir lacunas de aprendizagem e liberar os professores para o ensino em pequenos grupos — está agora no centro de um debate intenso. Em todos os Estados Unidos, distritos repletos de orçamentos de tecnologia pós-pandemia e pressionados pela escassez de professores estão fechando contratos com fornecedores de EdTech; simultaneamente, um coro crescente de educadores, defensores dos direitos civis e agências internacionais argumenta que os custos de se apressar na adoção da IA podem ser muito maiores do que os benefícios.

O problema dos dados: o viés intrínseco às ferramentas de aprendizagem

Quando um algoritmo atribui rotineiramente pontuações mais baixas ou intervenções mais frequentes aos mesmos grupos demográficos, o efeito não é meramente uma falha técnica: torna-se um mecanismo institucional que consolida a desigualdade. Os líderes escolares enfrentam um dilema legal e ético porque as escolhas de aquisição — quais plataformas comprar, quais dados coletar, por quanto tempo retê-los — determinam quais alunos estarão sujeitos a julgamentos automatizados e quais não estarão.

Pedagogia e o problema da "caixa preta"

Além do viés e da privacidade, os professores se preocupam com as consequências educacionais de longo prazo da terceirização do trabalho cognitivo para sistemas opacos. A IA generativa pode produzir um ensaio aceitável ou resolver um problema passo a passo, mas quando os alunos dependem da máquina para gerar ideias, redigir argumentos ou esboçar soluções, o esforço cognitivo deliberado que desenvolve o pensamento crítico pode atrofiar. A aprendizagem não se resume a respostas corretas, mas ao processo de pensar — demonstrar o trabalho, lidar com contra-argumentos, revisar rascunhos — e muitas ferramentas de IA atuais obscurecem esse processo.

Somado a isso, há a natureza de "caixa preta" de muitos modelos. Alunos e professores raramente veem como uma recomendação ou uma nota foi derivada, o que torna difícil transformar um resultado automatizado em um momento instrucional. As orientações educacionais federais têm enfatizado a manutenção de um humano no circuito para decisões consequentes precisamente por este motivo: a responsabilidade, a interpretabilidade e o julgamento profissional do educador permanecem essenciais para uma pedagogia sólida.

Vigilância, consentimento e a confiança abalada

A IA nas escolas frequentemente traz consigo novas formas de vigilância. Softwares de monitoramento de exames, análise de comportamento e telemetria de plataforma criam registros dos rostos, movimentos, padrões de digitação e tempo de dedicação à tarefa dos alunos. Esses registros são valiosos para fornecedores e administradores escolares, mas também sensíveis: quem pode acessá-los, por quanto tempo são armazenados e se são usados para desenvolver novos produtos comerciais são perguntas que muitos distritos ainda não responderam de forma abrangente.

Para famílias e professores, a presença de um monitoramento generalizado pode corroer a confiança. Alunos que sabem que estão sendo observados continuamente tendem a mudar seu comportamento de maneiras que prejudicam a aprendizagem: evitando comportamentos legítimos de distração que podem levar à exploração criativa, ou sentindo ansiedade que prejudica o desempenho. O consentimento é complicado em ambientes de educação básica porque menores nem sempre podem fornecer um acordo totalmente informado, e os pais podem não receber escolhas claras e comparáveis quando os fornecedores são agrupados em contratos de todo o distrito.

Implementações desiguais e um novo fosso digital

Longe de nivelar as oportunidades, a IA pode aprofundar uma divisão existente. Distritos mais ricos conseguem testar produtos robustos, exigir proteções de privacidade em contratos e financiar o desenvolvimento profissional para que os professores possam integrar as ferramentas de forma ponderada. Distritos com poucos recursos podem aceitar serviços gratuitos ou de nível de desconto que vêm com garantias de privacidade mais fracas, menos transparência e treinamento mínimo. O resultado: dois níveis de IA na educação — implementações premium e bem suportadas em algumas escolas, e sistemas mal governados e com pouco suporte em outras.

Essa divisão não apenas amplia as lacunas de desempenho, mas produz modelos educacionais divergentes. Em distritos afluentes, a IA pode servir como assistente para educadores bem treinados; em outros lugares, corre o risco de se tornar um substituto para o investimento em professores e currículos.

Resistência de base e um apelo pela "sanidade digital"

A resistência está se formando em vários níveis. Grupos de professores, coalizões de pais e organizações de direitos civis estão pedindo aos distritos que desacelerem as aquisições, tornem obrigatórios os projetos-piloto e exijam auditorias independentes para danos de viés e privacidade. Muitos defensores não são anti-tecnologia; eles são pró-pedagogia. Sua demanda é por um processo sóbrio e baseado em evidências: testar em pequena escala, medir os resultados de aprendizagem, testar impactos díspares e envolver professores e famílias nas decisões de aquisição.

Da aquisição à responsabilidade: passos concretos

A transição da adoção rápida para o uso responsável exige uma mudança de prioridades. Os distritos devem tratar a aquisição de IA como uma decisão de política pública, em vez de uma compra rotineira de TI. Isso significa pedir aos fornecedores documentação clara sobre fontes de dados e práticas de mitigação de viés, exigir explicabilidade para qualquer decisão que afete a avaliação ou a disciplina e especificar limites contratuais na reutilização de dados. Investimentos em treinamento de professores e integração curricular devem acompanhar qualquer implementação; licenças de software sem capacidade humana entregarão menos do que o prometido e trarão riscos de danos.

Reguladores e financiadores têm papéis a desempenhar. Agências públicas podem fornecer estruturas de avaliação independentes, financiar estudos-piloto que meçam tanto os ganhos de aprendizagem quanto os resultados de equidade e emitir diretrizes de aquisição que priorizem a privacidade e a transparência. Sem esses suportes sistêmicos, os distritos continuarão a enfrentar um poder de negociação assimétrico com grandes fornecedores e um cenário desigual de proteções.

O que está em jogo

As escolhas feitas nos escritórios de compras e conselhos escolares agora moldarão como uma geração inteira vivencia a aprendizagem. A IA tem o potencial de amplificar o bom ensino e personalizar a instrução em escala — mas também tem a capacidade de formalizar a discriminação, consolidar a vigilância e diluir o trabalho intelectual que as escolas devem fomentar. A questão para os líderes educacionais não é se devem usar a IA, mas como fazê-lo de maneiras que protejam os direitos dos alunos e fortaleçam a pedagogia em vez de substituí-la.

À medida que os distritos assinam contratos plurianuais, eles não estão apenas comprando software; eles estão endossando uma visão do que a escolarização deve ser. O caminho mais seguro é pragmático e centrado no ser humano: testar, medir, exigir transparência, investir nas pessoas e tornar a equidade a restrição padrão em qualquer implementação técnica.

Fontes

- Center for Democracy & Technology — relatório sobre danos e riscos da IA na educação

- American Civil Liberties Union — análise sobre IA e desigualdade

- U.S. Department of Education — relatório "Artificial Intelligence and the Future of Teaching and Learning"

- UNESCO — "Guidance for generative AI in education and research"

Comments

No comments yet. Be the first!