导言:课堂与十字路口

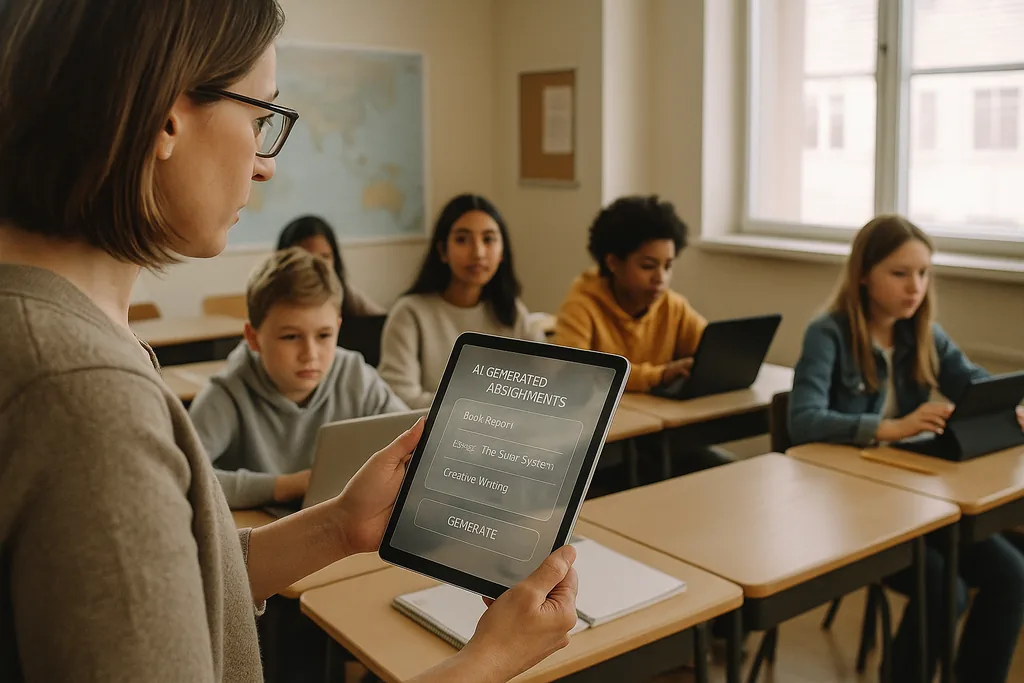

本月(2026年1月),在俄亥俄州郊区一间灯火通明的初中教室里,一位教师正在点击一个AI平台,该平台能为每位学生生成个性化的数学练习。这一场景被供应商吹捧为缩小学习差距、让教师腾出时间进行小组教学的高效方式,而如今它正处于一场激烈辩论的中心。在美国各地,拥有充裕疫情后技术预算并面临教师短缺压力的学区正纷纷与教育科技 (EdTech) 供应商签约;与此同时,越来越多的教育工作者、民权倡导者和国际机构认为,仓促引入AI的代价可能远大于其收益。

数据问题:植入学习工具的偏见

当算法例行公事地给特定人口群体打低分,或者对其实施更频繁的干预时,其后果不仅仅是一个技术缺陷:它变成了一种加剧不平等的体制机制。学校领导面临着法律和伦理困境,因为采购选择——购买哪些平台、收集哪些数据、保留多长时间——决定了哪些学生将接受自动判定,而哪些学生不会。

教学法与“黑箱”问题

除了偏见和隐私,教师们还担心将认知工作外包给不透明系统所带来的长期教育后果。生成式AI可以写出一篇尚可接受的论文,或逐步解决问题,但当学生依赖机器来生成想法、起草论点或列出解决方案时,培养批判性思维所需的刻意认知磨炼可能会萎缩。学习不仅在于正确答案,还在于思考的过程——展示推导过程、与反方观点交锋、修改草稿——而许多目前的AI工具模糊了这一过程。

更糟糕的是许多模型的“黑箱”性质。学生和教师很少能看到建议或评分是如何得出的,这使得将自动化输出转化为教学契机变得困难。美国联邦教育指南强调,在涉及重大决定时应保持“人在回路” (human in the loop),原因正由于此:问责制、可解释性以及教育者的专业判断对于健全的教学法至关重要。

监控、知情同意与受损的信任

学校中的AI往往伴随着新形式的监控。监考软件、行为分析和平台遥测技术记录了学生的面部、动作、打字模式和任务时间。这些记录对供应商和学校管理者很有价值,但也十分敏感:谁可以访问这些记录、存储多久、以及是否用于开发新的商业产品,这些都是许多学区尚未全面回答的问题。

对于家庭和教师来说,无处不在的监控可能会侵蚀信任。知道自己正受到持续观察的学生可能会改变其行为方式,从而损害学习:规避可能带来创造性探索的正当“分心”行为,或者产生损害表现的焦虑感。在K–12环境中,知情同意变得很复杂,因为未成年人并不总能提供充分知情的同意,而且当供应商被捆绑进学区范围的合同时,家长可能没有明确且对等的选择权。

不公平的推广与新的数字鸿沟

AI远未抚平不平等,反而可能加深现有的鸿沟。较富裕的学区能够试点成熟的产品,在合同中要求隐私保护,并资助专业发展,以便教师能深思熟虑地整合工具。资源匮乏的学区可能会接受免费或折扣级别的服务,而这些服务的隐私保证较弱、透明度较低且培训极少。其结果是:教育中的AI出现了两个层级——一些学校拥有优质、支持良好的部署,而另一些学校则是治理不善、支持匮乏的系统。

这种分化不仅扩大了成绩差距,还产生了不同的教育模式。在富裕学区,AI可以作为训练有素的教育者的助手;而在其他地方,它面临着成为教师和课程投资替代品的风险。

草根抵制与“数字理性”的呼吁

多层面的抵制正在形成。教师团体、家长联盟和民权组织正要求学区放慢采购速度,强制进行试点,并要求对偏见和隐私损害进行独立审查。许多倡导者并非反对技术,而是支持教学法。他们的诉求是一个冷静、循证的过程:小规模试点、衡量学习成果、测试差异化影响,并让教师和家庭参与采购决策。

从采购到问责:具体步骤

从快速采用转向负责任的使用需要优先事项的转变。学区应将AI采购视为一项公共政策决策,而非例行的IT采购。这意味着向供应商索取关于数据源和偏见缓解措施的明确文档,要求对影响评分或纪律的任何决定提供可解释性,并在合同中明确规定数据再利用的限制。对教师培训和课程整合的投资必须伴随任何部署;只有软件许可而缺乏人的能力,将导致交付效果不佳并带来风险。

监管机构和出资方也有其作用。公共机构可以提供独立评估框架,资助衡量学习增益和公平结果的试点研究,并发布优先考虑隐私和透明度的采购指南。如果没有这些系统性支持,学区将继续面临与大供应商之间不对称的讨价还价能力,以及不均衡的保护现状。

利害攸关

现在采购办公室和学校董事会做出的选择,将塑造整整一代人的学习体验。AI有潜力放大优质教学并实现大规模的个性化授课——但它也有能力使歧视形式化,巩固监控,并稀释学校理应培养的智力劳动。教育领导者面临的问题不是是否使用AI,而是如何以保护学生权利并加强而非取代教学法的方式来使用它。

当学区签署多年合同时,他们不仅是在购买软件,更是在认可一种关于教育应有样貌的愿景。最安全的路径是务实且以人为本的:试点、评估、要求透明度、投资于人才,并将公平作为任何技术部署的默认约束条件。

来源

- Center for Democracy & Technology —— 关于教育中AI的危害和风险报告

- American Civil Liberties Union —— AI与不平等现象分析

- U.S. Department of Education —— “人工智能与教学和学习的未来”报告

- UNESCO —— “生成式人工智能在教育和研究中的指南”

Comments

No comments yet. Be the first!