Incipit: un'aula e un crocevia

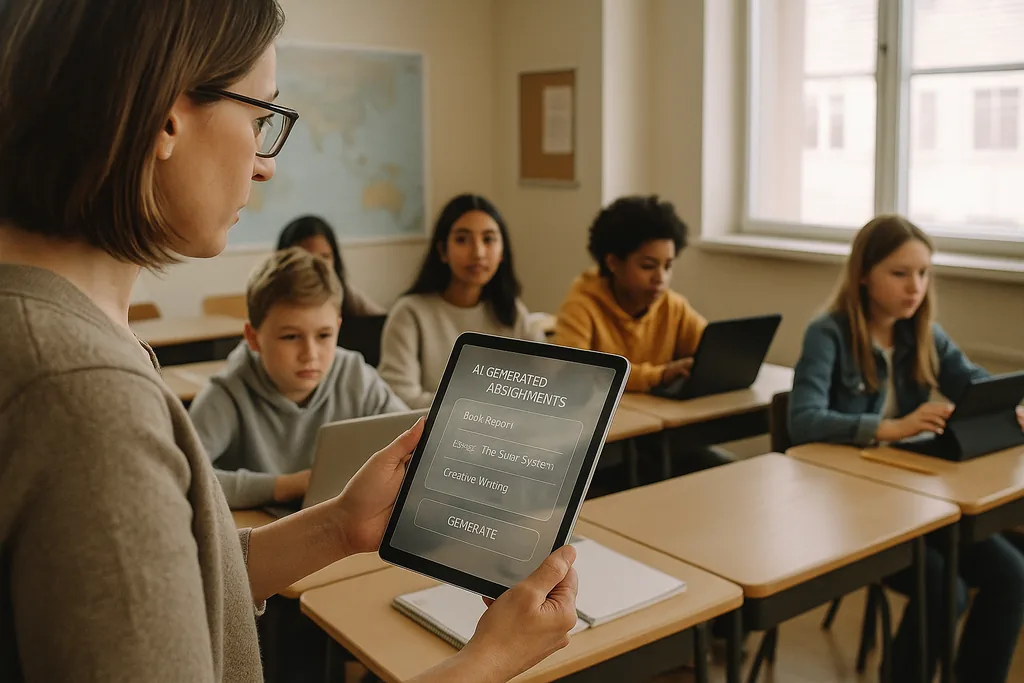

In un'aula di scuola media ben illuminata nella periferia dell'Ohio, questo mese (gennaio 2026), un insegnante scorre una piattaforma di IA che genera esercitazioni di matematica personalizzate per ogni studente. La scena — decantata dai fornitori come un modo efficiente per colmare le lacune nell'apprendimento e liberare gli insegnanti per l'istruzione in piccoli gruppi — si trova ora al centro di un intenso dibattito. In tutti gli Stati Uniti, i distretti carichi di budget tecnologici post-pandemia e messi alle strette dalla carenza di insegnanti stanno stipulando contratti con fornitori di EdTech; contemporaneamente, un coro crescente di educatori, sostenitori dei diritti civili e agenzie internazionali sostiene che i costi di una corsa precipitosa verso l'IA potrebbero essere molto superiori ai benefici.

Il problema dei dati: pregiudizi integrati negli strumenti di apprendimento

Quando un algoritmo assegna regolarmente punteggi più bassi o interventi più frequenti agli stessi gruppi demografici, l'effetto non è un semplice bug tecnico: diventa un meccanismo istituzionale che consolida la disuguaglianza. I dirigenti scolastici affrontano un dilemma legale ed etico perché le scelte di approvvigionamento — quali piattaforme acquistare, quali dati raccogliere, per quanto tempo conservarli — determinano quali studenti saranno soggetti a giudizi automatizzati e quali no.

La pedagogia e il problema della "scatola nera"

Oltre al pregiudizio e alla privacy, gli insegnanti temono le conseguenze educative a lungo termine dell'esternalizzazione del lavoro cognitivo a sistemi opachi. L'IA generativa può produrre un saggio accettabile o risolvere un problema passo dopo passo, ma quando gli studenti si affidano alla macchina per generare idee, bozze di argomentazioni o schemi di soluzioni, lo sforzo cognitivo deliberato che sviluppa il pensiero critico può atrofizzarsi. L'apprendimento non riguarda solo le risposte corrette, ma il processo di pensiero — mostrare il proprio procedimento, lottare con le controargomentazioni, rivedere le bozze — e molti strumenti di IA attuali oscurano tale processo.

Ad aggravare la situazione è la natura da "scatola nera" di molti modelli. Studenti e insegnanti raramente vedono come è stata derivata una raccomandazione o un voto, il che rende difficile trasformare un output automatizzato in un momento didattico. Le linee guida federali sull'istruzione hanno sottolineato l'importanza di mantenere l'intervento umano nel processo per le decisioni rilevanti proprio per questo motivo: responsabilità, interpretabilità e il giudizio professionale dell'educatore rimangono essenziali per una sana pedagogia.

Sorveglianza, consenso e fiducia incrinata

L'IA nelle scuole porta spesso con sé nuove forme di sorveglianza. Software di proctoring, analisi del comportamento e telemetria della piattaforma creano registri dei volti, dei movimenti, dei modelli di digitazione e del tempo dedicato alle attività degli studenti. Tali registri sono preziosi per i fornitori e gli amministratori scolastici, ma sono anche sensibili: chi può accedervi, per quanto tempo vengono conservati e se vengono utilizzati per sviluppare nuovi prodotti commerciali sono domande a cui molti distretti devono ancora rispondere in modo esauriente.

Per le famiglie e gli insegnanti, la presenza di un monitoraggio pervasivo può erodere la fiducia. Gli studenti che sanno di essere costantemente osservati tendono a cambiare il proprio comportamento in modi che danneggiano l'apprendimento: evitando legittimi comportamenti estranei al compito che possono portare all'esplorazione creativa, o provando un'ansia che ne compromette le prestazioni. Il consenso è complicato negli ambiti K-12 perché i minori non possono sempre fornire un accordo pienamente informato e i genitori potrebbero non avere scelte chiare e comparabili quando i fornitori sono inclusi in pacchetti di contratti a livello di distretto.

Implementazioni inique e un nuovo divario digitale

Lungi dal livellare le disparità, l'IA può approfondire un divario esistente. I distretti più ricchi sono in grado di testare prodotti robusti, richiedere protezioni della privacy nei contratti e finanziare lo sviluppo professionale affinché gli insegnanti possano integrare gli strumenti con criterio. I distretti con scarse risorse possono accettare servizi gratuiti o di fascia scontata che offrono garanzie sulla privacy più deboli, meno trasparenza e una formazione minima. Il risultato: due livelli di IA nell'istruzione — implementazioni premium e ben supportate in alcune scuole, e sistemi scarsamente governati e supportati in altre.

Questa scissione non solo amplia i divari di rendimento, ma produce modelli educativi divergenti. Nei distretti abbienti, l'IA può fungere da assistente per educatori ben addestrati; altrove, rischia di diventare un sostituto degli investimenti negli insegnanti e nei programmi di studio.

Resistenza dal basso e appello alla "sanità digitale"

L'opposizione si sta formando a più livelli. Gruppi di insegnanti, coalizioni di genitori e organizzazioni per i diritti civili chiedono ai distretti di rallentare l'approvvigionamento, rendere obbligatori i progetti pilota e richiedere audit indipendenti per i danni alla privacy e i pregiudizi. Molti sostenitori non sono anti-tecnologia; sono pro-pedagogia. La loro richiesta è un processo sobrio e guidato dall'evidenza: sperimentare in piccolo, misurare i risultati dell'apprendimento, testare gli impatti disparati e coinvolgere insegnanti e famiglie nelle decisioni di acquisto.

Dall'approvvigionamento alla responsabilità: passi concreti

Passare da una rapida adozione a un uso responsabile richiede un cambio di priorità. I distretti dovrebbero trattare l'approvvigionamento dell'IA come una decisione di politica pubblica piuttosto che come un comune acquisto IT. Ciò significa chiedere ai fornitori una documentazione chiara sulle fonti dei dati e sulle pratiche di mitigazione dei pregiudizi, richiedere la spiegabilità per qualsiasi decisione che influisca sulla valutazione o sulla disciplina e specificare limiti contrattuali sul riutilizzo dei dati. Gli investimenti nella formazione degli insegnanti e nell'integrazione curricolare devono accompagnare ogni implementazione; le licenze software senza capacità umana produrranno risultati inferiori alle attese e rischieranno di causare danni.

Le autorità di regolamentazione e i finanziatori hanno un ruolo da svolgere. Le agenzie pubbliche possono fornire quadri di valutazione indipendenti, finanziare studi pilota che misurino sia i guadagni di apprendimento che i risultati in termini di equità, ed emanare linee guida per l'approvvigionamento che diano priorità alla privacy e alla trasparenza. Senza questi supporti sistemici, i distretti continueranno ad affrontare un potere contrattuale asimmetrico con i grandi fornitori e un panorama di tutele disomogeneo.

Cosa c'è in gioco

Le scelte fatte oggi negli uffici acquisti e nei consigli scolastici plasmeranno il modo in cui un'intera generazione vivrà l'apprendimento. L'IA ha il potenziale per amplificare il buon insegnamento e personalizzare l'istruzione su vasta scala — ma ha anche la capacità di formalizzare la discriminazione, radicare la sorveglianza e diluire il lavoro intellettuale che le scuole dovrebbero promuovere. La domanda per i leader dell'istruzione non è se usare l'IA, ma come farlo in modi che proteggano i diritti degli studenti e rafforzino la pedagogia invece di sostituirla.

Mentre i distretti firmano contratti pluriennali, non stanno solo acquistando software; stanno sostenendo una visione di ciò che la scuola dovrebbe essere. Il percorso più sicuro è pragmatico e incentrato sull'uomo: sperimentare, misurare, richiedere trasparenza, investire nelle persone e rendere l'equità il vincolo predefinito per ogni implementazione tecnica.

Fonti

- Center for Democracy & Technology — rapporto sui danni e i rischi dell'IA nell'istruzione

- American Civil Liberties Union — analisi sull'IA e l'inequità

- U.S. Department of Education — rapporto "Intelligenza Artificiale e il futuro dell'insegnamento e dell'apprendimento"

- UNESCO — "Guida per l'IA generativa nell'istruzione e nella ricerca"

Comments

No comments yet. Be the first!