Лид: Классная комната на перепутье

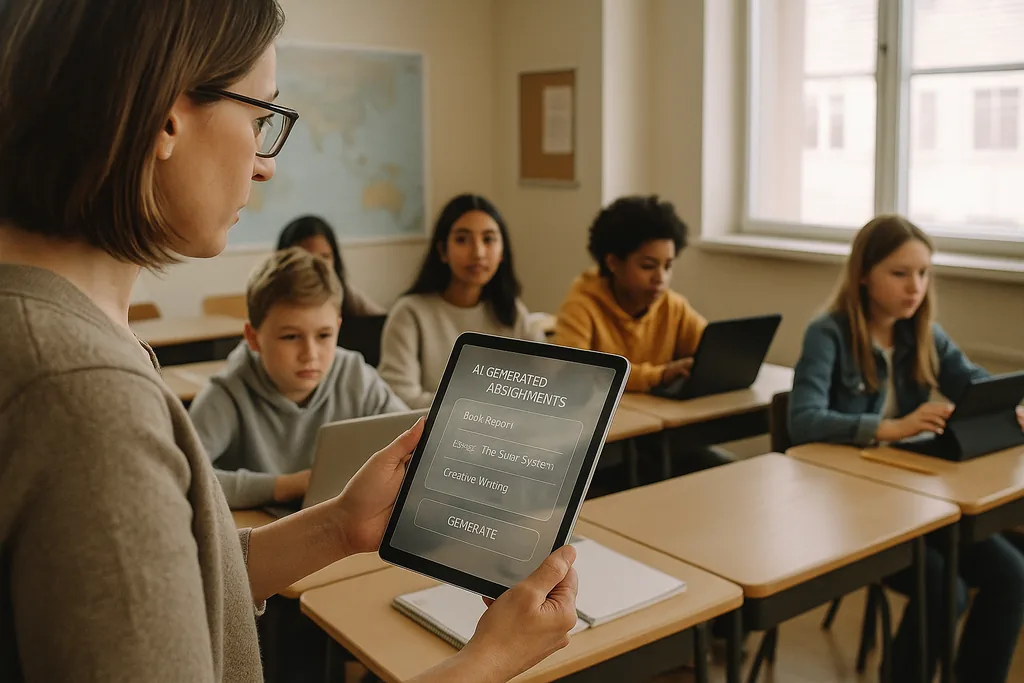

В ярко освещенном классе средней школы в пригороде Огайо в этом месяце (январь 2026 года) учитель просматривает ИИ-платформу, которая генерирует индивидуальные практические задания по математике для каждого ученика. Эта сцена, преподносимая поставщиками как эффективный способ устранения пробелов в знаниях и освобождения учителей для работы в малых группах, сегодня находится в центре острых дискуссий. По всей территории США школьные округа, располагающие значительными бюджетами на технологии после пандемии и испытывающие нехватку учителей, заключают контракты с EdTech-вендорами. Одновременно с этим растет число педагогов, правозащитников и международных организаций, утверждающих, что издержки поспешного внедрения ИИ могут значительно превысить выгоды.

Проблема данных: предвзятость, заложенная в инструменты обучения

Когда алгоритм систематически выставляет более низкие баллы или назначает более частые корректирующие мероприятия одним и тем же демографическим группам, это перестает быть просто технической ошибкой: это становится институциональным механизмом, закрепляющим неравенство. Руководители школ сталкиваются с правовой и этической дилеммой, поскольку решения о закупках — какие платформы покупать, какие данные собирать, как долго их хранить — определяют, какие ученики будут подвергаться автоматизированным суждениям, а какие нет.

Педагогика и проблема «черного ящика»

Помимо вопросов предвзятости и конфиденциальности, учителя обеспокоены долгосрочными образовательными последствиями передачи когнитивной нагрузки непрозрачным системам. Генеративный ИИ может написать сносное эссе или пошагово решить задачу, но когда учащиеся полагаются на машину в генерации идей, составлении аргументов или планировании решений, осознанное когнитивное усилие, развивающее критическое мышление, может атрофироваться. Обучение — это не только правильные ответы, но и сам процесс мышления: обоснование своей работы, борьба с контраргументами, редактирование черновиков — и многие современные инструменты ИИ скрывают этот процесс.

Ситуацию осложняет природа многих моделей, работающих по принципу «черного ящика». Ученики и учителя редко видят, как была получена рекомендация или оценка, что затрудняет превращение автоматизированного результата в учебный момент. Федеральные рекомендации по образованию подчеркивают необходимость участия человека в принятии значимых решений именно по этой причине: подотчетность, интерпретируемость и профессиональное суждение педагога остаются основой качественной педагогики.

Надзор, согласие и подорванное доверие

ИИ в школах часто приносит с собой новые формы надзора. Программное обеспечение для прокторинга, поведенческая аналитика и телеметрия платформ фиксируют лица учеников, их движения, манеру печати и время, затраченное на выполнение заданий. Эти записи ценны для вендоров и школьной администрации, но они также являются конфиденциальными: вопросы о том, кто имеет к ним доступ, как долго они хранятся и используются ли они для разработки новых коммерческих продуктов, во многих округах до сих пор не получили исчерпывающих ответов.

Для семей и учителей повсеместный мониторинг может подорвать доверие. Учащиеся, знающие, что за ними постоянно наблюдают, склонны менять свое поведение таким образом, что это вредит обучению: они избегают естественных отвлечений, которые могут привести к творческому поиску, или испытывают тревогу, снижающую успеваемость. Вопрос согласия в школьной среде К–12 сложен, поскольку несовершеннолетние не всегда могут предоставить полностью осознанное согласие, а родителям не всегда предоставляется четкий и сопоставимый выбор, когда услуги вендоров включены в общеокружные контракты.

Неравномерное внедрение и новый цифровой разрыв

Вместо того чтобы выровнять правила игры, ИИ может углубить существующий разрыв. Более богатые округа могут позволить себе пилотные запуски надежных продуктов, требовать защиты конфиденциальности в контрактах и финансировать профессиональное развитие, чтобы учителя могли грамотно интегрировать инструменты. Округа с недостаточным ресурсом могут соглашаться на бесплатные или дисконтные сервисы, которые сопровождаются более слабыми гарантиями конфиденциальности, меньшей прозрачностью и минимальным обучением. Результат: два уровня ИИ в образовании — премиальное, хорошо поддерживаемое внедрение в одних школах и плохо управляемые, слабо поддерживаемые системы в других.

Этот раскол не только увеличивает разрыв в успеваемости, но и порождает разные образовательные модели. В благополучных округах ИИ может служить помощником для квалифицированных педагогов; в других местах он рискует стать заменой инвестициям в учителей и учебные программы.

Низовое сопротивление и призыв к «цифровому благоразумию»

Противодействие формируется на нескольких уровнях. Профсоюзы учителей, коалиции родителей и правозащитные организации просят округа замедлить закупки, ввести обязательные пилотные проекты и требовать независимого аудита на предмет предвзятости и вреда конфиденциальности. Многие сторонники этой позиции не выступают против технологий; они выступают за педагогику. Их требование заключается в трезвом, основанном на доказательствах процессе: начинать с малых пилотов, измерять результаты обучения, проверять на предмет диспропорционального воздействия и вовлекать учителей и семьи в процесс принятия решений о закупках.

От закупок к подотчетности: конкретные шаги

Переход от стремительного внедрения к ответственному использованию требует смены приоритетов. Округа должны рассматривать закупки ИИ как решение в области государственной политики, а не как рутинную покупку ИТ-услуг. Это означает требование от вендоров четкой документации по источникам данных и методам снижения предвзятости, обеспечение объяснимости любых решений, влияющих на оценки или дисциплинарные взыскания, и установление договорных ограничений на повторное использование данных. Инвестиции в подготовку учителей и интеграцию учебных программ должны сопровождать любое внедрение; лицензии на ПО без участия человеческого потенциала не принесут результата и могут нанести вред.

Регуляторы и спонсоры также должны сыграть свою роль. Государственные органы могут предоставить системы независимой оценки, финансировать пилотные исследования, измеряющие как успехи в учебе, так и показатели равенства, а также издавать руководства по закупкам, приоритетом в которых являются конфиденциальность и прозрачность. Без такой системной поддержки округа по-прежнему будут сталкиваться с асимметричностью переговорных позиций в отношениях с крупными вендорами и неравномерным уровнем защиты.

Что поставлено на карту

Решения, принимаемые сейчас в отделах закупок и школьных советах, сформируют то, как целое поколение будет воспринимать процесс обучения. ИИ обладает потенциалом усилить качественное преподавание и масштабировать персонализированное обучение — но он также способен формализовать дискриминацию, закрепить надзор и обесценить интеллектуальный труд, который школы призваны развивать. Вопрос для руководителей образования заключается не в том, использовать ли ИИ, а в том, как делать это способами, которые защищают права учащихся и укрепляют педагогику, а не заменяют ее.

Подписывая многолетние контракты, округа не просто покупают программное обеспечение; они одобряют определенное видение того, каким должно быть школьное образование. Самый безопасный путь — прагматичный и человекоцентричный: проводить пилотные тесты, измерять результаты, требовать прозрачности, инвестировать в людей и делать равенство обязательным условием любого технологического развертывания.

Источники

- Center for Democracy & Technology — отчет о вреде и рисках ИИ в образовании

- American Civil Liberties Union — анализ ИИ и неравенства

- Министерство образования США — отчет «Искусственный интеллект и будущее преподавания и обучения»

- ЮНЕСКО — «Руководство по генеративному ИИ в образовании и исследованиях»

Comments

No comments yet. Be the first!