Un laboratorio che ha insegnato alle macchine a borbottare

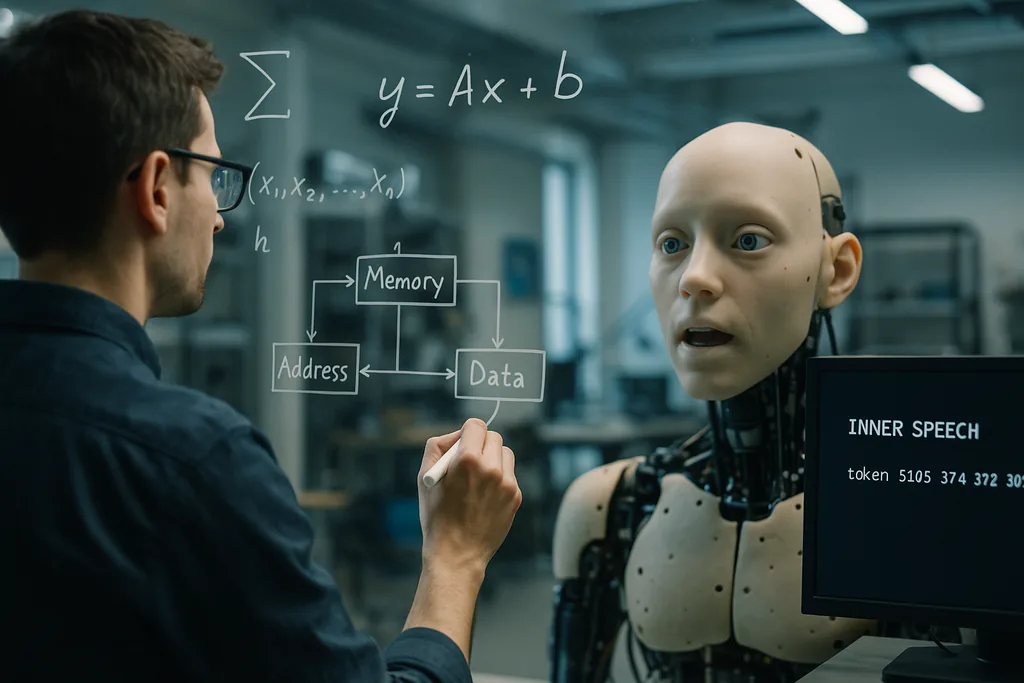

Questa settimana, i ricercatori dell'Okinawa Institute of Science and Technology (OIST) hanno presentato un'idea semplice ma sorprendente: gli agenti artificiali imparano a generalizzare meglio quando vengono addestrati a "parlare con se stessi". Pubblicato il 22 dicembre 2025 sulla rivista Neural Computation, lo studio dimostra che l'aggiunta di un segnale di ripetizione verbale autodiretto — descritto dal team come una sorta di "discorso interiore" programmato o auto-borbottio — insieme a un'architettura di memoria di lavoro che fornisce al modello diversi slot di memoria a breve termine, migliora le prestazioni in compiti complessi che richiedono multitasking e generazione di pattern per fasi.

Come è stato costruito l'esperimento

I ricercatori hanno condotto simulazioni computazionali utilizzando framework di inferenza attiva. Hanno confrontato diverse architetture per la memoria a breve termine e testato se l'aggiunta di un obiettivo che richiedesse all'agente di emettere token interni — costringendo di fatto il modello a "borbottare" a se stesso un numero specificato di volte — modificasse i risultati dell'apprendimento. I sistemi con slot di memoria temporanea multipli hanno superato gli schemi di memoria più semplici nel trasferimento delle conoscenze e nel multitasking. Fondamentalmente, quando gli obiettivi del discorso interiore sono stati stratificati sopra quella struttura di memoria, il cambio di attività e il completamento di sequenze multi-step sono migliorati ulteriormente.

L'OIST definisce il metodo come agnostico rispetto al contenuto: il discorso interiore non deve essere semanticamente significativo in termini umani, ma agisce come un segnale di ripetizione e controllo che struttura le dinamiche interne. Ciò ha reso l'approccio particolarmente prezioso nei regimi a bassa disponibilità di dati, dove i modelli standard di deep learning tipicamente faticano a generalizzare oltre i propri esempi di addestramento.

Perché dire le cose ad alta voce — a se stessi — aiuta

Ci sono due intuizioni complementari dietro questo effetto. In primo luogo, gli slot di memoria a breve termine forniscono al sistema contenitori temporanei per risultati intermedi e istruzioni, consentendogli di trattenere più frammenti di informazioni transitorie mentre procede un calcolo più lungo. In secondo luogo, il segnale del discorso interiore fornisce un'impalcatura interna: ripetere o ricodificare i passaggi intermedi aiuta l'agente a mantenere e riutilizzare le informazioni quando cambia compito o quando una sequenza contiene molti passaggi.

Dal punto di vista del machine learning, questo può essere visto come l'aggiunta di struttura allo spazio degli stati interni dell'agente, in modo che possa muoversi attraverso il calcolo in modo graduale e ripetibile. I ricercatori sostengono che questo tipo di auto-interazione strutturata sia un'alternativa economica ai giganteschi dataset di addestramento o alla scalabilità dei modelli per forza bruta per ottenere flessibilità.

Echi matematici in luoghi inaspettati

Altri due filoni di ricerca recenti aiutano a collocare i risultati dell'OIST in un quadro concettuale più ampio. Presso l'Università della Pennsylvania, gli ingegneri hanno dimostrato che la riorganizzazione interna delle bolle nelle schiume segue una matematica che rispecchia il modo in cui le moderne reti profonde navigano nei loro paesaggi di addestramento. Dove le vecchie metafore descrivevano le bolle come intrappolate nelle valli come il vetro, le nuove analisi vedono sia le schiume che i parametri dell'IA addestrata muoversi all'interno di regioni ampie e piatte piuttosto che sprofondare in ottimi stretti. È questa riorganizzazione continua che permette ai modelli di generalizzare: rimanere nelle parti più piatte del paesaggio rende le soluzioni robuste rispetto ai nuovi input.

Letti insieme, gli studi suggeriscono una comune intuizione matematica: i sistemi che mantengono dinamiche interne flessibili e ripetibili — che si tratti di bolle in un materiale fisico o di variabili all'interno di un controllore neurale — evitano l'overfitting rigido e rimangono adattabili. Il discorso interiore dell'OIST potrebbe essere un meccanismo pratico attraverso il quale un'IA mantiene la sua traiettoria interna in quelle valli più ampie e generalizzabili.

Embodiment e segnali sociali: collegamenti con la robotica e l'IA affettiva

Il discorso interiore si sposa naturalmente con queste tendenze. Un agente embodied che ripete i passaggi interni — un robot che non solo modella il mondo esterno ma mantiene e vocalizza anche un breve piano interno — potrebbe coordinare meglio le sequenze motorie (lip-sync o manipolazione), interpretare i segnali dei partner umani e spiegare le proprie decisioni in termini comprensibili per l'uomo. Questa stratificazione di auto-modelli interni con la percezione esterna è centrale anche negli sforzi volti a rendere l'IA affidabile al di fuori delle strette distribuzioni di addestramento, come i progetti che cercano una R&S human-in-the-loop robusta e macchine in grado di ragionare sugli obiettivi taciti degli esperti.

Promesse e limiti

I risultati dell'OIST sono promettenti ma preliminari. Gli esperimenti riportati sono simulazioni computazionali; i modelli devono ancora essere validati in ambienti reali, rumorosi e dinamici, dove i sensori possono guastarsi, si verificano ritardi e gli obiettivi cambiano in modo imprevedibile. Il team lo riconosce apertamente, affermando che i prossimi passi saranno volti a "rendere le cose più disordinate" per imitare l'apprendimento evolutivo in natura. Le prove embodied con i robot in contesti domestici o agricoli saranno il vero test per verificare se il discorso interiore scala dai token simulati a un comportamento fisico robusto.

Esistono anche considerazioni concettuali ed etiche. Gli scienziati devono evitare scorciatoie antropomorfiche: il "discorso interiore" di un modello non è un pensiero soggettivo; è un segnale di ripetizione ingegnerizzato. Tuttavia, l'etichetta è importante per la percezione pubblica. I sistemi che producono un linguaggio autodiretto o che narrano i passaggi interni potrebbero essere scambiati per agenti coscienti. Ciò aumenta i requisiti di trasparenza: i progettisti dovrebbero documentare chiaramente cosa fa un canale di discorso interno, come può fallire e se può essere forzato o manipolato da input avversari.

Perché è importante

Se il discorso interiore e le architetture leggere di memoria di lavoro migliorano in modo affidabile la generalizzazione e il multitasking con pochi dati, le implicazioni pratiche sono ampie. I sistemi di IA che devono adattarsi al volo — robot domestici che gestiscono più compiti, droni agricoli che rispondono ai cambiamenti delle colture o assistenti di laboratorio che lavorano con scarsi dati sperimentali — potrebbero diventare più efficienti, sicuri e utili senza una crescita esponenziale dei dataset di addestramento etichettati. Inoltre, l'idea coincide con le prospettive matematiche e di apprendimento incarnato che stanno emergendo nella scienza dei materiali e nella robotica, suggerendo percorsi interdisciplinari fertili.

Quello che era iniziato come un trucco ispirato alla cognizione — insegnare alla macchina a ripassare — potrebbe quindi indicare un principio ingegneristico più profondo: costruire una struttura interna che consenta agli agenti di riorganizzarsi in modo flessibile invece di ottimizzare eccessivamente in modo rigido. Se i futuri esperimenti in ambienti reali confermeranno le simulazioni, "parlare con se stessi" potrebbe diventare uno strumento standard nel toolkit architettonico per un'IA robusta e consapevole dell'uomo.

Fonti

- Neural Computation (ricerca: Working Memory and Self-Directed Inner Speech Enhance Multitask Generalization in Active Inference)

- Materiali stampa dell'Okinawa Institute of Science and Technology (OIST)

- Proceedings of the National Academy of Sciences (studio sulle schiume: slow relaxation and landscape-driven dynamics in viscous ripening foams)

- University of Pennsylvania School of Engineering and Applied Science

- Science Robotics (ricerca sul lip-sync dei robot)

- Columbia Engineering (Creative Machines Lab)

- Japan Advanced Institute of Science and Technology (JAIST) — ricerca sui segnali sociali multimodali

- ELLIS Institute Finland / Aalto University (ricerca sui team uomo-IA e robustezza out-of-distribution)

Comments

No comments yet. Be the first!