Een lab dat machines leerde mompelen

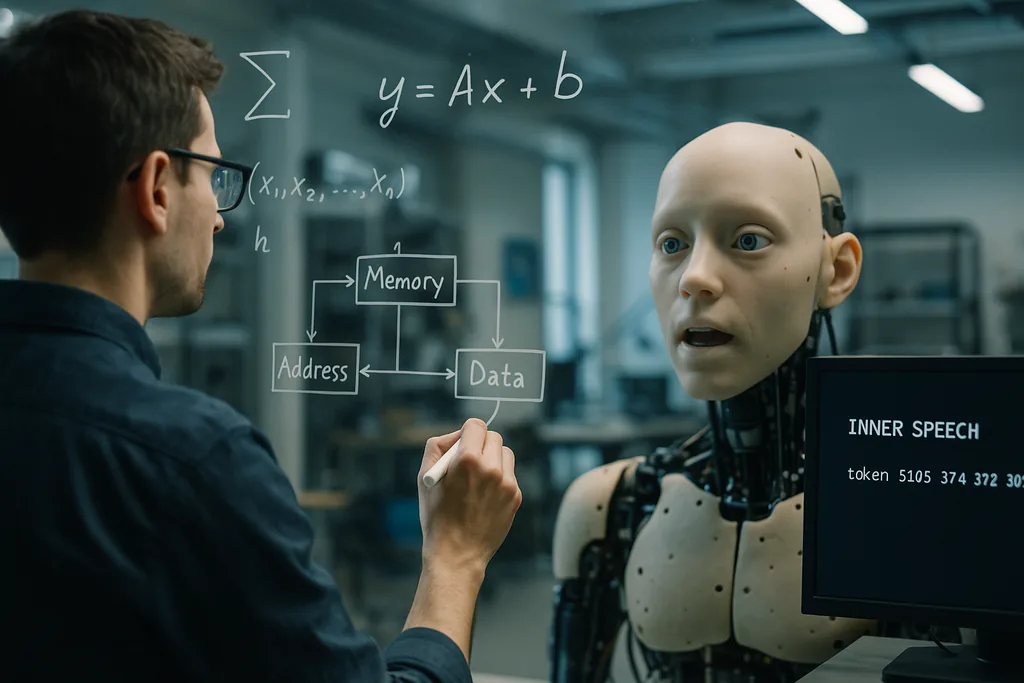

Deze week rapporteerden onderzoekers van het Okinawa Institute of Science and Technology (OIST) een eenvoudig maar opvallend idee: kunstmatige agenten leren beter te generaliseren wanneer ze getraind worden om "tegen zichzelf te praten". De studie, op 22 december 2025 gepubliceerd in het tijdschrift Neural Computation, laat zien dat het toevoegen van een zelfgestuurd verbaal herhalingssignaal — het team beschrijft het als een soort geprogrammeerde "innerlijke spraak" of zelf-mompelen — in combinatie met een werkgeheugenarchitectuur die het model meerdere kortetermijngeheugenslots geeft, de prestaties verbetert bij complexe taken die multitasking en stapsgewijze patroongeneratie vereisen.

Hoe het experiment werd opgezet

De onderzoekers voerden computationele simulaties uit met behulp van active inference-frameworks. Ze vergeleken verschillende architecturen voor het kortetermijngeheugen en testten of het toevoegen van een doel waarbij de agent interne tokens moest uitzenden — wat het model effectief dwingt om een gespecificeerd aantal keren tegen zichzelf te "mompelen" — de leerresultaten veranderde. Systemen met meerdere tijdelijke geheugenslots presteerden beter dan eenvoudigere geheugenschema's bij transfer en multitasking. Cruciaal was dat wanneer de doelen voor innerlijke spraak bovenop die geheugenstructuur werden geplaatst, de taakwisseling en het voltooien van reeksen met meerdere stappen verder verbeterden.

OIST presenteert de methode als inhoudsagnostisch: de innerlijke spraak hoeft in menselijke termen niet semantisch betekenisvol te zijn, maar fungeert als een herhalings- en controlesignaal dat de interne dynamiek structureert. Dat maakte de aanpak bijzonder waardevol in data-arme regimes waar standaard deep-learningmodellen doorgaans moeite hebben om te generaliseren buiten hun trainingsvoorbeelden.

Waarom dingen hardop — tegen jezelf — zeggen helpt

Er zijn twee complementaire intuïties achter dit effect. Ten eerste geven kortetermijngeheugenslots het systeem tijdelijke containers voor tussenresultaten en instructies, waardoor het meerdere stukjes vluchtige informatie kan vasthouden terwijl een langere berekening voortduurt. Ten tweede biedt het signaal van de innerlijke spraak een interne steunstructuur: het herhalen of opnieuw coderen van tussenstappen helpt de lerende entiteit om informatie vast te houden en te hergebruiken bij het wisselen van taken of wanneer een reeks veel stappen bevat.

Vanuit het perspectief van machine learning kan dit worden gezien als het toevoegen van structuur aan de interne toestandsruimte van de agent, zodat deze op een gefaseerde, herhaalbare manier door de berekening kan bewegen. De onderzoekers stellen dat dit soort gestructureerde zelfinteractie een goedkoop alternatief is voor gigantische trainingsdatasets of brute-force modelvergroting om flexibiliteit te bereiken.

Wiskundige echo's op onverwachte plekken

Twee andere recente onderzoekstrajecten helpen de resultaten van OIST in een breder conceptueel kader te plaatsen. Aan de University of Pennsylvania lieten ingenieurs zien dat de interne reorganisatie van bellen in schuim een wiskunde volgt die weerspiegelt hoe moderne diepe netwerken door hun trainingslandschappen navigeren. Waar oudere metaforen bellen behandelden alsof ze vast kwamen te zitten in valleien zoals glas, zien nieuwe analyses zowel schuimen als getrainde AI-parameters door brede, vlakke regio's dwalen in plaats van weg te zinken in smalle optima. Die voortdurende reorganisatie is wat modellen laat generaliseren: het verblijven in vlakkere delen van het landschap maakt oplossingen robuust tegen nieuwe inputs.

Samen gelezen suggereren de studies een gemeenschappelijke wiskundige intuïtie: systemen die een flexibele, herhaalbare interne dynamiek behouden — of het nu gaat om bellen in een fysiek materiaal of variabelen in een neurale controller — vermijden brosse overfitting en blijven aanpasbaar. De innerlijke spraak van OIST zou een praktisch mechanisme kunnen zijn waarmee een AI zijn interne traject in die bredere, generaliseerbare valleien houdt.

Belichaming en sociale signalen: verbanden met robotica en affectieve AI

Innerlijke spraak sluit op natuurlijke wijze aan bij deze trends. Een belichaamde agent die interne stappen repeteert — een robot die niet alleen de buitenwereld modelleert, maar ook een kort intern plan bijhoudt en uitspreekt — zou motorische sequenties (zoals lippensynchronisatie of manipulatie) beter kunnen coördineren, aanwijzingen van menselijke partners beter kunnen interpreteren en zijn eigen beslissingen in mensvriendelijke termen kunnen uitleggen. Dat gelaagd aanbrengen van interne zelfmodellen met externe perceptie staat ook centraal in pogingen om AI betrouwbaar te maken buiten nauwe trainingsdistributies, zoals projecten die streven naar robuuste human-in-the-loop R&D en machines die redeneren over de stilzwijgende doelstellingen van experts.

Beloften en beperkingen

De resultaten van OIST zijn veelbelovend maar voorlopig. De gerapporteerde experimenten zijn computationele simulaties; modellen moeten nog worden gevalideerd in rumoerige, dynamische omgevingen in de echte wereld waar sensoren falen, vertragingen optreden en doelen onvoorspelbaar veranderen. Het team erkent dit openlijk en stelt dat hun volgende stappen de zaken "rommeliger zullen maken" om ontwikkelingsgericht leren in de praktijk na te bootsen. Proeven met belichaamde robots in huishoudelijke of agrarische omgevingen zullen de echte test vormen of innerlijke spraak schaalbaar is van gesimuleerde tokens naar robuust fysiek gedrag.

Er zijn ook conceptuele en ethische overwegingen. Wetenschappers moeten antropomorfe terminologie vermijden: de "innerlijke spraak" van een model is geen subjectieve gedachte; het is een technisch ontworpen herhalingssignaal. Toch doet het label ertoe voor de publieke perceptie. Systemen die zelfgestuurde taal produceren of interne stappen vertellen, zouden kunnen worden aangezien voor bewuste agenten. Dat stelt eisen aan transparantie: ontwerpers moeten duidelijk documenteren wat een intern spraakkanaal doet, hoe het kan falen en of het kan worden beïnvloed of gemanipuleerd door adversariële inputs.

Waarom het belangrijk is

Als innerlijke spraak en lichtgewicht werkgeheugenarchitecturen de generalisatie en multitasking betrouwbaar verbeteren met bescheiden hoeveelheden data, zijn de praktische implicaties breed. AI-systemen die zich gaandeweg moeten aanpassen — huishoudrobots die taken combineren, landbouwdrones die reageren op veranderende gewassen, of laboratoriumassistenten die werken met schaarse experimentele data — zouden efficiënter, veiliger en nuttiger kunnen worden zonder een exponentiële groei van gelabelde trainingssets. Bovendien sluit het idee aan bij wiskundige en belichaamde leerperspectieven die nu opduiken in de materiaalkunde en robotica, wat wijst op vruchtbare interdisciplinaire paden.

Wat begon als een op cognitie geïnspireerde truc — leer de machine herhalen — zou daarom kunnen wijzen op een dieper technisch principe: bouw een interne structuur waarmee agenten zich flexibel kunnen reorganiseren in plaats van rigide te overoptimaliseren. Als toekomstige experimenten in echte omgevingen de simulaties bevestigen, kan "tegen jezelf praten" een standaardhulpmiddel worden in de architectonische gereedschapskist voor robuuste, mensbewuste AI.

Bronnen

- Neural Computation (onderzoekspaper: Working Memory and Self-Directed Inner Speech Enhance Multitask Generalization in Active Inference)

- Okinawa Institute of Science and Technology (OIST) persmateriaal

- Proceedings of the National Academy of Sciences (schuimstudie over langzame relaxatie en landschapsgestuurde dynamiek in viskeuze rijpende schuimen)

- University of Pennsylvania School of Engineering and Applied Science

- Science Robotics (onderzoek naar lippensynchronisatie bij robots)

- Columbia Engineering (Creative Machines Lab)

- Japan Advanced Institute of Science and Technology (JAIST) — multimodaal onderzoek naar sociale signalen

- ELLIS Institute Finland / Aalto University (onderzoek naar mens-AI-teams en robuustheid buiten de distributie)

Comments

No comments yet. Be the first!