Ein Labor, das Maschinen das Murmeln beibrachte

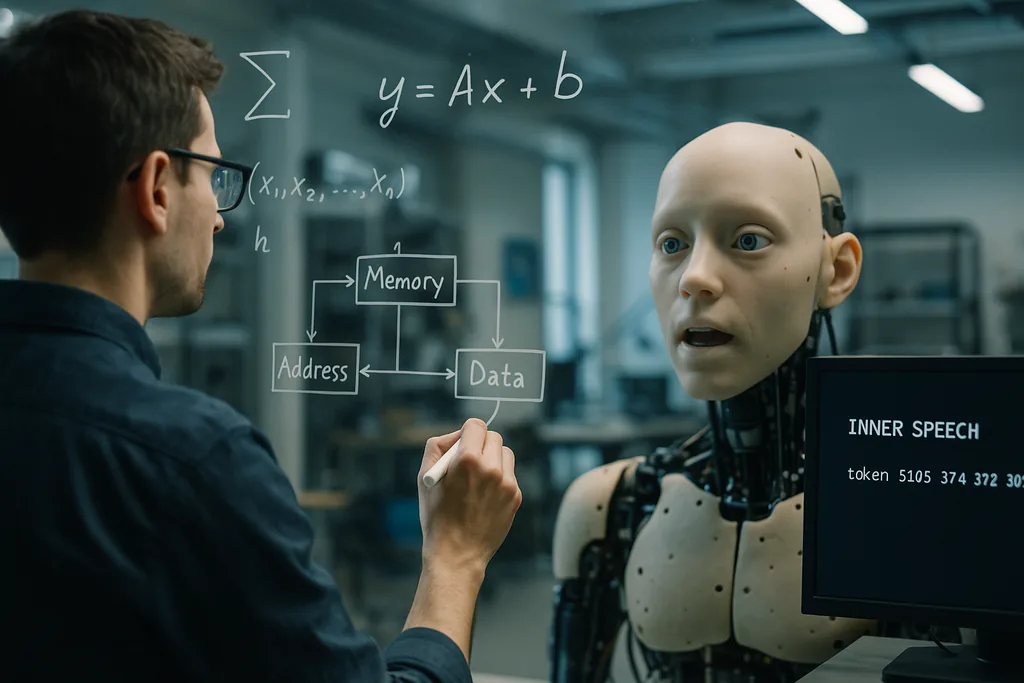

Diese Woche berichteten Forscher des Okinawa Institute of Science and Technology (OIST) über eine einfache, aber verblüffende Idee: Künstliche Agenten lernen besser zu generalisieren, wenn sie darauf trainiert werden, „mit sich selbst zu sprechen“. Die am 22. Dezember 2025 in der Fachzeitschrift Neural Computation veröffentlichte Studie zeigt, dass das Hinzufügen eines selbstgesteuerten verbalen Wiederholungssignals – das Team beschreibt es als eine Art programmierte „innere Sprache“ oder „Selbstmurmeln“ – zusammen mit einer Arbeitsgedächtnis-Architektur, die dem Modell mehrere Kurzzeitgedächtnis-Slots gibt, die Leistung bei schwierigen Aufgaben verbessert, die Multitasking und schrittweise Mustergenerierung erfordern.

Wie das Experiment aufgebaut war

Die Forscher führten Computersimulationen unter Verwendung von Active-Inference-Frameworks durch. Sie verglichen verschiedene Architekturen für das Kurzzeitgedächtnis und testeten, ob das Hinzufügen eines Ziels, das den Agenten zur Ausgabe interner Token aufforderte – was das Modell effektiv dazu zwang, eine festgelegte Anzahl von Malen vor sich hin zu „murmeln“ –, die Lernergebnisse veränderte. Systeme mit mehreren temporären Speicherplätzen übertrafen einfachere Gedächtnisschemata bei Transferleistungen und Multitasking. Entscheidend war, dass sich das Aufgaben-Switching und die Vervollständigung mehrstufiger Sequenzen weiter verbesserten, wenn diese Gedächtnisstruktur mit Zielen für die innere Sprache kombiniert wurde.

Das OIST beschreibt die Methode als inhaltsagnostisch: Die innere Sprache muss im menschlichen Sinne nicht semantisch bedeutungsvoll sein, sondern fungiert als Wiederholungs- und Steuersignal, das die interne Dynamik strukturiert. Dies machte den Ansatz besonders wertvoll in Szenarien mit geringer Datenmenge (Low-Data-Regime), in denen standardmäßige Deep-Learning-Modelle normalerweise Schwierigkeiten haben, über ihre Trainingsbeispiele hinaus zu generalisieren.

Warum es hilft, Dinge laut auszusprechen – zu sich selbst

Hinter diesem Effekt stehen zwei komplementäre Intuitionen. Erstens bieten Kurzzeitgedächtnis-Slots dem System temporäre Container für Zwischenergebnisse und Anweisungen, sodass es mehrere flüchtige Informationen halten kann, während eine längere Berechnung fortschreitet. Zweitens bietet das Signal der inneren Sprache ein internes Gerüst: Das Wiederholen oder Neu-Kodieren von Zwischenschritten hilft dem Lernenden, Informationen beizubehalten und wiederzuverwenden, wenn Aufgaben gewechselt werden oder wenn eine Sequenz viele Schritte umfasst.

Aus der Perspektive des maschinellen Lernens kann dies als Hinzufügen von Struktur zum internen Zustandsraum des Agenten betrachtet werden, sodass er sich auf eine gestufte, reproduzierbare Weise durch die Berechnungen bewegen kann. Die Forscher argumentieren, dass diese Art der strukturierten Selbstinteraktion eine kostengünstige Alternative zu riesigen Trainingsdatensätzen oder der Brute-Force-Skalierung von Modellen darstellt, um Flexibilität zu erreichen.

Mathematische Echos an unerwarteten Orten

Zwei weitere aktuelle Forschungsstränge helfen dabei, die Ergebnisse des OIST in einen breiteren konzeptionellen Rahmen einzuordnen. An der University of Pennsylvania zeigten Ingenieure, dass die interne Reorganisation von Blasen in Schäumen einer Mathematik folgt, die widerspiegelt, wie moderne tiefe Netzwerke durch ihre Trainingslandschaften navigieren. Während ältere Metaphern Blasen so behandelten, als würden sie wie Glas in Tälern gefangen werden, sehen neue Analysen sowohl Schäume als auch trainierte KI-Parameter in breiten, flachen Regionen mäandern, anstatt in engen Optima zu versinken. Diese kontinuierliche Reorganisation ermöglicht es Modellen zu generalisieren: Das Verbleiben in flacheren Teilen der Landschaft macht Lösungen robust gegenüber neuen Eingaben.

Zusammengenommen legen die Studien eine gemeinsame mathematische Intuition nahe: Systeme, die flexible, wiederholbare interne Dynamiken aufrechterhalten – seien es Blasen in einem physikalischen Material oder Variablen innerhalb einer neuronalen Steuerung –, vermeiden anfälliges Overfitting und bleiben anpassungsfähig. Die innere Sprache des OIST könnte ein praktischer Mechanismus sein, mit dem eine KI ihre interne Trajektorie in diesen breiteren, generalisierbaren Tälern hält.

Embodiment und soziale Signale: Verbindungen zu Robotik und affektiver KI

Die innere Sprache fügt sich natürlich in diese Trends ein. Ein verkörperter Agent (Embodied Agent), der interne Schritte wiederholt – ein Roboter, der nicht nur die Außenwelt modelliert, sondern auch einen kurzen internen Plan aufrechterhält und vokalisiert –, könnte Bewegungssequenzen (Lippensynchronisation oder Manipulation) besser koordinieren, Signale menschlicher Partner interpretieren und seine eigenen Entscheidungen in menschenfreundlichen Begriffen erklären. Diese Schichtung interner Selbstmodelle mit externer Wahrnehmung ist auch zentral für Bemühungen, KI außerhalb enger Trainingsverteilungen zuverlässig zu machen, wie etwa Projekte, die eine robuste Human-in-the-Loop-F&E und Maschinen anstreben, die über die impliziten Ziele von Experten reflektieren.

Versprechen und Grenzen

Die OIST-Ergebnisse sind vielversprechend, aber vorläufig. Die berichteten Experimente sind Computersimulationen; Modelle müssen noch in verrauschten, dynamischen realen Umgebungen validiert werden, in denen Sensoren ausfallen, Verzögerungen auftreten und sich Ziele unvorhersehbar ändern. Das Team erkennt dies offen an und erklärt, dass ihre nächsten Schritte „die Dinge unordentlicher machen“ werden, um das Entwicklungslernen unter realen Bedingungen nachzuahmen. Verkörperte Versuche mit Robotern in Haushalts- oder Agrarumgebungen werden der eigentliche Test dafür sein, ob die innere Sprache von simulierten Token auf robustes physisches Verhalten skalierbar ist.

Es gibt auch konzeptionelle und ethische Überlegungen. Wissenschaftler müssen anthropomorphe Abkürzungen vermeiden: Die „innere Sprache“ eines Modells ist kein subjektives Denken, sondern ein technisch entwickeltes Wiederholungssignal. Dennoch ist die Bezeichnung für die öffentliche Wahrnehmung von Bedeutung. Systeme, die selbstgesteuerte Sprache erzeugen oder interne Schritte kommentieren, könnten fälschlicherweise für bewusste Agenten gehalten werden. Dies erhöht die Anforderungen an die Transparenz: Entwickler sollten klar dokumentieren, was ein interner Sprachkanal tut, wie er versagen kann und ob er durch adversarielle Eingaben manipuliert werden kann.

Warum es wichtig ist

Wenn innere Sprache und leichtgewichtige Arbeitsgedächtnis-Architekturen die Generalisierung und das Multitasking bei bescheidenen Datenmengen zuverlässig verbessern, sind die praktischen Auswirkungen weitreichend. KI-Systeme, die sich spontan anpassen müssen – Haushaltsroboter, die zwischen Aufgaben jonglieren, Agrardrohnen, die auf wechselnde Erntebedingungen reagieren, oder Laborassistenten, die mit spärlichen experimentellen Daten arbeiten –, könnten effizienter, sicherer und nützlicher werden, ohne dass ein exponentielles Wachstum markierter Trainingsdatensätze erforderlich ist. Darüber hinaus deckt sich die Idee mit mathematischen und verkörperten Lernperspektiven, die derzeit in den Materialwissenschaften und der Robotik entstehen, was auf fruchtbare interdisziplinäre Wege hindeutet.

Was als kognitiv inspirierter Trick begann – der Maschine das Wiederholen beizubringen –, könnte daher auf ein tieferes technisches Prinzip hindeuten: den Aufbau interner Strukturen, die es Agenten ermöglichen, sich flexibel zu reorganisieren, anstatt starr zu überoptimieren. Wenn zukünftige Experimente in realen Umgebungen die Simulationen bestätigen, könnte das „Gespräch mit sich selbst“ zu einem Standardwerkzeug im Architektur-Baukasten für eine robuste, menschenorientierte KI werden.

Quellen

- Neural Computation (research paper: Working Memory and Self-Directed Inner Speech Enhance Multitask Generalization in Active Inference)

- Okinawa Institute of Science and Technology (OIST) Pressematerialien

- Proceedings of the National Academy of Sciences (Schaumstudie über langsame Relaxation und landschaftsgesteuerte Dynamik in viskosen Reifungsschäumen)

- University of Pennsylvania School of Engineering and Applied Science

- Science Robotics (Forschung zur Lippensynchronisation bei Robotern)

- Columbia Engineering (Creative Machines Lab)

- Japan Advanced Institute of Science and Technology (JAIST) – Forschung zu multimodalen sozialen Signalen

- ELLIS Institute Finland / Aalto University (Forschung zu Mensch-KI-Teams und Robustheit außerhalb der Verteilung)

Kommentare

Noch keine Kommentare. Seien Sie der Erste!