Um laboratório que ensinou máquinas a murmurar

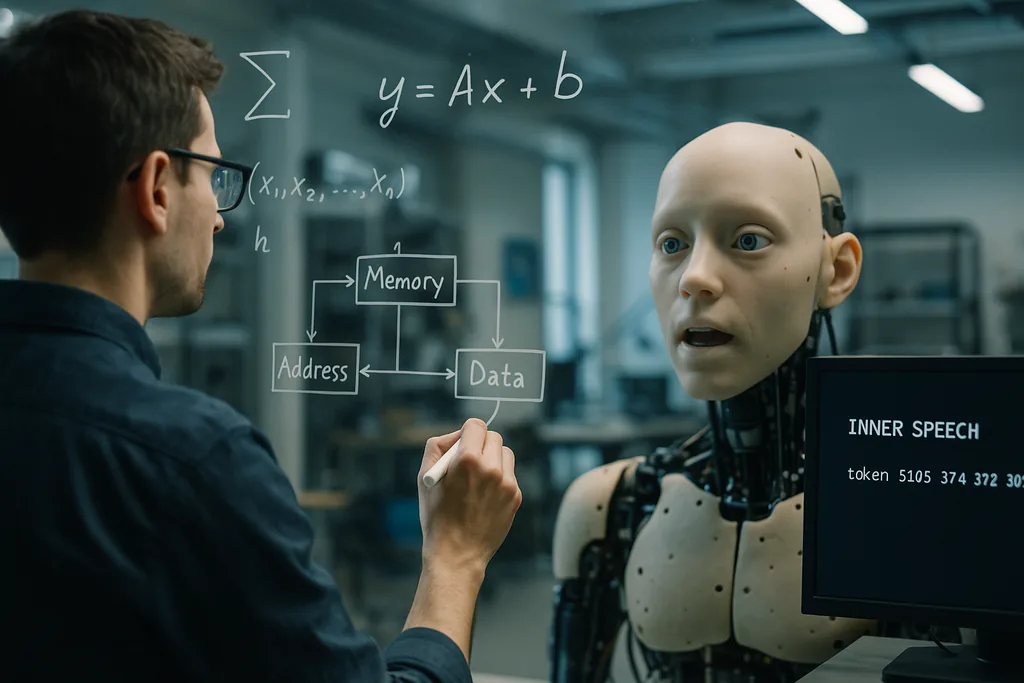

Esta semana, pesquisadores do Okinawa Institute of Science and Technology (OIST) relataram uma ideia simples, mas impressionante: agentes artificiais aprendem a generalizar melhor quando são treinados para "falar consigo mesmos". Publicado em 22 de dezembro de 2025 na revista Neural Computation, o estudo mostra que a adição de um sinal de ensaio verbal autodirigido — a equipe o descreve como um tipo de "discurso interno" programado ou auto-murmúrio — juntamente com uma arquitetura de memória de trabalho que fornece ao modelo múltiplos espaços de memória de curto prazo, melhora o desempenho em tarefas difíceis que exigem multitarefa e geração de padrões passo a passo.

Como o experimento foi construído

Os pesquisadores realizaram simulações computacionais usando frameworks de inferência ativa. Eles compararam diversas arquiteturas de memória de curto prazo e testaram se a adição de um objetivo que exigisse que o agente emitisse tokens internos — efetivamente forçando o modelo a "murmurar" para si mesmo um número especificado de vezes — alterava os resultados da aprendizagem. Sistemas com múltiplos espaços de memória temporária superaram esquemas de memória mais simples em transferência e multitarefa. Crucialmente, quando os alvos de discurso interno foram sobrepostos a essa estrutura de memória, a alternância de tarefas e a conclusão de sequências de múltiplas etapas melhoraram ainda mais.

O OIST enquadra o método como agnóstico em relação ao conteúdo: o discurso interno não precisa ser semanticamente significativo em termos humanos, mas atua como um sinal de ensaio e controle que estrutura a dinâmica interna. Isso tornou a abordagem particularmente valiosa em regimes de poucos dados, onde modelos padrão de deep learning normalmente têm dificuldade para generalizar além de seus exemplos de treinamento.

Por que dizer as coisas em voz alta — para si mesmo — ajuda

Existem duas intuições complementares por trás do efeito. Primeiro, os espaços de memória de curto prazo oferecem ao sistema recipientes temporários para resultados intermediários e instruções, permitindo que ele retenha múltiplas informações transitórias enquanto um cálculo mais longo prossegue. Segundo, o sinal de discurso interno fornece um andaime interno: ensaiar ou recodificar etapas intermediárias ajuda o aprendiz a manter e reutilizar informações ao trocar de tarefas ou quando uma sequência contém muitas etapas.

Do ponto de vista do aprendizado de máquina, isso pode ser visto como a adição de estrutura ao espaço de estados interno do agente, para que ele possa se mover através do cálculo de uma forma faseada e repetível. Os pesquisadores argumentam que esse tipo de auto-interação estruturada é uma alternativa barata a conjuntos de dados de treinamento gigantescos ou ao dimensionamento de modelos por força bruta para alcançar flexibilidade.

Ecos matemáticos em lugares inesperados

Outras duas linhas de pesquisa recentes ajudam a situar os resultados do OIST em um quadro conceitual mais amplo. Na University of Pennsylvania, engenheiros mostraram que a reorganização interna de bolhas em espumas segue uma matemática que reflete como as redes profundas modernas navegam em suas paisagens de treinamento. Enquanto metáforas mais antigas tratavam as bolhas como se estivessem presas em vales como o vidro, novas análises veem tanto as espumas quanto os parâmetros de IA treinados vagando dentro de regiões amplas e planas, em vez de afundarem em ótimos estreitos. Essa reorganização contínua é o que permite que os modelos generalizem: permanecer em partes mais planas da paisagem torna as soluções robustas a novas entradas.

Lidos em conjunto, os estudos sugerem uma intuição matemática comum: sistemas que mantêm dinâmicas internas flexíveis e ensaiáveis — sejam bolhas em um material físico ou variáveis dentro de um controlador neural — evitam o overfitting frágil e permanecem adaptáveis. O discurso interno do OIST poderia ser um mecanismo prático pelo qual uma IA mantém sua trajetória interna nesses vales mais amplos e generalizáveis.

Corporificação e sinais sociais: ligações com a robótica e a IA afetiva

O discurso interno se encaixa naturalmente com essas tendências. Um agente corporificado que ensaia etapas internas — um robô que não apenas modela o mundo externo, mas também mantém e vocaliza um plano interno curto — poderia coordenar melhor sequências motoras (sincronia labial ou manipulação), interpretar pistas de parceiros humanos e explicar suas próprias decisões em termos compreensíveis para humanos. Essa estratificação de auto-modelos internos com percepção externa também é central para os esforços que visam tornar a IA confiável fora de distribuições de treinamento estreitas, como projetos que buscam P&D robusto com humanos no circuito (human-in-the-loop) e máquinas que raciocinam sobre os objetivos tácitos de especialistas.

Promessas e limites

Os resultados do OIST são promissores, mas preliminares. Os experimentos relatados são simulações computacionais; os modelos ainda precisam ser validados em ambientes ruidosos, dinâmicos e do mundo real, onde sensores falham, ocorrem atrasos e os objetivos mudam de forma imprevisível. A equipe reconhece isso abertamente, afirmando que seus próximos passos serão "tornar as coisas mais confusas" para imitar a aprendizagem de desenvolvimento na prática. Testes corporificados com robôs em ambientes domésticos ou agrícolas serão o verdadeiro teste para saber se o discurso interno escala de tokens simulados para um comportamento físico robusto.

Há também considerações conceituais e éticas. Os cientistas devem evitar atalhos antropomórficos: o "discurso interno" de um modelo não é um pensamento subjetivo; é um sinal de ensaio de engenharia. Ainda assim, o rótulo importa para a percepção pública. Sistemas que produzem linguagem autodirigida ou que narram etapas internas podem ser confundidos com agentes conscientes. Isso aumenta os requisitos de transparência: os projetistas devem documentar claramente o que um canal de discurso interno faz, como ele pode falhar e se pode ser coagido ou manipulado por entradas adversárias.

Por que isso é importante

Se o discurso interno e arquiteturas leves de memória de trabalho melhorarem de forma confiável a generalização e a multitarefa com dados modestos, as implicações práticas são amplas. Sistemas de IA que precisam se adaptar rapidamente — robôs domésticos equilibrando tarefas, drones agrícolas respondendo a mudanças nas plantações ou assistentes de laboratório trabalhando com dados experimentais escassos — poderiam se tornar mais eficientes, seguros e úteis sem o crescimento exponencial de conjuntos de treinamento rotulados. Além disso, a ideia se alinha com perspectivas matemáticas e de aprendizagem corporificada que surgem agora na ciência dos materiais e na robótica, sugerindo caminhos interdisciplinares férteis.

O que começou como um truque inspirado na cognição — ensinar a máquina a ensaiar — pode, portanto, apontar para um princípio de engenharia mais profundo: construir uma estrutura interna que permita aos agentes se reorganizarem de forma flexível em vez de se otimizarem excessivamente de forma rígida. Se experimentos futuros em ambientes reais confirmarem as simulações, "falar consigo mesmo" pode se tornar uma ferramenta padrão no kit de arquitetura para uma IA robusta e consciente do ser humano.

Fontes

- Neural Computation (artigo de pesquisa: Working Memory and Self-Directed Inner Speech Enhance Multitask Generalization in Active Inference)

- Materiais de imprensa do Okinawa Institute of Science and Technology (OIST)

- Proceedings of the National Academy of Sciences (estudo de espuma sobre relaxamento lento e dinâmica impulsionada pela paisagem em espumas de amadurecimento viscoso)

- University of Pennsylvania School of Engineering and Applied Science

- Science Robotics (pesquisa sobre sincronia labial de robôs)

- Columbia Engineering (Creative Machines Lab)

- Japan Advanced Institute of Science and Technology (JAIST) — pesquisa de sinais sociais multimodais

- ELLIS Institute Finland / Aalto University (pesquisa sobre equipes humano-IA e robustez fora da distribuição)

Comments

No comments yet. Be the first!