Un laboratorio que enseñó a las máquinas a mascullar

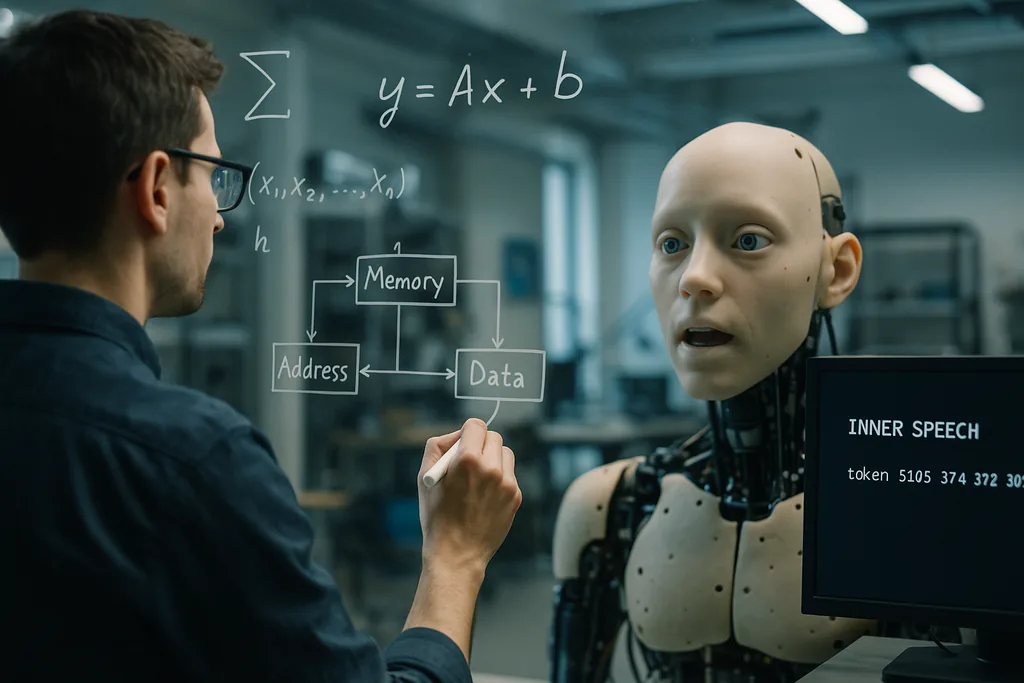

Esta semana, investigadores del Okinawa Institute of Science and Technology (OIST) informaron sobre una idea sencilla pero sorprendente: los agentes artificiales aprenden a generalizar mejor cuando se les entrena para "hablar consigo mismos". El estudio, publicado el 22 de diciembre de 2025 en la revista Neural Computation, muestra que añadir una señal de ensayo verbal autodirigida —el equipo la describe como una especie de "habla interna" programada o automurmullos— junto con una arquitectura de memoria de trabajo que dota al modelo de múltiples ranuras de memoria a corto plazo, mejora el rendimiento en tareas difíciles que requieren multitarea y generación de patrones paso a paso.

Cómo se construyó el experimento

Los investigadores realizaron simulaciones computacionales utilizando marcos de inferencia activa. Compararon varias arquitecturas de memoria a corto plazo y probaron si añadir un objetivo que exigiera al agente emitir tokens internos —obligando efectivamente al modelo a "mascullar" para sí mismo un número determinado de veces— cambiaba los resultados del aprendizaje. Los sistemas con múltiples ranuras de memoria temporal superaron a los esquemas de memoria más sencillos en transferencia y multitarea. Crucialmente, cuando se superpusieron los objetivos de habla interna sobre esa estructura de memoria, el cambio de tareas y la finalización de secuencias de varios pasos mejoraron aún más.

El OIST define el método como agnóstico respecto al contenido: el habla interna no necesita tener un significado semántico en términos humanos, sino que actúa como una señal de ensayo y control que estructura la dinámica interna. Esto hizo que el enfoque fuera especialmente valioso en regímenes de pocos datos, donde los modelos estándar de aprendizaje profundo suelen tener dificultades para generalizar más allá de sus ejemplos de entrenamiento.

Por qué decir las cosas en voz alta —a uno mismo— ayuda

Existen dos intuiciones complementarias tras este efecto. En primer lugar, las ranuras de memoria a corto plazo proporcionan al sistema contenedores temporales para resultados e instrucciones intermedias, permitiéndole retener múltiples piezas de información transitoria mientras se desarrolla un cálculo más largo. En segundo lugar, la señal de habla interna proporciona un andamiaje interno: ensayar o volver a codificar los pasos intermedios ayuda al sistema de aprendizaje a mantener y reutilizar la información al cambiar de tarea o cuando una secuencia contiene muchos pasos.

Desde la perspectiva del aprendizaje automático, esto puede verse como la adición de estructura al espacio de estados interno del agente para que pueda avanzar a través del cómputo de forma escalonada y repetible. Los investigadores sostienen que este tipo de autointeracción estructurada es una alternativa económica a los conjuntos de datos de entrenamiento gigantes o al escalado de modelos por fuerza bruta para lograr flexibilidad.

Ecos matemáticos en lugares inesperados

Otros dos hilos de investigación recientes ayudan a situar los resultados del OIST en un marco conceptual más amplio. En la University of Pennsylvania, los ingenieros demostraron que la reorganización interna de las burbujas en las espumas sigue unas matemáticas que reflejan cómo las redes profundas modernas navegan por sus paisajes de entrenamiento. Mientras que las metáforas más antiguas trataban a las burbujas como si quedaran atrapadas en valles como el vidrio, los nuevos análisis ven tanto a las espumas como a los parámetros de la IA entrenada deambulando por regiones amplias y llanas en lugar de hundirse en óptimos estrechos. Esa reorganización continua es lo que permite a los modelos generalizar: permanecer en las partes más llanas del paisaje hace que las soluciones sean robustas ante nuevas entradas.

Leídos en conjunto, los estudios sugieren una intuición matemática común: los sistemas que mantienen una dinámica interna flexible y ensayable —ya sean burbujas en un material físico o variables dentro de un controlador neuronal— evitan el sobreajuste (overfitting) frágil y mantienen su capacidad de adaptación. El habla interna del OIST podría ser un mecanismo práctico mediante el cual una IA mantiene su trayectoria interna en esos valles más amplios y generalizables.

Corporeidad y señales sociales: vínculos con la robótica y la IA afectiva

El habla interna encaja de forma natural con estas tendencias. Un agente corpóreo que ensaya pasos internos —un robot que no solo modela el mundo exterior, sino que también mantiene y vocaliza un breve plan interno— podría coordinar mejor las secuencias motoras (sincronización labial o manipulación), interpretar las señales de sus interlocutores humanos y explicar sus propias decisiones en términos comprensibles para las personas. Esa superposición de automodelos internos con la percepción externa también es fundamental para los esfuerzos destinados a hacer que la IA sea fiable fuera de las distribuciones de entrenamiento estrechas, como los proyectos que buscan una I+D robusta con "humanos en el bucle" (human-in-the-loop) y máquinas que razonen sobre los objetivos tácitos de los expertos.

Promesas y límites

Los resultados del OIST son prometedores pero preliminares. Los experimentos presentados son simulaciones computacionales; los modelos aún deben validarse en entornos del mundo real, ruidosos y dinámicos, donde los sensores fallan, se producen retrasos y los objetivos cambian de forma imprevisible. El equipo lo reconoce abiertamente, afirmando que sus próximos pasos serán "complicar las cosas" para imitar el aprendizaje evolutivo en el entorno natural. Las pruebas corpóreas con robots en entornos domésticos o agrícolas serán la verdadera prueba de si el habla interna escala de los tokens simulados a un comportamiento físico robusto.

También hay consideraciones conceptuales y éticas. Los científicos deben evitar los atajos antropomórficos: el "habla interna" de un modelo no es pensamiento subjetivo; es una señal de ensayo diseñada. Aun así, la etiqueta importa para la percepción pública. Los sistemas que producen un lenguaje autodirigido o que narran pasos internos podrían confundirse con agentes conscientes. Esto aumenta los requisitos de transparencia: los diseñadores deben documentar claramente qué hace un canal de habla interna, cómo puede fallar y si puede ser coaccionado o manipulado por entradas adversarias.

Por qué es importante

Si el habla interna y las arquitecturas ligeras de memoria de trabajo mejoran de forma fiable la generalización y la multitarea con datos modestos, las implicaciones prácticas son amplias. Los sistemas de IA que necesitan adaptarse sobre la marcha —robots domésticos que alternan tareas, drones agrícolas que responden a cultivos cambiantes o asistentes de laboratorio que trabajan con datos experimentales escasos— podrían volverse más eficientes, seguros y útiles sin necesidad de un crecimiento exponencial de los conjuntos de datos de entrenamiento etiquetados. Además, la idea encaja con las perspectivas matemáticas y de aprendizaje corpóreo que están surgiendo en la ciencia de materiales y la robótica, sugiriendo caminos interdisciplinarios fértiles.

Lo que empezó como un truco de inspiración cognitiva —enseñar a la máquina a ensayar— puede, por tanto, apuntar a un principio de ingeniería más profundo: construir una estructura interna que permita a los agentes reorganizarse de forma flexible en lugar de optimizar en exceso de manera rígida. Si los futuros experimentos en entornos reales confirman las simulaciones, "hablar con uno mismo" podría convertirse en una herramienta estándar en el kit de arquitectura para una IA robusta y consciente del factor humano.

Fuentes

- Neural Computation (artículo de investigación: Working Memory and Self-Directed Inner Speech Enhance Multitask Generalization in Active Inference)

- Okinawa Institute of Science and Technology (OIST), materiales de prensa

- Proceedings of the National Academy of Sciences (estudio sobre espumas sobre relajación lenta y dinámica impulsada por el paisaje en espumas de maduración viscosas)

- University of Pennsylvania School of Engineering and Applied Science

- Science Robotics (investigación sobre sincronización labial en robots)

- Columbia Engineering (Creative Machines Lab)

- Japan Advanced Institute of Science and Technology (JAIST) — investigación sobre señales sociales multimodales

- ELLIS Institute Finland / Aalto University (investigación sobre equipos humano-IA y robustez fuera de la distribución)

Comments

No comments yet. Be the first!