Ett labb som lärde maskiner att mumla

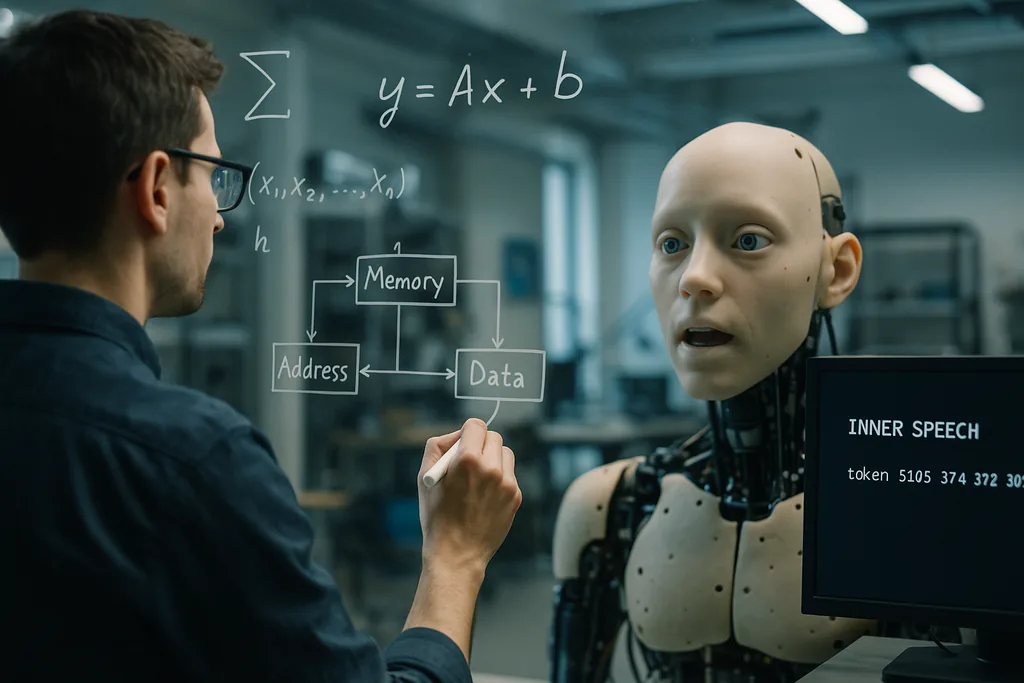

Denna vecka rapporterade forskare vid Okinawa Institute of Science and Technology (OIST) om en enkel men slående idé: artificiella agenter lär sig att generalisera bättre när de tränas i att ”prata med sig själva”. Studien, som publicerades den 22 december 2025 i tidskriften Neural Computation, visar att genom att lägga till en självstyrd verbal repetitions-signal – som teamet beskriver som ett slags programmerat ”inre tal” eller självmumlande – tillsammans med en arbetsminnesarkitektur som ger modellen flera korttidsminnesplatser, förbättras prestandan i svåra uppgifter som kräver multitasking och stegvis mönstergenerering.

Så byggdes experimentet upp

Forskarna genomförde datorbaserade simuleringar med ramverk för aktiv inferens. De jämförde flera arkitekturer för korttidsminne och testade om inlärningsresultaten förändrades genom att lägga till ett mål som krävde att agenten sände ut interna tokens – vilket i praktiken tvingade modellen att ”mumla” för sig själv ett visst antal gånger. System med flera temporära minnesplatser presterade bättre än enklare minnesmodeller vid överföring (transfer) och multitasking. När mål för inre tal lades ovanpå denna minnesstruktur förbättrades dessutom uppgiftsväxling och slutförande av flerstegssekvenser ytterligare.

OIST beskriver metoden som innehållsagnostisk: det inre talet behöver inte vara semantiskt meningsfullt i mänskliga termer, utan fungerar som en repetitions- och kontrollsignal som strukturerar den interna dynamiken. Detta gjorde metoden särskilt värdefull i lågdatamiljöer där vanliga djupinlärningsmodeller typiskt sett har svårt att generalisera utanför sina träningsexempel.

Varför det hjälper att säga saker högt – för sig själv

Det finns två kompletterande intuitioner bakom effekten. För det första ger korttidsminnesplatser systemet tillfälliga behållare för mellanresultat och instruktioner, vilket gör att det kan hålla kvar flera delar av övergående information medan en längre beräkning pågår. För det andra utgör signalen för det inre talet en intern stöttning: att repetera eller koda om mellansteg hjälper den lärande agenten att bevara och återanvända information vid uppgiftsväxling eller när en sekvens innehåller många steg.

Ur ett maskininlärningsperspektiv kan detta ses som att man lägger till struktur i agentens interna tillståndsrum så att den kan röra sig genom beräkningar på ett stegvis och upprepbart sätt. Forskarna menar att denna typ av strukturerad självinteraktion är ett billigt alternativ till gigantiska träningsdataset eller råstyrkebaserad modellskalning för att uppnå flexibilitet.

Matematiska ekon på oväntade platser

Två andra färska forskningsspår hjälper till att placera OIST:s resultat i en bredare konceptuell ram. Vid University of Pennsylvania visade ingenjörer att den interna omorganisationen av bubblor i skum följer matematik som speglar hur moderna djupa nätverk navigerar i sina träningslandskap. Där äldre metaforer liknade bubblor vid att fastna i dalar likt glas, ser nya analyser hur både skum och tränade AI-parametrar rör sig inom breda, flata regioner snarare än att sjunka ner i smala optima. Det är denna kontinuerliga omorganisation som gör att modeller kan generalisera: genom att stanna i plattare delar av landskapet blir lösningarna robusta mot nya indata.

Sammantaget tyder studierna på en gemensam matematisk intuition: system som upprätthåller en flexibel, repeterbar intern dynamik – oavsett om det är bubblor i ett fysiskt material eller variabler inuti en neural styrenhet – undviker skör överinpassning (overfitting) och förblir anpassningsbara. OIST:s inre tal skulle kunna vara en praktisk mekanism genom vilken en AI håller sin interna bana inom dessa bredare, generaliserbara dalar.

Fysisk gestaltning och sociala signaler: länkar till robotik och affektiv AI

Inre tal passar naturligt ihop med dessa trender. En förkroppsligad agent som repeterar interna steg – en robot som inte bara modellerar den yttre världen utan också upprätthåller och vokaliserar en kort intern plan – skulle bättre kunna koordinera motoriska sekvenser (läppsynkning eller manipulation), tolka mänskliga partners signaler och förklara sina egna beslut på ett människo-vänligt sätt. Denna lagring av interna självmodeller med extern perception är också central i ansträngningar för att göra AI pålitlig utanför snäva träningsdistributioner, såsom projekt som söker robust människa-i-loopen-forskning och maskiner som kan resonera kring experters tysta mål.

Löften och begränsningar

Resultaten från OIST är lovande men preliminära. De rapporterade experimenten är datorbaserade simuleringar; modeller behöver fortfarande valideras i brusiga, dynamiska och verkliga miljöer där sensorer fallerar, fördröjningar uppstår och mål ändras oförutsägbart. Teamet erkänner detta öppet och säger att deras nästa steg blir att ”göra saker stökigare” för att efterlikna utvecklingsinlärning i det fria. Tester med fysiska robotar i hushålls- eller jordbruksmiljöer blir det verkliga provet på om inre tal kan skalas upp från simulerade tokens till robust fysiskt beteende.

Det finns också konceptuella och etiska överväganden. Forskare måste undvika antropomorfiska förenklingar: en modells ”inre tal” är inte subjektivt tänkande; det är en konstruerad repetitions-signal. Ändå spelar etiketten roll för den allmänna uppfattningen. System som producerar självstyrt språk eller som berättar om interna steg skulle kunna misstas för medvetna agenter. Detta ökar kraven på transparens: konstruktörer bör tydligt dokumentera vad en kanal för internt tal gör, hur den kan fallera och om den kan manipuleras av antagonistiska indata.

Varför det spelar roll

Om inre tal och lätta arbetsminnesarkitekturer på ett tillförlitligt sätt förbättrar generalisering och multitasking med måttliga mängder data, är de praktiska konsekvenserna omfattande. AI-system som behöver anpassa sig i stunden – hushållsrobotar som hanterar flera uppgifter, jordbruksdrönare som reagerar på förändrade grödor eller laboratorieassistenter som arbetar med knappa experimentdata – kan bli effektivare, säkrare och mer användbara utan en exponentiell tillväxt av märkta träningsdata. Dessutom sammanfaller idén med matematiska och kroppsliga inlärningsperspektiv som nu växer fram inom materialvetenskap och robotik, vilket tyder på fruktbara tvärvetenskapliga vägar.

Vad som började som ett kognitionsinspirerat knep – att lära maskinen att repetera – kan därför peka på en djupare ingenjörsprincip: bygg intern struktur som låter agenter omorganisera sig flexibelt snarare än att överoptimera stelt. Om framtida experiment i verkliga miljöer bekräftar simuleringarna, kan det att ”prata med sig själv” bli ett standardverktyg i arkitekturverktygslådan för robust, människo-medveten AI.

Källor

- Neural Computation (forskningsartikel: Working Memory and Self-Directed Inner Speech Enhance Multitask Generalization in Active Inference)

- Okinawa Institute of Science and Technology (OIST) pressmaterial

- Proceedings of the National Academy of Sciences (skumstudie om långsam relaxation och landskapsdriven dynamik i viskösa mognande skum)

- University of Pennsylvania School of Engineering and Applied Science

- Science Robotics (forskning om läppsynkning för robotar)

- Columbia Engineering (Creative Machines Lab)

- Japan Advanced Institute of Science and Technology (JAIST) — forskning om multimodala sociala signaler

- ELLIS Institute Finland / Aalto University (forskning om människa-AI-team och robusthet utanför distributionen)

Comments

No comments yet. Be the first!