Nya koder minskar bruset som hindrar kvantdatorer från att skalas upp

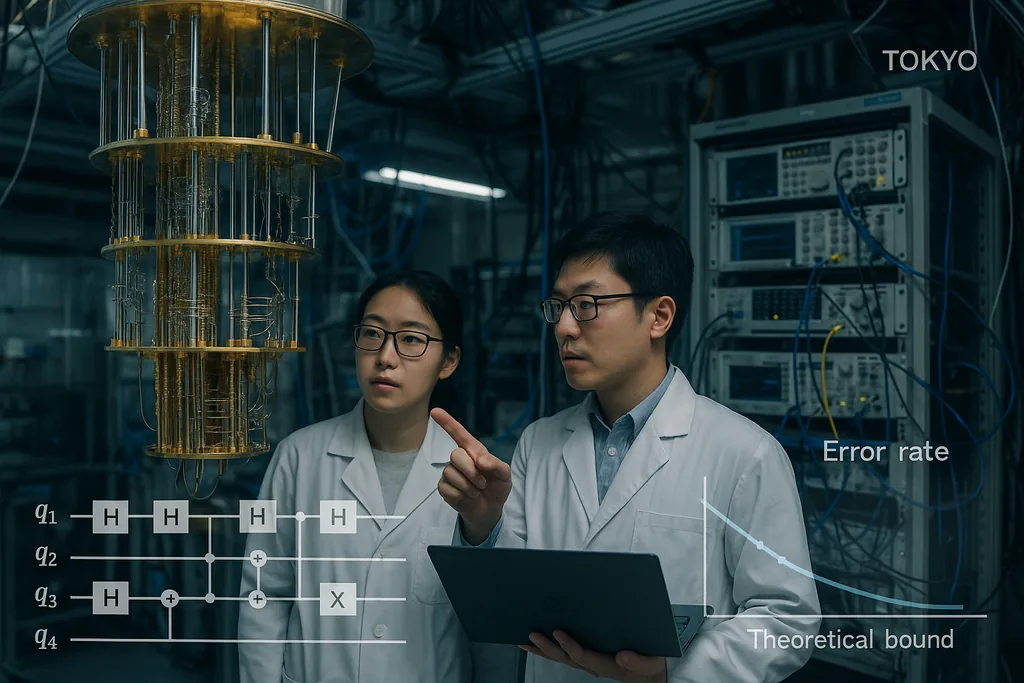

Den 30 september 2025 publicerade ett team i Tokyo en rapport som visar kvantfelrättande koder som ligger ovanligt nära den långvariga teoretiska gränsen för tillförlitlig kvantkommunikation och beräkning – den så kallade hashing-gränsen – samtidigt som de förblir effektivt avkodningsbara. Resultatet, som nu uppmärksammas i institutionella sammanfattningar, är ingen enkel magisk lösning; det är en noggrann omdesign av LDPC-konstruktioner (low-density parity-check) och deras avkodare som tillsammans pressar ner ramfelsfrekvensen till praktiska nivåer och håller den beräkningsmässiga resursåtgången låg. Dessa två egenskaper – prestanda nära kapacitetsgränsen och avkodningskostnader som skalar linjärt med maskinen – är just de egenskaper som krävs för att flytta kvantprocessorer från laboratoriekuriositeter till maskiner som kan hantera verkliga problem inom kemi, kryptografi och klimatvetenskap.

En kod nära kapacitetsgränsen för den brusiga kvantkanalen

Hashing-gränsen är ett informationsteoretiskt tak: den markerar den högsta hastighet med vilken kvantinformation kan överföras tillförlitligt över en brusig kanal med optimal kodning och avkodning. Historiskt sett har kvantkoder som är bevisbart effektiva legat långt ifrån den gränsen eller krävt opraktiskt tunga avkodare. Genom att demonstrera koder som både närmar sig gränsen och kan avkodas med klassiska resurser som skalar blygsamt, ger Komoto och Kasai goda argument för att hårdvaruskalning – projektet att koppla samman miljontals fysiska kvantbitar för att generera många logiska kvantbitar – är ett realistiskt ingenjörsmål snarare än en teoretisk önskedröm.

Avkodare: den förbisedda flaskhalsen som håller på att lösas

Felrättande koder är bara halva historien; snabba, exakta avkodare är den andra halvan. Under det senaste året har flera algoritmiska framsteg naggat avkodningsflaskhalsen i kanten. I juni 2025 beskrev forskare PLANAR, en exakt avkodningsalgoritm för vissa kodtopologier som förvandlar ett till synes olösligt maximum-likelihood-avkodningsproblem till en effektivt lösbar beräkning av en spinglas-partitionsfunktion på planära grafer. När PLANAR tillämpades på experimentella data minskade den logiska felprocenten avsevärt och visade att en del av det som såg ut som hårdvarubegränsningar i själva verket var en suboptimal avkodare. Denna insikt är viktig eftersom den innebär att bättre avkodare kan hämta ut mer prestanda från befintliga enheter utan att kvantmaskinvaran behöver ändras.

På ingenjörssidan flyttar industriteam dessa avkodningsidéer till klassisk hårdvara för realtid. IBM rapporterade nyligen att en central algoritm för felrättning kan köras på konventionella AMD FPGA:er tillräckligt snabbt för realtidsåterkoppling i supraledande system, vilket demonstrerar drift långt utöver den hastighet som krävs för många arkitekturer. Att köra avkodare på tillgängliga klassiska chipp är ett avgörande steg: det förvandlar felrättning från en offline-baserad och kostsam mjukvaruprocess till en praktisk tjänst med låg latens som kan bäddas in i kontrollstackar för stora maskiner. Tillsammans med koder nära kapacitetsgränsen sluter snabba hårdvaruavkodare cirkeln mellan teori och driftsättbara system.

Vad denna konvergens innebär för verkliga tillämpningar

Kvanttillämpningar som lovar transformativt värde – molekylär simulering för läkemedelsutveckling, logistikoptimering eller nya kryptografiska primitiver – kräver vanligtvis miljontals logiska kvantbitar eller extremt låga logiska felprocent under långa beräkningar. Hittills har dessa resursuppskattningar resulterat i astronomiska mängder fysiska kvantbitar eftersom felrättning har haft både dåliga tröskelvärden och kostsamma avkodare. Kombinationen av Komoto och Kasais kodkonstruktioner, förbättrade avkodare som PLANAR och strävan efter att köra avkodning på vanlig klassisk hårdvara sänker i princip denna resursåtgång avsevärt. Detta förskjuter balansen: en generation av kvanthårdvara som tidigare bedömdes som opraktisk kan nu vara inom räckhåll om ingenjörsteamen kan leverera kvantbit-arrayer i måttlig skala med den förväntade fysiska precisionen.

Det finns redan tillämpningsorienterade spår som bygger på detta arbete. Till exempel har forskare som utforskar kvantmaskininlärning visat att partiell eller approximativ felrättning kan göra kortsiktiga kvantmodeller betydligt mer praktiska än tidigare, vilket minskar de hårdvarukrav som krävs för att se en fördel. Sådana synergier mellan kodteori, approximativ feltolerans och algoritmdesign kan påskynda praktisk användning på mellanliggande maskiner redan innan fullständig feltolerans uppnås.

Hinder som kvarstår

Trots framstegen kvarstår flera svåra ingenjörs- och fysikproblem. Koderna och avkodarna i Komoto–Kasai-artikeln demonstreras i simuleringar och numeriska studier; att flytta dem till kisel, supraledande kretsar, fångade joner eller fotoniska uppställningar kräver konstruktion av avkodningspipeliner med extrema realtidsgarantier, dirigering av miljontals signaler genom kryogena stackar och undertryckande av sällsynta men förödande effekter som korrelerade fel orsakade av kosmisk strålning. Att implementera icke-binär aritmetik för ändliga fält i hårdvara, integrera syndromextraktion utan att tillföra brus och validera prestanda i realistiska brusmodeller för enheter är icke-triviala uppgifter som kommer att avgöra om det numeriska löftet blir en operativ verklighet.

Det finns också konkurrerande hårdvarustrategier. Vissa grupper förbättrar hårdvarans inneboende felresistens – till exempel hävdar fotoniska och cat-qubit-metoder olika avvägningar mellan naturlig brusbias och resursantal – och jämförelser mellan dessa arkitekturer kommer att vara avgörande allteftersom skalbara avkodare blir tillgängliga. Alla arkitekturer kommer inte att kunna utnyttja varje kod eller avkodare lika bra, så forskarvärlden behöver fortfarande validering mellan olika plattformar.

Från teori till ingenjörskonst: nästa steg

Vägen framåt ser ut som ett samordnat trespårigt program. För det första kommer koddesigners att förfina konstruktioner för att hantera mer realistiska brusmodeller och korrelerade fel, samt för att sänka felgolven ytterligare. För det andra kommer avkodningsteamen att fortsätta att minska latens och energikostnad samt porta algoritmer till FPGA:er, ASIC:er och kryogen logik där det behövs. För det tredje kommer hårdvarugrupper att benchmarka koder och avkodare på riktiga enheter och rapportera inte bara logiska felprocenter utan även dolda infrastrukturkostnader: klassisk beräkning, kablage, kylning och underhåll. Om dessa tre spår sammanstrålar kommer forskarvärlden att kunna förvandla det abstrakta löftet om kvantfördelar till konkreta färdplaner för maskiner som utför användbart arbete.

Sammanfattningsvis är det nyligen genomförda arbetet med LDPC-koder nära hashing-gränsen inte en isolerad framgång utan det senaste, övertygande tecknet på att en kombination av smartare koder, bättre avkodare och praktisk integration av klassisk hårdvara kan överbrygga klyftan mellan teori och tillämpning. Tidslinjen för brett användbar kvantdatabehandling förblir osäker, men dessa framsteg förbättrar avsevärt de ingenjörsmässiga argumenten för att bygga nästa generation av maskiner som ska försöka utföra verkligt arbete för industri och vetenskap.

Källor

- npj Quantum Information (Komoto & Kasai: "Quantum error correction near the coding theoretical bound").

- Physical Review Letters (Cao et al.: "Exact Decoding of Quantum Error‑Correcting Codes").

- Pressmaterial från Institute of Science Tokyo som sammanfattar Komoto & Kasais arbete.

- IBM:s forskningsrapporter och redogörelser om FPGA-implementeringar av kvantavkodare.

Comments

No comments yet. Be the first!