Nieuwe codes verminderen de ruis die de schaalbaarheid van quantumcomputers belemmert

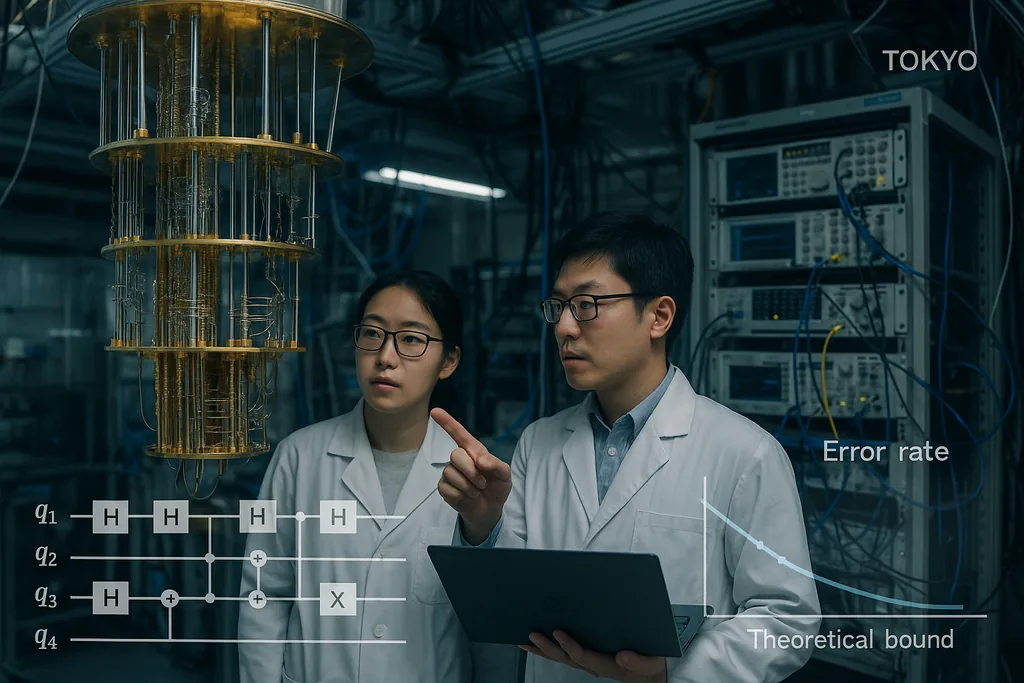

Op 30 september 2025 publiceerde een team in Tokio een artikel waarin quantumfoutcorrigerende codes worden gepresenteerd die ongebruikelijk dicht bij de langdurige theoretische limiet voor betrouwbare quantumcommunicatie en -berekening liggen — de zogenaamde hashing-grens — terwijl ze efficiënt decodeerbaar blijven. Het resultaat, dat inmiddels breed wordt uitgemeten in institutionele publicaties, is geen simpele wondermiddel; het is een zorgvuldig herontwerp van low-density parity-check-constructies en hun decoders die samen de frame-foutpercentages terugbrengen tot praktische niveaus en de computationele overhead laag houden. Die twee kenmerken — prestaties nabij de capaciteitslimiet en decoderingskosten die lineair schalen met de machine — zijn precies de eigenschappen die nodig zijn om quantumprocessoren te transformeren van laboratoriumcuriositeiten tot machines die echte problemen in de chemie, cryptografie en klimaatwetenschap kunnen aanpakken.

Een code nabij de capaciteitslimiet voor het ruisgevoelige quantumkanaal

De hashing-grens is een informatietheoretisch plafond: het markeert de hoogste snelheid waarmee quantuminformatie betrouwbaar over een ruisgevoelig kanaal kan worden verzonden bij gebruik van optimale codering en decodering. Historisch gezien lagen quantumcodes waarvan de efficiëntie bewezen kon worden ver van die limiet, of vereisten ze onpraktisch zware decoders. Door codes te demonstreren die zowel de grens benaderen als gedecodeerd kunnen worden met klassieke middelen die bescheiden schalen, leveren Komoto en Kasai een overtuigend bewijs dat hardware-schaling — het project om miljoenen fysieke qubits te koppelen om vele logische qubits te produceren — een realistisch technisch doel is in plaats van een theoretische droom.

Decoders: de miskende flessenhals wordt een opgelost probleem

Foutcorrigerende codes zijn slechts de helft van het verhaal; snelle, nauwkeurige decoders zijn de andere helft. Het afgelopen jaar hebben verschillende algoritmische vorderingen de bottleneck bij het decoderen weggenomen. In juni 2025 beschreven onderzoekers PLANAR, een exact decoderingsalgoritme voor bepaalde codetopolgieën dat een schijnbaar onbehandelbaar maximum-likelihood-decoderingsprobleem verandert in een efficiënt oplosbare spin-glas-partitiefunctie-berekening op planaire grafen. Bij toepassing op experimentele data verminderde PLANAR de logische foutpercentages aanzienlijk en toonde het aan dat een deel van wat hardwarelimieten leken, in werkelijkheid een suboptimale decoder was. Dat inzicht is cruciaal, omdat het betekent dat betere decoders meer prestaties uit bestaande apparaten kunnen halen zonder dat de quantumhardware hoeft te worden aangepast.

Aan de technische kant verplaatsen industriële teams deze decoderingsconcepten naar real-time klassieke hardware. IBM rapporteerde onlangs dat een belangrijk algoritme voor foutcorrectie op conventionele AMD FPGA's kan draaien, snel genoeg voor real-time feedback in supergeleidende systemen. Dit demonstreert een werking die ver boven de snelheid ligt die nodig is voor veel architecturen. Het draaien van decoders op toegankelijke klassieke chips is een cruciale stap: het transformeert foutcorrectie van een offline, kostbaar softwareproces in een praktische dienst met lage latentie die kan worden ingebed in de besturingssystemen van grote machines. Samen met de codes nabij de capaciteitslimiet sluiten snelle hardware-decoders de cirkel tussen theorie en inzetbare systemen.

Wat deze convergentie betekent voor echte toepassingen

Quantumtoepassingen die transformationele waarde beloven — moleculaire simulatie voor geneesmiddelenonderzoek, optimalisatie voor logistiek of nieuwe cryptografische primitieven — vereisen doorgaans miljoenen logische qubits of extreem lage logische foutpercentages die gedurende lange berekeningen worden volgehouden. Tot nu toe vertaalden die schattingen zich in astronomische aantallen fysieke qubits, omdat foutcorrectie zowel slechte drempelwaarden als kostbare decoders had. De combinatie van de coderingsconstructies van Komoto en Kasai, verbeterde decoders zoals PLANAR en het streven om decodering op standaard klassieke hardware uit te voeren, verlaagt die overhead in principe aanzienlijk. Dat verschuift de balans: een generatie quantumhardware die voorheen als onpraktisch werd beoordeeld, kan nu binnen bereik liggen als technische teams qubit-arrays op gematigde schaal kunnen leveren met de verwachte fysieke betrouwbaarheid.

Er zijn al toepassingsgerichte ontwikkelingen die voortbouwen op dit werk. Onderzoekers die quantum-machine-learning verkennen, hebben bijvoorbeeld aangetoond dat gedeeltelijke of benaderende foutcorrectie nabije-toekomst quantummodellen veel praktischer kan maken dan voorheen, waardoor de hardware-eisen die nodig zijn om een voordeel te zien, afnemen. Dergelijke synergieën tussen coderingstheorie, benaderende fouttolerantie en algoritme-ontwerp zouden het praktische gebruik op tussenliggende machines kunnen versnellen, nog voordat volledige fouttolerantie is bereikt.

Resterende barrières

Ondanks de vooruitgang blijven verschillende lastige technische en natuurkundige problemen bestaan. De codes en decoders in het artikel van Komoto en Kasai zijn aangetoond in simulaties en numerieke studies; het vertalen hiervan naar silicium, supergeleidende circuits, gevangen ionen of fotonische opstellingen vereist de ontwikkeling van decoder-pijplijnen met extreme real-time garanties, het routeren van miljoenen signalen door cryogene systemen en het onderdrukken van zeldzame maar verwoestende effecten zoals door kosmische straling veroorzaakte gecorreleerde fouten. Het implementeren van niet-binaire eindig-veld-rekenkunde in hardware, het integreren van syndroom-extractie zonder ruis toe te voegen en het valideren van prestaties in realistische ruismodellen voor apparaten zijn niet-triviale taken die zullen bepalen of de numerieke belofte een operationele realiteit wordt.

Er zijn ook concurrerende hardwarestrategieën in het spel. Sommige groepen verbeteren de intrinsieke foutbestendigheid van de hardware — fotonische en cat-qubit-benaderingen claimen bijvoorbeeld verschillende afwegingen tussen natuurlijke ruisbias en de benodigde middelen — en benchmarking tussen deze architecturen zal essentieel zijn naarmate schaalbare decoders beschikbaar komen. Niet elke architectuur zal in staat zijn om elke code of decoder even goed te benutten, dus de gemeenschap heeft nog steeds cross-platform validatie nodig.

Van theorie naar engineering: de volgende stappen

De weg voorwaarts ziet eruit als een gecoördineerd driesporenprogramma. Ten eerste zullen ontwerpers van codes constructies verfijnen om realistischere ruismodellen en gecorreleerde fouten aan te pakken, en om foutenmarges verder te verlagen. Ten tweede zullen decoder-teams de latentie en energiekosten blijven verlagen en algoritmen porteren naar FPGA's, ASICs en cryogene logica waar nodig. Ten derde zullen hardwaregroepen codes en decoders benchmarken op echte apparaten, waarbij ze niet alleen logische foutpercentages rapporteren, maar ook de verborgen infrastructuurkosten: klassieke rekenkracht, bekabeling, koeling en onderhoud. Als die drie sporen samenkomen, zal de gemeenschap in staat zijn om de abstracte belofte van quantumvoordeel om te zetten in concrete routekaarten voor machines die nuttig werk verrichten.

Kortom, het recente werk aan LDPC-codes nabij de hashing-grens is geen op zichzelf staand succes, maar het nieuwste, overtuigende teken dat een combinatie van slimmere codes, betere decoders en praktische integratie van klassieke hardware het gat tussen theorie en toepassing kan dichten. De tijdlijn voor breed inzetbare quantum computing blijft onzeker, maar deze vorderingen verbeteren de technische basis voor het bouwen van de volgende generatie machines die zullen proberen echt werk te verrichten voor de industrie en de wetenschap.

Bronnen

- npj Quantum Information (Komoto & Kasai: "Quantum error correction near the coding theoretical bound").

- Physical Review Letters (Cao et al.: "Exact Decoding of Quantum Error‑Correcting Codes").

- Persmateriaal van het Institute of Science Tokyo dat het werk van Komoto & Kasai samenvat.

- Onderzoeksbekendmakingen en rapportages van IBM over FPGA-implementaties van quantumdecoders.

Comments

No comments yet. Be the first!