Den 27 januari 2026 publicerade OpenAI ovanligt detaljerade tekniska anteckningar som förklarar hur Codex CLI – företagets kodningsagent för kommandoraden – faktiskt hanterar konversationer, anropar verktyg och hanterar kontext.

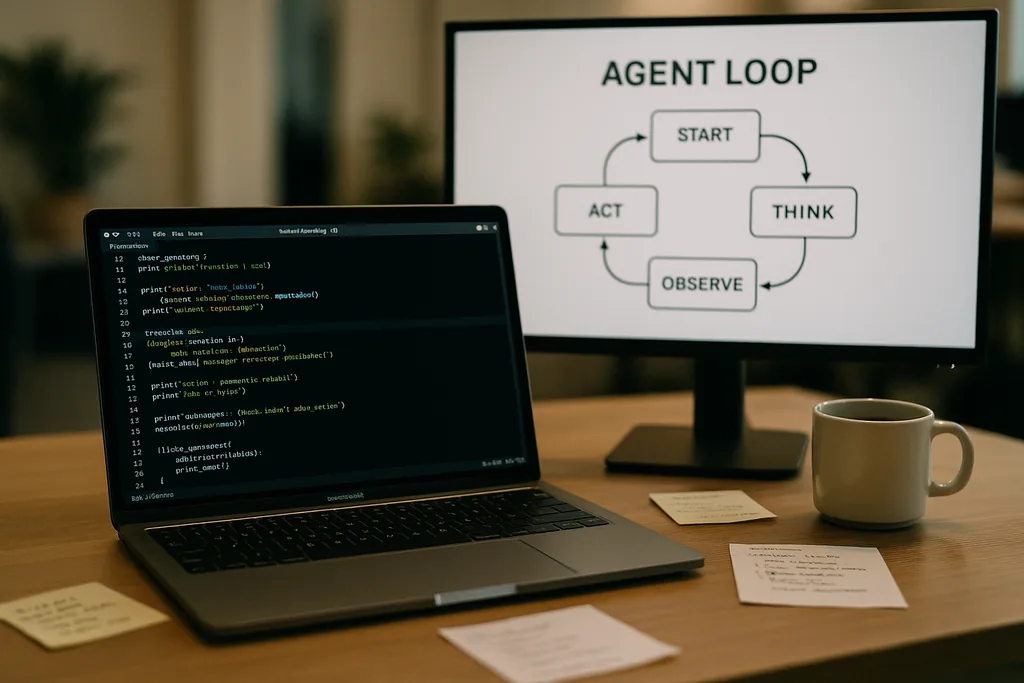

Hur agentloopen ser ut

Kärnan i Codex CLI är ett enkelt upprepande mönster som ingenjörer kallar för "agentloopen": ta emot användarinmatning, skapa en prompt, be modellen om ett svar, agera på de verktygsanrop som modellen begär, lägg till verktygens utdata i konversationen och repetera tills modellen returnerar ett slutgiltigt assistentmeddelande.

Detta mönster låter okomplicerat, men dokumentationen går igenom många små designbeslut som tillsammans formar prestanda och tillförlitlighet. Prompten som skickas till modellen är inte ett enskilt textblock; det är en strukturerad sammansättning av prioriterade komponenter. Rollerna system, utvecklare, assistent och användare avgör vilka instruktioner som har företräde. Ett verktygsfält visar tillgängliga funktioner – lokala skal-kommandon, planeringsverktyg, webbsökning och anpassade tjänster som exponeras via MCP-servrar (Model Context Protocol). Miljökontext beskriver sandbox-behörigheter, arbetskataloger och vilka filer eller processer som är synliga för agenten.

Verktygsanrop, MCP och sandboxing

När modellen genererar ett verktygsanrop kör Codex det verktyget i en kontrollerad miljö (dess sandbox), fångar upp utdata och lägger till resultatet i konversationen. Anpassade verktyg kan implementeras via MCP-servrar – en öppen standard som flera företag har anammat – vilket gör att en modell kan upptäcka och anropa förmågor utöver ett enkelt skal. Dokumentationen diskuterar också specifika buggar som teamet upptäckte när de byggde dessa integrationer – till exempel en inkonsekvent enumerering av MCP-verktyg – som var tvungna att åtgärdas.

OpenAI noterar att sandboxing och verktygsåtkomst är aktiva områden för kommande inlägg. Den initiala dokumentationen fokuserar på loop-mekaniken och prestandaoptimering snarare än den fullständiga hotmodellen för agenter med skrivåtkomst till ett filsystem eller nätverkstjänster.

Tillståndslösa förfrågningar, integritetsval och kostnaden för att kopiera kontext

Den ökningen är inte linjär. Varje tur lägger till tokens, och eftersom varje tur inkluderar tidigare turer i sin helhet, tenderar promptstorleken mot kvadratisk tillväxt i förhållande till antalet turer. Teamet dokumenterar detta uttryckligen och förklarar hur de mildrar det med kontextkompaktering och prompt-cachning.

Prompt-cachning och exakta prefix

Prompt-cachning är en pragmatisk optimering: om en ny förfrågan är ett exakt prefix av en tidigare cachad prompt, kan leverantören återanvända beräkningar och returnera resultat snabbare. Men cacher kräver rigiditet. Varje ändring av tillgängliga verktyg, ett modellbyte eller till och med en justering av sandbox-konfigurationen kan ogiltigförklara prefixet och förvandla en cache-träff till en kostsam miss. OpenAI-ingenjörer varnar för att utvecklare bör undvika rekonfigurering mitt i en konversation när de behöver konsekvent latens.

Cache-träffar beror på exakt prefixmatchning, så förnuftiga metoder inkluderar att låsa (pinning) verktygsmanifest och att hålla modellvalet konstant under en pågående interaktion. När cache-missar sker ofta, försämras systemet till fullständig ombearbetning vid varje anrop – precis när utvecklare förväntar sig att agenten ska kännas rapp.

Kontextkompaktering: att komprimera det förflutna utan att förlora mening

För att hantera token-tillväxt implementerar Codex automatisk kontextkompaktering. Istället för att överlåta det till ett användarkommando, anropar CLI:et en specialiserad API-slutpunkt som komprimerar äldre konversationsvändor till ett krypterat innehållsobjekt samtidigt som sammanfattad kunskap som modellen behöver för att fortsätta bibehålls. Tidigare versioner krävde manuell kompaktering av användaren; det nyare tillvägagångssättet flyttar processen till ett API-anrop som bevarar modellens arbetsminne.

Kompaktering minskar token-kostnaden men introducerar några finesser: sammanfattningar måste vara tillräckligt trogna för att förhindra framtida hallucinationer, krypteringsegenskaper måste matcha integritetsbegränsningar, och heuristik för kompaktering måste avgöra vilka delar av tillståndet som är nödvändiga kontra umbärliga. Dokumentationen flaggar dessa som öppna tekniska val snarare än fastställda designer.

Praktiska begränsningar och utvecklarupplevelse

OpenAI:s anteckningar är uppriktiga gällande styrkor och svagheter. För enkla uppgifter – den typ av scaffolding, boilerplate eller snabb prototypframtagning som kodningsagenter är utmärkta på – är Codex snabb och användbar. För djupare, kontexttungt ingenjörsarbete som modellen inte har sett i sina träningsdata, är agenten bräcklig. Den kommer att generera lovande skelett, för att sedan avstanna eller mata ut felaktiga steg som kräver mänsklig felsökning.

Ingenjörer som testat Codex internt fann att agenten kan påskynda det initiala skapandet av projekt dramatiskt, men den kan ännu inte ersätta den iterativa, expertdrivna felsökning som gedigen ingenjörskonst kräver. Teamet bekräftade också att de använder Codex för att bygga delar av Codex själv – en praxis som väcker intressanta frågor om feedback-loopar för verktyg som tränats på sin egen utdata.

Varför OpenAI öppnade upp detta – transparens, konkurrens och standarder

Att publicera en djupdykning i en konsumentprodukts interna teknik är anmärkningsvärt från ett företag som vanligtvis har vaktat sina operativa detaljer. OpenAI:s offentliggörande sammanfaller med en bredare satsning i ekosystemet mot agentstandarder: Anthropic och OpenAI stöder båda MCP för upptäckt och anrop av verktyg, och båda publicerar CLI-klienter som öppen källkod så att utvecklare kan inspektera beteendet från början till slut.

Transparensen tjänar flera målgrupper. Utvecklare får implementeringsmönster och praktiska råd för att bygga pålitliga agenter. Säkerhetsmedvetna ingenjörer kan granska avvägningar gällande sandboxar och verktygsåtkomst. Konkurrenter och standardiseringsorgan kan iterera snabbare eftersom de inte behöver bakåtutveckla (reverse-engineer) klientbeteenden för att kunna samverka.

Operativa råd för team som använder kodningsagenter

- Lås (pin) modeller och verktygsmanifest inom en session för att maximera prompt-cache-träffar och stabil prestanda.

- Använd kontextkompaktering proaktivt för långa uppgifter för att kontrollera token-kostnader och undvika skenande prompt-tillväxt.

- Begränsa agentens behörigheter och isolera skrivbara mappar i sandboxar för att minska oavsiktliga eller skadliga biverkningar.

- Förvänta dig och budgetera för manuell felsökning: agenter påskyndar grundstrukturer och iteration, men de ersätter ännu inte expertresonemang i komplexa kodbaser.

Vad som händer härnäst

Ingenjören som skrev inlägget signalerade uppföljningar som kommer att täcka CLI-arkitekturen mer på djupet, verktygsimplementering och sandbox-modellen. Dessa framtida inlägg kommer att vara betydelsefulla: när agenter får djupare åtkomst till utvecklares miljöer kommer mekaniken för säkert utförande, proveniens och verifierbara verktygsanrop att avgöra om team anammar dem som assistenter eller behandlar dem som riskfyllda kuriositeter.

För närvarande omvandlar OpenAI:s anteckningar en del av mystiken kring kodningsagenter till konkreta reglage och spakar. Denna förskjutning gör det lättare för ingenjörsteam att planera utifrån kända avvägningar – prestanda, integritet och bräcklighet – snarare än att upptäcka dem den hårda vägen under driftstopp i produktionen.

Codex CLI:s dokumentation är en inbjudan: läs implementeringen, testa gränsfallen och designa arbetsflöden som accepterar begränsningarna samtidigt som de drar nytta av de tydliga fördelarna. I en bransch som tävlar om att föra in agenter i vardagliga utvecklarverktyg är tydlighet kring felscenarier den mest sällsynta och mest användbara varan.

Källor

- OpenAI (dokumentation: "Unrolling the Codex agent loop")

- Anthropic (Model Context Protocol-specifikation och Claude Code-material)

- OpenAI:s tekniska repositorier och implementeringsanteckningar för Codex CLI

Comments

No comments yet. Be the first!