Op 27 januari 2026 publiceerde OpenAI ongebruikelijk gedetailleerde technische notities waarin wordt uitgelegd hoe de Codex CLI—de command-line programmeeragent van het bedrijf—daadwerkelijk gesprekken voert, tools aanroept en context beheert.

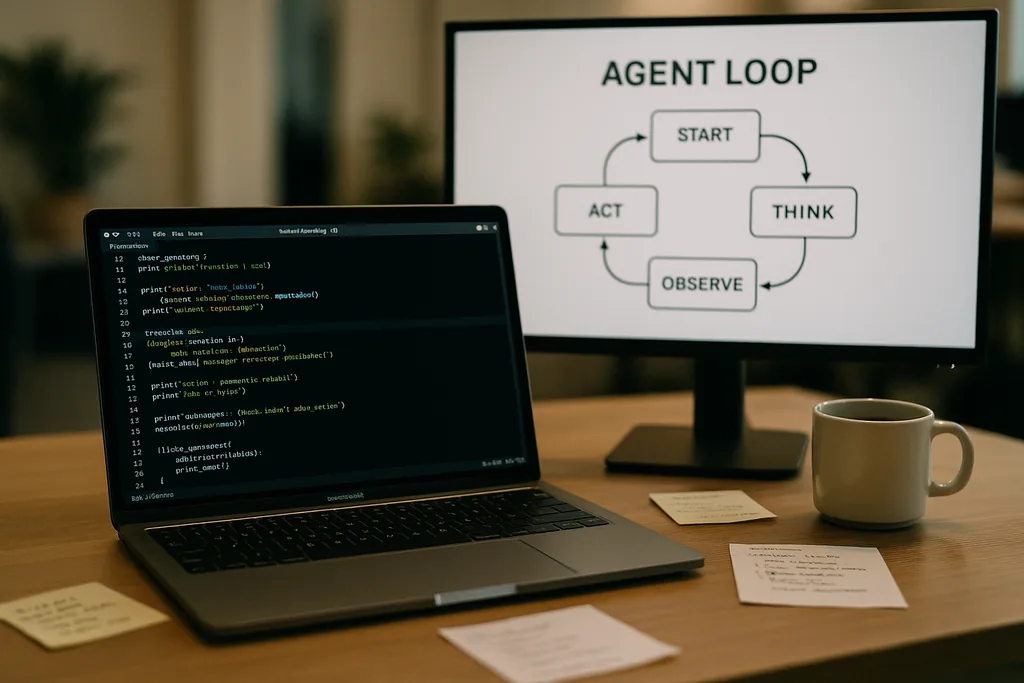

Hoe de agent-loop eruitziet

De kern van Codex CLI wordt gevormd door een eenvoudig herhalend patroon dat engineers de "agent-loop" noemen: accepteer gebruikersinvoer, stel een prompt op, vraag het model om een reactie, reageer op tool-calls die het model aanvraagt, voeg de tool-outputs toe aan het gesprek, en herhaal dit totdat het model een definitief bericht van de assistent teruggeeft.

Dat patroon klinkt eenvoudig, maar de documentatie belicht veel kleine ontwerpbeslissingen die samen de prestaties en betrouwbaarheid bepalen. De prompt die naar het model wordt gestuurd is geen enkel blok tekst; het is een gestructureerde samenstelling van geprioriteerde componenten. De rollen van systeem, developer, assistent en gebruiker bepalen welke instructies voorrang krijgen. Een tools-veld maakt de beschikbare functies bekend—lokale shell-commando's, planningshulpmiddelen, webzoekopdrachten en aangepaste diensten die worden ontsloten via Model Context Protocol (MCP) servers. De omgevingscontext beschrijft sandbox-machtigingen, werkmappen en welke bestanden of processen zichtbaar zijn voor de agent.

Tool-calls, MCP en sandboxing

Wanneer het model een tool-call genereert, voert Codex die tool uit in een gecontroleerde omgeving (de sandbox), legt de output vast en voegt het resultaat toe aan het gesprek. Aangepaste tools kunnen worden geïmplementeerd via MCP-servers—een open standaard die door verschillende bedrijven is omarmd—waarmee een model mogelijkheden kan ontdekken en aanroepen die verder gaan dan een eenvoudige shell. De documentatie bespreekt ook specifieke bugs die het team ontdekte tijdens het bouwen van deze integraties—bijvoorbeeld een inconsistente opsomming van MCP-tools—die moesten worden gepatcht.

OpenAI merkt op dat sandboxing en tool-toegang actieve onderwerpen zijn voor vervolgberichten. De initiële documentatie richt zich op de mechanica van de loop en het beperken van prestatieverlies, in plaats van op het volledige dreigingsmodel van agents met schrijftoegang tot een bestandssysteem of netwerkdiensten.

Stateless requests, privacykeuzes en de kosten van het kopiëren van context

Die toename is niet lineair. Elke beurt voegt tokens toe, en aangezien elke beurt de voorgaande beurten volledig bevat, neigt de prompt-omvang naar kwadratische groei ten opzichte van het aantal beurten. Het team documenteert dit expliciet en legt uit hoe ze dit beperken met contextcompactie en prompt-caching.

Prompt-caching en exacte prefixes

Prompt-caching is een pragmatische optimalisatie: als een nieuw verzoek een exact voorvoegsel (prefix) is van een eerder gecachte prompt, kan de provider berekeningen hergebruiken en sneller resultaten leveren. Maar caches vereisen striktheid. Elke wijziging aan beschikbare tools, een wisseling van model of zelfs een kleine aanpassing in de sandbox-configuratie kan de prefix ongeldig maken en een cache-hit veranderen in een kostbare misser. OpenAI-engineers waarschuwen dat ontwikkelaars herconfiguratie halverwege een gesprek moeten vermijden wanneer ze een consistente latentie nodig hebben.

Cache-hits zijn afhankelijk van exacte prefix-matching, dus verstandige praktijken zijn onder meer het vastzetten (pinnen) van tool-manifesten en het constant houden van de modelselectie binnen een lopende interactie. Wanneer cache-missers vaak voorkomen, degradeert het systeem naar volledige herverwerking bij elke aanroep—precies op het moment dat ontwikkelaars verwachten dat de agent vlot reageert.

Contextcompactie: het verleden comprimeren zonder betekenisverlies

Om de token-groei te beheersen, implementeert Codex automatische contextcompactie. In plaats van dit over te laten aan een gebruikerscommando, roept de CLI een gespecialiseerd API-endpoint aan dat oudere gesprekswendingen comprimeert tot een versleuteld inhoudsitem, terwijl de samengevatte kennis die het model nodig heeft om verder te gaan behouden blijft. Eerdere versies vereisten handmatige compactie door de gebruiker; de nieuwere aanpak verplaatst het proces naar een API-aanroep die het werkgeheugen van het model ontziet.

Compactie verlaagt de token-kosten, maar introduceert enkele subtiliteiten: samenvattingen moeten getrouw genoeg zijn om hallucinaties verderop in het proces te voorkomen, encryptie-instellingen moeten overeenkomen met privacybeperkingen, en compactie-heuristieken moeten beslissen welke delen van de status essentieel zijn versus wat gemist kan worden. De documentatie merkt deze aan als openstaande engineering-keuzes in plaats van definitieve ontwerpen.

Praktische beperkingen en de ervaring van ontwikkelaars

De notities van OpenAI zijn openhartig over sterke en zwakke punten. Voor eenvoudige taken—het soort scaffolding, boilerplate of snelle prototyping waar programmeeragents in uitblinken—is Codex snel en nuttig. Voor dieper, contextrijk technisch werk dat het model niet in zijn trainingsdata heeft gezien, is de agent fragiel. Het genereert dan veelbelovende structuren, maar loopt vervolgens vast of produceert onjuiste stappen die menselijke debugging vereisen.

Engineers die Codex intern testten, ontdekten dat de agent de initiële projectcreatie drastisch kan versnellen, maar nog niet de iteratieve, deskundige debugging kan vervangen die solide engineering vereist. Het team bevestigde ook dat ze Codex gebruiken om delen van Codex zelf te bouwen—een praktijk die interessante vragen oproept over feedbackloops bij tools die getraind zijn op hun eigen output.

Waarom OpenAI dit openbaar maakte—transparantie, concurrentie en standaarden

Het publiceren van een diepgaande analyse van de interne engineering van een consumentenproduct is opmerkelijk voor een bedrijf dat zijn operationele details doorgaans afschermt. De onthulling van OpenAI valt samen met een bredere beweging in het ecosysteem naar agent-standaarden: zowel Anthropic als OpenAI ondersteunen MCP voor het ontdekken en aanroepen van tools, en beide publiceren CLI-clients als open source, zodat ontwikkelaars het gedrag van begin tot eind kunnen inspecteren.

De transparantie dient verschillende doelgroepen. Ontwikkelaars krijgen implementatiepatronen en praktisch advies voor het bouwen van betrouwbare agents. Op veiligheid gerichte engineers kunnen de afwegingen rond sandboxing en tool-toegang kritisch bekijken. Concurrenten en de standaarden-gemeenschap kunnen sneller itereren omdat ze het gedrag van de client niet hoeven te reverse-engineeren om compatibiliteit te bereiken.

Operationeel advies voor teams die programmeeragents gebruiken

- Zet modellen en tool-manifesten vast binnen een sessie om prompt-cache-hits en stabiele prestaties te maximaliseren.

- Gebruik contextcompactie proactief bij lange taken om token-kosten te beheersen en ongebreidelde prompt-groei te voorkomen.

- Beperk de machtigingen van de agent en isoleer beschrijfbare mappen in sandboxes om onbedoelde of kwaadaardige bijwerkingen te verminderen.

- Houd rekening met en reserveer tijd voor handmatige debugging: agents versnellen scaffolding en iteratie, maar ze vervangen nog geen deskundig redeneren in complexe codebases.

Wat nu volgt

De engineer die het bericht schreef, kondigde vervolgartikelen aan die dieper zullen ingaan op de architectuur van de CLI, de implementatie van tools en het sandboxing-model. Die toekomstige bijdragen zullen van belang zijn: naarmate agents diepere toegang krijgen tot de omgevingen van ontwikkelaars, zullen de mechanica van veilige uitvoering, herkomst en verifieerbare tool-aanroepen bepalen of teams ze adopteren als assistenten of ze behandelen als risicovolle curiositeiten.

Voor nu zetten de notities van OpenAI een deel van de mystiek rond programmeeragents om in concrete knoppen en hendels. Die verschuiving maakt het voor engineering-teams gemakkelijker om te plannen rond bekende afwegingen—prestaties, privacy en fragiliteit—in plaats van ze op de harde manier te ontdekken tijdens storingen in productie.

De documentatie van de Codex CLI is een uitnodiging: lees de implementatie, test de randgevallen en ontwerp workflows die de beperkingen accepteren terwijl ze profiteren van de duidelijke voordelen. In een industrie die wedijvert om agents in alledaagse tools voor ontwikkelaars te integreren, is duidelijkheid over faalmodi het zeldzaamste en meest nuttige goed.

Bronnen

- OpenAI (documentatie: "Unrolling the Codex agent loop")

- Anthropic (Model Context Protocol specificatie en Claude Code materialen)

- OpenAI engineering repositories en Codex CLI implementatienotities

Comments

No comments yet. Be the first!