El 27 de enero de 2026, OpenAI publicó notas de ingeniería inusualmente detalladas que explican cómo Codex CLI —el agente de codificación por línea de comandos de la empresa— ejecuta realmente las conversaciones, llama a las herramientas y gestiona el contexto.

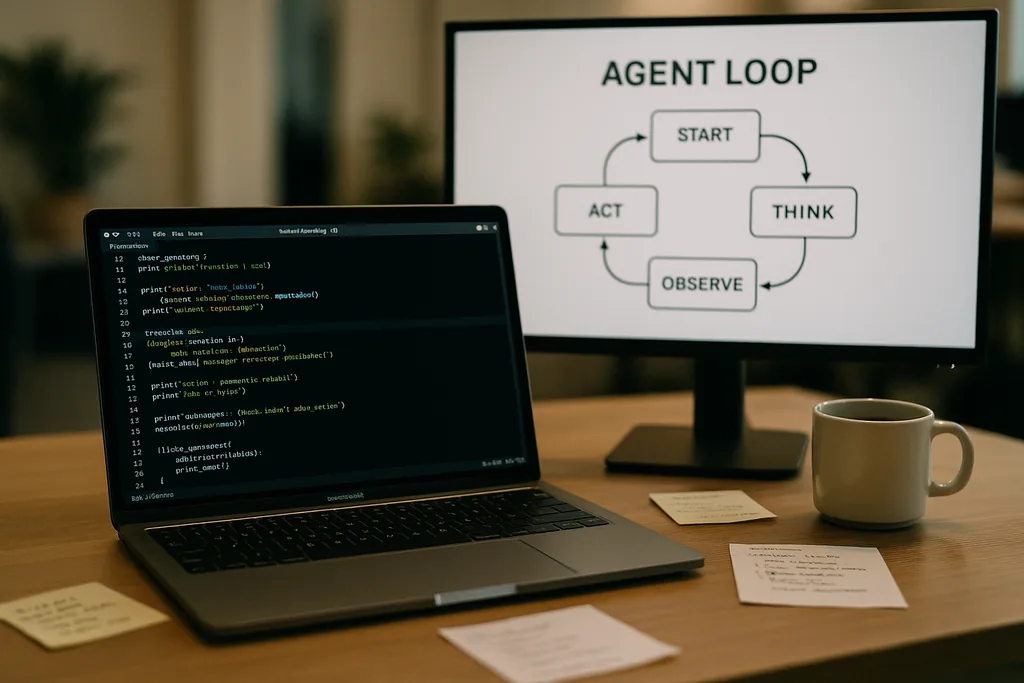

Cómo es el bucle del agente

En el corazón de Codex CLI se encuentra un patrón repetitivo simple que los ingenieros llaman el "bucle del agente": aceptar la entrada del usuario, elaborar un prompt, solicitar una respuesta al modelo, actuar según las llamadas a herramientas que el modelo solicite, añadir los resultados de las herramientas a la conversación y repetir hasta que el modelo devuelva un mensaje final del asistente.

Ese patrón suena sencillo, pero la documentación desglosa muchas pequeñas decisiones de diseño que, en conjunto, dan forma al rendimiento y la fiabilidad. El prompt enviado al modelo no es un bloque de texto único; es un ensamblaje estructurado de componentes priorizados. Los roles de sistema, desarrollador, asistente y usuario determinan qué instrucciones tienen prioridad. Un campo de herramientas (tools) anuncia las funciones disponibles: comandos de shell locales, utilidades de planificación, búsqueda web y servicios personalizados expuestos a través de servidores de Model Context Protocol (MCP). El contexto del entorno describe los permisos del sandbox, los directorios de trabajo y qué archivos o procesos son visibles para el agente.

Llamadas a herramientas, MCP y sandboxing

Cuando el modelo emite una llamada a una herramienta, Codex la ejecuta en un entorno controlado (su sandbox), captura la salida y añade el resultado a la conversación. Las herramientas personalizadas pueden implementarse a través de servidores MCP —un estándar abierto que varias empresas han adoptado—, que permiten a un modelo descubrir e invocar capacidades que van más allá de un simple shell. La documentación también analiza errores específicos que el equipo descubrió al crear estas integraciones —por ejemplo, una enumeración inconsistente de herramientas MCP— que tuvieron que ser corregidos.

OpenAI señala que el sandboxing y el acceso a herramientas son áreas activas para futuras publicaciones. La documentación inicial se centra en la mecánica del bucle y la mitigación del rendimiento, en lugar de en el modelo de amenazas completo de los agentes con acceso de escritura a un sistema de archivos o servicios de red.

Peticiones sin estado, opciones de privacidad y el coste de copiar el contexto

Esa inflación no es lineal. Cada turno añade tokens y, dado que cada turno incluye los turnos anteriores de forma íntegra, el tamaño del prompt tiende a un crecimiento cuadrático en relación con el número de turnos. El equipo documenta esto explícitamente y explica cómo lo mitigan mediante la compactación de contexto y el almacenamiento en caché de prompts.

Caché de prompts y prefijos exactos

La caché de prompts es una optimización pragmática: si una nueva petición es un prefijo exacto de un prompt almacenado previamente en caché, el proveedor puede reutilizar el procesamiento y devolver los resultados más rápido. Pero las cachés exigen rigidez. Cualquier cambio en las herramientas disponibles, un cambio de modelo o incluso un ajuste en la configuración del sandbox puede invalidar el prefijo y convertir un acierto de caché en un fallo costoso. Los ingenieros de OpenAI advierten que los desarrolladores deben evitar la reconfiguración a mitad de la conversación cuando necesiten una latencia constante.

Los aciertos de caché dependen de la coincidencia exacta del prefijo, por lo que las prácticas recomendadas incluyen fijar los manifiestos de herramientas y mantener constante la selección del modelo dentro de una interacción en curso. Cuando los fallos de caché ocurren con frecuencia, el sistema se degrada al reprocesamiento completo en cada llamada, precisamente cuando los desarrolladores esperan que el agente se sienta ágil.

Compactación de contexto: comprimir el pasado sin perder el significado

Para gestionar el crecimiento de tokens, Codex implementa una compactación automática del contexto. En lugar de dejarlo a un comando del usuario, la interfaz de línea de comandos (CLI) llama a un punto de conexión de API especializado que comprime los turnos de conversación más antiguos en un elemento de contenido cifrado, manteniendo al mismo tiempo el conocimiento resumido que el modelo necesita para continuar. Las versiones anteriores requerían la compactación manual por parte del usuario; el nuevo enfoque traslada el proceso a una llamada de API que preserva la memoria de trabajo del modelo.

La compactación reduce el coste de los tokens pero introduce algunos matices: los resúmenes deben ser lo suficientemente fieles como para evitar alucinaciones posteriores, las propiedades de cifrado deben ajustarse a las restricciones de privacidad y las heurísticas de compactación deben decidir qué piezas del estado son esenciales frente a las prescindibles. La documentación señala estos puntos como decisiones de ingeniería abiertas en lugar de diseños definitivos.

Límites prácticos y experiencia del desarrollador

Las notas de OpenAI son sinceras sobre las fortalezas y debilidades. Para tareas sencillas —el tipo de andamiaje, código repetitivo (boilerplate) o prototipado rápido en el que destacan los agentes de codificación— Codex es rápido y útil. Para trabajos de ingeniería más profundos y con gran carga de contexto que el modelo no ha visto en sus datos de entrenamiento, el agente es frágil. Generará estructuras prometedoras, pero luego se detendrá o producirá pasos incorrectos que requieren depuración humana.

Los ingenieros que probaron Codex internamente descubrieron que el agente puede acelerar drásticamente la creación inicial de proyectos, pero aún no puede reemplazar la depuración experta e iterativa que requiere una ingeniería sólida. El equipo también confirmó que utilizan Codex para construir partes del propio Codex, una práctica que plantea preguntas interesantes sobre el feedback de las herramientas entrenadas en sus propios resultados.

Por qué OpenAI ha abierto esto: transparencia, competencia y estándares

Publicar una inmersión profunda en la ingeniería interna de un producto de consumo es notable viniendo de una empresa que habitualmente ha guardado con celo sus detalles operativos. La revelación de OpenAI coincide con un impulso más amplio del ecosistema hacia los estándares de agentes: Anthropic y OpenAI admiten MCP para el descubrimiento e invocación de herramientas, y ambos publican clientes CLI como código abierto para que los desarrolladores puedan inspeccionar el comportamiento de extremo a extremo.

La transparencia sirve a varios públicos. Los desarrolladores obtienen patrones de implementación y consejos prácticos para construir agentes fiables. Los ingenieros centrados en la seguridad pueden examinar los pros y contras del sandbox y el acceso a herramientas. Los competidores y la comunidad de estándares pueden iterar más rápido porque no necesitan aplicar ingeniería inversa al comportamiento del cliente para lograr la interoperabilidad.

Consejos operativos para equipos que utilizan agentes de codificación

- Fijar los modelos y los manifiestos de herramientas dentro de una sesión para maximizar los aciertos en la caché de prompts y lograr un rendimiento estable.

- Utilizar la compactación de contexto de forma proactiva para tareas largas, con el fin de controlar los costes de tokens y evitar el crecimiento descontrolado del prompt.

- Limitar los permisos del agente e aislar las carpetas con permisos de escritura en sandboxes para reducir efectos secundarios accidentales o maliciosos.

- Prever y presupuestar tiempo para la depuración manual: los agentes aceleran el andamiaje y la iteración, pero aún no reemplazan el razonamiento experto en bases de código complejas.

Qué sigue

El ingeniero que escribió el post señaló futuras entregas que cubrirán la arquitectura de la CLI con más profundidad, la implementación de herramientas y el modelo de sandboxing. Esas futuras entradas serán importantes: a medida que los agentes obtienen un acceso más profundo a los entornos de los desarrolladores, la mecánica de la ejecución segura, la procedencia y la invocación verificable de herramientas determinarán si los equipos los adoptan como asistentes o los tratan como curiosidades arriesgadas.

Por ahora, las notas de OpenAI convierten parte del misticismo que rodea a los agentes de codificación en mandos y palancas concretos. Ese cambio facilita que los equipos de ingeniería planifiquen en función de los compromisos conocidos —rendimiento, privacidad y fragilidad— en lugar de descubrirlos por las malas durante interrupciones en la producción.

La documentación de Codex CLI es una invitación: leer la implementación, probar los casos límite y diseñar flujos de trabajo que acepten los límites mientras aprovechan los claros beneficios. En una industria que compite por poner agentes en las herramientas diarias de los desarrolladores, la claridad sobre los modos de fallo es el producto más raro y útil.

Fuentes

- OpenAI (documentación: "Unrolling the Codex agent loop")

- Anthropic (especificación de Model Context Protocol y materiales de Claude Code)

- Repositorios de ingeniería de OpenAI y notas de implementación de Codex CLI

Comments

No comments yet. Be the first!