方程式の内部に潜む未知の領域を学習するニューラルネットワーク

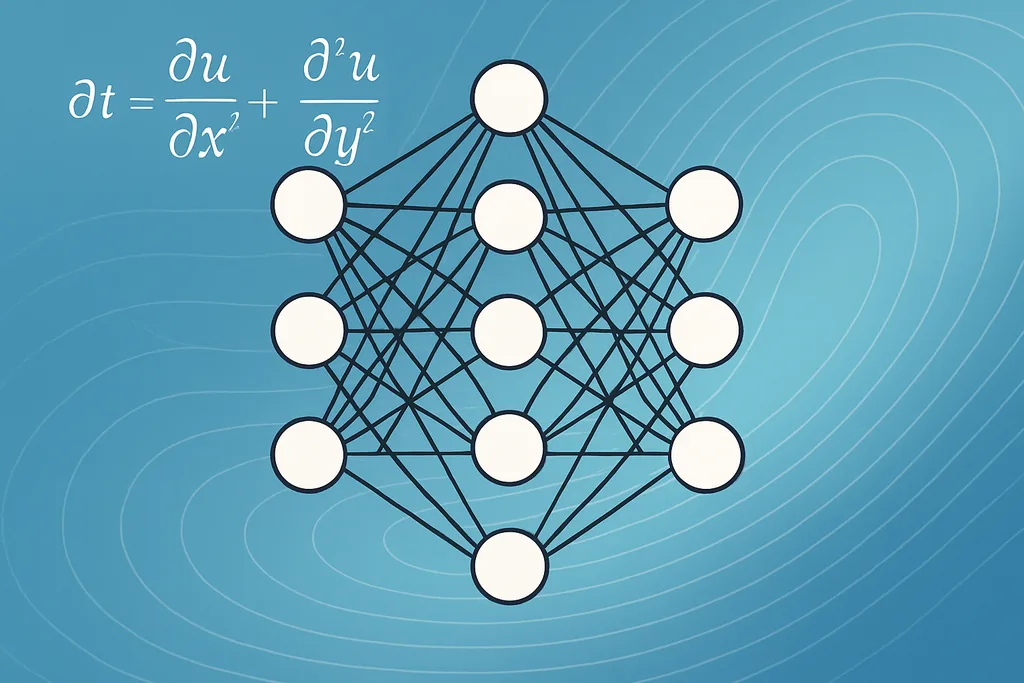

今週、数学者とエンジニアのグループが、熱、流体、個体群などを記述するために用いられる数学的な主力ツールである偏微分方程式(PDE)の内部に存在する未知の関数を、機械学習によって正確に復元する方法を発表した。オックスフォード大学の研究者を中心とし、カナダの共同研究者らも加わったこのチームは、ニューラルネットワークを未知の空間関数の代理としてPDEに直接埋め込み、観測された定常状態データに基づいてシステム全体を学習させる。その結果得られるのは、単に適合された数値やパラメータではなく、PDEが成立する場所であればどこでもモデルが評価できる関数であり、不完全な方程式を実行可能な予測モデルへと変容させる。

この進展は、長年の課題であった逆問題に取り組むものである。現実世界の多くのPDEには、環境刺激、個体群モデルにおける空間的に変化する相互作用核、あるいは流場の不均一性など、直接測定できない項が含まれており、これらの観測不可能な関数が予測を困難にしている。ニューラルネットワークを欠落した要素の代役とし、順モデルの出力が観測状態と一致するように最適化することで、研究者らはノイズの多い測定値の微分といった、従来のアプローチで一般的だった不安定なステップを回避している。彼らの損失関数は不動点残差を最小化するものであり、実質的に順モデルの数値計算された定常状態をデータに一致させるよう強制する。これにより、学習が安定し、過度なデータ前処理の必要性が軽減される。

機械学習がPDEに埋め込まれた関数を正確に復元する仕組み

核となる技術的な工夫は、考え方は単純だが実践においては繊細である。チームは、少数のスカラー係数を調整するのではなく、未知の空間項を調整可能な重みを持つニューラルネットワークとして表現した。PDEソルバーとネットワークは結合されており、ソルバーは候補関数を定常状態の解へと写像し、学習ループはPDEの解が測定値と一致するようにネットワークを微調整する。これは、物理的制約をゼロから学習させるのではなく、アーキテクチャに組み込む「物理情報を付加した学習(physics-informed learning)」と呼ばれる広範な手法の一例である。

実用的には、彼らが使用する最適化ターゲット(不動点残差ノルム)は、順モデルの平衡状態において正確にゼロになる。これが重要なのは、逆問題における不安定性の一般的な原因である、ノイズの多い観測データの数値微分を避けることができるからだ。また、この手順は疎で不規則にサンプリングされた測定値とも互換性がある。チームは、観測値が基礎となる関数が解に与える影響について十分に情報を持っていれば、驚くほど少ないデータで復元が可能であることを示している。このアイデアの変種はすでに他の分野でも現れており、貯留層流体シミュレーションにはハイブリッド量子・古典物理情報ニューラルネットワークが提案されており、微分可能なアルゴリズムモデルは組合せ問題に保証とスケールをもたらしている。これらの進展に共通するテーマは、ブラックボックスモデルを自由に彷徨わせるのではなく、物理学やアルゴリズムの構造を利用して学習を導くことにある。

機械学習の観点から言えば、これは演算子全体の記号回帰ではなく、関数レベルでの方程式発見である。ニューラルネットワークは万能近似器として機能する。十分な能力と適切な帰納バイアスが与えられれば、本来なら個別のパラメータ化が必要な未知の滑らかな関数を表現できる。学習によって、「どのランドスケープをPDEに組み込めば、観測されたデータが生成されるか?」を問うことで、それらの関数を抽出する。記号的な抽出が必要な場合、研究者は関数の復元に続いてモデル圧縮や疎回帰のステップを行い、人間が読める数式を生成することもできるが、新しい地点で評価可能な実行関数という直接的な出力自体、すでに価値のある科学的成果物である。

機械学習による正確な復元の限界 — 識別可能性、ノイズ、データ設計

有望な手法ではあるが、明確な境界も存在する。チームは、ノイズのない正確なシミュレーションでの成功を示した後、現実的な不完全性によってパフォーマンスがどのように低下するかを調査した。特に、構造的識別可能性と測定ノイズという2つの問題が浮き彫りになった。構造的識別可能性とは、PDEとデータのペアが持つ解析的な特性であり、一部の関数は、観測される出力に変化を与えないため、特定の観測セットからは一意に決定できない。研究者らは、単一の定常状態のスナップショットでは不十分な場合が多く、逆問題を制約するには、通常、少なくとも2つの独立した解、あるいは異なるシステム応答を探る摂動が必要であると強調している。

ノイズと疎なサンプリングは問題をさらに複雑にする。多くの数値実験において、疎なサンプリング条件下でも復元は可能であったが、観測ノイズが増えるにつれて精度は低下した。感度は問題によって異なり、測定誤差を予測可能な形で増幅させるPDEもあれば、平均化するPDEもある。つまり、実際に運用する際には、実験設計に細心の注意を払う必要がある。どこでいつサンプリングするか、どのようにして複数の情報豊かな解を生成するか、そしてネットワークが信号ではなくノイズに適合するのを防ぐために、どの正則化項を学習に含めるかといった点だ。

信頼性は重層的な問題である。機械学習は、未知の関数が観測可能な解に痕跡を残しており、学習プロトコルが正しい物理的制約をエンコードしており、データサンプルが代替案を排除するのに十分なほど解多様体を網羅しているという3つの要素が揃ったとき、隠れた関数を正確に復元する。これらの条件が満たされない場合、復元された関数は、もっともらしく見えても誤っている可能性がある。本研究における失敗モードの体系的な調査は、漠然とした警告を実務者が利用できるテスト可能な診断ツールへと変換しているという点で、まさに有用である。

手法、ツール、および補完的なアプローチ

この論文は、拡大を続ける方程式発見手法のツールボックスの一部をなすものである。物理情報ニューラルネットワーク(PINN)とその量子・古典ハイブリッドはその一族であり、微分演算子を損失関数に組み込むことで、支配的なPDEは既知だが一部の項が未知である場合に特に威力を発揮する。メッセージパッシング・グラフニューラルネットワークは、材料やネットワーク化された生態系などの離散構造を持つ問題に対して異なる角度からアプローチし、アルゴリズム的な保証を継承するように設計できる。記号回帰技術(疎回帰、基底追跡、その他の簡潔なモデル発見手法)は、数値的な代理モデルではなく、解釈可能な解析式を目的とする場合に依然として価値がある。

学習された関数からの記号式の抽出は、活発な研究分野である。実務家はしばしば2段階のパイプラインを使用する。まずデータに適合する柔軟なニューラルサロゲートを学習し、次にそのサロゲートに疎なフィッティングやプルーニングを施して、コンパクトな解析形式を抽出するという流れだ。このハイブリッドなワークフローは、ノイズや複雑さを処理するニューラルネットワークの柔軟性と、科学者が分析・検証できる記号モデルの解釈可能性という、両者の長所を組み合わせたものである。

生態学、材料学、流体力学への応用

これが重要である理由は、機械学習がモデルの目に見えない部分を正確に復元できれば、記述的なスナップショットを予測ツールに変換できるからである。生態学において、未知の関数は環境場や個体群の凝集を形成する相互作用核である可能性があり、それを復元することで、管理者は新しい条件下での種の分布を予測できるようになる。材料学や凝縮系モデルでは、可変伝導率のような空間的不均一性がマクロな挙動を決定する未知数であることが多く、復元された関数は設計や制御に直接的な入力を提供する。このアプローチは、計算コストを削減しつつ物理的な忠実度を維持するためにハイブリッド量子・古典PINNが提案されている貯留層工学の分野とも補完し合うものである。

これらの領域全体を通じて、本手法はデータ収集とモデル運用の間の摩擦を軽減する。物理学を一から構築し直したり、現象論的な項を過学習させたりする代わりに、科学者は構造をガイドとして学習を進め、利用可能で評価可能なモデルを得ることができる。実用的な利益は、実験者がこの手法に必要とされる複数の情報豊かなシステム応答をいかに生成できるか、そして現実的なノイズやモデリング誤差に対して学習を堅牢にするための継続的な取り組みにかかっている。

Sources

- ArXiv (preprint: Learning functional components of PDEs from data using neural networks)

- Mathematical Institute, University of Oxford (Torkel E. Loman, Jose A. Carrillo, Ruth E. Baker)

- Department of Mathematics, Physics and Geology, Cape Breton University

- Department of Engineering, University of Oxford

- Yangtze University; King Abdullah University of Technology (Quantum‑Classical PINN reservoir simulation work)

- RWTH Aachen University; TU Munich; MIT; University of Cologne (graph neural network approaches to algorithmic problems)

Comments

No comments yet. Be the first!