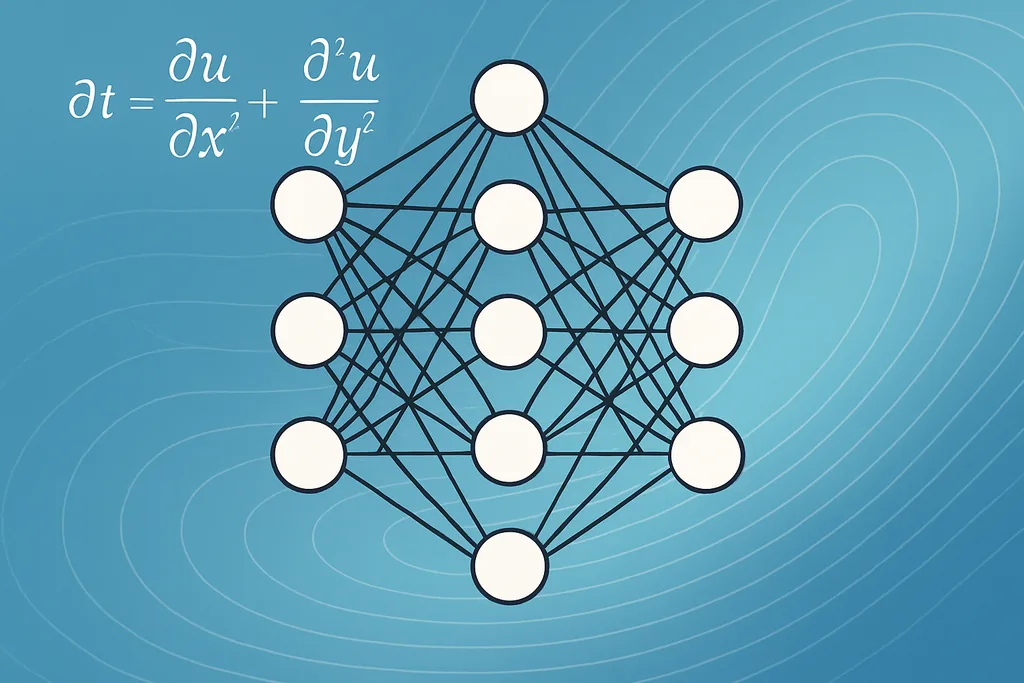

Reti neurali che apprendono i paesaggi invisibili all'interno delle equazioni

Questa settimana un gruppo di matematici e ingegneri ha pubblicato un metodo che mostra come il machine learning recuperi con precisione funzioni ignote che risiedono all'interno di equazioni differenziali alle derivate parziali — i pilastri matematici usati per descrivere calore, fluidi, popolazioni e altro ancora. Il team, con il contributo principale di ricercatori dell'Università di Oxford e collaboratori in Canada, integra una rete neurale direttamente nell'EDP come surrogato della funzione spaziale ignota e addestra l'intero sistema su dati di stato stazionario osservati. Il risultato non è solo un numero o un parametro adattato: è una funzione che il modello può valutare ovunque l'EDP abbia senso, trasformando equazioni incomplete in modelli predittivi funzionanti.

L'avanzamento affronta un problema inverso di lunga data. Molte EDP del mondo reale contengono termini che non possiamo misurare direttamente — uno stimolo ambientale, un kernel di interazione spazialmente variabile in un modello di popolazione o una eterogeneità in un campo di flusso — e queste funzioni non osservate compromettono le previsioni. Consentendo a una rete neurale di sostituire il pezzo mancante e ottimizzando il modo in cui l'output del modello in avanti (forward) corrisponde agli stati osservati, i ricercatori superano alcuni dei passaggi fragili comuni negli approcci precedenti, come la differenziazione di misurazioni rumorose. La loro funzione di perdita minimizza un residuo di punto fisso — forzando efficacemente lo stato stazionario calcolato numericamente del modello forward a corrispondere ai dati — stabilizzando l'addestramento e riducendo la necessità di una pesante pre-elaborazione dei dati.

Come il machine learning recupera con precisione le funzioni incorporate nelle EDP

Il trucco tecnico fondamentale è semplice nell'idea e delicato nella pratica. Invece di regolare una manciata di coefficienti scalari, il team rappresenta il termine spaziale ignoto come una rete neurale con pesi regolabili. Il risolutore EDP e la rete sono accoppiati: il risolutore mappa una funzione candidata a una soluzione di stato stazionario, e il ciclo di addestramento orienta la rete affinché la soluzione dell'EDP si allinei con le misurazioni. Questo è un esempio di una famiglia più ampia di metodi noti come physics-informed learning, dove i vincoli fisici sono integrati nell'architettura invece di essere appresi puramente da zero.

Praticamente, l'obiettivo di ottimizzazione che utilizzano — la norma del residuo di punto fisso — si annulla esattamente per gli equilibri del modello forward. Ciò è importante perché evita di calcolare derivate numeriche di dati osservativi rumorosi, una fonte comune di instabilità nei problemi inversi. Rende inoltre la procedura compatibile con misurazioni sparse e campionate irregolarmente: il team dimostra che il recupero funziona con una quantità di dati sorprendentemente ridotta, a condizione che le osservazioni siano sufficientemente informative sull'effetto della funzione sottostante sulla soluzione. Varianti di questa idea stanno già apparendo in altri campi: sono state proposte reti neurali physics-informed ibride quantistico-classiche per simulazioni di flusso nei giacimenti, mentre i modelli algoritmici differenziabili apportano garanzie e scalabilità ai problemi combinatori. Questi sviluppi condividono lo stesso tema: usare la struttura della fisica o dell'algoritmo per guidare l'apprendimento, invece di lasciare che i modelli black-box vaghino liberamente.

Dal punto di vista del machine learning, questa è una scoperta di equazioni a livello funzionale piuttosto che una regressione simbolica di interi operatori. Le reti neurali agiscono come approssimatori universali: data una capacità sufficiente e il giusto bias induttivo, possono rappresentare funzioni ignote lisce che altrimenti richiederebbero parametrizzazioni su misura. L'addestramento estrae queste funzioni chiedendosi: quale paesaggio, se inserito nell'EDP, produce i dati che osserviamo? Laddove sia necessaria l'estrazione simbolica, i ricercatori possono far seguire al recupero funzionale un passaggio di compressione del modello o di regressione sparsa per produrre espressioni leggibili dall'uomo, ma l'output immediato — una funzione funzionante valutabile in nuovi punti — è già un prezioso risultato scientifico.

I limiti del recupero accurato tramite machine learning: identificabilità, rumore e progettazione dei dati

Nonostante le promesse, il metodo presenta confini chiari. Il team dimostra il successo con simulazioni esatte e prive di rumore e poi esplora come le prestazioni degradino con imperfezioni realistiche. Emergono due problemi: l'identificabilità strutturale e il rumore di misurazione. L'identificabilità strutturale è una proprietà analitica della coppia EDP-dati: alcune funzioni non possono essere determinate in modo univoco da un dato insieme di osservazioni perché lasciano invariati gli output osservati. I ricercatori sottolineano che una singola istantanea dello stato stazionario è spesso insufficiente; normalmente sono necessarie almeno due soluzioni indipendenti, o perturbazioni che sollecitino diverse risposte del sistema, per vincolare il problema inverso.

Il rumore e il campionamento sparso complicano ulteriormente le cose. Il recupero rimane praticabile sotto campionamento sparso in molti dei loro test sintetici, ma la precisione cala all'aumentare del rumore di osservazione. La sensibilità varia a seconda del problema: alcune EDP amplificano gli errori di misurazione in modi prevedibili, mentre altre li mediano. Ciò significa che le implementazioni pratiche devono prestare molta attenzione alla progettazione sperimentale: dove e quando campionare, come generare molteplici soluzioni informative e quali termini di regolarizzazione includere nell'addestramento per impedire alla rete di adattarsi al rumore anziché al segnale.

L'affidabilità è una questione complessa. Il machine learning recupera accuratamente le funzioni nascoste quando tre ingredienti si allineano: la funzione ignota ha un'impronta sulla soluzione osservabile, il protocollo di addestramento codifica i corretti vincoli fisici e il campione di dati copre una porzione sufficiente della varietà delle soluzioni per escludere spiegazioni alternative. Quando queste condizioni vengono meno, le funzioni recuperate possono essere ingannevolmente plausibili ma errate. L'esplorazione sistematica delle modalità di fallimento dello studio è utile proprio perché converte avvertimenti vaghi in diagnostiche verificabili per i professionisti.

Tecniche, strumenti e approcci complementari

L'articolo si inserisce in una cassetta degli attrezzi in crescita di metodi per la scoperta di equazioni. Le reti neurali physics-informed (PINN) e i loro ibridi quantistico-classici sono una famiglia: incorporano operatori differenziali nella perdita e sono particolarmente interessanti quando l'EDP regolatrice è nota ma alcuni termini non lo sono. Le reti neurali grafiche message-passing offrono un angolo diverso per problemi con strutture discrete, ad esempio nei materiali o nei sistemi ecologici a rete, e possono essere progettate per ereditare garanzie algoritmiche. Le tecniche di regressione simbolica — regressione sparsa, basis pursuit e altri metodi di scoperta di modelli parsimoniosi — rimangono preziose quando l'obiettivo è un'espressione analitica interpretabile piuttosto che un surrogato numerico.

L'estrazione di espressioni simboliche dalla funzione appresa è un'area di ricerca attiva. I professionisti utilizzano spesso una pipeline a due stadi: prima apprendono un surrogato neurale flessibile che si adatta ai dati, poi post-elaborano quel surrogato con un passaggio di adattamento sparso o potatura (pruning) per distillare una forma analitica compatta. Quel flusso di lavoro ibrido combina il meglio di entrambi i mondi: la flessibilità delle reti neurali nel gestire rumore e complessità, e l'interpretabilità dei modelli simbolici che gli scienziati possono analizzare e convalidare.

Applicazioni tra ecologia, materiali e meccanica dei fluidi

Perché questo è importante: se il machine learning recupera con precisione le parti invisibili di un modello, è possibile convertire istantanee descrittive in strumenti predittivi. In ecologia, la funzione ignota potrebbe essere un campo ambientale o un kernel di interazione che modella l'aggregazione della popolazione; recuperarla consente ai gestori di prevedere la distribuzione delle specie in nuove condizioni. Nei modelli dei materiali e della materia condensata, le eterogeneità spaziali come la conduttività variabile sono spesso le incognite che determinano il comportamento macroscopico, e una funzione recuperata fornisce un input diretto per la progettazione e il controllo. L'approccio integra anche il lavoro nell'ingegneria dei giacimenti dove sono state proposte PINN ibride quantistico-classiche per ridurre i costi computazionali mantenendo la fedeltà fisica nella risoluzione delle EDP di flusso.

In questi domini, il metodo riduce l'attrito tra la raccolta dei dati e l'implementazione del modello. Invece di ricostruire la fisica da zero o sovradimensionare (overfitting) termini fenomenologici, gli scienziati possono lasciare che la struttura guidi l'apprendimento e ottenere comunque modelli utilizzabili e valutabili. I guadagni pratici dipenderanno da quanto bene gli sperimentatori sapranno generare le molteplici risposte informative del sistema necessarie al metodo e dal lavoro continuo per rendere l'addestramento robusto al rumore realistico e all'errore di modellazione.

Fonti

- ArXiv (preprint: Learning functional components of PDEs from data using neural networks)

- Mathematical Institute, University of Oxford (Torkel E. Loman, Jose A. Carrillo, Ruth E. Baker)

- Department of Mathematics, Physics and Geology, Cape Breton University

- Department of Engineering, University of Oxford

- Yangtze University; King Abdullah University of Technology (lavoro sulla simulazione di giacimenti con PINN quantistico-classiche)

- RWTH Aachen University; TU Munich; MIT; University of Cologne (approcci con reti neurali grafiche a problemi algoritmici)

Comments

No comments yet. Be the first!