Des réseaux de neurones qui apprennent les paysages invisibles au cœur des équations

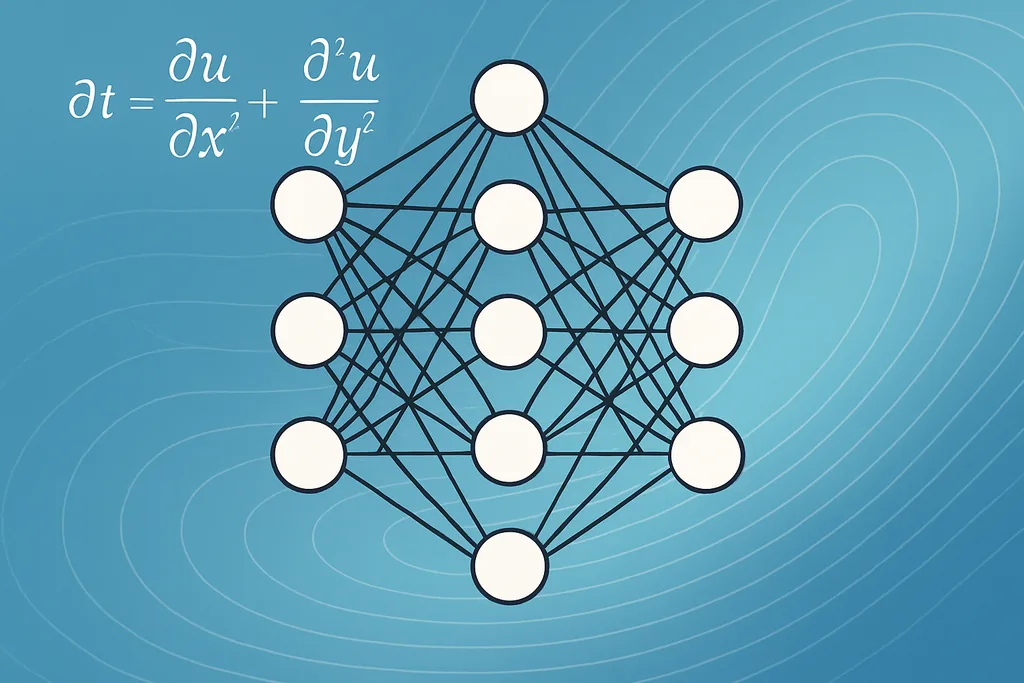

Cette semaine, un groupe de mathématiciens et d'ingénieurs a publié une méthode montrant comment l'apprentissage automatique récupère avec précision des fonctions inconnues situées au sein d'équations aux dérivées partielles — les piliers mathématiques utilisés pour décrire la chaleur, les fluides, les populations et bien plus encore. L'équipe, avec des contributions majeures de chercheurs de l'University of Oxford et de collaborateurs au Canada, intègre un réseau de neurones directement dans l'EDP en tant que substitut de la fonction spatiale inconnue et entraîne l'ensemble du système à partir de données d'état stationnaire observées. Le résultat n'est pas seulement un nombre ou un paramètre ajusté : c'est une fonction que le modèle peut évaluer partout où l'EDP est pertinente, transformant des équations incomplètes en modèles prédictifs opérationnels.

Cette avancée s'attaque à un problème inverse de longue date. De nombreuses EDP du monde réel contiennent des termes que nous ne pouvons pas mesurer directement — un stimulus environnemental, un noyau d'interaction variant spatialement dans un modèle de population, ou une hétérogénéité dans un champ d'écoulement — et ces fonctions non observées paralysent les prévisions. En laissant un réseau de neurones remplacer la pièce manquante et en optimisant la correspondance entre la sortie du modèle direct et les états observés, les chercheurs contournent certaines étapes fragiles communes aux approches précédentes, comme la différenciation de mesures bruitées. Leur fonction de perte minimise un résidu de point fixe — forçant ainsi l'état stationnaire calculé numériquement du modèle direct à correspondre aux données — ce qui stabilise l'entraînement et réduit la nécessité d'un prétraitement lourd des données.

Comment l'apprentissage automatique récupère avec précision des fonctions intégrées dans les EDP

L'astuce technique centrale est simple dans l'idée mais délicate en pratique. Plutôt que d'ajuster une poignée de coefficients scalaires, l'équipe représente le terme spatial inconnu sous la forme d'un réseau de neurones aux poids ajustables. Le solveur d'EDP et le réseau sont couplés : le solveur associe une fonction candidate à une solution d'état stationnaire, et la boucle d'entraînement ajuste le réseau de sorte que la solution de l'EDP s'aligne sur les mesures. C'est un exemple d'une famille plus large de méthodes connues sous le nom d'apprentissage informé par la physique, où des contraintes physiques sont intégrées à l'architecture plutôt que d'être apprises de zéro.

Pratiquement, la cible d'optimisation qu'ils utilisent — la norme du résidu de point fixe — s'annule exactement pour les équilibres du modèle direct. Cela est crucial car cela évite de calculer les dérivées numériques de données d'observation bruitées, une source courante d'instabilité dans les problèmes inverses. Cela rend également la procédure compatible avec des mesures éparses et échantillonnées de manière irrégulière : l'équipe montre que la récupération fonctionne avec étonnamment peu de données, à condition que les observations soient suffisamment informatives sur l'effet de la fonction sous-jacente sur la solution. Des variantes de cette idée apparaissent déjà dans d'autres domaines : des réseaux de neurones hybrides quantiques-classiques informés par la physique ont été proposés pour les simulations d'écoulement de réservoir, tandis que des modèles algorithmiques différentiables apportent des garanties et de l'échelle aux problèmes combinatoires. Ces développements partagent le même thème — utiliser la structure de la physique ou de l'algorithme pour guider l'apprentissage, plutôt que de laisser des modèles « boîte noire » errer librement.

D'un point de vue de l'apprentissage automatique, il s'agit d'une découverte d'équations au niveau fonctionnel plutôt que d'une régression symbolique d'opérateurs entiers. Les réseaux de neurones agissent comme des approximateurs universels : dotés d'une capacité suffisante et du bon biais inductif, ils peuvent représenter des fonctions inconnues lisses qui nécessiteraient autrement des paramétrages sur mesure. L'entraînement extrait ces fonctions en posant la question suivante : quel paysage, lorsqu'il est injecté dans l'EDP, produit les données que nous observons ? Lorsqu'une extraction symbolique est nécessaire, les chercheurs peuvent faire suivre la récupération fonctionnelle d'une étape de compression de modèle ou de régression éparse pour produire des expressions lisibles par l'homme, mais le résultat immédiat — une fonction opérationnelle que l'on peut évaluer en de nouveaux points — constitue déjà un livrable scientifique précieux.

Limites de la récupération par apprentissage automatique — identifiabilité, bruit et conception des données

Malgré les promesses, la méthode présente des limites claires. L'équipe démontre le succès avec des simulations exactes et sans bruit, puis explore comment les performances se dégradent avec des imperfections réalistes. Deux problèmes se distinguent : l'identifiabilité structurelle et le bruit de mesure. L'identifiabilité structurelle est une propriété analytique du couple EDP-données : certaines fonctions ne peuvent pas être déterminées de manière unique à partir d'un ensemble donné d'observations car elles laissent les sorties observées inchangées. Les chercheurs soulignent qu'un seul instantané d'état stationnaire est souvent insuffisant ; au moins deux solutions indépendantes, ou des perturbations sondant différentes réponses du système, sont normalement requises pour contraindre le problème inverse.

Le bruit et l'échantillonnage épars compliquent davantage les choses. La récupération reste viable sous un échantillonnage épars dans nombre de leurs tests synthétiques, mais la précision chute à mesure que le bruit d'observation augmente. La sensibilité varie selon le problème : certaines EDP amplifient les erreurs de mesure de manière prévisible, tandis que d'autres les lissent. Cela signifie que les déploiements pratiques doivent accorder une attention particulière à la conception expérimentale : où et quand échantillonner, comment générer plusieurs solutions informatives, et quels termes de régularisation inclure dans l'entraînement pour empêcher le réseau de s'ajuster au bruit plutôt qu'au signal.

La fiabilité est une question à plusieurs niveaux. L'apprentissage automatique récupère avec précision les fonctions cachées lorsque trois ingrédients s'alignent : la fonction inconnue a une empreinte sur la solution observable, le protocole d'entraînement encode les bonnes contraintes physiques, et l'échantillon de données couvre une part suffisante de la variété des solutions pour écarter les explications alternatives. Lorsque ces conditions ne sont pas remplies, les fonctions récupérées peuvent être trompeusement plausibles mais fausses. L'exploration systématique des modes de défaillance de l'étude est utile précisément parce qu'elle convertit des avertissements vagues en diagnostics testables pour les praticiens.

Techniques, outils et approches complémentaires

L'article s'inscrit dans une boîte à outils croissante de méthodes de découverte d'équations. Les réseaux de neurones informés par la physique (PINN) et leurs hybrides quantiques-classiques constituent une famille : ils intègrent des opérateurs différentiels dans la perte et sont particulièrement attrayants lorsque l'EDP régissante est connue mais que certains termes ne le sont pas. Les réseaux de neurones de graphes par passage de messages offrent un angle différent pour les problèmes à structures discrètes, par exemple dans les matériaux ou les systèmes écologiques en réseau, et peuvent être conçus pour hériter de garanties algorithmiques. Les techniques de régression symbolique — régression éparse, poursuite de base et autres méthodes de découverte de modèles parcimonieux — restent précieuses lorsque l'objectif est une expression analytique interprétable plutôt qu'un substitut numérique.

L'extraction d'expressions symboliques à partir de la fonction apprise est un domaine de recherche actif. Les praticiens utilisent souvent un pipeline en deux étapes : apprendre d'abord un substitut neuronal flexible qui s'ajuste aux données, puis post-traiter ce substitut avec une étape d'ajustement éparse ou d'élagage pour distiller une forme analytique compacte. Ce flux de travail hybride combine le meilleur des deux mondes — la flexibilité des réseaux de neurones pour gérer le bruit et la complexité, et l'interprétabilité des modèles symboliques que les scientifiques peuvent analyser et valider.

Applications en écologie, matériaux et mécanique des fluides

Pourquoi cela est important : si l'apprentissage automatique récupère avec précision les éléments invisibles d'un modèle, vous pouvez convertir des instantanés descriptifs en outils prédictifs. En écologie, la fonction inconnue pourrait être un champ environnemental ou un noyau d'interaction qui façonne l'agrégation de la population ; sa récupération permet aux gestionnaires de prévoir la distribution des espèces dans de nouvelles conditions. Dans les modèles de matériaux et de physique de la matière condensée, les hétérogénéités spatiales telles que la conductivité variable sont fréquemment les inconnues qui déterminent le comportement macroscopique, et une fonction récupérée fournit une donnée d'entrée directe pour la conception et le contrôle. L'approche complète également les travaux en ingénierie de réservoir où des PINN hybrides quantiques-classiques ont été proposés pour réduire le coût de calcul tout en conservant la fidélité physique lors de la résolution d'EDP d'écoulement.

Dans tous ces domaines, la méthode réduit la friction entre la collecte de données et le déploiement de modèles. Au lieu de reconstruire la physique à partir de zéro ou de surajuster des termes phénoménologiques, les scientifiques peuvent laisser la structure guider l'apprentissage tout en obtenant des modèles utilisables et évaluables. Les gains pratiques dépendront de la capacité des expérimentateurs à générer les multiples réponses informatives du système dont la méthode a besoin et de la poursuite des travaux pour rendre l'entraînement robuste au bruit réaliste et aux erreurs de modélisation.

Sources

- ArXiv (prépublication : Learning functional components of PDEs from data using neural networks)

- Mathematical Institute, University of Oxford (Torkel E. Loman, Jose A. Carrillo, Ruth E. Baker)

- Department of Mathematics, Physics and Geology, Cape Breton University

- Department of Engineering, University of Oxford

- Yangtze University ; King Abdullah University of Technology (travaux de simulation de réservoir par PINN hybride quantique-classique)

- RWTH Aachen University ; TU Munich ; MIT ; University of Cologne (approches par réseaux de neurones de graphes pour les problèmes algorithmiques)

Comments

No comments yet. Be the first!