Neuronale Netze, die die verborgenen Landschaften innerhalb von Gleichungen erlernen

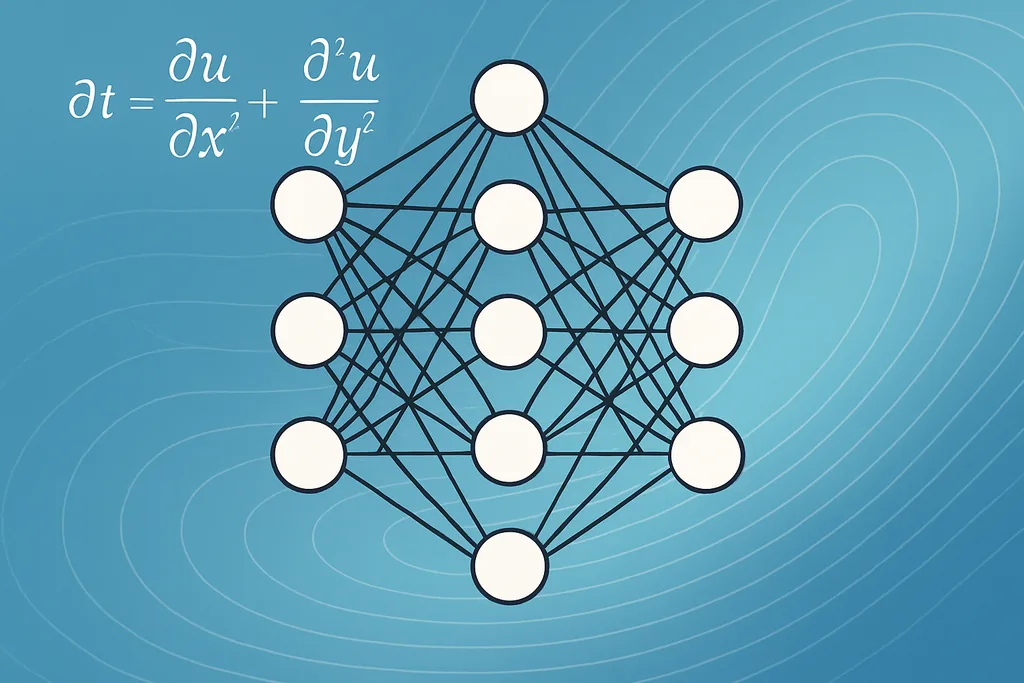

In dieser Woche veröffentlichte eine Gruppe von Mathematikern und Ingenieuren eine Methode, die zeigt, wie maschinelles Lernen präzise unbekannte Funktionen rekonstruiert, die in partiellen Differentialgleichungen eingebettet sind – den mathematischen Arbeitspferden, die zur Beschreibung von Wärme, Flüssigkeiten, Populationen und mehr verwendet werden. Das Team, mit federführenden Beiträgen von Forschern der University of Oxford und Kollaborateuren in Kanada, bettet ein neuronales Netzwerk direkt als Surrogat für die unbekannte räumliche Funktion in die PDE ein und trainiert das gesamte System anhand beobachteter stationärer Daten. Das Ergebnis ist nicht nur eine angepasste Zahl oder ein Parameter: Es ist eine Funktion, die das Modell überall dort auswerten kann, wo die PDE sinnvoll ist, wodurch unvollständige Gleichungen in funktionierende prädiktive Modelle verwandelt werden.

Dieser Fortschritt nimmt ein langjähriges inverses Problem in Angriff. Viele reale PDEs enthalten Terme, die wir nicht direkt messen können – einen Umweltreiz, einen räumlich variierenden Interaktionskern in einem Populationsmodell oder eine Heterogenität in einem Strömungsfeld – und diese unbeobachteten Funktionen behindern die Vorhersage. Indem sie ein neuronales Netzwerk für das fehlende Teil einspringen lassen und optimieren, wie die Ausgabe des Vorwärtsmodells mit den beobachteten Zuständen übereinstimmt, umgehen die Forscher einige der fehleranfälligen Schritte früherer Ansätze, wie etwa das Differenzieren verrauschter Messwerte. Ihre Verlustfunktion minimiert ein Fixpunkt-Residuum – was effektiv den numerisch berechneten stationären Zustand des Vorwärtsmodells zwingt, mit den Daten übereinzustimmen –, was das Training stabilisiert und die Notwendigkeit einer drastischen Datenvorverarbeitung reduziert.

Wie maschinelles Lernen in PDEs eingebettete Funktionen präzise rekonstruiert

Der zentrale technische Kniff ist in der Idee einfach und in der Praxis filigran. Anstatt eine Handvoll skalarer Koeffizienten abzustimmen, repräsentiert das Team den unbekannten räumlichen Term als ein neuronales Netzwerk mit anpassbaren Gewichten. Der PDE-Solver und das Netzwerk sind gekoppelt: Der Solver bildet eine Kandidatenfunktion auf eine stationäre Lösung ab, und die Trainingsschleife passt das Netzwerk so an, dass die PDE-Lösung mit den Messungen übereinstimmt. Dies ist ein Beispiel für eine breitere Familie von Methoden, die als physik-informiertes Lernen bekannt sind, bei denen physikalische Randbedingungen in die Architektur eingebaut werden, anstatt sie rein von Grund auf neu zu erlernen.

In der Praxis verschwindet das von ihnen verwendete Optimierungsziel – die Norm des Fixpunkt-Residuums – exakt für Gleichgewichtszustände des Vorwärtsmodells. Das ist wichtig, weil dadurch die Bildung numerischer Ableitungen von verrauschten Beobachtungsdaten vermieden wird, eine häufige Instabilitätsquelle bei inversen Problemen. Es macht das Verfahren auch kompatibel mit spärlichen, unregelmäßig abgetasteten Messungen: Das Team zeigt, dass die Rekonstruktion mit überraschend wenig Daten funktioniert, vorausgesetzt, die Beobachtungen sind aussagekräftig genug bezüglich der Auswirkung der zugrunde liegenden Funktion auf die Lösung. Varianten dieser Idee tauchen bereits in anderen Bereichen auf: Hybride quanten-klassische physik-informierte neuronale Netze wurden für Reservoir-Strömungssimulationen vorgeschlagen, während differenzierbare algorithmische Modelle Garantien und Skalierbarkeit für kombinatorische Probleme bringen. Diese Entwicklungen teilen das gleiche Thema – die Nutzung von Strukturen aus der Physik oder dem Algorithmus, um das Lernen zu leiten, anstatt Black-Box-Modelle frei umherwandern zu lassen.

Aus der Perspektive des maschinellen Lernens handelt es sich hierbei um die Entdeckung von Gleichungen auf funktionaler Ebene und nicht um eine symbolische Regression ganzer Operatoren. Neuronale Netze fungieren als universelle Approximatoren: Bei ausreichender Kapazität und dem richtigen induktiven Bias können sie glatte unbekannte Funktionen darstellen, die ansonsten maßgeschneiderte Parametrisierungen erfordern würden. Das Training extrahiert diese Funktionen durch die Frage: Welche Landschaft erzeugt, wenn sie in die PDE eingesetzt wird, die von uns beobachteten Daten? Wo eine symbolische Extraktion erforderlich ist, können Forscher auf die funktionale Rekonstruktion einen Modellkompressions- oder Sparse-Regressionsschritt folgen lassen, um menschenlesbare Ausdrücke zu erzeugen, aber das unmittelbare Ergebnis – eine funktionierende Funktion, die an neuen Punkten ausgewertet werden kann – ist bereits ein wertvolles wissenschaftliches Resultat.

Grenzen der präzisen Rekonstruktion durch maschinelles Lernen – Identifizierbarkeit, Rauschen und Datendesign

Trotz aller Versprechen hat die Methode klare Grenzen. Das Team demonstriert den Erfolg mit exakten, rauscharfreien Simulationen und untersucht dann, wie die Leistung bei realistischen Unvollkommenheiten abnimmt. Zwei Probleme stechen hervor: die strukturelle Identifizierbarkeit und das Messrauschen. Die strukturelle Identifizierbarkeit ist eine analytische Eigenschaft des PDE-Daten-Paares: Einige Funktionen können aus einem gegebenen Satz von Beobachtungen nicht eindeutig bestimmt werden, weil sie die beobachteten Ausgaben unverändert lassen. Die Forscher betonen, dass eine einzelne stationäre Momentaufnahme oft nicht ausreicht; normalerweise sind mindestens zwei unabhängige Lösungen oder Perturbationen, die unterschiedliche Systemreaktionen hervorrufen, erforderlich, um das inverse Problem einzugrenzen.

Rauschen und spärliche Abtastung verkomplizieren die Sache weiter. Die Rekonstruktion bleibt in vielen ihrer synthetischen Tests unter spärlicher Abtastung machbar, aber die Genauigkeit sinkt, wenn das Beobachtungsrauschen zunimmt. Die Empfindlichkeit variiert je nach Problem: Einige PDEs verstärken Messfehler auf vorhersehbare Weise, während andere sie ausmitteln. Das bedeutet, dass bei praktischen Einsätzen dem experimentellen Design große Aufmerksamkeit gewidmet werden muss: wo und wann Proben zu nehmen sind, wie mehrere aussagekräftige Lösungen generiert werden können und welche Regularisierungsterme in das Training aufgenommen werden sollten, um zu verhindern, dass das Netzwerk das Rauschen anstatt des Signals anpasst.

Zuverlässigkeit ist eine vielschichtige Frage. Maschinelles Lernen rekonstruiert verborgene Funktionen präzise, wenn drei Zutaten zusammenkommen: Die unbekannte Funktion hinterlässt einen Abdruck in der beobachtbaren Lösung, das Trainingsprotokoll kodiert die korrekten physikalischen Randbedingungen und die Datenstichprobe deckt genug von der Lösungsmannigfaltigkeit ab, um alternative Erklärungen auszuschließen. Wenn diese Bedingungen nicht erfüllt sind, können rekonstruierte Funktionen täuschend plausibel, aber falsch sein. Die systematische Untersuchung von Fehlermodi in der Studie ist gerade deshalb nützlich, weil sie vage Warnungen in testbare Diagnosen für Praktiker umwandelt.

Techniken, Werkzeuge und komplementäre Ansätze

Das Paper ist Teil eines wachsenden Werkzeugkastens von Methoden zur Gleichungsentdeckung. Physik-informierte neuronale Netze (PINNs) und ihre quanten-klassischen Hybride sind eine Familie: Sie backen Differentialoperatoren in den Verlust ein und sind besonders attraktiv, wenn die zugrunde liegende PDE bekannt ist, einige Terme jedoch nicht. Message-Passing-Graph-Neuronale-Netze bieten einen anderen Blickwinkel für Probleme mit diskreten Strukturen, zum Beispiel in Materialien oder vernetzten ökologischen Systemen, und können so entworfen werden, dass sie algorithmische Garantien erben. Symbolische Regressionstechniken – Sparse-Regression, Basis Pursuit und andere Methoden zur Entdeckung sparsamer Modelle – bleiben wertvoll, wenn das Ziel ein interpretierbarer analytischer Ausdruck statt eines numerischen Surrogats ist.

Die Extraktion symbolischer Ausdrücke aus der gelernten Funktion ist ein aktives Forschungsgebiet. Praktiker verwenden oft eine zweistufige Pipeline: Zuerst wird ein flexibles neuronales Surrogat gelernt, das zu den Daten passt, und anschließend wird dieses Surrogat mit einem Sparse-Fitting- oder Pruning-Schritt nachbearbeitet, um eine kompakte analytische Form zu destillieren. Dieser hybride Workflow kombiniert das Beste aus beiden Welten – die Flexibilität neuronaler Netze im Umgang mit Rauschen und Komplexität und die Interpretierbarkeit symbolischer Modelle, die Wissenschaftler analysieren und validieren können.

Anwendungen in Ökologie, Materialwissenschaften und Strömungsmechanik

Warum das wichtig ist: Wenn maschinelles Lernen die unsichtbaren Teile eines Modells präzise rekonstruiert, kann man deskriptive Momentaufnahmen in prädiktive Werkzeuge verwandeln. In der Ökologie könnte die unbekannte Funktion ein Umweltfeld oder ein Interaktionskern sein, der die Aggregation von Populationen formt; ihre Rekonstruktion ermöglicht es Managern, Artenverteilungen unter neuen Bedingungen vorherzusagen. In Materialmodellen und Modellen der kondensierten Materie sind räumliche Heterogenitäten wie eine variable Leitfähigkeit häufig die Unbekannten, die das makroskopische Verhalten bestimmen, und eine rekonstruierte Funktion bietet einen direkten Input für Design und Steuerung. Der Ansatz ergänzt auch Arbeiten in der Lagerstättentechnik, wo hybride quanten-klassische PINNs vorgeschlagen wurden, um die Rechenkosten zu senken und gleichzeitig die physikalische Treue beim Lösen von Strömungs-PDEs zu bewahren.

In all diesen Bereichen verringert die Methode die Reibung zwischen Datenerfassung und Modelleinsatz. Anstatt die Physik von Grund auf neu aufzubauen oder phänomenologische Terme zu überfitten, können Wissenschaftler die Struktur das Lernen leiten lassen und dennoch nutzbare, evaluierbare Modelle erhalten. Die praktischen Gewinne werden davon abhängen, wie gut Experimentatoren die multiplen, informativen Systemantworten generieren können, die die Methode benötigt, sowie von der weiteren Arbeit, das Training robust gegenüber realistischem Rauschen und Modellierungsfehlern zu machen.

Quellen

- ArXiv (Preprint: Learning functional components of PDEs from data using neural networks)

- Mathematical Institute, University of Oxford (Torkel E. Loman, Jose A. Carrillo, Ruth E. Baker)

- Department of Mathematics, Physics and Geology, Cape Breton University

- Department of Engineering, University of Oxford

- Yangtze University; King Abdullah University of Technology (Quantum‑Classical PINN reservoir simulation work)

- RWTH Aachen University; TU Munich; MIT; University of Cologne (Graph-Neuronale-Netz-Ansätze für algorithmische Probleme)

Kommentare

Noch keine Kommentare. Seien Sie der Erste!