Als Eric Schmidt diese Woche auf einer öffentlichen Veranstaltung sagte: „Uns geht der Strom aus“, wirkte dieser Kommentar wie eine Provokation in ganz Silicon Valley und Washington. Schmidt, der ehemalige Chef von Google, schätzte, dass die USA etwa 92 Gigawatt an neuer Leistung benötigen würden, um das rasante Wachstum großflächiger künstlicher Intelligenz aufrechtzuerhalten – eine Zahl, mit der er die Grenzen des heutigen Stromnetzes unterstrich. Die Reaktionen reichten von Investoren, die nervös den Infrastrukturbedarf neu berechneten, bis hin zu SpaceX-CEO Elon Musk, der auf X einen Scherz postete – „Wenn es nur eine Firma gäbe, die das tun könnte“ – und dabei den Clip teilte, eine Bemerkung, die die Energiedebatte mit erneuten Diskussionen über weltraumgestützte Rechenzentren verknüpfte.

eric schmidt says 'we're running out of electricity' — das Ausmaß des Problems

Schmidts Zahl von 92 Gigawatt ist deshalb so bemerkenswert, weil sie abstrakte Trends des maschinellen Lernens in eine gängige technische Einheit umrechnet: Leistungskapazität. Zum Vergleich merkte er an, dass ein durchschnittliches Kernkraftwerk etwa 1,5 Gigawatt erzeugt, was bedeutet, dass der von ihm beschriebene Engpass dem Äquivalent von Dutzenden neuer großer Reaktoren entspricht. Die Behauptung ist kein wörtlicher Countdown bis zum Blackout, sondern ein Alarmruf auf politischer Ebene: KI-Training und die neue Generation von Inferenzdiensten sind energiehungrig, und das Wachstum der Modellskalierung, der Dichte der Rechenzentren und des Kühlbedarfs könnte den geplanten Ausbau der Energieversorger übertreffen.

Dieser Druck zeigt sich im steigenden Energieverbrauch von Rechenzentren, der Rund-um-die-Uhr-Kühlung für dicht gepackte Beschleuniger-Hardware und den Betriebskosten für das Ausführen von Modellen auf globaler Ebene. Investoren und Unternehmer haben diese Besorgnis aufgegriffen: Der Risikokapitalgeber Chamath Palihapitiya warnte, dass die Strompreise in die Höhe schießen könnten, wenn sich die Branche nicht strukturell ändert, und große Cloud-Player planen bereits neue Kapazitäten im Bereich von Hunderten von Megawatt. Schmidts Kurzformel – eric schmidt says 'we're running out of electricity' – erfasst sowohl eine technische als auch eine politische Herausforderung: wie man wesentlich größere Rechenlasten bereitstellt, ansiedelt und reguliert.

eric schmidt says 'we're running out of electricity' — Weltraum-Rechenzentren als Antwort

Befürworter sagen, dass orbitale Racks eher frühe Experimente in den Bereichen Zuverlässigkeit, Wärmemanagement und Strahlungshärte wären als unmittelbarer Ersatz für terrestrische Cloud-Regionen. Pichai hat den Plan als „Moonshot“ bezeichnet, mit kleinen Testsystemen bis 2027, um zu bewerten, ob Rechenhardware die Strahlungsumgebung übersteht, wie die thermische Steuerung in großem Maßstab funktioniert und wie Wartungsmodelle aussehen. Jeff Bezos und andere haben ähnliche langfristige Visionen geäußert – mit der Prognose, dass sich die Wirtschaftlichkeit orbitaler Zentren über Jahrzehnte hinweg mit der von Bodenanlagen annähern könnte, wenn die Startkosten sinken.

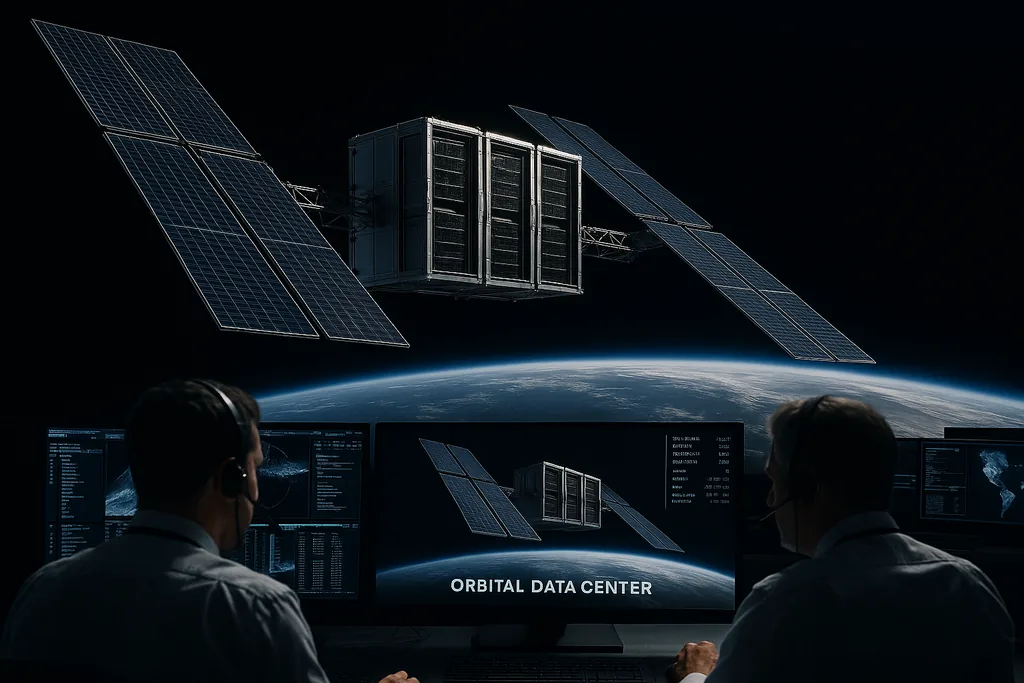

Wie Weltraum-Rechenzentren funktionieren würden und ob Solarstrom im Orbit sie versorgen kann

Weltraum-Rechenzentren nehmen auf dem Papier viele Formen an: Racks in einer niedrigen Erdumlaufbahn (LEO), größere Stationen in einer geosynchronen Umlaufbahn (GEO) oder Plattformen auf der Mondoberfläche. Alle Varianten setzen auf Photovoltaik für die primäre Erzeugung; im Sonnenlicht produzieren Solarmodule im Orbit aufgrund der fehlenden atmosphärischen Dämpfung mehr Energie pro Flächeneinheit als in typischen Bodenbreitengraden. Das macht kontinuierlichen Solarstrom im Prinzip zu einer überzeugenden Energiequelle, insbesondere für GEO oder sorgfältig konzipierte LEO-Konstellationen, die die Zeit im Erdschatten minimieren.

Missionsplaner müssen zudem Lösungen für Thermotechnik, Strahlungsabschirmung, Fehlerbehebung und Wartung im Orbit finden. Strahlungskühlung ist effektiv, aber die Hitze muss dennoch von heißen Chips zu Radiatoren geleitet werden, und Radiatoren erhöhen die Masse und Oberfläche – was die Startkosten steigert. Fazit: Solarstrom im Orbit ist als Erzeugungsquelle technisch machbar; dies in ein zuverlässiges, wirtschaftliches Rechenzentrum umzuwandeln, bleibt eine gewaltige technische Aufgabe.

Technische und wirtschaftliche Hindernisse für die Verlagerung von Rechenzentren von der Erde weg

Weltraum-Befürworter verweisen oft auf sinkende Startkosten und wiederverwendbare Raketen als den entscheidenden Faktor, der orbitale Rechenzentren plötzlich realistisch macht. Elon Musks öffentlicher Spott – „Wenn es nur eine Firma gäbe, die das tun könnte“ – steht stellvertretend für die Rolle, die SpaceX und ähnliche Start-Innovatoren spielen könnten. Dennoch äußerte sich Amazon Web Services-CEO Matt Garman unverblümt skeptisch: Weltraumzentren seien heute „nicht wirtschaftlich“. Er und andere verweisen auf den offensichtlichen Kostenpunkt – die Kosten für den Transport von Masse in den Orbit – sowie auf eine zweite Einschränkung: die aktuelle Frequenz zuverlässiger Starts.

Über die reinen Startkosten hinaus sehen sich Betreiber höheren Kosten für strahlungsgehärtete Server, Redundanz und Software gegenüber, die Mikrounterbrechungen toleriert. Auch die Servicemodelle spielen eine Rolle: Die meisten Cloud-Nutzer erwarten vorhersagbare Latenzzeiten und großen, kostengünstigen Speicher. Rechenleistung in den Orbit zu verlagern, mag für spezifische Workloads geeignet sein (lange Batch-Trainingsläufe, spezialisierte Inferenz im großen Maßstab oder Workloads, die eine höhere Latenz tolerieren), wird aber in naher Zukunft für die allgemeine Cloud ungeeignet sein. Zudem gibt es regulatorische und sicherheitstechnische Fragen zu Weltraumschrott, Frequenzzuteilungen für das Power Beaming und grenzüberschreitende Daten-Governance, wenn Satelliten wie schwimmende nationale Einrichtungen agieren.

Branchendynamik — Akteure, Politik und der Weg nach vorn

Das Gespräch vermischt technische Debatten mit unternehmensstrategischen Signalen. Alphabets Project Suncatcher wird als Forschungsprogramm positioniert – ein Experiment mit Racks und thermischen Systemen –, während die Fortschritte von SpaceX bei den Startkosten und der Startfrequenz als Wegbereiter genannt werden. Die Berichte über Unternehmensschritte, die SpaceX und xAI miteinander verknüpfen, fügen eine finanzielle Dimension hinzu: Unternehmen, die einst in angrenzenden Märkten konkurrierten, ordnen sich neu, um künftige Geschäftsmodelle für Rechenleistung im Weltraum zu erschließen. Unterdessen betonen Cloud-Platzhirsche wie AWS öffentlich die Wirtschaftlichkeit und mahnen zur Vorsicht.

Auch politische Akteure werden eine Rolle spielen. Energieversorger, Netzplaner und nationale Regulierungsbehörden stehen vor der Wahl, wo Investitionen priorisiert werden sollen: mehr terrestrische Erzeugung und Übertragung, mehr Effizienz auf der Nachfrageseite oder strategische Wetten auf exotische Alternativen wie orbitales Computing. Deshalb liest sich Schmidts Kommentar ebenso sehr als politischer Anstoß wie als technischer Hinweis: Wenn die Nation KI-gestütztes Computing ernst nimmt, wird sie eine koordinierte Planung in den Bereichen Energie, Raumfahrt und Telekommunikation benötigen.

Zeitpläne und was als Nächstes zu erwarten ist

Es ist unwahrscheinlich, dass Weltraum-Rechenzentren eine über Nacht stattfindende Verschiebung der weltweiten Datenverarbeitung bewirken. Realistischerweise ist ein stufenweiser Weg zu erwarten: kleine, instrumentierte Test-Racks im Orbit zur Messung der Zuverlässigkeit; bessere strahlungstolerante Beschleuniger und fehlertolerante Software; Demonstrationsmissionen, die zeigen, dass thermische Kontrolle und Energiemanagement in der Praxis funktionieren. Wenn diese erfolgreich sind, könnte sich die Wirtschaftlichkeit verbessern, während die Startpreise weiter sinken und bestimmte Nischen-Workloads ihren Wert für die Ausführung im Orbit unter Beweis stellen.

Kurzfristig könnte die größte Auswirkung von Schmidts Bemerkung strategischer Natur sein: Sie lenkt die Aufmerksamkeit auf die Angebotsseite von Rechenleistung und zwingt Cloud-Anbieter, Versorgungsunternehmen und politische Entscheidungsträger dazu, Pfade für Energie und Kapazität zu entwerfen. Ob dies zu orbitalen Rechenzentren, einem massiven Vorstoß für neue terrestrische Erzeugung oder einer Mischung aus Effizienz und dezentralem Computing führt, wird von technischen Ergebnissen, Regulierungen und der Entscheidung abhängen, wo privates Kapital seine Wetten platziert.

Vorerst ist der Satz eric schmidt says 'we're running out of electricity' weniger ein wörtlicher Countdown als vielmehr ein konzeptioneller Rahmen, der eine technische und gesundheitspolitische Diskussion über die Grenzen der aktuellen Infrastruktur und die kreativen – wenn auch teuren – vorgeschlagenen Alternativen beschleunigt hat.

Quellen

- Alphabet / Google (öffentliche Erklärungen zu Project Suncatcher und Kommentare von Sundar Pichai)

- Eric Schmidt, öffentliche Äußerungen zum Energiebedarf von KI

- SpaceX (Elon Musk Statements und Entwicklungen der Starttechnologie des Unternehmens)

- Amazon Web Services (Kommentare von Matt Garman)

Kommentare

Noch keine Kommentare. Seien Sie der Erste!