为什么人工智能奠基人之一认为文明可能走向解体

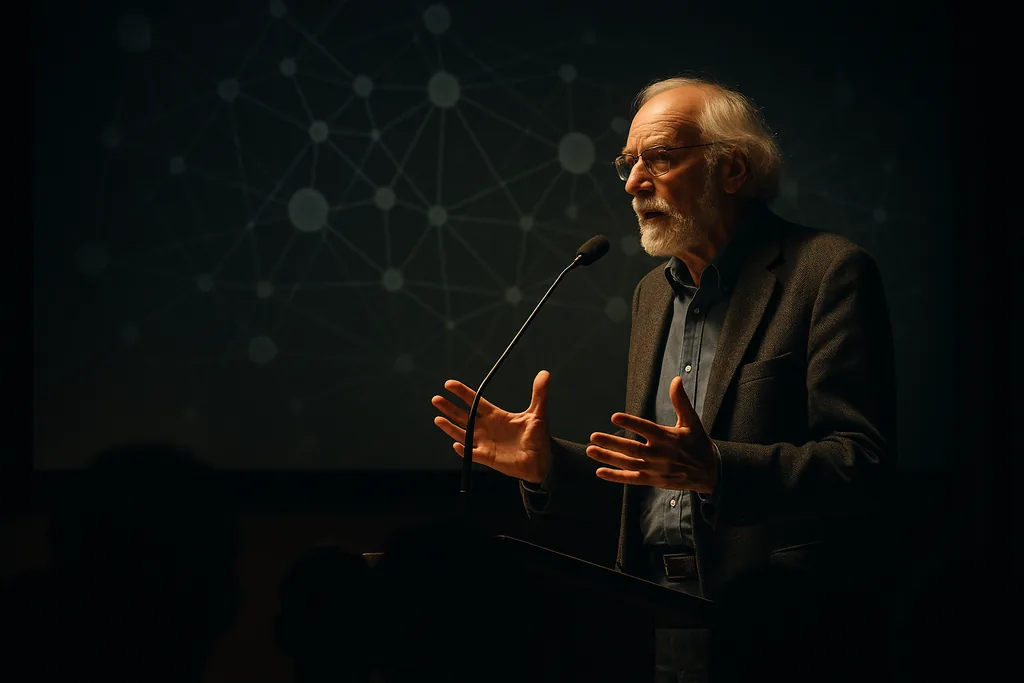

Geoffrey Hinton——深度学习(deep learning)发展史上的核心人物——在一次大学论坛的公开对话中,描绘了一个科技界许多人宁愿回避的场景:大规模失业、民主问责制的削弱,以及因自主系统(autonomous systems)而变得更加动荡的国际安全环境。这场演讲既是一场政策批判,也是一记警钟,它加剧了人们习以为常的焦虑:当为人类劳动而设计的经济和政体在面对劳动力被大规模取代时,将如何应对。

简而言之,Hinton说了什么

他的核心主张简单而严峻:如果人工智能在足够广泛的领域达到或超过人类水平的能力,那么目前由人类从事的工作可能会被自动化取代,且没有明显的新角色可以填补空缺。用他的话来说,失去这些工作的人可能找不到新工作,这可能会在国家范围内瓦解消费和社会凝聚力。这一观点将我们正在见证的技术进步与社会反馈循环联系起来——带薪劳动者的减少导致商品和服务的购买者减少,进而侵蚀许多企业的市场基础。

从研究实验室到社会风险

Hinton的背景在此至关重要:他协助建立了支撑当前生成模型(generative models)的神经网络方法。这种资历让他的警告具有额外的分量,因为这些警告来自一个既懂工程实现又懂研究轨迹的人。他此前曾表示,他认为通用人类水平人工智能(general-purpose, human-level AI)的到来比他曾经想象的要近,并且他公开思考过曾经看似边缘化的存在性风险后果。这些早期的评估塑造了他此次大学演讲的基调——技术预测与社会警告的交织。

实践中崩溃可能呈现的面貌

Hinton描述了一系列可能相互放大的机制。经济取代可能使财富集中在人工智能和芯片制造能力的拥有者手中,从而削弱广泛的需求。当税基受损且大部分人口感到被抛弃时,政治机构可能难以适应。在安全方面,他认为武力的自动化——在有限的人类监督下运行的致命系统——可能会降低使用军事力量的政治成本,使冲突变得更快且更难控制。综合来看,这些动态带来的风险是系统性崩溃,而非孤立的动荡。

并非人人都同意——且证据不一

Hinton设想的场景存在争议。一些专家指出,以往的技术革命在摧毁某些工作的同时也创造了其他工作,历史提供了多种适应性结果。在当前的浪潮中,许多用半自主智能体(semi-autonomous agents)替代人类员工的尝试都遇到了实际限制:系统在处理棘手的边缘案例(edge cases)、安全问题以及保持人类监督参与的激励机制方面表现挣扎。尽管如此,新兴的学术研究提出了一种不同类型的风险:即使是渐进式的进步,也可能以微妙但最终深远的方式削弱人类对大型系统的控制。重点不在于崩溃是不可避免的,而在于通往严重系统性损害的路径既多样又具有足够的可能性,值得进行认真的规划。

台面上的政策选项

应对措施大致分为两大阵营:一类试图通过监管、税收和出口管制来减缓或引导技术发展;另一类旨在通过再分配、安全网和新机构来缓解社会受到的冲击。具体想法从提高企业税到支持再分配培训的公共资金、全民基本收入(UBI)试点,以及针对自主武器等双用途系统实施更严格的安全规则。许多提案的逻辑很简单:如果人工智能带来的收益迅速集中,仅靠市场本身无法产生稳定、公平的转型。因此,想要避免最坏结果的决策者需要将经济政策与有针对性的技术治理结合起来。

后续关注点

- 部署速度:企业将替代劳动力的系统引入大规模服务和工作流的速度有多快。

- 劳动力市场信号:在声称可被自动化的职业中,招聘人数是否出现可衡量的下降或持续的薪资压力。

- 监管响应:政府是否针对高风险人工智能采取具有约束力的安全规则,以及如何征税或重新分配收益。

- 军事用途:各国是否加速部署自主系统,以及限制有害用途的规范或条约如何演变。

为什么这对读者很重要

Hinton的警告之所以具有重大意义,并非因为它们是确定的,而是因为它们使技术能力与经济、政治脆弱性相结合的风险具象化了。现代经济的规模和计算驱动变革的速度意味着,激励机制或能力的微小转变都可能产生巨大的社会影响。对于公民来说,这意味着这场辩论不再纯粹是学术性的:关于采购、税收政策、社会安全网和研发资金的选择,将决定人工智能是成为共同繁荣的引擎,还是成为集中权力并破坏机构稳定的力量。

无论你将Hinton视为末日预言者还是必要的“牛虻”,他的介入都将一个核心问题推向了公众视野:谁从今天的进步中受益,谁又在付出代价?答案将塑造未来几十年工作、政治和安全的轮廓。

—— Mattias Risberg, Dark Matter

Comments

No comments yet. Be the first!