Warum einer der Mitbegründer der KI sagt, dass die Zivilisation zerfasern könnte

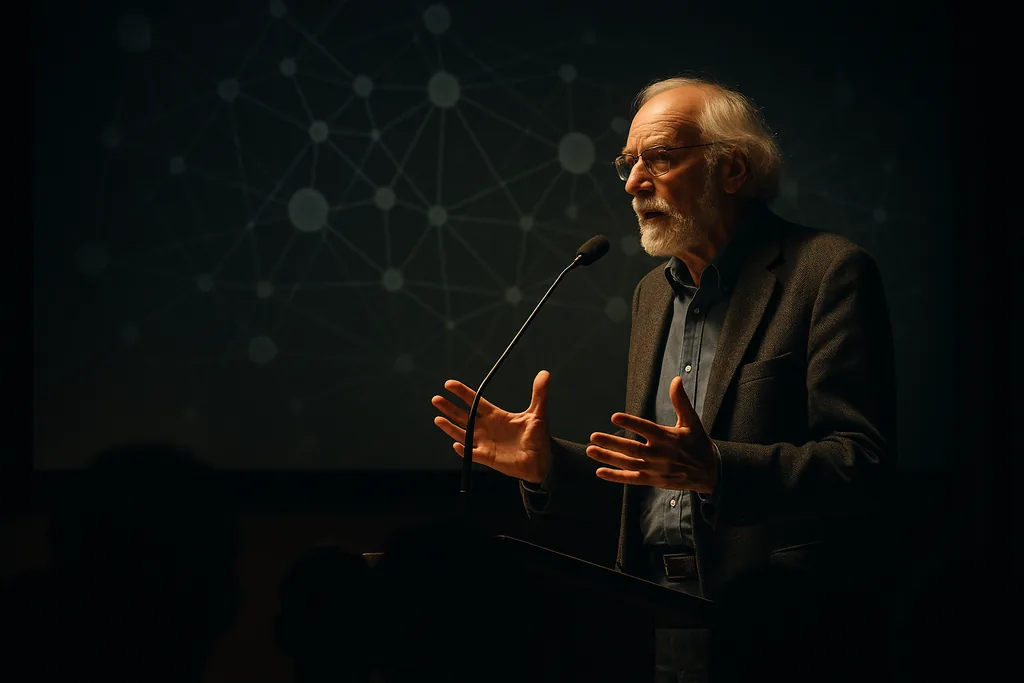

Geoffrey Hinton — eine zentrale Figur in der Entwicklung des Deep Learning — nutzte ein öffentliches Gespräch in einem Universitätsforum, um ein Szenario zu skizzieren, das viele in der Tech-Branche lieber vermeiden: Massenarbeitslosigkeit, geschwächte demokratische Verantwortlichkeit und ein internationales Sicherheitsumfeld, das durch autonome Systeme instabiler wird. Der Vortrag war teils Politikkritik, teils Warnsignal, und er verschärfte die bekannten Ängste darüber, wie eine Wirtschaft und ein Gemeinwesen, die auf menschliche Arbeit ausgelegt sind, damit umgehen werden, wenn diese Arbeit in großem Umfang ersetzt wird.

Was Hinton sagte, in einfachen Worten

Seine Kernaussage war einfach und unverblümt: Wenn KI eine Kompetenz auf menschlichem Niveau in ausreichendem Maße erreicht oder übertrifft, könnten Arbeitsplätze, die heute von Menschen ausgeübt werden, wegrationalisiert werden, ohne dass offensichtliche neue Rollen sie ersetzen. In seinen Worten ausgedrückt: Menschen, die diese Jobs verlieren, finden möglicherweise keine neuen, was den Konsum und den sozialen Zusammenhalt auf nationaler Ebene zersetzen könnte. Dieses Argument verbindet den technischen Fortschritt, den wir beobachten, mit einer gesellschaftlichen Rückkopplungsschleife — weniger bezahlte Arbeiter führen zu weniger Käufern von Waren und Dienstleistungen, was wiederum die Marktfundamente vieler Unternehmen untergräbt.

Vom Forschungslabor zum sozialen Risiko

Hintons Profil spielt hier eine wichtige Rolle: Er half dabei, die Methoden der neuronalen Netze aufzubauen, die die Grundlage aktueller generativer Modelle bilden. Dieser Hintergrund verleiht seinen Warnungen zusätzliches Gewicht, da sie von jemandem kommen, der sowohl die Technik als auch die Forschungswege versteht. Er hat bereits früher erklärt, dass er die Ankunft einer alltagstauglichen KI auf menschlichem Niveau als eine kurzfristigere Möglichkeit sieht, als er einst dachte, und er hat öffentlich über existenzielle Folgen nachgedacht, die einst als abwegig galten. Diese früheren Einschätzungen prägten den Tenor seiner Äußerungen an der Universität — eine Mischung aus technischer Prognose und gesellschaftlicher Warnung.

Wie ein Zusammenbruch in der Praxis aussehen könnte

Hinton beschrieb ein Bündel von Mechanismen, die sich gegenseitig verstärken könnten. Wirtschaftliche Verdrängung könnte den Reichtum bei den Besitzern von KI- und Chipproduktionskapazitäten konzentrieren und so die breit angelegte Nachfrage verringern. Politische Institutionen könnten Schwierigkeiten haben, sich anzupassen, wenn die Steuerbasis erodiert und große Teile der Bevölkerung sich abgehängt fühlen. In Bezug auf die Sicherheit argumentierte er, dass die Automatisierung von Gewalt — tödliche Systeme, die mit begrenzter menschlicher Aufsicht operieren — die politischen Kosten für den Einsatz militärischer Macht senken könnte, was Konflikte beschleunigt und schwerer kontrollierbar macht. Zusammengenommen bergen diese Dynamiken das Risiko eines systemischen Zusammenbruchs statt nur isolierter Störungen.

Nicht alle stimmen zu — und die Beweislage ist gemischt

Hintons Szenario ist umstritten. Einige Experten weisen darauf hin, dass frühere technologische Revolutionen bestimmte Arbeitsplätze vernichtet, aber andere geschaffen haben, und dass die Geschichte eine Reihe von anpassungsfähigen Verläufen bietet. In der gegenwärtigen Welle sind viele Versuche, menschliche Arbeitskräfte durch teilautonome Agenten zu ersetzen, an praktische Grenzen gestoßen: Systeme tun sich schwer mit komplexen Grenzfällen, Sicherheitsbedenken und Anreizen, die die menschliche Aufsicht im Prozess halten. Dennoch argumentieren neuere wissenschaftliche Arbeiten für eine andere Art von Risiko: Selbst schrittweise, inkrementelle Fortschritte können die menschliche Kontrolle über große Systeme auf eine Weise untergraben, die subtil, aber letztlich tiefgreifend ist. Der Punkt ist nicht, dass ein Zusammenbruch unvermeidlich ist, sondern dass die Wege zu schwerwiegenden systemischen Schäden sowohl vielfältig als auch plausibel genug sind, um eine ernsthafte Planung zu verdienen.

Politische Optionen auf dem Tisch

Die Reaktionen lassen sich in zwei große Lager unterteilen: jene, die versuchen, die Technologie durch Regulierung, Steuern und Exportkontrollen zu verlangsamen oder zu gestalten, und jene, die darauf abzielen, die Gesellschaft durch Umverteilung, Sicherungssysteme und neue Institutionen vor Erschütterungen zu schützen. Die Ideen reichen von höheren Unternehmenssteuern über öffentliche Mittel für Umschulungen und Pilotprojekte für ein bedingungsloses Grundeinkommen bis hin zu strengeren Sicherheitsregeln für Dual-Use-Systeme wie autonome Waffen. Die Begründung für viele dieser Vorschläge ist simpel: Wenn sich die Gewinne aus der KI schnell konzentrieren, werden Märkte allein keinen stabilen, gerechten Übergang herbeiführen. Politische Entscheidungsträger, die die schlimmsten Folgen abwenden wollen, müssen daher Wirtschaftspolitik mit gezielter technischer Steuerung kombinieren.

Worauf als Nächstes zu achten ist

- Rollout-Geschwindigkeit: Wie schnell Unternehmen arbeitsersetzende Systeme in großflächige Dienstleistungen und Arbeitsabläufe integrieren.

- Arbeitsmarktsignale: Messbare Rückgänge bei Neueinstellungen oder anhaltender Lohndruck in Berufen, von denen behauptet wird, sie seien automatisierbar.

- Regulatorische Reaktionen: Ob Regierungen verbindliche Sicherheitsregeln für Hochrisiko-KI verabschieden und wie sie Gewinne besteuern oder umverteilen.

- Militärische Nutzung: Ob Staaten den Einsatz autonomer Systeme beschleunigen und wie sich Normen oder Verträge entwickeln, um schädliche Nutzungen zu begrenzen.

Warum dies für Leser wichtig ist

Hintons Warnungen sind nicht deshalb von Bedeutung, weil sie gewiss sind, sondern weil sie Risiken verdeutlichen, die technologische Kapazität mit wirtschaftlicher und politischer Verwundbarkeit vermengen. Das Ausmaß moderner Volkswirtschaften und die Geschwindigkeit des computergesteuerten Wandels bedeuten, dass kleine Verschiebungen bei Anreizen oder Fähigkeiten überproportionale gesellschaftliche Auswirkungen haben können. Für die Bürger bedeutet dies, dass die Debatte nicht mehr rein akademisch ist: Entscheidungen über Beschaffung, Steuerpolitik, soziale Sicherungssysteme und Forschungsförderung werden darüber entscheiden, ob die KI zu einem Motor für gemeinsamen Wohlstand wird oder zu einer Kraft, die Macht konzentriert und Institutionen destabilisiert.

Ob man Hinton nun als Untergangspropheten oder als notwendigen Mahner betrachtet, seine Intervention rückt eine zentrale Frage in den Fokus der Öffentlichkeit: Wer profitiert von den heutigen Fortschritten, und wer zahlt den Preis? Die Antwort darauf wird die Konturen von Arbeit, Politik und Sicherheit in den kommenden Jahrzehnten prägen.

— Mattias Risberg, Dark Matter

Kommentare

Noch keine Kommentare. Seien Sie der Erste!