Pourquoi l'un des fondateurs de l'IA affirme que la civilisation pourrait s'effriter

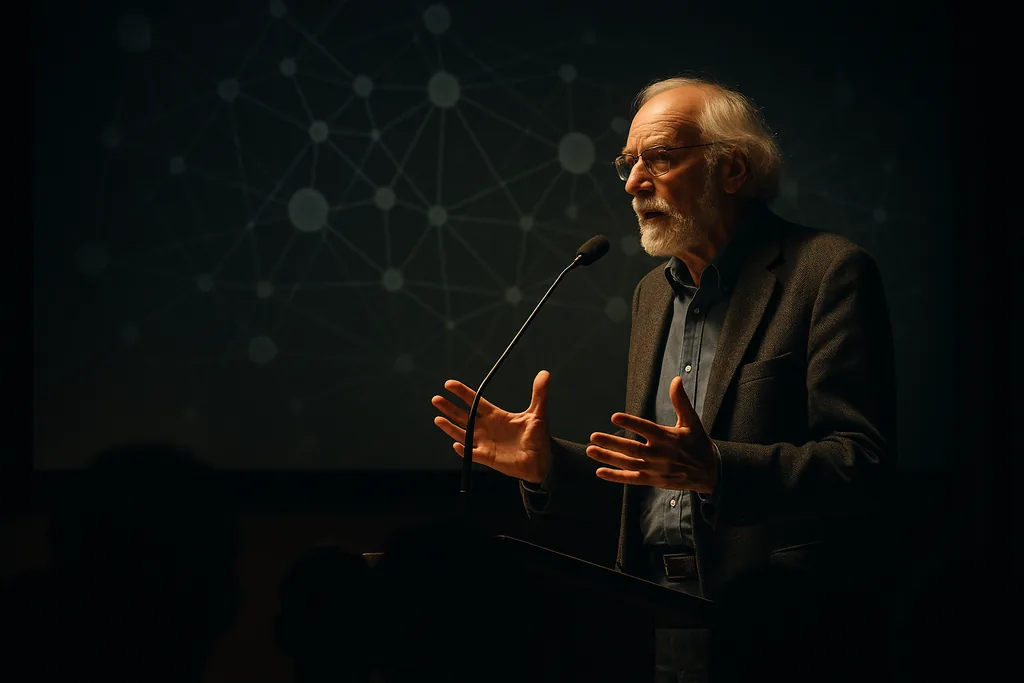

Geoffrey Hinton — figure centrale du développement de l'apprentissage profond — a profité d'une conversation publique lors d'un forum universitaire pour esquisser un scénario que beaucoup dans le secteur technologique préfèrent éviter : chômage de masse, affaiblissement de la responsabilité démocratique et un environnement de sécurité internationale rendu plus instable par les systèmes autonomes. Son intervention tenait à la fois de la critique politique et du cri d'alarme, accentuant les inquiétudes familières sur la manière dont une économie et un système politique conçus pour le travail humain feront face lorsque ce travail sera remplacé à grande échelle.

Ce qu'a dit Hinton, en termes simples

Son argument principal était simple et direct : si l'IA atteint ou dépasse la compétence humaine de manière assez généralisée, les emplois que les gens occupent actuellement pourraient être automatisés sans que de nouveaux rôles évidents ne les remplacent. Selon ses termes, les personnes perdant ces emplois pourraient ne pas en trouver de nouveaux, ce qui pourrait défaire la consommation et la cohésion sociale à l'échelle nationale. Cet argument lie les progrès techniques actuels à une boucle de rétroaction sociale — moins de travailleurs rémunérés signifie moins d'acheteurs de biens et de services, ce qui, à son tour, érode les fondements du marché de nombreuses entreprises.

Du laboratoire de recherche au risque social

Le profil de Hinton est ici primordial : il a aidé à bâtir les méthodes de réseaux de neurones qui sous-tendent les modèles génératifs actuels. Ce pedigree donne un poids supplémentaire à ses mises en garde, car elles proviennent de quelqu'un qui comprend à la fois l'ingénierie et les trajectoires de recherche. Il a précédemment déclaré qu'il considérait l'arrivée d'une IA à usage général de niveau humain comme une possibilité à plus court terme qu'il ne le pensait auparavant, et il a publiquement envisagé des issues existentielles qui semblaient autrefois marginales. Ces évaluations antérieures ont façonné la teneur de ses remarques universitaires — un mélange de prévisions techniques et d'avertissements sociaux.

À quoi pourrait ressembler un effondrement en pratique

Hinton a décrit un ensemble de mécanismes qui pourraient s'amplifier mutuellement. Le déplacement économique pourrait concentrer la richesse entre les mains des propriétaires de l'IA et des capacités de fabrication de puces, réduisant ainsi la demande globale. Les institutions politiques pourraient peiner à s'adapter alors que les bases fiscales s'érodent et qu'une grande partie de la population se sent délaissée. Sur le plan de la sécurité, il a soutenu que l'automatisation de la force — des systèmes létaux fonctionnant avec une surveillance humaine limitée — pourrait abaisser le coût politique de l'utilisation de la puissance militaire, rendant les conflits plus rapides et plus difficiles à contrôler. Ensemble, ces dynamiques créent le risque d'une rupture systémique plutôt que de perturbations isolées.

Tout le monde n'est pas d'accord — et les preuves sont mitigées

Le scénario de Hinton est contesté. Certains experts soulignent que les révolutions technologiques précédentes ont détruit certains emplois tout en en créant d'autres, et que l'histoire offre une gamme de résultats adaptatifs. Dans la vague actuelle, de nombreuses tentatives de substitution de travailleurs humains par des agents semi-autonomes se sont heurtées à des limites pratiques : les systèmes peinent avec les cas marginaux complexes, les préoccupations de sécurité et les incitations qui maintiennent la surveillance humaine dans la boucle. Cela dit, des travaux universitaires récents soutiennent un type de risque différent : même des avancées progressives et incrémentales peuvent éroder le contrôle humain sur les grands systèmes de manière subtile mais finalement profonde. L'idée n'est pas que l'effondrement est inévitable, mais que les voies menant à de graves dommages systémiques sont à la fois variées et suffisamment plausibles pour mériter une planification sérieuse.

Les options politiques sur la table

Les réponses se divisent en deux grands camps : ceux qui tentent de ralentir ou de façonner la technologie par la réglementation, les taxes et les contrôles à l'exportation, et ceux qui visent à protéger la société des perturbations par la redistribution, les filets de sécurité et de nouvelles institutions. Les idées vont d'une augmentation des impôts sur les sociétés au financement public de la reconversion, en passant par des projets pilotes de revenu universel de base et des règles de sécurité plus strictes pour les systèmes à double usage tels que les armes autonomes. La logique de nombre de ces propositions est simple : si les gains de l'IA se concentrent rapidement, les marchés seuls ne produiront pas une transition stable et équitable. Les décideurs politiques qui souhaitent éviter les pires issues devront donc combiner politique économique et gouvernance technique ciblée.

Ce qu'il faut surveiller ensuite

- Vitesse de déploiement : la rapidité avec laquelle les entreprises intègrent des systèmes remplaçant la main-d'œuvre dans des services et des flux de travail à grande échelle.

- Signaux du marché du travail : baisses mesurables des embauches ou pression salariale persistante dans les professions jugées automatisables.

- Réponses réglementaires : si les gouvernements adoptent des règles de sécurité contraignantes pour l'IA à haut risque et comment ils taxent ou redistribuent les gains.

- Utilisations militaires : si les États accélèrent le déploiement de systèmes autonomes et comment les normes ou traités évoluent pour limiter les utilisations néfastes.

Pourquoi cela est important pour les lecteurs

Les avertissements de Hinton sont lourds de conséquences non pas parce qu'ils sont certains, mais parce qu'ils cristallisent des risques qui mêlent capacité technologique et vulnérabilité économique et politique. L'échelle des économies modernes et la vitesse du changement piloté par la puissance de calcul signifient que de légers changements dans les incitations ou les capacités peuvent avoir des effets sociaux démesurés. Pour les citoyens, cela implique que le débat n'est plus purement académique : les choix concernant les marchés publics, la politique fiscale, les filets de sécurité sociale et le financement de la R&D détermineront si l'IA deviendra un moteur de prospérité partagée ou une force qui concentre le pouvoir et déstabilise les institutions.

Que vous considériez Hinton comme un prophète de malheur ou un trublion nécessaire, son intervention expose une question centrale au grand jour : qui bénéficie des avancées d'aujourd'hui, et qui en paie le prix ? La réponse façonnera les contours du travail, de la politique et de la sécurité dans les décennies à venir.

— Mattias Risberg, Dark Matter

Comments

No comments yet. Be the first!